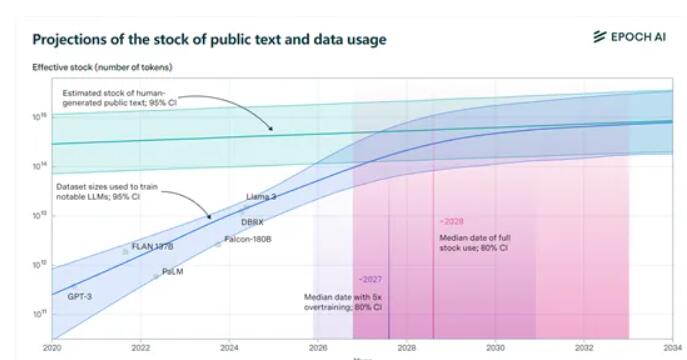

Laporan terbaru yang dirilis oleh Epochai menunjukkan bahwa kumpulan data pelatihan teks publik berkualitas tinggi di dunia akan habis oleh model bahasa besar dalam beberapa tahun ke depan. Laporan tersebut memperkirakan bahwa antara tahun 2026 dan 2032, data yang ada sekitar 300 triliun token akan habis, dan “pelatihan berlebihan” pada model tersebut telah mempercepat proses ini. Versi Llama3 8B dari Meta mengalami overtrained sebanyak 100 kali. Jika semua model mengadopsi pendekatan ini, datanya mungkin akan habis pada tahun 2025. Menghadapi “kekurangan data” yang akan datang, Epochai telah mengusulkan empat solusi potensial, memberikan arah baru untuk akuisisi data di bidang kecerdasan buatan.

Para peneliti secara khusus menunjukkan bahwa "overtraining" adalah penyebab utama percepatan konsumsi data pelatihan. Misalnya, Llama3 open source terbaru Meta, versi 8B, mengalami overtraining 100 kali lipat! Jika semua model berperilaku seperti ini, data kami mungkin harus berpisah pada tahun 2025.

Tapi jangan khawatir, kami masih punya jalan. Epoch AI menyediakan empat metode baru untuk memperoleh data pelatihan, menjadikan “kekurangan data” di dunia AI tidak lagi menjadi mimpi buruk.

1) Data sintetis: Sama seperti makanan yang dibuat dari peralatan memasak, data sintetis menggunakan pembelajaran mendalam untuk menyimulasikan data nyata dan menghasilkan data baru. Namun jangan terlalu bersemangat terlalu dini; kualitas data sintetik bisa jadi tidak merata, cenderung overfitting, dan tidak memiliki fitur linguistik yang berbeda dengan teks sebenarnya.

2) Pembelajaran data multimodal dan lintas domain: Metode ini tidak terbatas pada teks, tetapi juga mencakup gambar, video, audio, dan tipe data lainnya. Sama seperti di KTV, Anda tidak hanya bisa menyanyi, menari, tetapi juga berakting. Pembelajaran multi-modal memungkinkan model untuk memahami dan menangani tugas-tugas kompleks secara lebih komprehensif.

3) Data pribadi: Saat ini, jumlah total data teks pribadi di dunia adalah sekitar 3100 triliun token, lebih dari 10 kali lipat data publik! Namun Anda harus berhati-hati saat menggunakan data pribadi keamanan adalah hal besar. Selain itu, proses memperoleh dan mengintegrasikan data non-publik bisa jadi rumit.

4) Pembelajaran interaktif real-time dengan dunia nyata: Biarkan model belajar dan berkembang melalui interaksi langsung dengan dunia nyata. Pendekatan ini mengharuskan model menjadi otonom dan mudah beradaptasi, mampu memahami instruksi pengguna secara akurat dan mengambil tindakan di dunia nyata.

Keempat metode yang dikemukakan Epochai masing-masing memiliki kelebihan dan kekurangan serta menghadapi tantangan yang berbeda-beda. Di masa depan, cara mengatasi masalah data secara efektif akan berdampak langsung pada pengembangan dan penerapan teknologi kecerdasan buatan. Hal ini memerlukan kerja sama antara peneliti ilmiah dan industri untuk mencari cara yang lebih efektif dalam memperoleh dan memanfaatkan data guna memastikan pengembangan kecerdasan buatan yang berkelanjutan dan sehat.