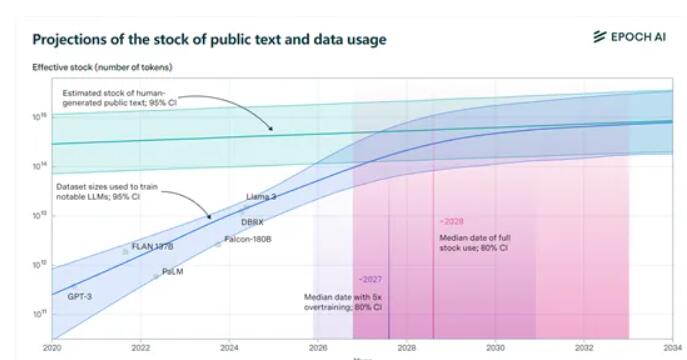

Le dernier rapport publié par Epochai indique que les ensembles de données publiques mondiales de formation de textes de haute qualité seront épuisés par les grands modèles linguistiques au cours des prochaines années. Le rapport prédit qu'entre 2026 et 2032, les données existantes d'environ 300 000 milliards de jetons seront épuisées, et le « surentraînement » du modèle a accéléré ce processus. La version Llama3 8B de Meta est surentraînée 100 fois. Si tous les modèles adoptent cette approche, les données pourraient être épuisées d’ici 2025. Face à la « pénurie de données » à venir, Epochai a proposé quatre solutions potentielles, ouvrant une nouvelle direction à l'acquisition de données dans le domaine de l'intelligence artificielle.

Les chercheurs ont spécifiquement souligné que le « surentraînement » est le principal responsable de l’accélération de la consommation des données d’entraînement. Par exemple, la dernière version open source Llama3, 8B de Meta, présente un étonnant surentraînement 100 fois supérieur ! Si tous les modèles se comportent ainsi, nos données devront peut-être dire au revoir en 2025 !

Mais ne vous inquiétez pas, nous avons encore du chemin à parcourir. Epoch AI propose quatre nouvelles méthodes pour obtenir des données de formation, faisant de la « pénurie de données » dans le monde de l'IA un cauchemar.

1) Données synthétiques : tout comme un repas préparé à partir d'un kit de cuisine, les données synthétiques utilisent l'apprentissage profond pour simuler des données réelles et générer de toutes nouvelles données. Mais ne vous enthousiasmez pas trop tôt : la qualité des données synthétiques peut être inégale, sujette au surajustement et manquer des caractéristiques linguistiques nuancées du texte réel.

2) Apprentissage de données multimodales et interdomaines : Cette méthode ne se limite pas au texte, mais inclut également les images, les vidéos, l'audio et d'autres types de données. Tout comme dans KTV, vous pouvez non seulement chanter, danser, mais aussi jouer. L'apprentissage multimodal permet au modèle de comprendre et de gérer de manière plus globale des tâches complexes.

3) Données privées : À l'heure actuelle, la quantité totale de données textuelles privées dans le monde est d'environ 3 100 000 milliards de jetons, soit plus de 10 fois celle des données publiques. Mais vous devez être prudent lorsque vous utilisez des données privées. la sécurité est une grande chose. De plus, le processus d’obtention et d’intégration de données non publiques peut s’avérer complexe.

4) Apprentissage interactif en temps réel avec le monde réel : laissez le modèle apprendre et s'améliorer grâce à une interaction directe avec le monde réel. Cette approche nécessite que les modèles soient autonomes et adaptables, capables de comprendre avec précision les instructions des utilisateurs et d'agir dans le monde réel.

Les quatre méthodes proposées par Epochai ont chacune leurs propres avantages et inconvénients et font face à des défis différents. À l'avenir, la manière de résoudre efficacement les problèmes de données affectera directement le développement et l'application de la technologie de l'intelligence artificielle. Cela nécessite que les chercheurs scientifiques et l’industrie travaillent ensemble pour explorer des moyens plus efficaces d’obtenir et d’utiliser des données afin d’assurer le développement durable et sain de l’intelligence artificielle.