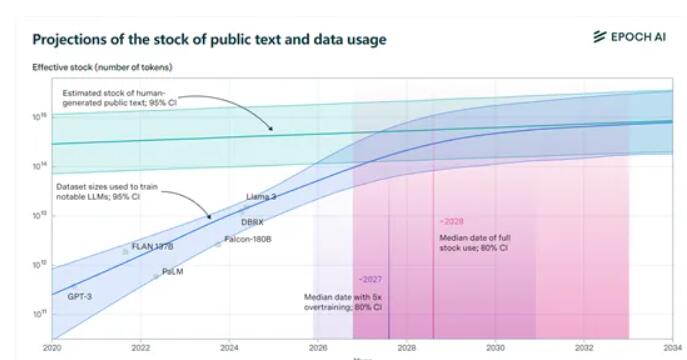

Epochai机构发布的最新报告指出,全球公开的高质量文本训练数据集将在未来几年内被大型语言模型消耗殆尽。报告预测,在2026年到2032年间,现有的约300万亿tokens的数据将被用完,而模型的“过度训练”更是加速了这一进程。Meta的Llama3 8B版本的过度训练就达到了惊人的100倍,如果所有模型都采用这种方式,数据可能在2025年就会耗尽。面对即将到来的“数据荒”,Epochai机构提出了四种潜在的解决方案,为人工智能领域的数据获取提供了新的方向。

研究人员特别指出,“过度训练”是加速消耗训练数据的罪魁祸首。比如Meta最新开源的Llama3,8B版本的过度训练竟然达到了惊人的100倍!如果所有模型都这么玩,咱们的数据可能在2025年就得说拜拜了。

但别急,咱们还有招。Epoch ai给出了四种获取训练数据的新方法,让AI界的“数据荒”不再是梦魇。

1)合成数据: 就像用料理包做出的大餐,合成数据利用深度学习模拟真实数据,生成全新的数据。但别高兴太早,合成数据的质量可能参差不齐,容易过拟合,缺乏真实文本的细微语言特征。

2)多模态和跨领域数据学习: 这种方法不仅限于文本,还包括图像、视频、音频等多种数据类型。就像在KTV里,不仅能唱,还能跳,还能演,多模态学习让模型更全面地理解和处理复杂任务。

3)私有数据: 目前全球文本数据的私有总量大约是3100万亿tokens,是公开数据的10倍多!但使用私有数据得小心翼翼,毕竟隐私和安全性是大事。而且,获取和整合非公共数据的过程可能非常复杂。

4)与真实世界实时交互学习: 让模型通过与真实世界的直接互动来学习和进步。这种方法要求模型具备自主性和适应性,能够准确理解用户指令,并在现实世界中采取行动。

Epochai提出的这四种方法,各有优劣,也面临着不同的挑战。未来,如何有效地解决数据问题,将直接影响人工智能技术的发展和应用。 这需要科研人员和产业界共同努力,探索更有效的数据获取和利用方式,才能保证人工智能持续健康发展。