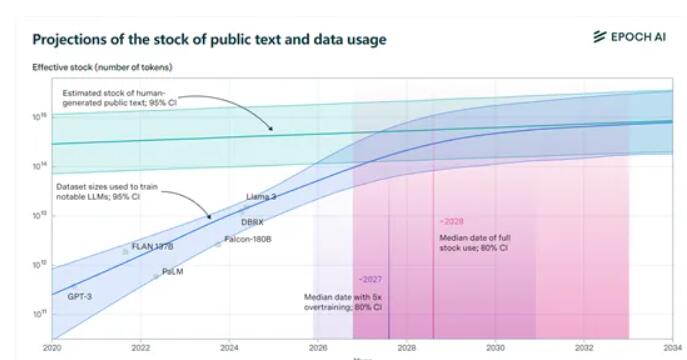

Epochai가 발표한 최신 보고서에 따르면 전 세계의 공개 고품질 텍스트 교육 데이터 세트가 향후 몇 년 내에 대규모 언어 모델로 인해 고갈될 것이라고 합니다. 보고서는 2026년부터 2032년 사이에 약 300조 개의 토큰에 달하는 기존 데이터가 소진될 것으로 예측하고 있으며, 모델의 "과도한 훈련"으로 인해 이 과정이 가속화되었습니다. Meta의 Llama3 8B 버전은 100배나 오버트레이닝됩니다. 모든 모델이 이 접근 방식을 채택하면 2025년까지 데이터가 소진될 수 있습니다. 다가오는 "데이터 부족"에 직면하여 Epochai는 인공 지능 분야의 데이터 수집에 대한 새로운 방향을 제시하는 네 가지 잠재적 솔루션을 제안했습니다.

연구진은 훈련 데이터 소비를 가속화하는 주범으로 '오버 트레이닝'을 구체적으로 지적했다. 예를 들어 Meta의 최신 오픈 소스 Llama3, 8B 버전은 놀랍게도 100배의 오버트레이닝을 제공합니다. 모든 모델이 이와 같이 작동한다면 우리 데이터는 2025년에 작별 인사를 해야 할 수도 있습니다.

하지만 걱정하지 마세요. 아직 방법이 남아 있습니다. Epoch AI는 훈련 데이터를 얻는 네 가지 새로운 방법을 제공하여 AI 세계의 '데이터 부족'을 더 이상 악몽이 아닙니다.

1) 합성 데이터: 요리 키트로 만든 음식처럼 합성 데이터는 딥러닝을 사용해 실제 데이터를 시뮬레이션하고 새로운 데이터를 생성합니다. 하지만 너무 일찍 너무 흥분하지 마세요. 합성 데이터의 품질이 고르지 않고, 과적합되기 쉽고, 실제 텍스트의 미묘한 언어적 특징이 부족할 수 있습니다.

2) 다중 모드 및 교차 도메인 데이터 학습: 이 방법은 텍스트에만 국한되지 않고 이미지, 비디오, 오디오 및 기타 데이터 유형도 포함합니다. KTV와 마찬가지로 노래, 춤뿐만 아니라 연기도 할 수 있습니다. 다중 모달 학습을 통해 모델은 복잡한 작업을 보다 포괄적으로 이해하고 처리할 수 있습니다.

3) 개인 데이터: 현재 전 세계 개인 텍스트 데이터의 총량은 약 3,100조 토큰으로, 이는 공공 데이터의 10배가 넘습니다! 하지만 개인 데이터를 사용할 때는 결국 조심해야 합니다. 보안은 큰 것입니다. 더욱이, 비공개 데이터를 획득하고 통합하는 과정은 복잡할 수 있습니다.

4) 현실 세계와의 실시간 대화형 학습: 모델이 현실 세계와의 직접적인 상호 작용을 통해 학습하고 향상되도록 합니다. 이 접근 방식을 사용하려면 모델이 자율적이고 적응 가능해야 하며, 사용자 지침을 정확하게 이해하고 실제 세계에서 조치를 취할 수 있어야 합니다.

Epochai가 제안한 네 가지 방법은 각각 장점과 단점이 있으며 서로 다른 과제에 직면해 있습니다. 앞으로는 데이터 문제를 어떻게 효과적으로 해결하느냐가 인공지능 기술의 발전과 적용에 직접적인 영향을 미치게 될 것이다. 이를 위해서는 과학 연구자와 업계가 함께 협력하여 인공 지능의 지속 가능하고 건전한 개발을 보장하기 위해 데이터를 획득하고 활용하는 보다 효과적인 방법을 모색해야 합니다.