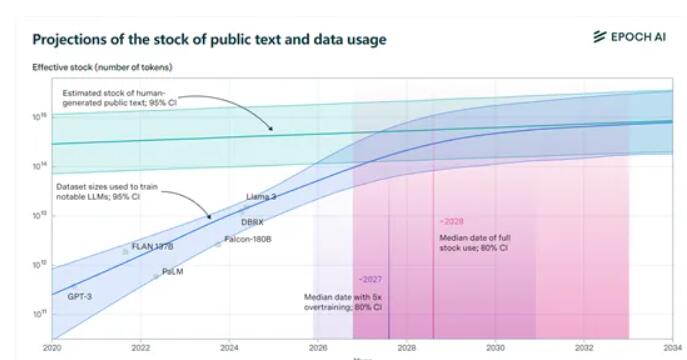

Der neueste von Epochai veröffentlichte Bericht deutet darauf hin, dass die weltweit verfügbaren qualitativ hochwertigen Texttrainingsdatensätze in den nächsten Jahren durch große Sprachmodelle erschöpft sein werden. Der Bericht prognostiziert, dass zwischen 2026 und 2032 die vorhandenen Daten von etwa 300 Billionen Token aufgebraucht sein werden, und das „Übertraining“ des Modells hat diesen Prozess beschleunigt. Die Llama3 8B-Version von Meta ist um das 100-fache überlastet. Wenn alle Modelle diesen Ansatz übernehmen, könnten die Daten bis 2025 erschöpft sein. Angesichts der bevorstehenden „Datenknappheit“ hat Epochai vier mögliche Lösungen vorgeschlagen, die eine neue Richtung für die Datenerfassung im Bereich der künstlichen Intelligenz vorgeben.

Die Forscher wiesen ausdrücklich darauf hin, dass „Übertraining“ der Hauptgrund für die Beschleunigung des Verbrauchs von Trainingsdaten ist. Metas neueste Open-Source-Version Llama3, 8B, hat beispielsweise ein erstaunliches 100-faches Übertraining! Wenn sich alle Modelle so verhalten, müssen sich unsere Daten möglicherweise im Jahr 2025 verabschieden.

Aber keine Sorge, wir haben immer noch einen Weg. Epoch AI bietet vier neue Methoden zum Erhalten von Trainingsdaten, sodass der „Datenmangel“ in der KI-Welt kein Albtraum mehr ist.

1) Synthetische Daten: Genau wie eine Mahlzeit, die aus einem Kochset zubereitet wird, nutzen synthetische Daten Deep Learning, um reale Daten zu simulieren und völlig neue Daten zu generieren. Aber seien Sie nicht zu früh aufgeregt; die Qualität synthetischer Daten kann ungleichmäßig sein, zu Überanpassungen neigen und es können ihnen die nuancierten sprachlichen Merkmale echten Textes fehlen.

2) Multimodales und domänenübergreifendes Datenlernen: Diese Methode ist nicht auf Text beschränkt, sondern umfasst auch Bilder, Videos, Audio und andere Datentypen. Genau wie bei KTV kann man nicht nur singen, tanzen, sondern auch schauspielern. Durch multimodales Lernen kann das Modell komplexe Aufgaben umfassender verstehen und bewältigen.

3) Private Daten: Derzeit beträgt die Gesamtmenge an privaten Textdaten auf der Welt etwa 3100 Billionen Token, was mehr als dem Zehnfachen der öffentlichen Daten entspricht. Bei der Verwendung privater Daten ist jedoch Vorsicht geboten! Sicherheit ist eine große Sache. Darüber hinaus kann der Prozess der Beschaffung und Integration nicht öffentlicher Daten komplex sein.

4) Interaktives Lernen in Echtzeit mit der realen Welt: Lassen Sie das Modell durch direkte Interaktion mit der realen Welt lernen und sich verbessern. Dieser Ansatz erfordert, dass Modelle autonom und anpassungsfähig sind und in der Lage sind, Benutzeranweisungen genau zu verstehen und in der realen Welt Maßnahmen zu ergreifen.

Die vier von Epochai vorgeschlagenen Methoden haben jeweils ihre eigenen Vor- und Nachteile und stehen vor unterschiedlichen Herausforderungen. Die Frage, wie Datenprobleme in Zukunft effektiv gelöst werden können, wird sich direkt auf die Entwicklung und Anwendung der Technologie der künstlichen Intelligenz auswirken. Dies erfordert, dass wissenschaftliche Forscher und die Industrie zusammenarbeiten, um effektivere Wege zur Gewinnung und Nutzung von Daten zu finden, um eine nachhaltige und gesunde Entwicklung der künstlichen Intelligenz sicherzustellen.