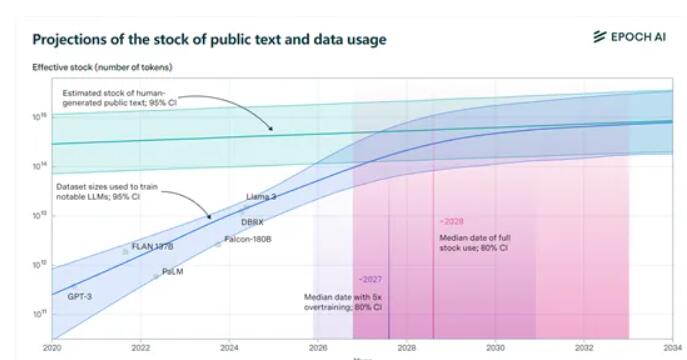

Epochai が発表した最新のレポートは、世界中で公開されている高品質のテキスト トレーニング データセットが、今後数年間で大規模な言語モデルによって使い果たされてしまうことを示しています。報告書は、2026年から2032年の間に、約300兆トークンの既存データが使い果たされると予測しており、モデルの「オーバートレーニング」がこのプロセスを加速させている。 Meta の Llama3 8B バージョンは、驚異的な 100 回のオーバートレーニングを受けると、2025 年までにデータが枯渇する可能性があります。来るべき「データ不足」に直面して、エポチャイは4つの潜在的な解決策を提案し、人工知能分野におけるデータ収集の新たな方向性を提供した。

研究者らは特に、「オーバートレーニング」がトレーニング データの消費を加速する主な原因であると指摘しました。たとえば、Meta の最新のオープンソース Llama3 の 8B バージョンには、驚くべき 100 回のオーバートレーニングがあります。すべてのモデルがこのように動作すると、2025 年にデータは別れを告げなければならない可能性があります。

でも心配しないでください、まだ方法はあります。 Epoch AI は、トレーニング データを取得するための 4 つの新しい方法を提供し、AI の世界での「データ不足」をもはや悪夢ではありません。

1) 合成データ: 調理キットから作られた食事と同じように、合成データはディープラーニングを使用して実際のデータをシミュレートし、まったく新しいデータを生成します。ただし、あまり早く興奮しすぎないでください。合成データの品質は不均一で、過剰適合しやすく、実際のテキストの微妙な言語的特徴が欠けている可能性があります。

2) マルチモーダルおよびクロスドメインのデータ学習: この方法はテキストに限定されず、画像、ビデオ、オーディオ、その他のデータ タイプも含まれます。 KTV と同様に、歌ったり踊ったりするだけでなく、マルチモーダル学習により、モデルが複雑なタスクをより包括的に理解して処理できるようになります。

3) プライベート データ: 現在、世界中のプライベート テキスト データの総量は約 3,100 兆トークンであり、これは公開データの 10 倍以上です。しかし、結局のところ、プライベート データを使用する場合は注意が必要です。セキュリティは大きな問題です。さらに、非公開データを取得して統合するプロセスは複雑になる場合があります。

4) 現実世界とのリアルタイム対話型学習: 現実世界との直接対話を通じてモデルを学習させ、改善させます。このアプローチでは、モデルが自律的で適応性があり、ユーザーの指示を正確に理解して現実世界でアクションを実行できる必要があります。

Epochai が提案する 4 つの方法には、それぞれ独自の長所と短所があり、異なる課題に直面しています。将来的には、データの問題を効果的に解決する方法は、人工知能技術の開発と応用に直接影響します。 そのためには、科学研究者と業界が協力して、人工知能の持続的かつ健全な発展を確実にするためにデータを取得して利用するより効果的な方法を模索する必要があります。