Zemi

1.0.0

可以在此處找到有關下載預處理數據集和預處理服裝數據集的說明

從:https://uofi.box.com/s/wnt6cv7icuir4q3wb2a6viuyklme5dga下載checkpoints 。將檢查點目錄放在zemi/output/p3_finetuning下的checkpoints中

使用conda env create -f environment.yml 。運行accelerate config以配置設備。

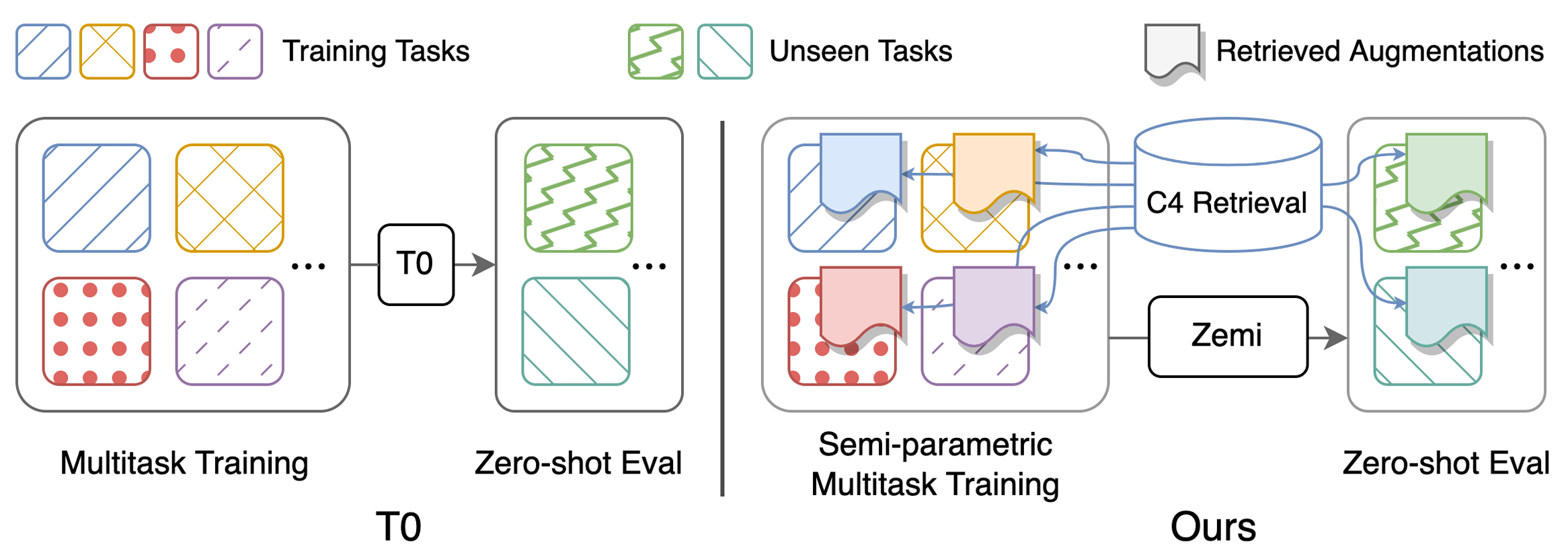

表1中重現主要結果的腳本:執行(半)參數多任務促使培訓和零射門評估。有關配置的詳細說明,請參見此處。所有腳本都應在zemi/下運行。 SETUP_ENV.sh將在以下腳本中調用以設置env變量。如果不使用與上述設置完全相同的文件夾結構,則可以修改變量。

bash ./training/no_aug_base.shbash ./training/no_aug_large.shbash ./training/concat_base.shbash ./training/concat_large.shbash ./training/fid_base.shbash ./training/fid_large.shbash ./training/zemi_base.sh zemi_base.shbash ./training/zemi_large.sh zemi/modeling_t5.py來自此行和zemi/modeling_xattn.pyzemi/multi_task_fine_tune_baseline.pyzemi/multi_task_fine_tune_xattn.pyzemi/eval_original_task_only.pyzemi/eval_original_task_only_xattn.py visualization/包含每個任務檢索的文檔的示例。我們包括在visualization/top50_highest_score_retrieval_instances和visualization/top50_lowest_score_retrieval_instances中包括最高和最低BM25分數的前50個示例。我們還包括每個數據集的前50個實例,而無需在visualization/first50_retrieval_instances中重新排序。

@article{wang2022zemi,

title={Zemi: Learning Zero-Shot Semi-Parametric Language Models from Multiple Tasks},

author={Wang, Zhenhailong and Pan, Xiaoman and Yu, Dian and Yu, Dong and Chen, Jianshu and Ji, Heng},

journal={arXiv preprint arXiv:2210.00185},

year={2022}

}