Les instructions sur le téléchargement des ensembles de données prétraités et des ensembles de données de costum de préparation peuvent être trouvés ici

Téléchargez checkpoints depuis: https://uofi.box.com/s/wnt6cv7icuir4q3wb2a6viuyklme5dga. Mettez les répertoires de points de contrôle dans checkpoints sous zemi/output/p3_finetuning

Configurez un environnement conda avec conda env create -f environment.yml . Exécutez accelerate config pour configurer le périphérique.

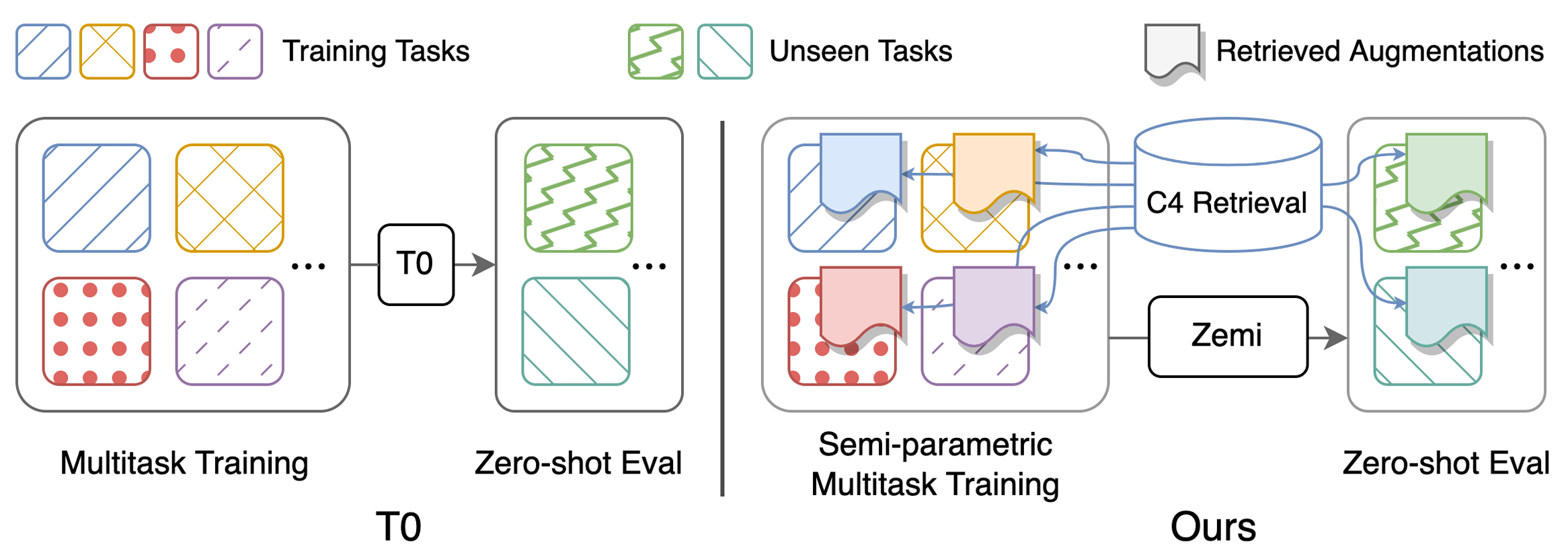

Scripts pour reproduire les principaux résultats du tableau 1: effectuer (semi-) paramétrique multitâche invité à la formation et à l'évaluation zéro-shot. Des instructions détaillées sur les configurations peuvent être trouvées ici. Tous les scripts doivent être exécutés sous zemi/ . SETUP_ENV.sh sera appelé dans les scripts suivants pour configurer les variables env. On peut modifier les variables si vous n'utilisez pas exactement la même structure de dossier que la configuration ci-dessus.

bash ./training/no_aug_base.shbash ./training/no_aug_large.shbash ./training/concat_base.shbash ./training/concat_large.shbash ./training/fid_base.shbash ./training/fid_large.shbash ./training/zemi_base.shbash ./training/zemi_large.sh zemi/modeling_t5.py à partir de cette ligne et zemi/modeling_xattn.pyzemi/multi_task_fine_tune_baseline.pyzemi/multi_task_fine_tune_xattn.pyzemi/eval_original_task_only.pyzemi/eval_original_task_only_xattn.py visualization/ Contient des exemples des documents récupérés pour chaque tâche. Nous incluons les 50 principaux exemples avec les scores BM25 les plus élevés et les plus bas dans visualization/top50_highest_score_retrieval_instances et visualization/top50_lowest_score_retrieval_instances . Nous incluons également les 50 premières instances pour chaque ensemble de données sans réorganiser dans visualization/first50_retrieval_instances .

@article{wang2022zemi,

title={Zemi: Learning Zero-Shot Semi-Parametric Language Models from Multiple Tasks},

author={Wang, Zhenhailong and Pan, Xiaoman and Yu, Dian and Yu, Dong and Chen, Jianshu and Ji, Heng},

journal={arXiv preprint arXiv:2210.00185},

year={2022}

}