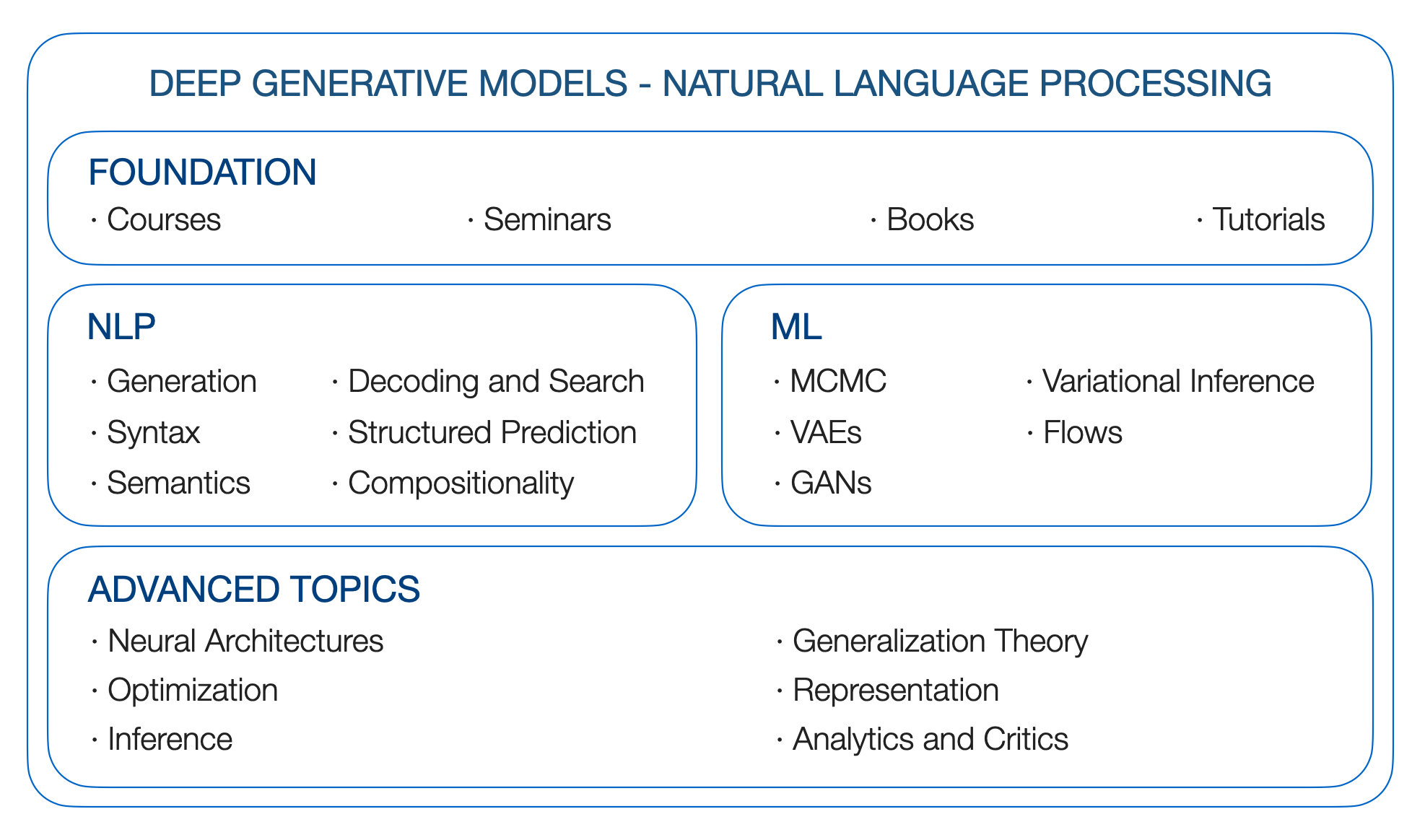

DGMS 4 NLP。自然語言處理的深層生成模型。路線圖。

Yao Fu,愛丁堡大學,[email protected]

**更新**:GPT如何獲得其能力?將語言模型的緊急能力追溯到其來源

**更新**:更仔細地查看語言模型緊急能力

**更新**:大型Languge模型

**更新**:遠程依賴關係;為什麼S4擅長長序列:記住具有在線函數近似的序列

** TODO 1 **:校準;提示;遠程變形金剛;州空間模型

** todo 2 **:矩陣分解和單詞嵌入;內核;高斯過程

** todo 3 **:推理與RL之間的關係;

(撰寫於2019年初,起源於哥倫比亞的DGM研討會)

為什麼我們想要深層的生成模型?因為我們想學習產生語言的基本因素。人類語言包含豐富的潛在因素,連續的因素可能是情感,意圖和其他人,離散/結構因素可能是pos/ ner標籤或語法樹。其中許多是潛在的,就像在大多數情況下一樣,我們只是觀察到句子。它們也是生成的:人類應該根據總體思想,當前情緒,語法以及我們可以或不能命名的所有其他事物產生語言。

如何以統計原則的方式對語言的生成過程進行建模?我們是否可以有一個靈活的框架,使我們能夠在擁有標籤時合併明確的監督信號,或者在沒有標籤但具有其他先驗知識的情況下添加遙遠的監督或邏輯/統計約束,或者在沒有標籤或先驗的情況下簡單地推斷出最有意義的內容?我們是否有可能在仍然是數學和概率的同時利用高級神經體系結構的建模能力? DGM允許我們實現這些目標。

讓我們開始旅程。

引用:

@article{yao2019DGM4NLP,

title = "Deep Generative Models for Natual Language Processing",

author = "Yao Fu",

year = "2019",

url = "https://github.com/FranxYao/Deep-Generative-Models-for-Natural-Language-Processing"

}

如何為NLP編寫變異推理和生成模型:食譜。對於初學者來說,強烈建議寫有關NLP VAE的論文。

關於自然語言的深層變量模型(鏈接),EMNLP 18的教程

NLP的潛在結構模型。 ACL 2019教程鏈接

哥倫比亞統計局8201-深刻的生成模型,約翰·坎寧安(John Cunningham)

Stanford CS 236-史蒂芬諾·埃爾蒙(Stefano Ermon)

U Toronto CS 2541-可區分推理和生成模型,CS 2547學習離散潛在結構,CSC 2547 2019年秋季:學習搜索。戴維·杜文納(David Duvenaud)

U Toronto Sta 4273冬季2021-最小化期望。克里斯·麥迪遜(Chris Maddison)

伯克利CS294-158-深度無監督的學習。由Pieter Abbeel

哥倫比亞STC 8101-表示學習:概率觀點。大衛·布萊(David Blei)

斯坦福大學CS324-大語言模型。珀西·梁,塔索里·橋本和克里斯托弗·雷

U多倫多CSC2541-神經網訓練動力學。羅傑·格羅斯(Roger Grosse)。

DGM的資金基於概率圖形模型。因此,我們查看以下資源

Blei的圖形模型基礎,哥倫比亞的STAT 6701(鏈接)

Xing的概率圖形模型,CMU(鏈接)的10-708

Collins的自然語言處理,COMS 4995在哥倫比亞(鏈接)

模式識別和機器學習。克里斯托弗·M·畢曉普(Christopher M. Bishop)。 2006

機器學習:概率的觀點。凱文·P·墨菲(Kevin P. Murphy)。 2012

圖形模型,指數族和變異推斷。 2008

語言結構預測。 2011

句法過程。 2000

從連續空間生成句子,conll 15

文本處理的神經變異推斷,ICML 16

學習文本生成的神經模板。 EMNLP 2018

基於剩餘的文本生成模型。 ICLR 20

用潛在單詞袋的釋義產生。 Neurips 2019。

Fairseq解碼庫。 [github]

控制能力神經文本生成[Lil'log]

最佳第一光束搜索。 TACL 2020

神經文本變性的奇怪案例。 ICLR 2020

從條件語言模型中比較各種解碼方法。 ACL 2019

隨機樑和在哪裡可以找到它們:無需替換的gumbel-top-k技巧。 ICML 19

有條件的泊松隨機梁搜索。 EMNLP 2021

使用晶格進行文本生成的大規模解碼。 2021

使用網格光束搜索詞素限制的解碼為序列生成。 ACL 2017

通過動態光束分配的神經機器翻譯,快速詞彙約束解碼。 NAACL 2018

改進的詞彙約束解碼,用於翻譯和單語言重寫。 NAACL 2019

旨在解碼為神經機器翻譯中的連續優化。 EMNLP 2017

梯度引導的無監督的詞彙約束文本生成。 EMNLP 2020

控製文本生成作為連續優化,並具有多個約束。 2021

神經科解碼:(聯合國)具有謂詞邏輯約束的監督神經文本生成。 NAACL 2021

神經系統解碼:具有LookAhead啟發式的限製文本產生。 2021

冷解碼:基於能量的限製文本生成具有langevin動力學。 2022

注意:我尚未完全瀏覽本章,請給我建議!

非自動回歸神經機器翻譯。 ICLR 2018

完全非自動入學的神經機器翻譯:貿易技巧。

使用離散潛在變量以序列模型進行快速解碼。 ICML 2021

Markov Transformers的級聯文本生成。 Arxiv 20

掃視變壓器,用於非自動回歸神經機器翻譯。 ACL 2021

托多:更多

提示論文,thunlp(鏈接)

CTRL:可控生成的條件變壓器語言模型。 Arxiv 2019

插件語言模型:一種簡單的控製文本生成方法

火炬結構:深層結構化預測庫。 github,紙,文檔

條件隨機字段的簡介。 2012

內部外部和前進算法只是反向傳播。 2016。

通過Fenchel-Young損失學習。 JMLR 2019

結構化注意網絡。 ICLR 2017

可區分的動態編程,用於結構化預測和注意力。 ICML 2018

復發性神經網絡語法。 NAACL 16

無監督的複發性神經網絡語法,NAACL 19

可區分的擾動和parse:半監督解析,具有結構化變異自動編碼器,ICLR 19

句法過程。 2020

語義上的語義角色標籤的自我注意力。 EMNLP 2018最佳紙張獎

語義解析具有半監督的順序自動編碼器。 2016

NLP中的組成概括。紙張清單

無系統性的概括:關於序列到序列復發網絡的組成技能。 ICML 2019

改進文本到SQL評估方法。 ACL 2018

使用馬爾可夫鏈蒙特卡洛方法的概率推斷。 1993

順序蒙特卡洛的元素(鏈接)

哈密頓蒙特卡洛(Link)的概念介紹

候選抽樣(鏈接)

噪聲構成的估計:未歸一化統計模型的新估計原理。 Aistata 2010

*抽樣。 NIPS 2014最佳紙張獎

劍橋變異推理閱讀組(鏈接)

變分推斷:統計學家的評論。

隨機變異推斷

隨機搜索的變異貝葉斯推斷。 ICML 12

自動編碼變種貝葉斯,ICLR 14

Beta-vae:以有限的變分框架學習基本的視覺概念。 ICLR 2017

重要性加權自動編碼器。 ICLR 2015

深層生成模型中的隨機反向傳播和近似推斷。 ICML 14

半損壞的變異自動編碼器,ICML 18

對抗正規化自動編碼器,ICML 18

有關重新聚集的更多信息:將高斯混合物,置換矩陣和排斥採樣器(伽瑪和迪里奇)重新聚集。

通過混合密度分佈的隨機反向傳播,Arxiv 16

通過接受拒絕採樣算法進行重新聚集梯度。 Aistats 2017

隱式重聚梯度。 Neurips 2018。

使用Gumbel-Softmax進行分類重新聚集。 ICLR 2017

混凝土分佈:連續放鬆離散隨機變量。 ICLR 2017

可逆的高斯重新聚體化:重新訪問Gumbel-Softmax。 2020

可通過連續放鬆來重新聚集的子集採樣。 IJCAI 2019

生成對抗網絡,NIPS 14

邁向培訓生成對抗網絡的原則方法,ICLR 2017

Wasserstein Gan

Infogan:可解釋的表示通過信息最大化生成對抗網的信息。 NIPS 2016

對抗性的推斷。 ICLR 2017

基於流量的深層生成模型,來自LIL的日誌

歸一流流量的變化推斷,ICML 15

通過標準化流程學習語言

改進的變異推理隨反向自迴旋流量

使用實際NVP估計密度估計。 ICLR 17

無視句法結構,具有可逆神經投影。 EMNLP 2018

離散序列的潛在標準化流量。 ICML 2019。

離散流:離散數據的可逆生成模型。 2019

FlowSeq:具有生成流動的非自動迴旋條件序列產生。 EMNLP 2019

差異神經機器翻譯具有歸一化流量。 ACL 2020

在預訓練語言模型的句子嵌入中。 EMNLP 2020

FY:需要查看如何將基於得分的生成模型和擴散模型用於離散序列

通過估計數據分佈的梯度來產生建模。博客2021

基於分數的生成建模論文

通過估計數據分佈的梯度來產生建模。 Neurips 2019

什麼是擴散模型? 2021

很棒的擴散模型

使用非平衡熱力學的深度無監督學習。 2015

剝離擴散概率模型。神經2020

Argmax流和多項式擴散:學習分配分佈。神經2021

離散狀態空間中的結構化deNo化擴散模型。神經2021

自回歸擴散模型。 ICLR 2022

擴散LM改善可控文本生成。 2022

具有深厚語言理解的感性文本對圖像擴散模型。 2022

有序神經元:整合成構成複發神經網絡的樹

RNN可以使用最佳內存生成有限的層次結構語言

分析多頭自我注意力:專業的負責人進行繁重的舉重,其餘的可以修剪。 ACL 2019

在神經序列模型中自我注意的理論局限性。 TACL 2019

重新考慮表演者的注意力。 2020

Thunlp:預訓練的lange型號紙列表(鏈接)

Tomohide Shibata的與Bert相關的論文

河馬:具有最佳多項式投影的複發記憶。神經2020

將經常性,卷積和連續的時時間模型與線性狀態空間層相結合。神經2021

有效地用結構化狀態空間對長序列進行建模。 ICLR 2022

為什麼S4擅長長序列:記住具有在線函數近似的序列。 2022

GPT3(175b)。語言模型是很少的學習者。 2020年5月

Megatron-Turing NLG(530b)。使用DeepSpeed和Megatron訓練大型生成語言模型的Megatron-Tring NLG 530B。 2022年1月

LAMDA(137b)。 LAMDA:對話應用程序的語言模型。 2022年1月

Gopher(280b)。縮放語言模型:訓練Gopher的方法,分析和見解。 2021年12月

Chinchilla(70b)。培訓計算最佳的大語言模型。 2022年3月

棕櫚(540b)。棕櫚:使用途徑進行縮放語言建模。 2022年4月

OPT(175b)。選擇:開放訓練的預訓練變壓器語言模型。 2022年5月

Bloom(176b):大科學大型開放科學開放式多語言語言模型。 2022年5月

Blenderbot 3(175b):一種部署的對話代理,不斷學習負責任地參與。 2022年8月

神經語言模型的縮放定律。 2020

大型語言模型的緊急能力。 2022

最小化期望。克里斯·麥迪遜(Chris Maddison)

機器學習中的蒙特卡洛梯度估計

蒙特卡洛目標的變異推斷。 ICML 16

鋼筋:離散潛在變量模型的低變化,無偏梯度估計。 nips 17

通過空隙的反向傳播:針對黑盒梯度估計的優化控制變體。 ICLR 18

使用釘子通過結構化gragmax進行反向傳播。 ACL 2018最佳紙張榮譽提名。

了解尖頭的力學:潛在結構學習的替代梯度。 EMNLP 2020

使用可微分的優化器學習。神經2020

帶有隨機軟磁技巧的梯度估計。神經2020

可區分的動態編程,用於結構化預測和注意力。 ICML 18

通過連續放鬆對分類網絡的隨機優化

使用最佳運輸的可區分等級和排序

對Birkhoff多層的重新聚集,以進行變異置換推斷。 Aistats 2018

稀疏和結構化神經關注的正規框架。 Neurips 2017

Sparsemap:可區分的稀疏結構化推理。 ICML 2018

帶有部分觀察到的treecrfs嵌套命名的實體識別。 AAAI 2021

Rao-Blackwellized隨機梯度用於離散分佈。 ICML 2019。

通過稀疏性對離散和結構化潛在變量的有效邊緣化。神經2020

結構性潛在變量模型的後正則化。 JMLR 2010

BlackBox生成的後控制。 2019

依賴性語法誘導,具有基於神經變化的解析器。 AAAI 2019

(中文)微分幾何與拓撲學簡明教程

只有貝葉斯應學習一個歧管(從數據中估算差異幾何結構)。 Arxiv 2018

深層生成模型的Riemannian幾何形狀。 CVPRW 2018

深層生成圖像模型及其應用的幾何形狀。 ICLR 2021

深層生成模型的指標。 Aistats 2017

在地球公制空間中,用於最低最大優化的一階算法。 2022

大規模內核機器的隨機功能。 Neurips 2007

找到隨機性的結構:用於構建近似矩陣分解的概率算法。暹羅2011

通過隨機伸縮總和對環和限制有效優化。 ICML 2019

伸縮密度比率估計。神經2020

通過隨機截斷的無偏見可擴展的高斯過程。 ICML 2021

隨機自動分化。 ICLR 2021

用隨機化縮放結構化推斷。 2021

信息理論的要素。封面和托馬斯。 1991

在互信息的各種界限上。 ICML 2019

通過共同的信息估計和最大化學習深度表示。 ICLR 2019

地雷:共同信息神經估計

深度變分信息瓶頸。 ICLR 2017

識別貝葉斯混合模型

分解各種自動編碼器中的分解。 ICML 2019

在無監督的分離表示的學習中,具有挑戰的共同假設。 ICML 2019

深度表示中不變性和脫離的出現

不變風險最小化

修復破碎的Elbo。 ICML 2018。

更緊密的變化界限不一定更好。 ICML 2018

連續的Bernoulli:修復變異自動編碼器中的普遍誤差。 Neurips 2019

深刻的生成模型知道他們不知道的東西嗎? ICLR 2019

有效估計深層生成語言模型。 ACL 2020

深神經網絡中貝葉斯的後驗有多好? ICML 2020

深神經網絡中冷後代的統計理論。 ICLR 2021

自迴旋模型及其替代方案的局限性。 NAACL 2021