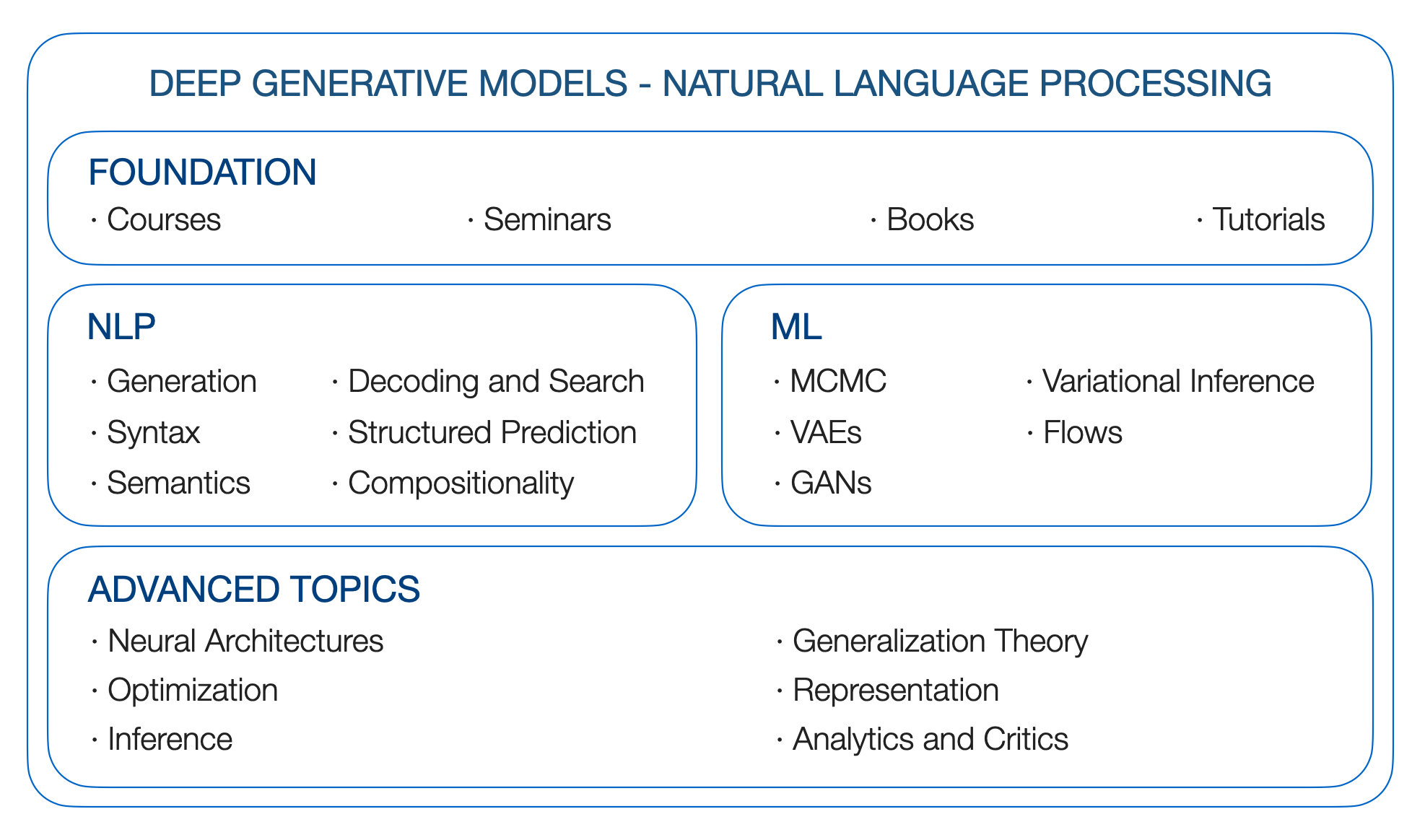

DGMS 4 NLP。自然语言处理的深层生成模型。路线图。

Yao Fu,爱丁堡大学,[email protected]

**更新**:GPT如何获得其能力?将语言模型的紧急能力追溯到其来源

**更新**:更仔细地查看语言模型紧急能力

**更新**:大型Languge模型

**更新**:远程依赖关系;为什么S4擅长长序列:记住具有在线函数近似的序列

** TODO 1 **:校准;提示;远程变形金刚;州空间模型

** todo 2 **:矩阵分解和单词嵌入;内核;高斯过程

** todo 3 **:推理与RL之间的关系;

(撰写于2019年初,起源于哥伦比亚的DGM研讨会)

为什么我们想要深层的生成模型?因为我们想学习产生语言的基本因素。人类语言包含丰富的潜在因素,连续的因素可能是情感,意图和其他人,离散/结构因素可能是pos/ ner标签或语法树。其中许多是潜在的,就像在大多数情况下一样,我们只是观察到句子。它们也是生成的:人类应该根据总体思想,当前情绪,语法以及我们可以或不能命名的所有其他事物产生语言。

如何以统计原则的方式对语言的生成过程进行建模?我们是否可以有一个灵活的框架,使我们能够在拥有标签时合并明确的监督信号,或者在没有标签但具有其他先验知识的情况下添加遥远的监督或逻辑/统计约束,或者在没有标签或先验的情况下简单地推断出最有意义的内容?我们是否有可能在仍然是数学和概率的同时利用高级神经体系结构的建模能力? DGM允许我们实现这些目标。

让我们开始旅程。

引用:

@article{yao2019DGM4NLP,

title = "Deep Generative Models for Natual Language Processing",

author = "Yao Fu",

year = "2019",

url = "https://github.com/FranxYao/Deep-Generative-Models-for-Natural-Language-Processing"

}

如何为NLP编写变异推理和生成模型:食谱。对于初学者来说,强烈建议写有关NLP VAE的论文。

关于自然语言的深层变量模型(链接),EMNLP 18的教程

NLP的潜在结构模型。 ACL 2019教程链接

哥伦比亚统计局8201-深刻的生成模型,约翰·坎宁安(John Cunningham)

Stanford CS 236-史蒂芬诺·埃尔蒙(Stefano Ermon)

U Toronto CS 2541-可区分推理和生成模型,CS 2547学习离散潜在结构,CSC 2547 2019年秋季:学习搜索。戴维·杜文纳(David Duvenaud)

U Toronto Sta 4273冬季2021-最小化期望。克里斯·麦迪逊(Chris Maddison)

伯克利CS294-158-深度无监督的学习。由Pieter Abbeel

哥伦比亚STC 8101-表示学习:概率观点。大卫·布莱(David Blei)

斯坦福大学CS324-大语言模型。珀西·梁,塔索里·桥本和克里斯托弗·雷

U多伦多CSC2541-神经网训练动力学。罗杰·格罗斯(Roger Grosse)。

DGM的资金基于概率图形模型。因此,我们查看以下资源

Blei的图形模型基础,哥伦比亚的STAT 6701(链接)

Xing的概率图形模型,CMU(链接)的10-708

Collins的自然语言处理,COMS 4995在哥伦比亚(链接)

模式识别和机器学习。克里斯托弗·M·毕晓普(Christopher M. Bishop)。 2006

机器学习:概率的观点。凯文·P·墨菲(Kevin P. Murphy)。 2012

图形模型,指数族和变异推断。 2008

语言结构预测。 2011

句法过程。 2000

从连续空间生成句子,conll 15

文本处理的神经变异推断,ICML 16

学习文本生成的神经模板。 EMNLP 2018

基于剩余的文本生成模型。 ICLR 20

用潜在单词袋的释义产生。 Neurips 2019。

Fairseq解码库。 [github]

控制能力神经文本生成[Lil'log]

最佳第一光束搜索。 TACL 2020

神经文本变性的奇怪案例。 ICLR 2020

从条件语言模型中比较各种解码方法。 ACL 2019

随机梁和在哪里可以找到它们:无需替换的gumbel-top-k技巧。 ICML 19

有条件的泊松随机梁搜索。 EMNLP 2021

使用晶格进行文本生成的大规模解码。 2021

使用网格光束搜索词素限制的解码为序列生成。 ACL 2017

通过动态光束分配的神经机器翻译,快速词汇约束解码。 NAACL 2018

改进的词汇约束解码,用于翻译和单语言重写。 NAACL 2019

旨在解码为神经机器翻译中的连续优化。 EMNLP 2017

梯度引导的无监督的词汇约束文本生成。 EMNLP 2020

控制文本生成作为连续优化,并具有多个约束。 2021

神经科解码:(联合国)具有谓词逻辑约束的监督神经文本生成。 NAACL 2021

神经系统解码:具有LookAhead启发式的限制文本产生。 2021

冷解码:基于能量的限制文本生成具有langevin动力学。 2022

注意:我尚未完全浏览本章,请给我建议!

非自动回归神经机器翻译。 ICLR 2018

完全非自动入学的神经机器翻译:贸易技巧。

使用离散潜在变量以序列模型进行快速解码。 ICML 2021

Markov Transformers的级联文本生成。 Arxiv 20

扫视变压器,用于非自动回归神经机器翻译。 ACL 2021

托多:更多

提示论文,thunlp(链接)

CTRL:可控生成的条件变压器语言模型。 Arxiv 2019

插件语言模型:一种简单的控制文本生成方法

火炬结构:深层结构化预测库。 github,纸,文档

条件随机字段的简介。 2012

内部外部和前进算法只是反向传播。 2016。

通过Fenchel-Young损失学习。 JMLR 2019

结构化注意网络。 ICLR 2017

可区分的动态编程,用于结构化预测和注意力。 ICML 2018

复发性神经网络语法。 NAACL 16

无监督的复发性神经网络语法,NAACL 19

可区分的扰动和parse:半监督解析,具有结构化变异自动编码器,ICLR 19

句法过程。 2020

语义上的语义角色标签的自我注意力。 EMNLP 2018最佳纸张奖

语义解析具有半监督的顺序自动编码器。 2016

NLP中的组成概括。纸张清单

无系统性的概括:关于序列到序列复发网络的组成技能。 ICML 2019

改进文本到SQL评估方法。 ACL 2018

使用马尔可夫链蒙特卡洛方法的概率推断。 1993

顺序蒙特卡洛的元素(链接)

哈密顿蒙特卡洛(Link)的概念介绍

候选抽样(链接)

噪声构成的估计:未归一化统计模型的新估计原理。 Aistata 2010

*抽样。 NIPS 2014最佳纸张奖

剑桥变异推理阅读组(链接)

变分推断:统计学家的评论。

随机变异推断

随机搜索的变异贝叶斯推断。 ICML 12

自动编码变种贝叶斯,ICLR 14

Beta-vae:以有限的变分框架学习基本的视觉概念。 ICLR 2017

重要性加权自动编码器。 ICLR 2015

深层生成模型中的随机反向传播和近似推断。 ICML 14

半损坏的变异自动编码器,ICML 18

对抗正规化自动编码器,ICML 18

有关重新聚集的更多信息:将高斯混合物,置换矩阵和排斥采样器(伽玛和迪里奇)重新聚集。

通过混合密度分布的随机反向传播,Arxiv 16

通过接受拒绝采样算法进行重新聚集梯度。 Aistats 2017

隐式重聚梯度。 Neurips 2018。

使用Gumbel-Softmax进行分类重新聚集。 ICLR 2017

混凝土分布:连续放松离散随机变量。 ICLR 2017

可逆的高斯重新聚体化:重新访问Gumbel-Softmax。 2020

可通过连续放松来重新聚集的子集采样。 IJCAI 2019

生成对抗网络,NIPS 14

迈向培训生成对抗网络的原则方法,ICLR 2017

Wasserstein Gan

Infogan:可解释的表示通过信息最大化生成对抗网的信息。 NIPS 2016

对抗性的推断。 ICLR 2017

基于流量的深层生成模型,来自LIL的日志

归一流流量的变化推断,ICML 15

通过标准化流程学习语言

改进的变异推理随反向自回旋流量

使用实际NVP估计密度估计。 ICLR 17

无视句法结构,具有可逆神经投影。 EMNLP 2018

离散序列的潜在标准化流量。 ICML 2019。

离散流:离散数据的可逆生成模型。 2019

FlowSeq:具有生成流动的非自动回旋条件序列产生。 EMNLP 2019

差异神经机器翻译具有归一化流量。 ACL 2020

在预训练语言模型的句子嵌入中。 EMNLP 2020

FY:需要查看如何将基于得分的生成模型和扩散模型用于离散序列

通过估计数据分布的梯度来产生建模。博客2021

基于分数的生成建模论文

通过估计数据分布的梯度来产生建模。 Neurips 2019

什么是扩散模型? 2021

很棒的扩散模型

使用非平衡热力学的深度无监督学习。 2015

剥离扩散概率模型。神经2020

Argmax流和多项式扩散:学习分配分布。神经2021

离散状态空间中的结构化deNo化扩散模型。神经2021

自回归扩散模型。 ICLR 2022

扩散LM改善可控文本生成。 2022

具有深厚语言理解的感性文本对图像扩散模型。 2022

有序神经元:整合成构成复发神经网络的树

RNN可以使用最佳内存生成有限的层次结构语言

分析多头自我注意力:专业的负责人进行繁重的举重,其余的可以修剪。 ACL 2019

在神经序列模型中自我注意的理论局限性。 TACL 2019

重新考虑表演者的注意力。 2020

Thunlp:预训练的lange型号纸列表(链接)

Tomohide Shibata的与Bert相关的论文

河马:具有最佳多项式投影的复发记忆。神经2020

将经常性,卷积和连续的时时间模型与线性状态空间层相结合。神经2021

有效地用结构化状态空间对长序列进行建模。 ICLR 2022

为什么S4擅长长序列:记住具有在线函数近似的序列。 2022

GPT3(175b)。语言模型是很少的学习者。 2020年5月

Megatron-Turing NLG(530b)。使用DeepSpeed和Megatron训练大型生成语言模型的Megatron-Tring NLG 530B。 2022年1月

LAMDA(137b)。 LAMDA:对话应用程序的语言模型。 2022年1月

Gopher(280b)。缩放语言模型:训练Gopher的方法,分析和见解。 2021年12月

Chinchilla(70b)。培训计算最佳的大语言模型。 2022年3月

棕榈(540b)。棕榈:使用途径进行缩放语言建模。 2022年4月

OPT(175b)。选择:开放训练的预训练变压器语言模型。 2022年5月

Bloom(176b):大科学大型开放科学开放式多语言语言模型。 2022年5月

Blenderbot 3(175b):一种部署的对话代理,不断学习负责任地参与。 2022年8月

神经语言模型的缩放定律。 2020

大型语言模型的紧急能力。 2022

最小化期望。克里斯·麦迪逊(Chris Maddison)

机器学习中的蒙特卡洛梯度估计

蒙特卡洛目标的变异推断。 ICML 16

钢筋:离散潜在变量模型的低变化,无偏梯度估计。 nips 17

通过空隙的反向传播:针对黑盒梯度估计的优化控制变体。 ICLR 18

使用钉子通过结构化gragmax进行反向传播。 ACL 2018最佳纸张荣誉提名。

了解尖头的力学:潜在结构学习的替代梯度。 EMNLP 2020

使用可微分的优化器学习。神经2020

带有随机软磁技巧的梯度估计。神经2020

可区分的动态编程,用于结构化预测和注意力。 ICML 18

通过连续放松对分类网络的随机优化

使用最佳运输的可区分等级和排序

对Birkhoff多层的重新聚集,以进行变异置换推断。 Aistats 2018

稀疏和结构化神经关注的正规框架。 Neurips 2017

Sparsemap:可区分的稀疏结构化推理。 ICML 2018

带有部分观察到的treecrfs嵌套命名的实体识别。 AAAI 2021

Rao-Blackwellized随机梯度用于离散分布。 ICML 2019。

通过稀疏性对离散和结构化潜在变量的有效边缘化。神经2020

结构性潜在变量模型的后正则化。 JMLR 2010

BlackBox生成的后控制。 2019

依赖性语法诱导,具有基于神经变化的解析器。 AAAI 2019

(中文)微分几何与拓扑学简明教程

只有贝叶斯应学习一个歧管(从数据中估算差异几何结构)。 Arxiv 2018

深层生成模型的Riemannian几何形状。 CVPRW 2018

深层生成图像模型及其应用的几何形状。 ICLR 2021

深层生成模型的指标。 Aistats 2017

在地球公制空间中,用于最低最大优化的一阶算法。 2022

大规模内核机器的随机功能。 Neurips 2007

找到随机性的结构:用于构建近似矩阵分解的概率算法。暹罗2011

通过随机伸缩总和对环和限制有效优化。 ICML 2019

伸缩密度比率估计。神经2020

通过随机截断的无偏见可扩展的高斯过程。 ICML 2021

随机自动分化。 ICLR 2021

用随机化缩放结构化推断。 2021

信息理论的要素。封面和托马斯。 1991

在互信息的各种界限上。 ICML 2019

通过共同的信息估计和最大化学习深度表示。 ICLR 2019

地雷:共同信息神经估计

深度变分信息瓶颈。 ICLR 2017

识别贝叶斯混合模型

分解各种自动编码器中的分解。 ICML 2019

在无监督的分离表示的学习中,具有挑战的共同假设。 ICML 2019

深度表示中不变性和脱离的出现

不变风险最小化

修复破碎的Elbo。 ICML 2018。

更紧密的变化界限不一定更好。 ICML 2018

连续的Bernoulli:修复变异自动编码器中的普遍误差。 Neurips 2019

深刻的生成模型知道他们不知道的东西吗? ICLR 2019

有效估计深层生成语言模型。 ACL 2020

深神经网络中贝叶斯的后验有多好? ICML 2020

深神经网络中冷后代的统计理论。 ICLR 2021

自回旋模型及其替代方案的局限性。 NAACL 2021