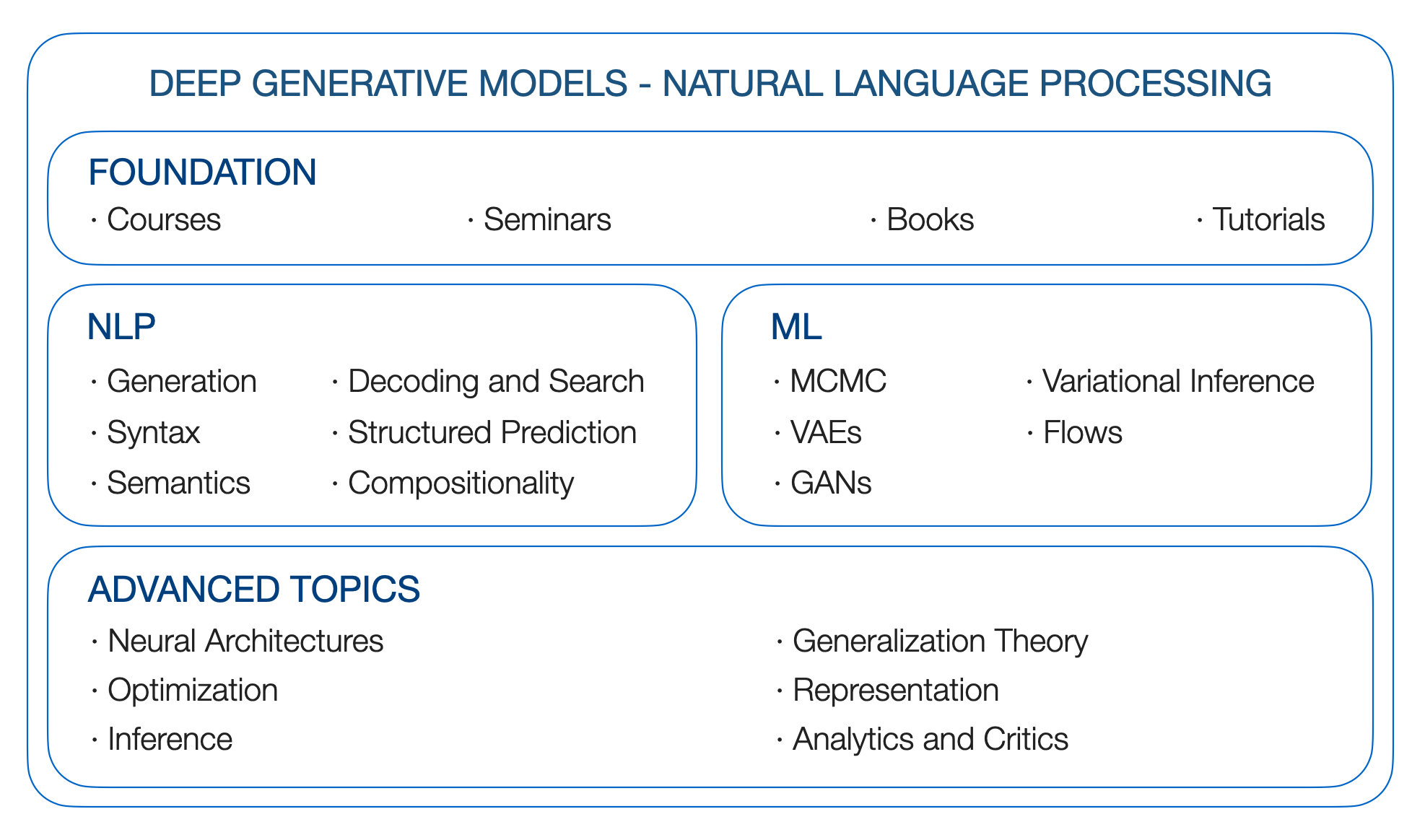

DGMS 4 NLP。自然言語処理のための深い生成モデル。ロードマップ。

Yao Fu、エジンバラ大学、[email protected]

**更新**:GPTはどのようにその能力を獲得しますか?言語モデルの緊急能力をソースに追跡します

**更新**:言語モデルの緊急能力を詳しく見る

**更新**:大規模な言語モデル

**更新**:長距離依存関係。 S4が長いシーケンスで優れている理由:オンライン関数近似でシーケンスを思い出す

** todo 1 **:キャリブレーション;プロンプト;長距離変圧器;状態空間モデル

** todo 2 **:マトリックスの因数分解と単語の埋め込み。カーネル;ガウスプロセス

** TODO 3 **:推論とRLの関係。

(2019年初頭に書かれ、コロンビアでのDGMセミナーから生まれました)

なぜ深い生成モデルが必要なのですか?言語を生成する基本的な要因を学びたいからです。人間の言語には豊富な潜在要因が含まれており、連続的な要因は感情、意図、その他である可能性があります。離散/構造的要因は、POS/ nerタグまたは構文の木である可能性があります。それらの多くは、ほとんどの場合と同様に潜在的であり、文を観察するだけです。また、生成的です。人間は、全体的なアイデア、現在の感情、構文、および名前を付けることができない、またはすべてのものに基づいて言語を作成する必要があります。

統計的に原則的な方法で言語の生成プロセスをモデル化する方法は?ラベルがあるときに明示的な監督信号を組み込むことができる柔軟なフレームワークを作成したり、ラベルがないが他の事前の知識がある場合に遠い監督や論理/統計的制約を追加したり、ラベルも事前にもないときに最も意味のあるものを推測することができますか?数学的で確率的でありながら、高度な神経アーキテクチャのモデリング力を活用する可能性はありますか? DGMにより、これらの目標を達成できます。

旅を始めましょう。

引用:

@article{yao2019DGM4NLP,

title = "Deep Generative Models for Natual Language Processing",

author = "Yao Fu",

year = "2019",

url = "https://github.com/FranxYao/Deep-Generative-Models-for-Natural-Language-Processing"

}

NLPの変分推論と生成モデルの書き方:レシピ。これは、初心者がNLPのVAEに関する論文を書いていることに強く提案されています。

自然言語の深い潜在変数モデルに関するチュートリアル(リンク)、EMNLP 18

NLPの潜在構造モデル。 ACL 2019チュートリアルリンク

コロンビア統計8201-ジョン・カニンガム著ディープ生成モデル

スタンフォードCS 236-ステファノ・エルモンによる深い生成モデル

U Toronto CS 2541-微分可能な推論と生成モデル、CS 2547学習離散潜在構造、CSC 2547 2019年秋:検索の学習。 David Duvenaudによる

UトロントSTA 4273 2021年冬 - 期待を最小限に抑える。クリス・マディソンによる

Berkeley CS294-158-監視されていない深い学習。ピーターアブビールによって

Columbia STCS 8101-表現学習:確率論的な視点。 David Bleiによる

スタンフォードCS324-大規模な言語モデル。 Percy Liang、Tatsunori Hashimoto、Christopher Re

UトロントCSC2541-ニューラルネットトレーニングダイナミクス。ロジャー・グロスによる。

DGMSの資金は、確率的グラフィカルモデルに基づいて構築されています。そのため、次のリソースをご覧ください

ブレイのグラフィカルモデルの基礎コース、コロンビアの統計6701(リンク)

Xingの確率的グラフィカルモデル、10-708 CMU(リンク)

コリンズの自然言語加工、コロンビアの4995(リンク)

パターン認識と機械学習。クリストファー・M・ビショップ。 2006年

機械学習:確率的視点。ケビンP.マーフィー。 2012年

グラフィカルモデル、指数ファミリ、および変分推論。 2008年

言語構造予測。 2011年

構文プロセス。 2000

連続空間から文を生成する、conll 15

テキスト処理のための神経変動推論、ICML 16

テキスト生成のためのニューラルテンプレートの学習。 EMNLP 2018

テキスト生成のための残留エネルギーベースのモデル。 ICLR 20

潜在的な言葉の袋で言い換えます。 Neurips 2019。

FairSeqデコードライブラリ。 [github]

コントロールベルニューラルテキスト生成[lil'log]

ベストファーストビーム検索。 TACL 2020

神経テキストの変性の奇妙なケース。 ICLR 2020

条件付き言語モデルからの多様なデコード方法の比較。 ACL 2019

確率的ビームとそれらを見つける場所:置換せずにサンプリングシーケンスのガンベルトップKトリック。 ICML 19

条件付きポアソン確率的ビーム検索。 EMNLP 2021

格子を使用したテキスト生成のための大規模なデコード。 2021

グリッドビーム検索を使用したシーケンス生成用の字句的に制約されたデコード。 ACL 2017

神経機械翻訳のための動的ビーム割り当てによる高速字句制約のデコード。 NAACL 2018

翻訳と単一言語の書き換えのための字句制約のデコードを改善しました。 NAACL 2019

神経機械翻訳における継続的な最適化としてのデコードに向けて。 EMNLP 2017

勾配誘導装飾されていない語彙的に制約されたテキスト生成。 EMNLP 2020

複数の制約を伴う継続的な最適化としての制御されたテキスト生成。 2021

神経学的解読:( UN)述語論理制約を備えた監督された神経テキスト生成。 NAACL 2021

神経学的A*エスクデコード:Lookahead Heuristicsを使用した制約テキスト生成。 2021

コールドデコード:ランジュビンダイナミクスによるエネルギーベースの制約テキスト生成。 2022

注:私はこの章を完全に説明していません。提案をしてください!

非自動性ニューラルマシンの翻訳。 ICLR 2018

完全に非自動性のあるニューラル機械翻訳:貿易のトリック。

離散潜在変数を使用したシーケンスモデルでの高速デコード。 ICML 2021

マルコフ変圧器を使用したカスケードテキスト生成。 arxiv 20

非自動性神経機械翻訳のための視線変圧器。 ACL 2021

TODO:それについてもっと

迅速な論文、thunlp(リンク)

CTRL:制御可能な生成のための条件付きトランス語モデル。 ARXIV 2019

言語モデルをプラグアンドプレイ:制御されたテキスト生成への簡単なアプローチ

トーチ構造:深い構造化された予測ライブラリ。 github、紙、ドキュメント

条件付きランダムフィールドの紹介。 2012年

インサイドアウトサイドとフォワードバックワードアルゴリズムは、バックプロップです。 2016年。

フェンチェルヨンの損失による学習。 JMLR 2019

構造化された注意ネットワーク。 ICLR 2017

構造化された予測と注意のための微分可能な動的プログラミング。 ICML 2018

再発性ニューラルネットワーク文法。 NAACL 16

監視されていない再発性ニューラルネットワーク文法、NAACL 19

微分可能なタートゥルとパルス:構造化された変動自動エンコーダー、ICLR 19を使用したセミスパイブ化された解析

構文プロセス。 2020

セマンティックロールラベル付けのための言語的に情報に基づいた自己告発。 EMNLP 2018 Best Paper Award

セミスパイブ化されたシーケンシャル自動エンコーダーを使用したセマンティック解析。 2016年

NLPの組成一般化。ペーパーリスト

体系性のない一般化:シーケンスからシーケンスの再発ネットワークの構成スキルについて。 ICML 2019

テキスト間評価方法論の改善。 ACL 2018

マルコフチェーンモンテカルロ法を使用した確率的推論。 1993年

シーケンシャルモンテカルロの要素(リンク)

ハミルトニアンモンテカルロ(リンク)の概念的紹介

候補サンプリング(リンク)

ノイズコンストラシスティブ推定:非正規化された統計モデルの新しい推定原則。 Aistata 2010

A*サンプリング。 NIPS 2014 Best Paper Award

ケンブリッジ変異推論読書グループ(リンク)

変動推論:統計学者のレビュー。

確率的変異推論

確率的検索による変分ベイジアン推論。 ICML 12

自動エンコード変異ベイズ、ICLR 14

Beta-Vae:制約された変動フレームワークを使用して、基本的な視覚概念を学習します。 ICLR 2017

重要な加重自動エンコーダー。 ICLR 2015

深い生成モデルにおける確率的バックプロパゲーションと近似推論。 ICML 14

半層化変分自動エンコーダー、ICML 18

敵対的に正規化された自動エンコーダー、ICML 18

修復の詳細:ガウス混合物、順列マトリックス、および拒絶サンプラー(ガンマとディリクレ)を再分析する。

混合密度分布を介した確率的バックプロパゲーション、arxiv 16

受け入れrefictionサンプリングアルゴリズムを介した勾配の勾配。 Aistats 2017

暗黙的なリダメータ化勾配。 Neurips 2018。

Gumbel-SoftMaxによるカテゴリの再評価。 ICLR 2017

コンクリート分布:離散ランダム変数の連続緩和。 ICLR 2017

反転性ガウスの再評価:ガンベルソフトマックスの再訪。 2020

連続的な緩和によるレパラメテロ化可能なサブセットサンプリング。 IJCAI 2019

生成敵のネットワーク、NIPS 14

生成敵のネットワークをトレーニングするための原則的な方法に向けて、ICLR 2017

ワッサースタインガン

Infogan:生成的敵対網を最大化する情報による解釈可能な表現学習。 NIPS 2016

敵対的に学んだ推論。 ICLR 2017

Lilのログから、フローベースの深い生成モデル

正規化フローを伴う変動推論、ICML 15

正規化フローで言語について学ぶ

逆自己回帰流による変分推論の改善

実際のNVPを使用した密度推定。 ICLR 17

可逆的な神経突起を伴う構文構造の教師なし学習。 EMNLP 2018

離散シーケンスの潜在的正規化フロー。 ICML 2019。

離散フロー:離散データの可逆生成モデル。 2019年

FlowSeq:生成フローを伴う非自動性条件シーケンス生成。 EMNLP 2019

正規化フローを備えた分散ニューラル機械翻訳。 ACL 2020

事前に訓練された言語モデルからの文の埋め込み。 EMNLP 2020

FY:スコアベースの生成モデルと拡散モデルを離散シーケンスに使用する方法を確認する必要があります

データ分布の勾配を推定することによる生成モデリング。ブログ2021

スコアベースの生成モデリングペーパー

データ分布の勾配を推定することによる生成モデリング。 Neurips 2019

拡散モデルとは何ですか? 2021

素晴らしい拡散モデル

非平衡熱力学を使用した深い教師の学習。 2015年

拡散確率モデルを除去します。ニューリップ2020

Argmaxの流れと多項拡散:学習カテゴリー分布。ニューリップ2021

個別の状態空間における構造化された拡散モデル。ニューリップ2021

自己回帰拡散モデル。 ICLR 2022

拡散LMは、制御可能なテキスト生成を改善します。 2022

深い言語理解を備えたフォトリアリックなテキストから画像間拡散モデル。 2022

注文ニューロン:再発性ニューラルネットワークに構造化されたツリーを統合します

RNNは、最適なメモリを備えた境界階層言語を生成できます

マルチヘッドの自己告発の分析:専門のヘッドは重い持ち上げを行い、残りは剪定することができます。 ACL 2019

神経シーケンスモデルにおける自己関節の理論的制限。 TACL 2019

パフォーマーとの注意を再考します。 2020

thunlp:事前に訓練された言語モデルペーパーリスト(リンク)

Tomohide ShibataのBert関連の論文

Hippo:最適な多項式投影を伴う再発メモリ。ニューリップ2020

再発性、畳み込み、および連続時間モデルと線形状態空間層を組み合わせます。ニューリップ2021

構造化された状態空間で長いシーケンスを効率的にモデリングします。 ICLR 2022

S4が長いシーケンスで優れている理由:オンライン関数近似でシーケンスを思い出します。 2022

GPT3(175b)。言語モデルは、少ないショット学習者です。 2020年5月

Megatron-Turing NLG(530b)。 DeepspeedとMegatronを使用して、大規模な生成言語モデルであるMegatron-Turing NLG 530Bをトレーニングします。 2022年1月

ラムダ(137b)。 Lamda:ダイアログアプリケーションの言語モデル。 2022年1月

Gopher(280b)。言語モデルのスケーリング:トレーニングGopherからの方法、分析、洞察。 2021年12月

チンチラ(70b)。 Training Compute-Optimal Large Languals Models。 2022年3月

パーム(540b)。 Palm:経路を使用した言語モデリングのスケーリング。 2022年4月

OPT(175b)。 OPT:事前に訓練されたトランス語モデルを開きます。 2022年5月

Bloom(176b):BigScienceの大規模なオープンサイエンスオープンアクセス多言語言語モデル。 2022年5月

BlenderBot 3(175b):責任を持って関与することを継続的に学習する展開された会話エージェント。 2022年8月

神経言語モデルのスケーリング法則。 2020

大規模な言語モデルの緊急能力。 2022

期待を最小限に抑える。クリス・マディソン

機械学習におけるモンテカルロ勾配推定

モンテカルロの目的に対する変動推論。 ICML 16

鉄筋:離散潜在変数モデルの低変数、偏りのない勾配推定値。 NIPS 17

voidによるバックプロパゲーション:ブラックボックス勾配推定のコントロールの最適化。 ICLR 18

Spigotを使用して構造化されたArgmaxを介してバックプロパギング。 ACL 2018ベストペーパー名誉ある言及。

スピゴットのメカニズムを理解する:潜在的な構造学習のためのサロゲートグラデーション。 EMNLP 2020

微分可能な摂動オプティマイザーを使用した学習。ニューリップ2020

確率的ソフトマックストリックによる勾配推定。ニューリップ2020

構造化された予測と注意のための微分可能な動的プログラミング。 ICML 18

連続的な緩和によるネットワークの並べ替えの確率的最適化

最適な輸送を使用した微分ランクと並べ替え

変動順列推論のためにBirkhoffポリトープを修復します。 Aistats 2018

まばらで構造化された神経注意のための正則化されたフレームワーク。 Neurips 2017

SPARSEMAP:微分可能なスパース構造推論。 ICML 2018

部分的に観察されたTREECRFを使用して、ネストされた名前付きエンティティ認識。 AAAI 2021

rao-lackwellized分離分布のための確率勾配。 ICML 2019。

スパースを介した離散および構造化された潜在変数の効率的な疎外。ニューリップ2020

構造化された潜在変数モデルの事後正規化。 JMLR 2010

ブラックボックス生成の事後制御。 2019年

神経変異遷移ベースのパーサーによる依存性文法誘導。 AAAI 2019

(中国語)微分几何与拓扑学简明教程

ベイズのみがマニホールドを学習する必要があります(データからの幾何学的構造の差が推定されます)。 ARXIV 2018

深い生成モデルのリーマニアの幾何学。 CVPRW 2018

ディープ生成画像モデルのジオメトリとそのアプリケーション。 ICLR 2021

深い生成モデルのメトリック。 Aistats 2017

測地線測定スペースにおけるMIN-MAX最適化のための1次アルゴリズム。 2022

大規模なカーネルマシンのランダム機能。 Neurips 2007

ランダム性のある構造を見つける:おおよそのマトリックス分解を構築するための確率的アルゴリズム。 SIAM 2011

ランダム化された望遠鏡の合計によるループと制限の効率的な最適化。 ICML 2019

伸縮密度比推定の推定。ニューリップ2020

ランダム化された切り捨てによるバイアスフリーのスケーラブルなガウスプロセス。 ICML 2021

ランダム化された自動分化。 ICLR 2021

ランダム化による構造的推論のスケーリング。 2021

情報理論の要素。カバーとトーマス。 1991年

相互情報の変動境界について。 ICML 2019

相互情報の推定と最大化による深い表現を学習します。 ICLR 2019

鉱山:相互情報神経の推定

深い変動情報ボトルネック。 ICLR 2017

ベイジアン混合モデルの識別

変分自動エンコーダーの解き角を解き放つ。 ICML 2019

監視されていない表現の監視されていない学習における一般的な仮定に挑戦します。 ICML 2019

深い表現における不変性と解き分析の出現

不変リスク最小化

壊れたエルボを修正します。 ICML 2018。

よりタイトな変分の境界は必ずしもより良いとは限りません。 ICML 2018

連続ベルヌーリ:変分自動エンコーダーの広範なエラーの修正。 Neurips 2019

深い生成モデルは、彼らが知らないことを知っていますか? ICLR 2019

深い生成言語モデルの効果的な推定。 ACL 2020

深いニューラルネットワークのベイズ後部は本当にどれくらい良いですか? ICML 2020

深いニューラルネットワークにおける寒冷後部の統計理論。 ICLR 2021

自己回帰モデルの制限とその代替案。 NAACL 2021