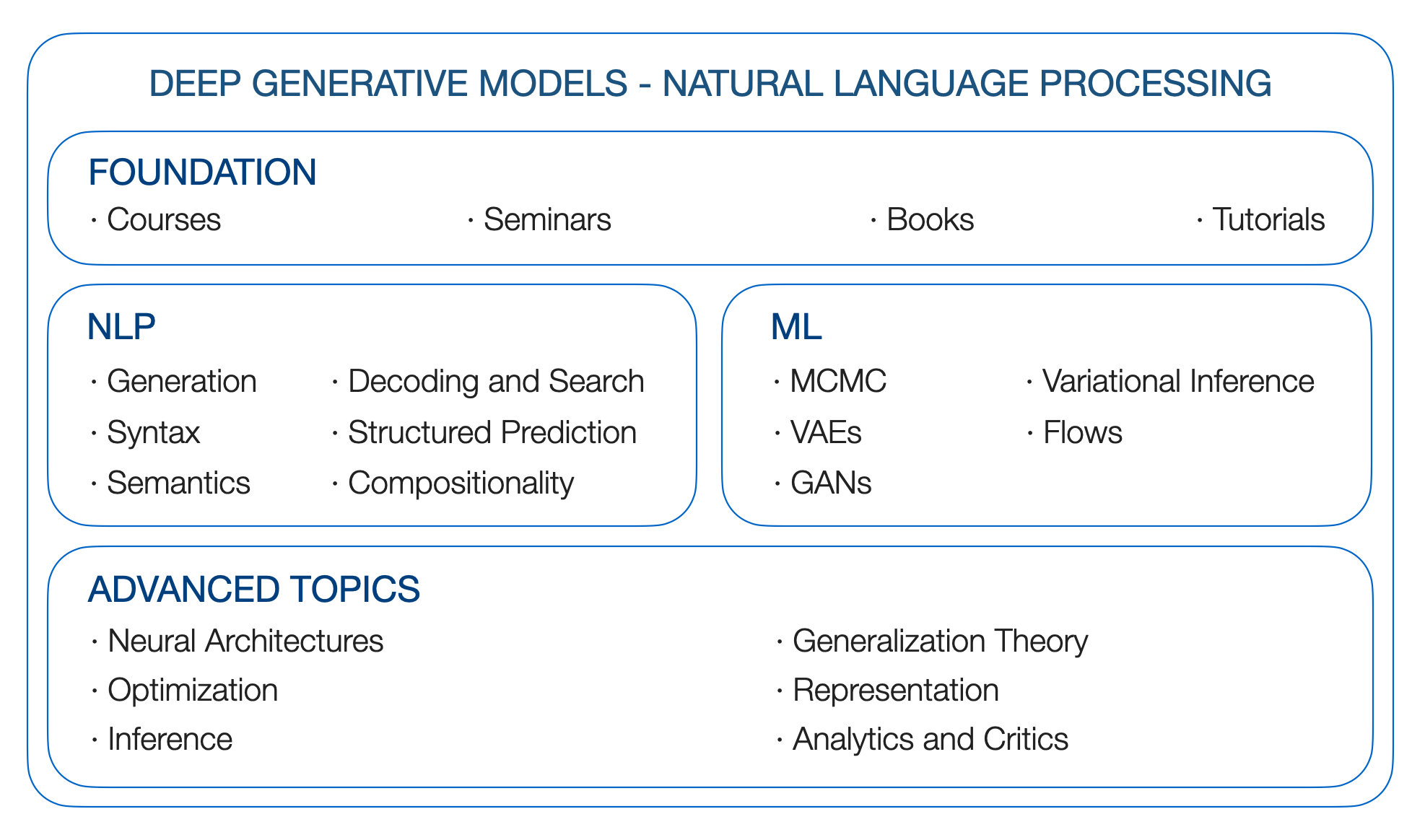

DGMS 4 NLP. Model generatif yang dalam untuk pemrosesan bahasa alami. Peta jalan.

Yao Fu, Universitas Edinburgh, [email protected]

** Pembaruan **: Bagaimana GPT memperoleh kemampuannya? Menelusuri Kemampuan Muncul Model Bahasa ke Sumber Mereka

** UPDATE **: Pandangan yang lebih dekat pada Model Bahasa Kemampuan Muncul

** Pembaruan **: Model Lak Besar

** Pembaruan **: Ketergantungan jarak jauh; Mengapa S4 Baik Dalam Urutan Panjang: Mengingat Urutan Dengan Perkiraan Fungsi Online

** TODO 1 **: kalibrasi; Dorongan; Transformator jarak jauh; Model ruang negara bagian

** TODO 2 **: Faktorisasi matriks dan embedding kata; Kernel; Proses Gaussian

** TODO 3 **: Hubungan antara inferensi dan RL;

(Ditulis pada awal 2019, berasal dari seminar DGM di Columbia)

Mengapa kita menginginkan model generatif yang dalam? Karena kami ingin mempelajari faktor -faktor dasar yang menghasilkan bahasa. Bahasa manusia mengandung faktor -faktor laten yang kaya, yang terus menerus mungkin adalah emosi, niat, dan lainnya, faktor -faktor diskrit/ struktural mungkin merupakan tag pos/ ner atau pohon sintaksis. Banyak dari mereka laten seperti dalam kebanyakan kasus, kami hanya mengamati kalimat. Mereka juga generatif: manusia harus menghasilkan bahasa berdasarkan ide keseluruhan, emosi saat ini, sintaks, dan semua hal lain yang dapat atau tidak dapat kita beri nama.

Bagaimana cara memodelkan proses generatif bahasa dengan cara yang berprinsip secara statistik? Bisakah kita memiliki kerangka kerja fleksibel yang memungkinkan kita untuk memasukkan sinyal pengawasan eksplisit ketika kita memiliki label, atau menambah pengawasan yang jauh atau kendala logis/ statistik ketika kita tidak memiliki label tetapi memiliki pengetahuan sebelumnya, atau hanya menyimpulkan apa pun yang paling masuk akal ketika kita tidak memiliki label atau apriori? Mungkinkah kita mengeksploitasi kekuatan pemodelan arsitektur saraf canggih sambil tetap menjadi matematis dan probabilistik? DGM memungkinkan kami untuk mencapai tujuan ini.

Mari kita mulai perjalanan.

Kutipan:

@article{yao2019DGM4NLP,

title = "Deep Generative Models for Natual Language Processing",

author = "Yao Fu",

year = "2019",

url = "https://github.com/FranxYao/Deep-Generative-Models-for-Natural-Language-Processing"

}

Cara Menulis Inferensi Variasional dan Model Generatif untuk NLP: Resep. Ini sangat disarankan untuk makalah menulis pemula tentang VAE untuk NLP.

Tutorial tentang model variabel laten dalam bahasa alami (tautan), EMNLP 18

Model Struktur Laten untuk NLP. ACL 2019 Tutorial Link

Columbia Stat 8201 - Model Generatif yang Dalam, oleh John Cunningham

Stanford CS 236 - Model generatif yang dalam, oleh Stefano Ermon

U Toronto CS 2541 - Model inferensi dan generatif yang dapat dibedakan, CS 2547 Pembelajaran Struktur Laten Diskrit, CSC 2547 Musim Gugur 2019: Belajar mencari. Oleh David Duvenaud

U Toronto STA 4273 Musim Dingin 2021 - Meminimalkan harapan. Oleh Chris Maddison

Berkeley CS294-158 - Pembelajaran yang tidak diawasi. Oleh Pieter Abbeel

Columbia STCS 8101 - Pembelajaran Representasi: Perspektif Probabilistik. Oleh David Blei

Stanford CS324 - Model Bahasa Besar. Oleh Percy Liang, Tatsunori Hashimoto dan Christopher RE

U Toronto CSC2541 - Dinamika Pelatihan Bersih Neural. Oleh Roger Grosse.

Fundasi DGM dibangun di atas model grafis probabilistik. Jadi kita melihat sumber daya berikut

Foundation of Graphical Models Course Blei, Stat 6701 di Columbia (tautan)

Model Grafis Probabilistik Xing, 10-708 di CMU (tautan)

Pemrosesan Bahasa Alami Collins, Coms 4995 di Columbia (tautan)

Pengenalan pola dan pembelajaran mesin. Christopher M. Bishop. 2006

Pembelajaran mesin: Perspektif probabilistik. Kevin P. Murphy. 2012

Model grafis, keluarga eksponensial, dan inferensi variasional. 2008

Prediksi struktur linguistik. 2011

Proses sintaksis. 2000

Menghasilkan kalimat dari ruang kontinu, Conll 15

Inferensi variasional saraf untuk pemrosesan teks, ICML 16

Mempelajari templat saraf untuk pembuatan teks. EMNLP 2018

Model berbasis energi residual untuk pembuatan teks. Iclr 20

Generasi parafrase dengan kantong kata -kata laten. Neurips 2019.

Perpustakaan Decoding Fairseq. [GitHub]

Controllabel Generasi Teks Saraf [Lil'log]

Pencarian balok terlebih dahulu. TACL 2020

Kasus penasaran dari degenerasi teks saraf. ICLR 2020

Perbandingan beragam metode decoding dari model bahasa bersyarat. ACL 2019

Balok stokastik dan di mana menemukannya: trik gumbel-top-k untuk urutan pengambilan sampel tanpa penggantian. ICML 19

Pencarian balok stokastik Poisson bersyarat. EMNLP 2021

Decoding skala besar untuk pembuatan teks menggunakan kisi. 2021

Decoding yang dibatasi secara leksikal untuk generasi urutan menggunakan pencarian balok grid. ACL 2017

Decoding yang dibatasi secara leksikal dengan alokasi sinar dinamis untuk terjemahan mesin saraf. NAACL 2018

Peningkatan decoding yang dibatasi secara leksikal untuk terjemahan dan penulisan ulang monolingual. NAACL 2019

Menuju decoding sebagai optimasi berkelanjutan dalam terjemahan mesin saraf. EMNLP 2017

Generasi teks yang dibatasi secara gradien yang dipandu secara tidak diawasi. EMNLP 2020

Pembuatan teks terkontrol sebagai optimasi kontinu dengan banyak kendala. 2021

Decoding neurologis: (PBB) Generasi teks saraf yang diawasi dengan batasan logika predikat. NAACL 2021

Neurologis A*Esque Decoding: Generasi teks terbatas dengan heuristik lookahead. 2021

Decoding Dingin: Pembuatan teks terbatas berbasis energi dengan dinamika Langevin. 2022

Catatan: Saya belum sepenuhnya melalui bab ini, tolong beri saya saran!

Terjemahan Mesin Saraf Non-Autoregressive. ICLR 2018

Terjemahan mesin saraf yang sepenuhnya non-autoregresif: trik perdagangan.

Decoding cepat dalam model urutan menggunakan variabel laten diskrit. ICML 2021

Generasi teks bertingkat dengan transformator Markov. Arxiv 20

Lirik Transformator untuk Terjemahan Mesin Saraf Non-Autoregressive. ACL 2021

TODO: lebih lanjut tentang itu

Makalah prompt, thunlp (tautan)

CTRL: Model bahasa transformator bersyarat untuk generasi yang dapat dikendalikan. ARXIV 2019

Model Bahasa plug and Play: Pendekatan sederhana untuk pembuatan teks yang dikendalikan

Torch-struktur: Perpustakaan prediksi terstruktur dalam. GitHub, kertas, dokumentasi

Pengantar bidang acak bersyarat. 2012

Algoritma dalam-luar dan maju-mundur hanyalah backprop. 2016.

Belajar dengan kerugian fenchel-young. JMLR 2019

Jaringan perhatian terstruktur. ICLR 2017

Pemrograman dinamis yang dapat dibedakan untuk prediksi dan perhatian terstruktur. ICML 2018

Tata bahasa jaringan saraf berulang. NAACL 16

Tata Bahasa Jaringan Saraf Berulang Tanpa Pengawasan, NAACL 19

Parsing-and-Parse yang Diferensial: Parsing semi-diawasi dengan autoencoder variasional terstruktur, ICLR 19

Proses sintaksis. 2020

Perhatian diri yang diinformasikan secara linguistik untuk pelabelan peran semantik. EMNLP 2018 Best Paper Award

Parsing semantik dengan autoencoders berurutan semi-diawasi. 2016

Generalisasi komposisi di NLP. Daftar Kertas

Generalisasi Tanpa Sistematisitas: Pada keterampilan komposisi jaringan berulang urutan-ke-urutan. ICML 2019

Meningkatkan metodologi evaluasi teks-ke-SQL. ACL 2018

Inferensi Probabilistik Menggunakan Metode Rantai Markov Monte Carlo. 1993

Elemen dari Sequential Monte Carlo (tautan)

Pengantar Konseptual untuk Hamiltonian Monte Carlo (tautan)

Calon Pengambilan Sampel (Tautan)

Estimasi Konstruktif Kebisingan: Prinsip Estimasi Baru untuk Model Statistik yang Tidak Diformalisasi. Aistata 2010

A* pengambilan sampel. NIPS 2014 Best Paper Award

Kelompok Pembacaan Inferensi Variasional Cambridge (tautan)

Inferensi Variasional: Ulasan untuk ahli statistik.

Inferensi variasional stokastik

Variasional Bayesian Inference dengan pencarian stokastik. ICML 12

Auto-Encoding Variational Bayes, ICLR 14

Beta-vae: Mempelajari konsep visual dasar dengan kerangka kerja variasional yang terbatas. ICLR 2017

Pentingnya Autoencoders tertimbang. ICLR 2015

Stochastic backpropagation dan perkiraan inferensi pada model generatif yang dalam. ICML 14

Autoencoders variasional semi-amortisasi, ICML 18

Autoencoders yang diatur secara bermusuhan, ICML 18

Lebih lanjut tentang reparameterisasi: untuk reparameterisasi campuran Gaussian, matriks permutasi, dan sampler penolakan (gamma dan dirichlet).

Stochastic backpropagation melalui distribusi kepadatan campuran, arxiv 16

Gradien reparameterisasi melalui algoritma pengambilan sampel penerimaan-penolakan. Aistats 2017

Gradien reparameterisasi implisit. Neurips 2018.

Reparameterisasi kategori dengan gumbel-softmax. ICLR 2017

Distribusi beton: relaksasi terus menerus dari variabel acak diskrit. ICLR 2017

Reparameterisasi Gaussian Invertible: Meninjau kembali Gumbel-Softmax. 2020

Pengambilan sampel subset yang dapat diulang -ulang melalui relaksasi berkelanjutan. IJCAI 2019

Jaringan permusuhan generatif, nips 14

Menuju metode prinsip untuk melatih jaringan permusuhan generatif, ICLR 2017

Wasserstein Gan

Infogan: Pembelajaran Representasi yang Dapat Ditafsirkan dengan informasi yang memaksimalkan jaring permusuhan generatif. NIPS 2016

Kesimpulan yang dipelajari secara bermusuhan. ICLR 2017

Model generatif mendalam berbasis aliran, dari Lil's Log

Inferensi variasional dengan aliran normalisasi, ICML 15

Belajar tentang bahasa dengan arus normalisasi

Peningkatan inferensi variasional dengan aliran autoregresif terbalik

Estimasi kepadatan menggunakan NVP nyata. Iclr 17

Pembelajaran tanpa pengawasan tentang struktur sintaksis dengan proyeksi saraf yang dapat dibalik. EMNLP 2018

Aliran normalisasi laten untuk urutan diskrit. ICML 2019.

Aliran diskrit: Model generatif yang dapat dibalik dari data diskrit. 2019

Flowseq: Generasi urutan bersyarat non-autoregresif dengan aliran generatif. EMNLP 2019

Terjemahan mesin saraf variasional dengan aliran normalisasi. ACL 2020

Pada kalimat embeddings dari model bahasa pra-terlatih. EMNLP 2020

TA: Perlu melihat bagaimana model generatif berbasis skor dan model difusi dapat digunakan untuk urutan diskrit

Pemodelan generatif dengan memperkirakan gradien distribusi data. Blog 2021

Makalah pemodelan generatif berbasis skor

Pemodelan generatif dengan memperkirakan gradien distribusi data. Neurips 2019

Apa itu model difusi? 2021

Model difusi yang mengagumkan

Pembelajaran tanpa pengawasan yang dalam menggunakan termodinamika nonequilibrium. 2015

Model probabilistik difusi denoising. Neurips 2020

Argmax mengalir dan difusi multinomial: pembelajaran distribusi kategori. Neurips 2021

Model difusi denoising terstruktur dalam ruang negara diskrit. Neurips 2021

Model Difusi Autoregresif. ICLR 2022

Difusi-LM meningkatkan pembuatan teks yang dapat dikendalikan. 2022

Model difusi teks-ke-gambar fotorealistik dengan pemahaman bahasa yang mendalam. 2022

Neuron yang dipesan: Mengintegrasikan pohon yang terstruktur ke dalam jaringan saraf berulang

RNNs dapat menghasilkan bahasa hierarkis yang dibatasi dengan memori yang optimal

Menganalisis Multi-Head Self-Itention: Kepala Khusus melakukan pengangkatan berat, sisanya dapat dipangkas. ACL 2019

Keterbatasan teoritis perhatian diri dalam model urutan saraf. TACL 2019

Memikirkan kembali perhatian dengan pemain. 2020

THUNLP: Daftar kertas model lange pra-terlatih (tautan)

Kertas-kertas terkait Bert Tomohide Shibata

Hippo: Memori berulang dengan proyeksi polinomial yang optimal. Neurips 2020

Menggabungkan model waktu yang berulang, konvolusional, dan kontinu dengan lapisan ruang negara linier. Neurips 2021

Pemodelan urutan panjang secara efisien dengan ruang keadaan terstruktur. ICLR 2022

Mengapa S4 bagus dalam urutan panjang: Mengingat urutan dengan perkiraan fungsi online. 2022

GPT3 (175b). Model bahasa adalah pelajar beberapa shot. Mei 2020

Megatron-Turing NLG (530B). Menggunakan Deepspeed dan Megatron untuk melatih Megatron-Turing NLG 530B, model bahasa generatif skala besar. Jan 2022

LAMDA (137B). LAMDA: Model bahasa untuk aplikasi dialog. Jan 2022

Gopher (280b). Model Bahasa Skala: Metode, Analisis & Wawasan dari Pelatihan Gopher. Desember 2021

Chinchilla (70b). Model bahasa besar komputasi-optimal. Mar 2022

Palm (540b). Palm: Pemodelan bahasa penskalaan dengan jalur. Apr 2022

Opt (175b). OPT: Buka model bahasa transformator pra-terlatih. Mei 2022

Bloom (176b): BigScience Model Bahasa Multilingual Akses Terbuka Terbuka Besar. Mei 2022

BlenderBot 3 (175B): Agen percakapan yang digunakan terus -menerus belajar untuk terlibat secara bertanggung jawab. Agustus 2022

Penskalaan hukum untuk model bahasa saraf. 2020

Kemampuan yang muncul dari model bahasa besar. 2022

Meminimalkan harapan. Chris Maddison

Estimasi Gradien Monte Carlo dalam Pembelajaran Mesin

Inferensi variasional untuk tujuan Monte Carlo. ICML 16

Rebar: Estimasi gradien yang tidak bias dan tidak bias untuk model variabel laten diskrit. Nips 17

Backpropagation melalui void: Mengoptimalkan variasi kontrol untuk estimasi gradien kotak hitam. Iclr 18

Backpropagating melalui argmax terstruktur menggunakan keran. ACL 2018 Paper Terbaik Yang Terhormat Disebut.

Memahami mekanisme keran: gradien pengganti untuk pembelajaran struktur laten. EMNLP 2020

Belajar dengan pengoptimal yang terganggu. Neurips 2020

Estimasi gradien dengan trik softmax stokastik. Neurips 2020

Pemrograman dinamis yang dapat dibedakan untuk prediksi dan perhatian terstruktur. ICML 18

Optimalisasi stokastik jaringan penyortiran melalui relaksasi berkelanjutan

Peringkat dan penyortiran yang dapat dibedakan menggunakan transportasi optimal

Reparameterisasi politop Birkhoff untuk inferensi permutasi variasional. Aistats 2018

Kerangka kerja yang diatur untuk perhatian saraf yang jarang dan terstruktur. Neurips 2017

Sparsemap: Inferensi terstruktur jarang yang dapat dibedakan. ICML 2018

Pengakuan entitas yang disebutkan bersarang dengan treecrfs yang teramati sebagian. Aaai 2021

Gradien stokastik rao-blackwellized untuk distribusi diskrit. ICML 2019.

Marginalisasi efisien variabel laten diskrit dan terstruktur melalui sparsity. Neurips 2020

Regularisasi posterior untuk model variabel laten terstruktur. JMLR 2010

Kontrol posterior generasi blackbox. 2019

Induksi tata bahasa ketergantungan dengan parser berbasis transisi variasional saraf. Aaai 2019

(Dalam bahasa Cina) 微分几何与拓扑学简明教程

Hanya Bayes yang harus belajar manifold (pada estimasi struktur geometris diferensial dari data). ARXIV 2018

Geometri Riemannian dari model generatif yang dalam. CVPRW 2018

Geometri model gambar generatif yang dalam dan aplikasinya. ICLR 2021

Metrik untuk model generatif yang dalam. Aistats 2017

Algoritma orde pertama untuk optimasi Min-Max di ruang metrik geodesik. 2022

Fitur acak untuk mesin kernel skala besar. Neurips 2007

Struktur menemukan keacakan: algoritma probabilistik untuk membangun perkiraan dekomposisi matriks. Siam 2011

Optimalisasi loop dan batas yang efisien dengan jumlah teleskopik acak. ICML 2019

Estimasi Rasio Kepadatan Teleskop. Neurips 2020

Proses Gaussian yang dapat diskalakan bebas bias melalui pemotongan acak. ICML 2021

Diferensiasi otomatis acak. ICLR 2021

Penskalaan inferensi terstruktur dengan pengacakan. 2021

Elemen teori informasi. Tutup dan Thomas. 1991

Pada batasan variasi informasi timbal balik. ICML 2019

Mempelajari representasi mendalam dengan estimasi informasi timbal balik dan maksimalisasi. ICLR 2019

Tambang: Estimasi Saraf Saraf Saling

Hottleneck Informasi Variasional yang dalam. ICLR 2017

Mengidentifikasi model campuran Bayesian

Disentangling Disentanglement pada Autoencoders Variasional. ICML 2019

Menantang asumsi umum dalam pembelajaran yang tidak diawasi dari representasi yang terpencil. ICML 2019

Munculnya invarian dan pemasangan dalam representasi mendalam

Minimalisasi risiko invarian

Memperbaiki Elbo yang rusak. ICML 2018.

Batas variasional yang lebih ketat tidak selalu lebih baik. ICML 2018

Bernoulli kontinu: Memperbaiki kesalahan yang meresap dalam autoencoder variasional. Neurips 2019

Apakah model generatif yang dalam tahu apa yang tidak mereka ketahui? ICLR 2019

Estimasi efektif model bahasa generatif yang dalam. ACL 2020

Seberapa bagus Bayes posterior dalam jaringan saraf dalam? ICML 2020

Teori statistik posterior dingin dalam jaringan saraf yang dalam. ICLR 2021

Keterbatasan model autoregresif dan alternatifnya. NAACL 2021