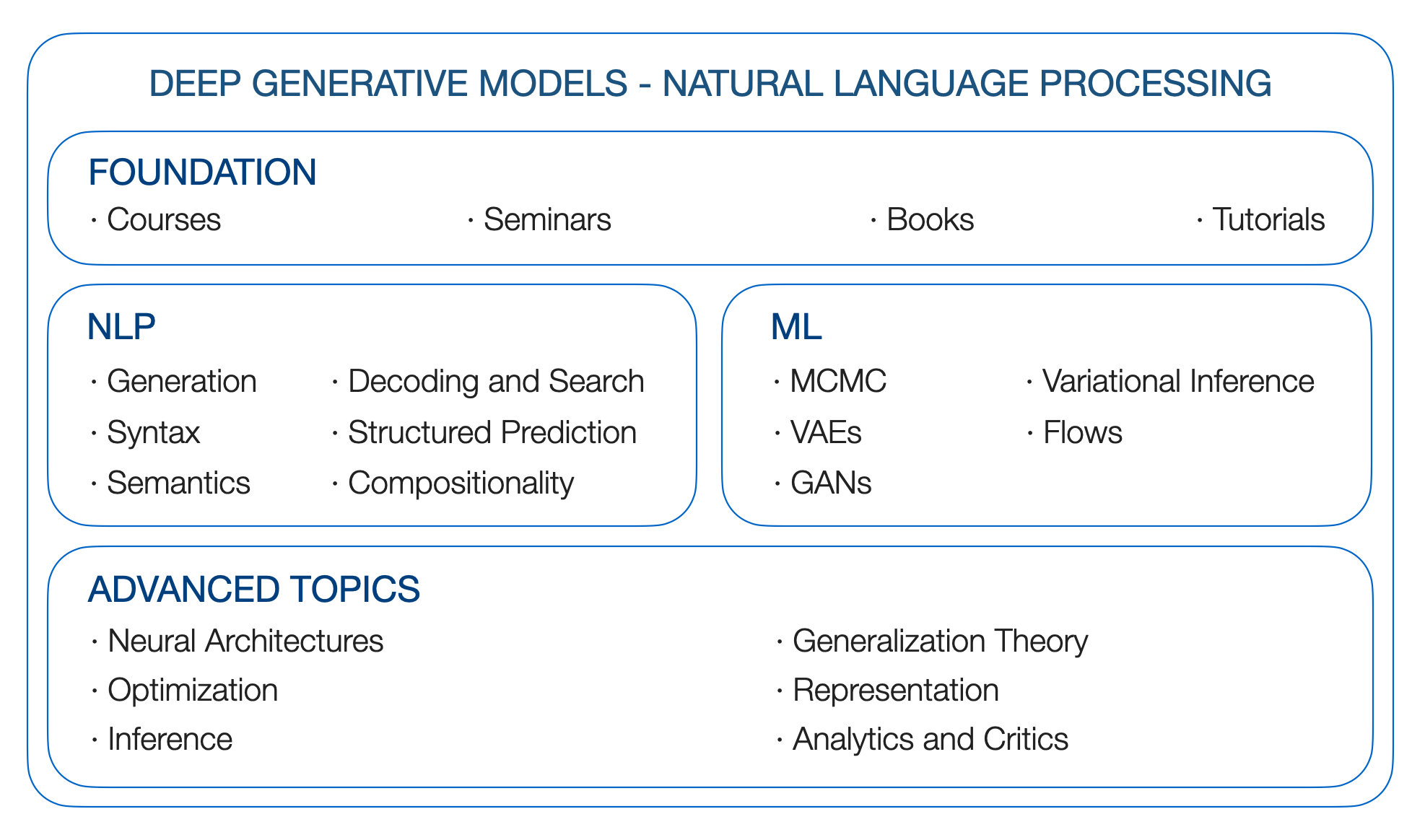

DGMS 4 NLP. 자연어 처리를위한 깊은 생성 모델. 로드맵.

Edinburgh 대학교 Yao Fu, [email protected]

** 업데이트 ** : GPT는 어떻게 능력을 얻습니까? 언어 모델의 출현 능력을 소스로 추적합니다

** 업데이트 ** : 언어 모델 출현 능력을 자세히 살펴 봅니다

** 업데이트 ** : 대형 모델

** 업데이트 ** : 장거리 종속성; S4가 긴 시퀀스에 능숙한 이유 : 온라인 함수 근사치의 시퀀스 기억

** TODO 1 ** : 교정; 격려; 장거리 변압기; 상태 공간 모델

** todo 2 ** : 매트릭스 인수화 및 단어 임베딩; 커널; 가우스 과정

** TODO 3 ** : 추론과 RL의 관계;

(2019 년 초에 작성된 콜롬비아의 DGM 세미나에서 시작)

우리는 왜 깊은 생성 모델을 원합니까? 우리는 언어를 생성하는 기본 요소를 배우고 싶어하기 때문입니다. 인간 언어에는 풍부한 잠재적 요인이 포함되어 있으며, 지속적인 요인은 감정, 의도 및 기타 요인 일 수 있습니다. 개별/ 구조적 요인은 POS/ NER 태그 또는 구문 트리 일 수 있습니다. 그들 중 많은 사람들이 대부분의 경우와 마찬가지로 잠재적입니다. 우리는 단지 문장을 관찰합니다. 그것들은 또한 생성 적입니다. 인간은 전체 아이디어, 현재 감정, 구문 및 우리가 이름을 지을 수 없거나 할 수없는 다른 모든 것들에 따라 언어를 생산해야합니다.

통계적으로 원칙적으로 언어의 생성 프로세스를 모델링하는 방법은 무엇입니까? 레이블이있을 때 명백한 감독 신호를 통합하거나 레이블이 없지만 다른 사전 지식이있을 때 먼 감독 또는 논리적/ 통계적 제약을 추가 할 수있는 유연한 프레임 워크를 가질 수 있습니까? 수학적이고 확률 론적으로 고급 신경 구조의 모델링 능력을 악용 할 수 있습니까? DGM을 통해 이러한 목표를 달성 할 수 있습니다.

여행을 시작합시다.

소환:

@article{yao2019DGM4NLP,

title = "Deep Generative Models for Natual Language Processing",

author = "Yao Fu",

year = "2019",

url = "https://github.com/FranxYao/Deep-Generative-Models-for-Natural-Language-Processing"

}

NLP에 대한 변형 추론 및 생성 모델을 작성하는 방법 : 레시피. 이것은 NLP 용 VAE에 관한 논문을 작성하는 초보자에게 강력하게 제안됩니다.

자연 언어의 깊은 잠복 변수 모델에 대한 튜토리얼 (LINK), EMNLP 18

NLP에 대한 잠재 구조 모델. ACL 2019 튜토리얼 링크

Columbia STAT 8201 -John Cunningham의 깊은 생성 모델

Stanford CS 236- Stefano Ermon의 깊은 생성 모델

U Toronto CS 2541- 차별화 가능한 추론 및 생성 모델, CS 2547 학습 이산 잠재 구조 학습, CSC 2547 2019 년 가을 : 검색 학습. David Duvenaud

U Toronto STA 4273 Winter 2021- 기대 최소화. Chris Maddison

버클리 CS294-158- 감독되지 않은 심도있는 학습. Pieter Abbeel에 의해

Columbia STCS 8101- 표현 학습 : 확률 적 관점. David Blei

스탠포드 CS324- 큰 언어 모델. Percy Liang, Tatsunori Hashimoto 및 Christopher Re

U Toronto CSC2541- 신경 순 훈련 역학. Roger Grosse.

DGM의 자금은 확률 론적 그래픽 모델에 기반을두고 있습니다. 그래서 우리는 다음 자원을 살펴 봅니다

컬럼비아의 Blei 's Foundation of Graphical Models Course, STAT 6701 (링크)

Xing의 확률 론적 그래픽 모델, CMU의 10-708 (링크)

Collins의 자연 언어 처리, COMS 4995 at Columbia (Link)

패턴 인식 및 기계 학습. 크리스토퍼 M. 비숍. 2006

기계 학습 : 확률 적 관점. 케빈 P. 머피. 2012

그래픽 모델, 지수 패밀리 및 변형 추론. 2008

언어 구조 예측. 2011

구문 과정. 2000

연속 공간에서 문장 생성, Conll 15

텍스트 처리에 대한 신경 변동 추론, ICML 16

텍스트 생성을위한 신경 템플릿 학습. EMNLP 2018

텍스트 생성을위한 잔류 에너지 기반 모델. ICLR 20

잠재적 인 단어 가방으로 생성을 말하십시오. Neurips 2019.

Fairseq 디코딩 라이브러리. [github]

Controllabel 신경 텍스트 생성 [Lil'Log]

최선의 최초의 빔 검색. TACL 2020

신경 텍스트 변성의 호기심 많은 사례. ICLR 2020

조건부 언어 모델에서 다양한 디코딩 방법의 비교. ACL 2019

확률 빔과 찾을 수있는 곳 : 교체없이 샘플링 시퀀스를위한 Gumbel-Top-K 트릭. ICML 19

조건부 포아송 확률 빔 검색. EMNLP 2021

격자를 사용한 텍스트 생성을위한 대규모 스케일 디코딩. 2021

그리드 빔 검색을 사용한 서열 생성을위한 어휘 제약 디코딩. ACL 2017

신경 기계 번역을위한 동적 빔 할당으로 빠른 어휘 제한된 디코딩. NAACL 2018

번역 및 단일 언어 재 작성을위한 어휘 제약 디코딩 개선. NAACL 2019

신경 기계 번역에서의 지속적인 최적화로서 디코딩을 향해. EMNLP 2017

구배 유도 감독되지 않은 어휘 제한된 텍스트 생성. EMNLP 2020

여러 제약 조건으로 지속적인 최적화로 제어 된 텍스트 생성. 2021

신경 학적 디코딩 : (UN) 술어 논리 제약으로 감독 된 신경 텍스트 생성. NAACL 2021

신경 학적 a*esque decoding : Lookahead 휴리스틱을 사용한 제한된 텍스트 생성. 2021

콜드 디코딩 : Langevin Dynamics를 사용한 에너지 기반 제한된 텍스트 생성. 2022

참고 :이 장을 완전히 살펴 보지 않았습니다. 제안 해주세요!

비 유포적 신경 기계 번역. ICLR 2018

완전히 비유 한 신경 기계 번역 : 무역의 속임수.

개별 잠재 변수를 사용하여 순서 대기 모델에서 빠른 디코딩. ICML 2021

Markov Transformers를 사용한 계단식 텍스트 생성. arxiv 20

비 유적지가없는 신경 기계 번역을위한 글씨 변압기. ACL 2021

Todo : 그것에 대해 더

프롬프트 서류, Thunlp (링크)

CTRL : 제어 가능한 생성을위한 조건부 변압기 언어 모델. ARXIV 2019

플러그 앤 플레이 언어 모델 : 제어 된 텍스트 생성에 대한 간단한 접근 방식

토치 스트럭 : 깊은 구조화 된 예측 라이브러리. Github, 종이, 문서

조건부 랜덤 필드 소개. 2012

내부 외부 및 전방 공간 알고리즘은 역전입니다. 2016.

Fenchel-Young 손실로 배우는 것. JMLR 2019

구조화 된주의 네트워크. ICLR 2017

구조화 된 예측 및주의를위한 차별화 가능한 동적 프로그래밍. ICML 2018

반복 신경 네트워크 문법. NAACL 16

감독되지 않은 재발 성 신경망 문법, NAACL 19

차별화 가능한 혼란과 파스 : 구조적 변형 자동 코더를 사용한 반 감독 구문 분석, ICLR 19

구문 과정. 2020

의미 론적 역할 라벨링을위한 언어 적으로 정보를 얻은 자기 소지. EMNLP 2018 Best Paper Award

반 감독 된 순차적 인 자동 인코더를 사용한 시맨틱 파싱. 2016

NLP의 구성 일반화. 종이 목록

체계성없는 일반화 : 시퀀스-시퀀스 재발 네트워크의 구성 기술. ICML 2019

텍스트-SQL 평가 방법론 향상. ACL 2018

Markov Chain Monte Carlo 방법을 사용한 확률 론적 추론. 1993

순차적 몬테 카를로의 요소 (링크)

해밀턴 몬테 카를로에 대한 개념적 소개 (링크)

후보 샘플링 (링크)

소음 제한 추정 : 정상화되지 않은 통계 모델에 대한 새로운 추정 원리. Aistata 2010

* 샘플링. NIPS 2014 Best Paper Award

케임브리지 변형 추론 읽기 그룹 (링크)

변형 추론 : 통계 학자에 대한 검토.

확률 론적 변동 추론

확률 론적 검색과의 변형 베이지안 추론. ICML 12

자동 인코딩 변형 베이, ICLR 14

베타 VAE : 제한된 변형 프레임 워크를 사용하여 기본 시각적 개념을 학습합니다. ICLR 2017

중요성 가중 자동 인코더. ICLR 2015

깊은 생성 모델에서 확률 론적 역전 및 대략적인 추론. ICML 14

반 사기화 변동 자동 인코 코더, ICML 18

반응 적으로 정규화 된 자동 인코더, ICML 18

리 파라 미터 화에 대한 자세한 내용 : 가우시안 혼합물, 순열 행렬 및 거부 샘플러 (감마 및 디리클 렛)를 재사용하는 것.

혼합 밀도 분포를 통한 확률 론적 역전, ARXIV 16

수용 재배치 샘플링 알고리즘을 통한 리파 라미터 화 그라디언트. Aistats 2017

암시 적 재 파라미터 화 그라디언트. Neurips 2018.

Gumbel-Softmax를 사용한 범주 형 재사용. ICLR 2017

콘크리트 분포 : 개별 랜덤 변수의 지속적인 완화. ICLR 2017

역전 가능한 가우스 리파 라미터 화 : Gumbel-Softmax 재 방문. 2020

연속적인 이완을 통한 리 파라이트 화 가능한 서브 세트 샘플링. IJCAI 2019

생성 적대성 네트워크, NIPS 14

생성 적대적 네트워크를 훈련하기위한 원칙적 방법, ICLR 2017

Wasserstein 간

Infogan : 생성 적대성 그물을 극대화하는 정보에 의한 해석 가능한 표현 학습. NIPS 2016

반대 학적으로 배운 추론. ICLR 2017

Lil의 로그에서 흐름 기반 깊은 생성 모델

정규화 흐름에 대한 변동 추론, ICML 15

정상화 흐름으로 언어에 대해 배웁니다

역자토 회귀 흐름으로 개선 된 변동 추론

실제 NVP를 사용한 밀도 추정. ICLR 17

거꾸로 된 신경 예측으로 구문 구조에 대한 감독되지 않은 학습. EMNLP 2018

개별 시퀀스의 잠복 정규화 흐름. ICML 2019.

이산 흐름 : 이산 데이터의 거꾸로 생성 모델. 2019

FlowSeQ : 생성 흐름을 갖는 비 유적지가없는 조건부 서열 생성. EMNLP 2019

정규화 흐름을 가진 변형 신경 기계 번역. ACL 2020

사전 훈련 된 언어 모델의 문장 내부. EMNLP 2020

FY : 점수 기반 생성 모델 및 확산 모델을 개별 시퀀스에 사용하는 방법을 확인해야합니다.

데이터 분포의 기울기를 추정하여 생성 모델링. 블로그 2021

점수 기반 생성 모델링 논문

데이터 분포의 기울기를 추정하여 생성 모델링. Neurips 2019

확산 모델이란 무엇입니까? 2021

멋진 분해 모델

비평형 열역학을 사용한 깊은 감독 학습. 2015

확산 확률 모델을 비난합니다. Neurips 2020

Argmax 흐름 및 다중 확산 : 학습 범주 적 분포. Neurips 2021

개별 상태 공간에서 구조화 된 비난 확산 모델. Neurips 2021

자동 회귀 확산 모델. ICLR 2022

확산 LM은 제어 가능한 텍스트 생성을 향상시킵니다. 2022

깊은 언어 이해를 가진 사진 텍스트-이미지 확산 모델. 2022

순서 뉴런 : 재발 성 신경망에 구조화 된 트리를 통합합니다

RNN은 최적의 메모리로 제한된 계층 적 언어를 생성 할 수 있습니다

멀티 헤드 자체 소지 분석 : 전문 헤드는 무거운 리프팅을 수행하고 나머지는 가지 치기를 할 수 있습니다. ACL 2019

신경 서열 모델에서 자기 변환의 이론적 한계. TACL 2019

공연자들과의 관심을 다시 생각합니다. 2020

Thunlp : 미리 훈련 된 언어 모델 용지 목록 (링크)

Tomohide Shibata의 Bert 관련 논문

HIPPO : 최적의 다항식 투영을 가진 재발 기억. Neurips 2020

재발, 컨볼 루션 및 연속 시간 모델과 선형 상태 공간 층을 결합합니다. Neurips 2021

구조화 된 상태 공간으로 긴 시퀀스를 효율적으로 모델링합니다. ICLR 2022

S4가 장기 순서에 능숙한 이유 : 온라인 기능 근사치의 시퀀스를 기억합니다. 2022

GPT3 (175b). 언어 모델은 소수의 학습자입니다. 2020 년 5 월

Megatron-Turing NLG (530b). DeepSpeed와 Megatron을 사용하여 대규모 생성 언어 모델 인 Megatron-Turing NLG 530B를 훈련시킵니다. 2022 년 1 월

Lamda (137b). Lamda : 대화 상자 응용 프로그램을위한 언어 모델. 2022 년 1 월

고퍼 (280b). 언어 모델 스케일링 : 훈련 고퍼의 방법, 분석 및 통찰력. 2021 년 12 월

친칠라 (70b). 훈련 컴퓨팅 최적의 대형 언어 모델. 2022 년 3 월

팜 (540b). Palm : 경로로 언어 모델링을 스케일링합니다. 2022 년 4 월

opt (175b). OPT : 사전 훈련 된 변압기 언어 모델 열기. 2022 년 5 월

Bloom (176b) : Bigscience 대형 오픈 과학 오픈 액세스 다국어 언어 모델. 2022 년 5 월

Blenderbot 3 (175b) : 책임감있게 참여하는 법을 배우는 배치 된 대화 상담원. 2022 년 8 월

신경 언어 모델의 스케일링 법률. 2020

큰 언어 모델의 출현 능력. 2022

기대치를 최소화합니다. 크리스 매디슨

머신 러닝에서 몬테 카를로 그라디언트 추정

Monte Carlo 목표에 대한 변형 추론. ICML 16

Rebar : 개별 잠재 변수 모델에 대한 저변 한, 편견이없는 그라디언트 추정치. NIPS 17

공극을 통한 역전 : 제어 최적화는 블랙 박스 그라디언트 추정을 위해 변동합니다. ICLR 18

스피터를 사용하여 구조화 된 Argmax를 통해 역전. ACL 2018 최고의 논문 명예 언급.

Spigot의 역학 이해 : 잠재 구조 학습을위한 대리 기울기. EMNLP 2020

차별화 가능한 혼란스러운 최적화기로 학습. Neurips 2020

확률 론적 소프트 맥스 트릭을 사용한 그라디언트 추정. Neurips 2020

구조화 된 예측 및주의를위한 차별화 가능한 동적 프로그래밍. ICML 18

지속적인 이완을 통한 분류 네트워크의 확률 적 최적화

최적의 전송을 사용하여 차별화 가능한 순위 및 정렬

변동 적 순열 추론을 위해 Birkhoff 폴리 토프를 재발매합니다. Aistats 2018

희소하고 구조화 된 신경주의를위한 정규화 된 프레임 워크. Neurips 2017

Sparsemap : 차별화 가능한 드문 구조적 추론. ICML 2018

부분적으로 관찰 된 TreeCRF를 사용하여 이름 지정된 엔티티 인식. AAAI 2021

이산 분포를위한 Rao-Blackwellized 확률 구배. ICML 2019.

희소성을 통한 개별적이고 구조화 된 잠재 변수의 효율적인 소외. Neurips 2020

구조화 된 잠재 변수 모델에 대한 사후 정규화. JMLR 2010

Blackbox Generation의 후방 제어. 2019

신경 변동 전이 기반 구문 분석기를 사용한 의존성 문법 유도. AAAI 2019

(중국어) 微分几何与拓扑学简明教程

베이 즈만이 매니 폴드를 배워야합니다 (데이터로부터 차동 기하학적 구조의 추정). ARXIV 2018

깊은 생성 모델의 리만도 기하학. CVPRW 2018

깊은 생성 이미지 모델의 형상 및 응용 프로그램. ICLR 2021

깊은 생성 모델에 대한 메트릭. Aistats 2017

지오 드시 메트릭 공간에서 최소 점수 최적화를위한 1 차 알고리즘. 2022

대규모 커널 머신의 임의의 기능. Neurips 2007

임의성을 가진 구조 찾기 : 근사한 행렬 분해를 구성하기위한 확률 적 알고리즘. 시암 2011

무작위 망원경 합계로 루프 및 한계의 효율적인 최적화. ICML 2019

텔레 스코핑 밀도 비율 추정. Neurips 2020

무작위 절단을 통한 바이어스가없는 확장 가능한 가우스 프로세스. ICML 2021

무작위 자동 차별화. ICLR 2021

무작위 화에 대한 구조화 된 추론. 2021

정보 이론의 요소. 커버와 토마스. 1991

상호 정보의 변형 범위. ICML 2019

상호 정보 추정 및 최대화에 의한 깊은 표현 학습. ICLR 2019

광산 : 상호 정보 신경 추정

깊은 변형 정보 병목 현상. ICLR 2017

베이지안 혼합 모델 식별

변형자가 인코더에서 분리 방해. ICML 2019

분리 된 표현에 대한 감독되지 않은 학습에서 일반적인 가정에 도전합니다. ICML 2019

깊은 표현에서 불변과 분리의 출현

불변 위험 최소화

부러진 엘보 고정. ICML 2018.

더 엄격한 변형 범위가 반드시 더 나은 것은 아닙니다. ICML 2018

연속 Bernoulli : 변형 자동 인코더에서 광범위한 오류를 고정합니다. Neurips 2019

깊은 생성 모델이 자신이 모르는 것을 알고 있습니까? ICLR 2019

깊은 생성 언어 모델의 효과적인 추정. ACL 2020

깊은 신경 네트워크에서 베이즈 후부는 얼마나 좋은가요? ICML 2020

깊은 신경 네트워크에서 차가운 후구의 통계 이론. ICLR 2021

자가 회귀 모델과 대안의 한계. NAACL 2021