該存儲庫包含用於復制結果和經過訓練的Imagenet模型的代碼:

重新考慮網絡修剪的價值。 [arxiv] [OpenReview]

Zhuang Liu*,Mingjie Sun*,Tinghui Zhou,Gao Huang,Trevor Darrell(*同等貢獻)。

ICLR 2019。也是NIPS 2018緊湊型深神經網絡研討會上的最佳紙張獎。

本倉庫中包含的幾種修剪方法的實現也很容易用於其他研究目的。

我們的論文表明,與從典型的“訓練,修剪和微調”中獲得的模型相比,對於結構化修剪,從頭開始訓練修剪模型幾乎總是可以達到可比或更高的準確性(圖1)。我們得出的結論是,對於那些修剪方法:

我們的結果表明,在對結構化修剪方法的未來研究中,需要進行更仔細的基線評估。

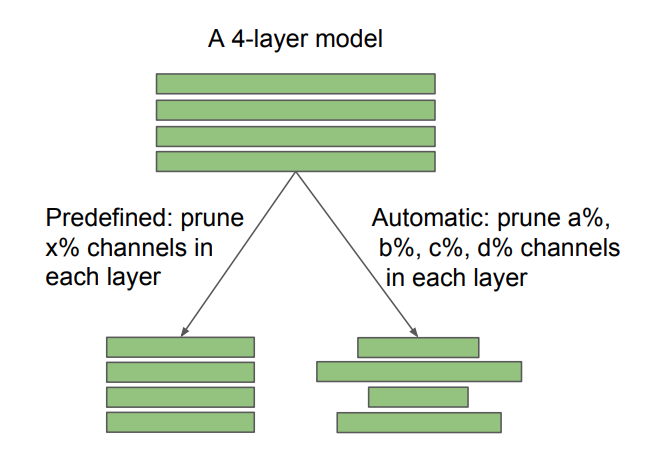

圖2:在通道修剪中,預定義和自動發現的目標架構之間的差異。修剪率x是用戶指定的,而a,b,c,d由修剪算法確定。非結構化的稀疏修剪也可以看作是自動的。我們的發現對預定義和自動方法具有不同的含義:對於預定義的方法,可以跳過傳統的“訓練,修剪和微調”管道,直接訓練修剪的模型;對於自動方法,可以將修剪視為建築學習的一種形式。

我們還與“彩票假設”進行了比較(Frankle&Carbin 2019),並發現以最佳的學習率,Frankle&Carbin(2019)中使用的“獲勝門票”初始化並沒有帶來隨機初始化的改進。有關更多詳細信息,請參考我們的論文。

我們評估了以下七種修剪方法。

前六個是結構化的,而最後一個是非結構化的(或稀疏)。對於CIFAR,我們的代碼基於Pytorch分類和網絡攀升。對於ImageNet,我們使用官方的Pytorch Imagenet培訓代碼。指令和模型在每個子文件夾中。

有關彩票假設的實驗,請參閱文件夾CIFAR/彩票門票。

我們的實驗環境為Python 3.6&Pytorch 0.3.1。

隨時通過問題/電子郵件與我們討論論文/代碼!

sunmj15在gmail.com上

liuzhuangthu在gmail.com上

如果您在研究中使用我們的代碼,請引用:

@inproceedings{liu2018rethinking,

title={Rethinking the Value of Network Pruning},

author={Liu, Zhuang and Sun, Mingjie and Zhou, Tinghui and Huang, Gao and Darrell, Trevor},

booktitle={ICLR},

year={2019}

}