このリポジトリには、次の論文に、結果を再現するためのコードと訓練されたイメージネットモデルが含まれています。

ネットワーク剪定の価値を再考します。 [arxiv] [OpenReview]

Zhuang Liu*、Mingjie Sun*、Tinghui Zhou、Gao Huang、Trevor Darrell(*平等な貢献)。

ICLR2019。また、コンパクトディープニューラルネットワークに関するNIPS 2018ワークショップでのベストペーパーアワード。

このレポに含まれるいくつかの剪定方法の実装は、他の研究目的でも容易に使用できます。

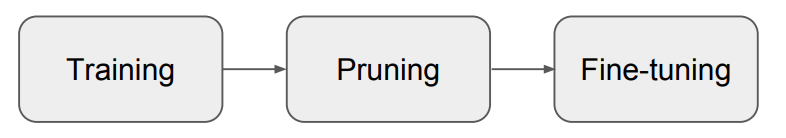

私たちの論文は、構造化された剪定の場合、剪定されたモデルをゼロからトレーニングすることで、ほとんどの場合、典型的な「トレーニング、剪定、微調整」(図1)手順から得られたモデルよりも、ほぼ常に同等または高いレベルの精度を達成できることを示しています。これらの剪定方法については、

我々の結果は、構造化された剪定方法に関する将来の研究におけるより慎重なベースライン評価の必要性を示唆しています。

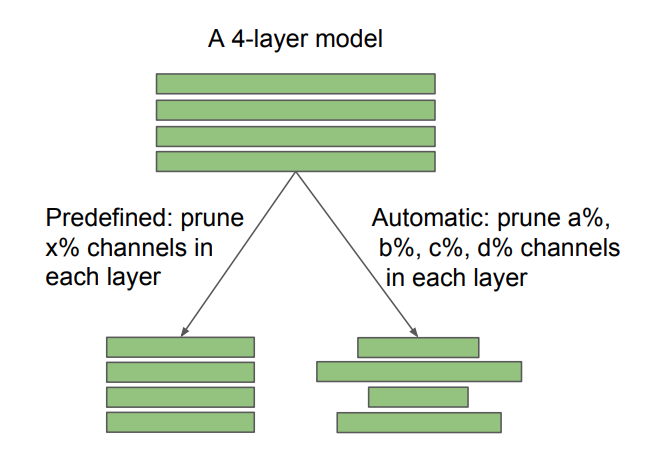

図2:チャネル剪定における事前定義されたターゲットアーキテクチャと自動化されたターゲットアーキテクチャの違い。剪定比xはユーザー指定であり、a、b、c、dは剪定アルゴリズムによって決定されます。構造化されていないスパース剪定も自動と見なすことができます。私たちの発見には、事前定義された自動方法と自動的な方法には異なる意味があります。事前定義された方法では、従来の「トレーニング、剪定、微調整」パイプラインをスキップし、剪定されたモデルを直接訓練することが可能です。自動方法の場合、剪定はアーキテクチャ学習の形と見なすことができます。

また、「宝くじチケット仮説」(Frankle&Carbin 2019)とも比較され、最適な学習率で、Frankle&Carbin(2019)で使用される「勝利チケット」の初期化は、ランダムな初期化を改善しないことがわかります。詳細については、私たちの論文を参照してください。

次の7つの剪定方法を評価しました。

最初の6つは構造化され、最後の6つは構造化されていません(またはまばら)。 CIFARの場合、私たちのコードはPytorch分類とネットワークスリミングに基づいています。 Imagenetには、公式のPytorch Imagenetトレーニングコードを使用します。指示とモデルは各サブフォルダーにあります。

宝くじのチケット仮説に関する実験については、cifar/宝くじのフォルダーを参照してください。

実験環境は、Python 3.6とPytorch 0.3.1です。

問題や電子メールを通じて、お気軽に論文/コードについて話し合ってください!

gmail.comのsunmj15

gmail.comのliuzhuangthu

調査でコードを使用する場合は、引用してください。

@inproceedings{liu2018rethinking,

title={Rethinking the Value of Network Pruning},

author={Liu, Zhuang and Sun, Mingjie and Zhou, Tinghui and Huang, Gao and Darrell, Trevor},

booktitle={ICLR},

year={2019}

}