Dieses Repository enthält den Code für die Reproduktion der Ergebnisse und geschulte Imagnet -Modelle im folgenden Papier:

Den Wert des Netzwerkbeschneidung überdenken. [Arxiv] [OpenReview]

Zhuang Liu*, Mingjie Sun*, Tinghui Zhou, Gao Huang, Trevor Darrell (*gleicher Beitrag).

ICLR 2019. Auch der beste Papierpreis beim NIPS 2018 Workshop für kompakte tiefe neuronale Netze.

Mehrere in diesem Repo enthaltene Implementierungen von Beschneidungsmethoden können auch für andere Forschungszwecke leicht verwendet werden.

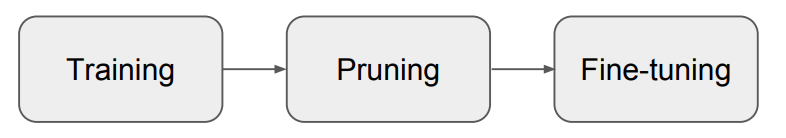

Unser Papier zeigt, dass beim strukturierten Beschneidung das Training des beschnittenen Modells von Grund auf fast immer eine vergleichbare oder höhere Genauigkeit erreichen kann als das Modell, das aus dem typischen Verfahren "Training, Beschneidung und Feinabstimmung" (Abb. 1) erhalten wurde . Wir schließen daraus, dass für diese Schnittmethoden:

Unsere Ergebnisse deuten darauf hin, dass in zukünftigen Forschungen zu strukturierten Beschneidungsmethoden sorgfältigere Basisbewertungen erforderlich sind.

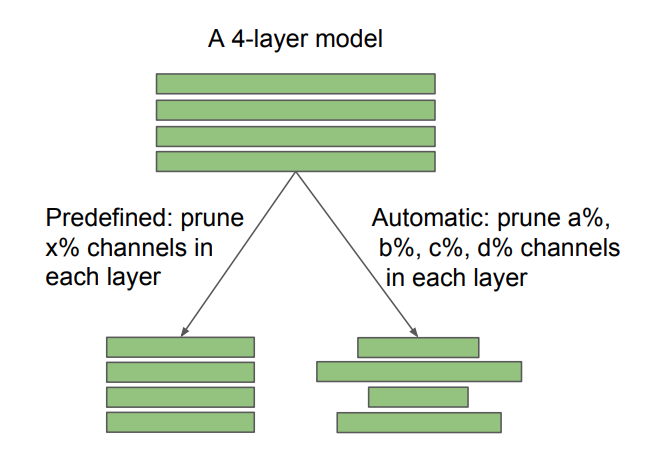

Abb. 2: Unterschied zwischen vordefinierten und automatisch entdeckten Zielarchitekturen im Kanalbeschneiden. Das Schnittverhältnis X ist benutzerdefiniert, während A, B, C, D durch den Schnittalgorithmus bestimmt werden. Unstrukturiertes spärliches Beschneiden kann ebenfalls als automatisch angesehen werden. Unser Befund hat unterschiedliche Auswirkungen auf vordefinierte und automatische Methoden: Bei einer vordefinierten Methode ist es möglich, die traditionelle Pipeline "Training, Beschneidung und Feinabstimmung" zu überspringen und das beschnittene Modell direkt zu trainieren. Bei automatischen Methoden kann das Beschneiden als eine Form des Architekturlernens angesehen werden.

Wir vergleichen uns auch mit der "Lotteriekartenhypothese" (Frankle & Carbin 2019) und stellen fest, dass mit der optimalen Lernrate die in Frankle & Carbin (2019) verwendete Initialisierung "Gewinnerticket" keine Verbesserung gegenüber der zufälligen Initialisierung verleiht. Weitere Informationen finden Sie in unserem Artikel.

Wir haben die folgenden sieben Schnittmethoden bewertet.

Die ersten sechs sind strukturiert, während der letzte unstrukturiert (oder spärlich) ist. Für CIFAR basiert unser Code auf Pytorch-Klassifizierung und Netzwerksklassifizierung. Für ImageNet verwenden wir den offiziellen Pytorch ImageNet -Trainingscode. Die Anweisungen und Modelle befinden sich in jedem Unterordner.

Für Experimente zur Lotteriekartenhypothese finden Sie im Ordner Cifar/Lottery-Ticket.

Unsere Experimentumgebung ist Python 3.6 & Pytorch 0.3.1.

Sie können gerne über Themen/E -Mails mit uns Papiere/Code besprechen!

Sunmj15 bei gmail.com

liuzhuangthu bei gmail.com

Wenn Sie unseren Code in Ihrer Forschung verwenden, zitieren Sie bitte:

@inproceedings{liu2018rethinking,

title={Rethinking the Value of Network Pruning},

author={Liu, Zhuang and Sun, Mingjie and Zhou, Tinghui and Huang, Gao and Darrell, Trevor},

booktitle={ICLR},

year={2019}

}