该存储库包含用于复制结果和经过训练的Imagenet模型的代码:

重新考虑网络修剪的价值。 [arxiv] [OpenReview]

Zhuang Liu*,Mingjie Sun*,Tinghui Zhou,Gao Huang,Trevor Darrell(*同等贡献)。

ICLR 2019。也是NIPS 2018紧凑型深神经网络研讨会上的最佳纸张奖。

本仓库中包含的几种修剪方法的实现也很容易用于其他研究目的。

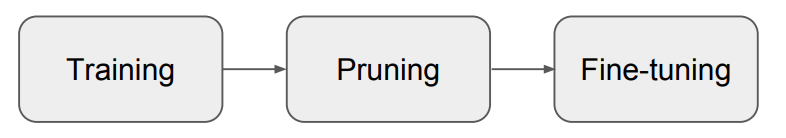

我们的论文表明,与从典型的“训练,修剪和微调”中获得的模型相比,对于结构化修剪,从头开始训练修剪模型几乎总是可以达到可比或更高的准确性(图1)。我们得出的结论是,对于那些修剪方法:

我们的结果表明,在对结构化修剪方法的未来研究中,需要进行更仔细的基线评估。

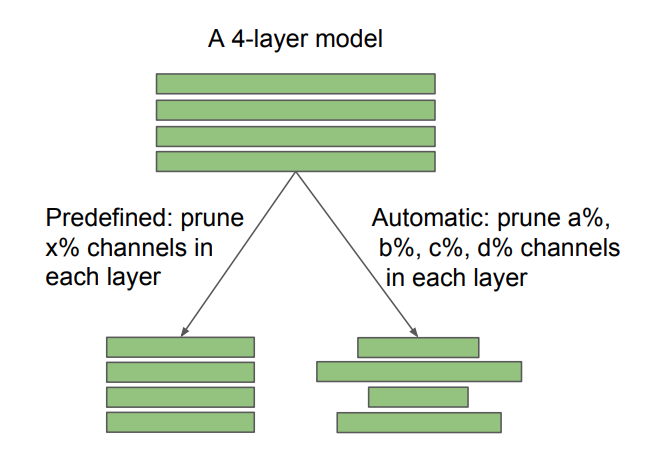

图2:在通道修剪中,预定义和自动发现的目标架构之间的差异。修剪率x是用户指定的,而a,b,c,d由修剪算法确定。非结构化的稀疏修剪也可以看作是自动的。我们的发现对预定义和自动方法具有不同的含义:对于预定义的方法,可以跳过传统的“训练,修剪和微调”管道,直接训练修剪的模型;对于自动方法,可以将修剪视为建筑学习的一种形式。

我们还与“彩票假设”进行了比较(Frankle&Carbin 2019),并发现以最佳的学习率,Frankle&Carbin(2019)中使用的“获胜门票”初始化并没有带来随机初始化的改进。有关更多详细信息,请参考我们的论文。

我们评估了以下七种修剪方法。

前六个是结构化的,而最后一个是非结构化的(或稀疏)。对于CIFAR,我们的代码基于Pytorch分类和网络攀升。对于ImageNet,我们使用官方的Pytorch Imagenet培训代码。指令和模型在每个子文件夹中。

有关彩票假设的实验,请参阅文件夹CIFAR/彩票门票。

我们的实验环境为Python 3.6&Pytorch 0.3.1。

随时通过问题/电子邮件与我们讨论论文/代码!

sunmj15在gmail.com上

liuzhuangthu在gmail.com上

如果您在研究中使用我们的代码,请引用:

@inproceedings{liu2018rethinking,

title={Rethinking the Value of Network Pruning},

author={Liu, Zhuang and Sun, Mingjie and Zhou, Tinghui and Huang, Gao and Darrell, Trevor},

booktitle={ICLR},

year={2019}

}