AdaptSegNet

1.0.0

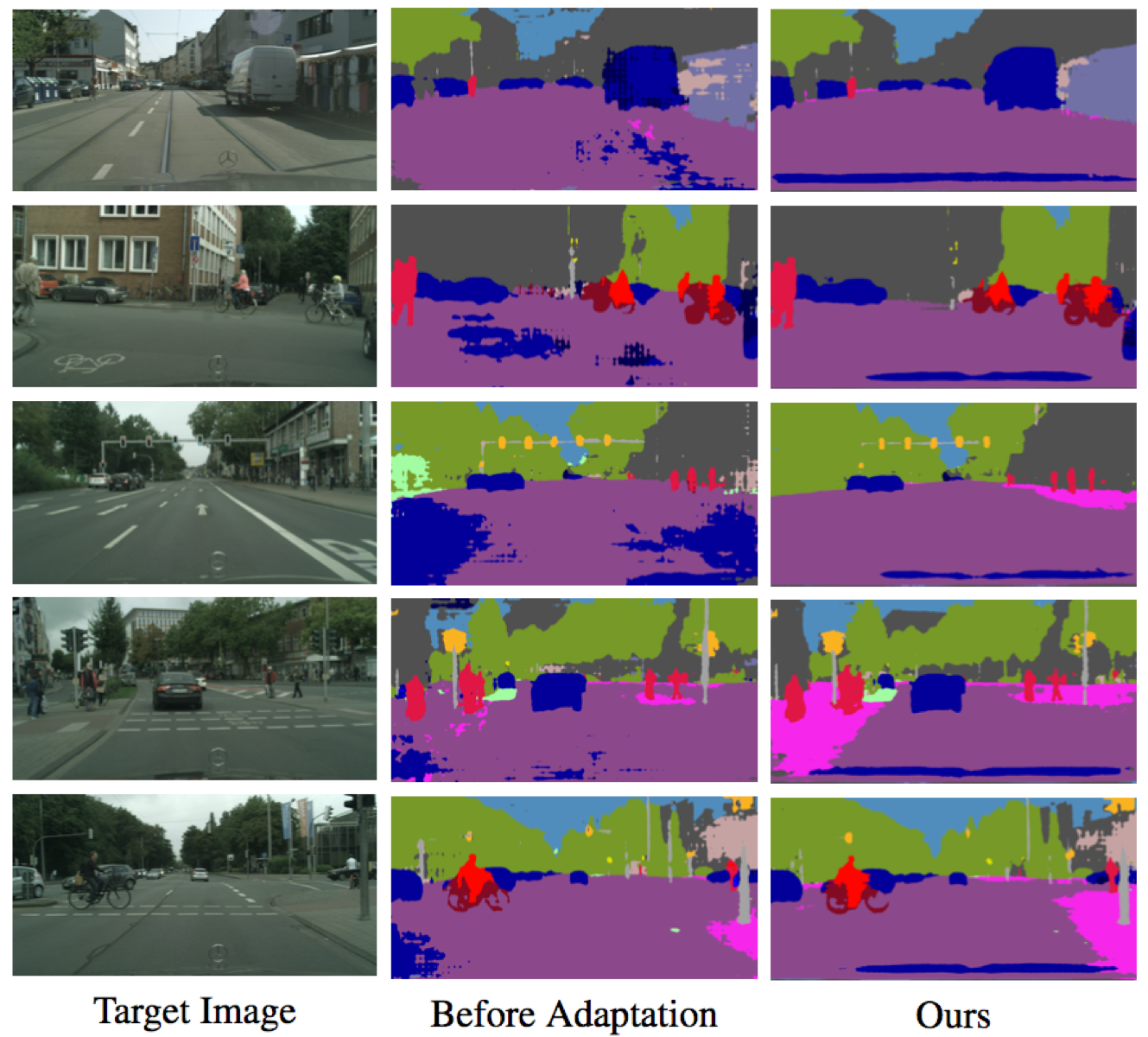

Pytorch實現了我們的方法,用於調整從合成數據集(源域)到真實數據集(目標域)的語義分割方法。基於此實施,我們的結果在Visda挑戰中排名第三。

聯繫人:yi-hsuan tsai(gmail dot com的Wasidennis)和wei-chih Hung(ucmerced dot edu的Whung8)

學習適應結構化的輸出空間以進行語義分割

Yi-Hsuan Tsai*,Wei-Chih Hung*,Samuel Schulter,Kihyuk Sohn,Ming-Hsuan Yang和Manmohan Chandraker

IEEE計算機視覺和模式識別會議(CVPR),2018年(聚光燈)(*表示同等的貢獻)。

如果您覺得這對您的研究有用,請引用我們的論文。

@inproceedings{Tsai_adaptseg_2018,

author = {Y.-H. Tsai and W.-C. Hung and S. Schulter and K. Sohn and M.-H. Yang and M. Chandraker},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

title = {Learning to Adapt Structured Output Space for Semantic Segmentation},

year = {2018}

}

使用python 2和cuda 8.0安裝http://pytorch.org的pytorch

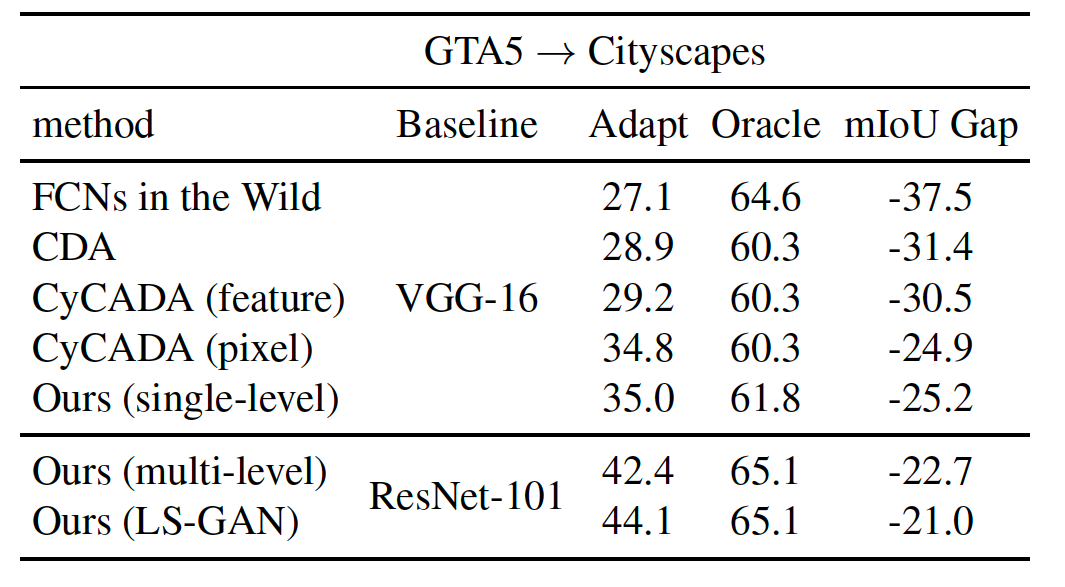

新添加LS-GAN目標以提高性能

--gan LS在培訓期間選項(有關更多詳細信息,請參見下文)Pytorch 0.4,帶Python 3和Cuda 8.0

pytorch_0.4文件夾中的培訓和評估代碼替換培訓和評估代碼--tensorboard提供張板--lambda-adv-target1 0.00005 --lambda-adv-target2 0.0005 。我們將盡快調查這個問題。克隆這個倉庫

git clone https://github.com/wasidennis/AdaptSegNet

cd AdaptSegNet

下載GTA5數據集作為源域,然後將其放入data/GTA5文件夾中

下載CityScapes數據集作為目標域,然後將其放入data/Cityscapes文件夾中

請在此處的三個基准設置上使用Resnet-101找到我們的型號

它們包括基線(沒有適應和特徵適應)和我們的模型(單層和多層次)

使用LS-GAN和使用Synscapes作為源域的新更新結果

下載預先訓練的多級GTA5-TO-CITYSCAPES模型,然後將其放入model文件夾中

測試模型和結果將保存在result文件夾中

python evaluate_cityscapes.py --restore-from ./model/GTA2Cityscapes_multi-ed35151c.pth

python evaluate_cityscapes.py --model DeeplabVGG --restore-from ./model/GTA2Cityscapes_vgg-ac4ac9f6.pth

python compute_iou.py ./data/Cityscapes/data/gtFine/val result/cityscapes

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single_lsgan

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.01

--gan LS

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_multi

--lambda-seg 0.1

--lambda-adv-target1 0.0002 --lambda-adv-target2 0.001

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.001

此代碼是從Pytorch-Deeplab大量借來的。

該模型和代碼僅用於非商業研究目的。