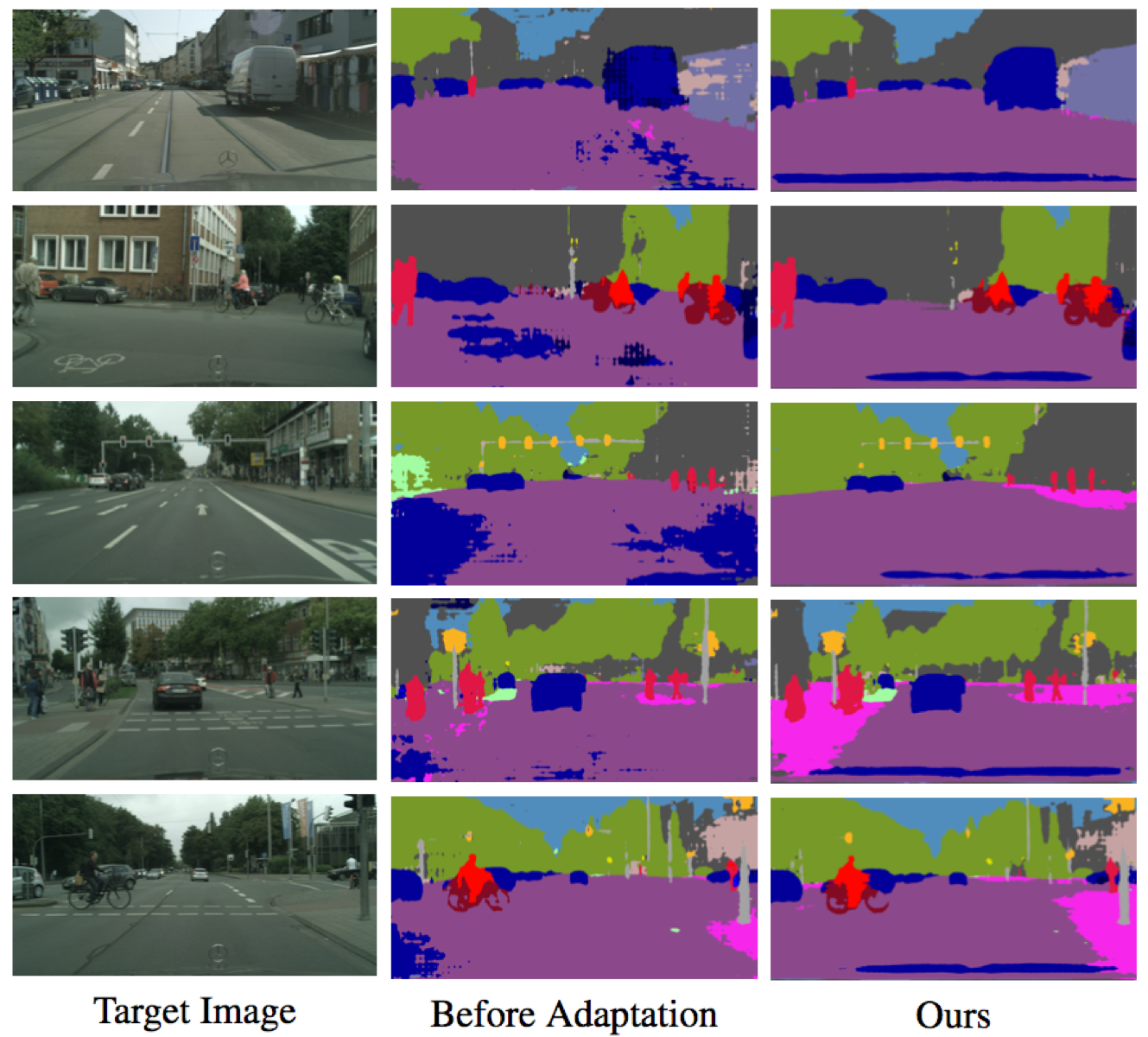

Implementación de Pytorch de nuestro método para adaptar la segmentación semántica del conjunto de datos sintético (dominio de origen) al conjunto de datos real (dominio objetivo). Según esta implementación, nuestro resultado ocupa el tercer lugar en el desafío VISDA.

Contacto: Yi-Hsuan Tsai (Wasidennis en Gmail Dot com) y Wei-Chih Hung (Whung8 en ucmerced Dot edu)

Aprender a adaptar el espacio de salida estructurado para la segmentación semántica

Yi-hsuan tsai*, wei-chih hung*, Samuel Schulter, Kihyuk Sohn, Ming-Hsuan Yang y Manmohan Chandraker

Conferencia IEEE sobre visión por computadora y reconocimiento de patrones (CVPR), 2018 ( Spotlight ) (* indica una contribución igual).

Cite nuestro documento si lo encuentra útil para su investigación.

@inproceedings{Tsai_adaptseg_2018,

author = {Y.-H. Tsai and W.-C. Hung and S. Schulter and K. Sohn and M.-H. Yang and M. Chandraker},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

title = {Learning to Adapt Structured Output Space for Semantic Segmentation},

year = {2018}

}

Instale Pytorch desde http://pytorch.org con Python 2 y Cuda 8.0

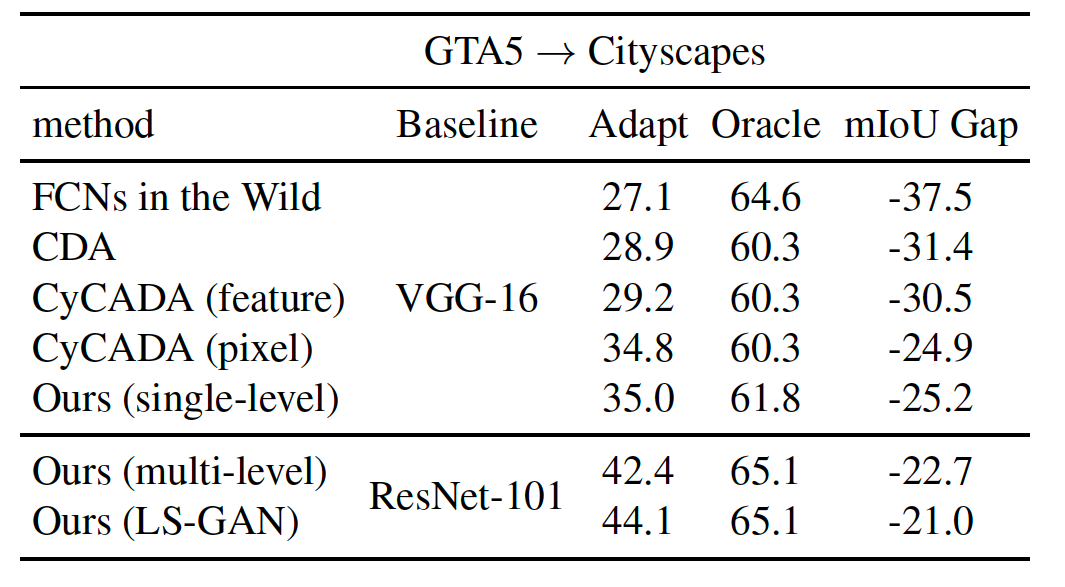

Nuevo Agregar el objetivo de LS-Gan para mejorar el rendimiento

--gan LS Opción durante la capacitación (consulte a continuación para obtener más detalles)Pytorch 0.4 con Python 3 y Cuda 8.0

pytorch_0.4--tensorboard en el comando--lambda-adv-target1 0.00005 --lambda-adv-target2 0.0005 . Investigaremos este problema pronto.Clon este repositorio

git clone https://github.com/wasidennis/AdaptSegNet

cd AdaptSegNet

Descargue el conjunto de datos GTA5 como dominio de origen y póngalo en la carpeta data/GTA5

Descargue el conjunto de datos Cityscapes como el dominio de destino y póngalo en la carpeta de data/Cityscapes

Encuentre nuestros modelos pretratidos utilizando resnet-101 en tres configuraciones de referencia aquí

Incluyen líneas de base (sin adaptación y con adaptación de características) y nuestros modelos (de un solo nivel y multinivel)

Nuevos resultados de actualización utilizando LS-Gan y usando Synscapes como dominio de origen

Descargue el modelo de GTA5 a Cityscapes de varios niveles previamente capacitado y colóquelo en la carpeta model

Prueba el modelo y los resultados se guardarán en la carpeta result

python evaluate_cityscapes.py --restore-from ./model/GTA2Cityscapes_multi-ed35151c.pth

python evaluate_cityscapes.py --model DeeplabVGG --restore-from ./model/GTA2Cityscapes_vgg-ac4ac9f6.pth

python compute_iou.py ./data/Cityscapes/data/gtFine/val result/cityscapes

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single_lsgan

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.01

--gan LS

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_multi

--lambda-seg 0.1

--lambda-adv-target1 0.0002 --lambda-adv-target2 0.001

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.001

Este código está muy prestado de Pytorch-Deeplab.

El modelo y el código están disponibles solo para fines de investigación no comerciales.