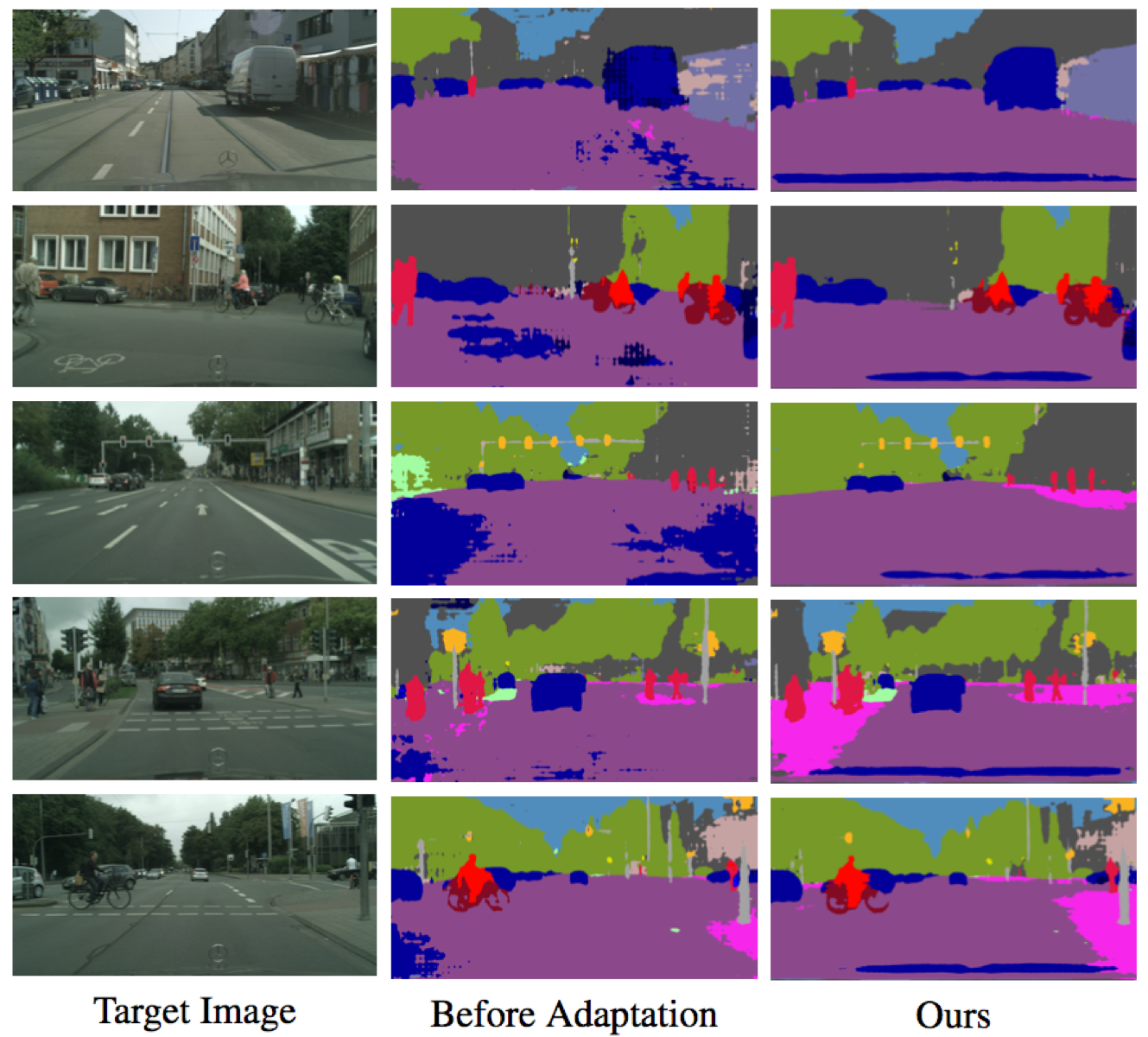

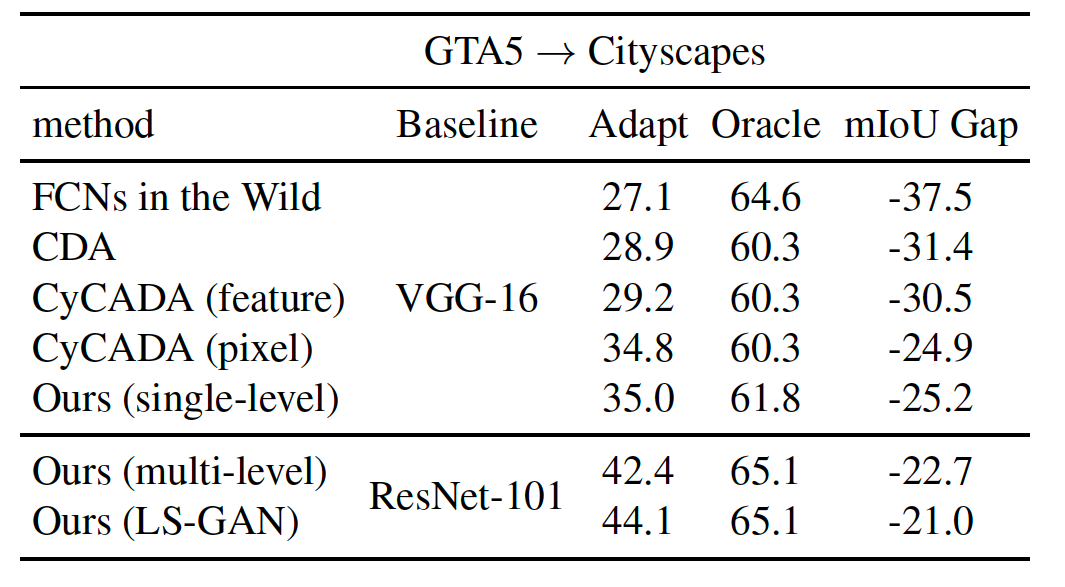

Implementação de Pytorch de nosso método para adaptar a segmentação semântica do conjunto de dados sintéticos (domínio de origem) ao conjunto de dados real (domínio de destino). Com base nessa implementação, nosso resultado é classificado em 3º lugar no Visda Challenge.

Contato: Yi-Hsuan Tsai (Wasidennis no Gmail Dot Com) e Wei-Chih Hung (Whung8 no Ucmerced Dot Edu)

Aprendendo a adaptar o espaço de saída estruturado para segmentação semântica

Yi-Hsuan Tsai*, Wei-chih Hung*, Samuel Schulter, Kihyuk Sohn, Ming-Hsuan Yang e Manmohan Chandraker

Conferência do IEEE sobre visão computacional e reconhecimento de padrões (CVPR), 2018 ( Spotlight ) (* indica contribuição igual).

Cite nosso artigo se achar útil para sua pesquisa.

@inproceedings{Tsai_adaptseg_2018,

author = {Y.-H. Tsai and W.-C. Hung and S. Schulter and K. Sohn and M.-H. Yang and M. Chandraker},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

title = {Learning to Adapt Structured Output Space for Semantic Segmentation},

year = {2018}

}

Instale o Pytorch em http://pytorch.org com Python 2 e Cuda 8.0

Novo Adicione o objetivo do LS-Gan para melhorar o desempenho

--gan LS durante o treinamento (veja abaixo para obter mais detalhes)Pytorch 0.4 com Python 3 e Cuda 8.0

pytorch_0.4--tensorboard no comando--lambda-adv-target1 0.00005 --lambda-adv-target2 0.0005 . Investigaremos esse problema em breve.Clone este repo

git clone https://github.com/wasidennis/AdaptSegNet

cd AdaptSegNet

Faça o download do conjunto de dados GTA5 como domínio de origem e coloque -o na pasta data/GTA5

Faça o download do conjunto de dados da Cityscapes como domínio de destino e coloque -o na pasta data/Cityscapes

Encontre nossos modelos pretados usando o ResNet-101 em três configurações de referência aqui

Eles incluem linhas de base (sem adaptação e com adaptação de recursos) e nossos modelos (de nível único e de vários níveis)

Novos resultados de atualização usando LS-GAN e usando synancapes como domínio de origem

Faça o download do modelo pré-treinado GTA5-to-Cityscapes e coloque-o na pasta model

Teste o modelo e os resultados serão salvos na pasta result

python evaluate_cityscapes.py --restore-from ./model/GTA2Cityscapes_multi-ed35151c.pth

python evaluate_cityscapes.py --model DeeplabVGG --restore-from ./model/GTA2Cityscapes_vgg-ac4ac9f6.pth

python compute_iou.py ./data/Cityscapes/data/gtFine/val result/cityscapes

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single_lsgan

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.01

--gan LS

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_multi

--lambda-seg 0.1

--lambda-adv-target1 0.0002 --lambda-adv-target2 0.001

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.001

Este código é fortemente emprestado da Pytorch-Deeplab.

O modelo e o código estão disponíveis apenas para fins de pesquisa não comerciais.