Pytorch -Implementierung unserer Methode zur Anpassung der semantischen Segmentierung aus dem synthetischen Datensatz (Quelldomäne) an den realen Datensatz (Zieldomäne). Basierend auf dieser Implementierung wird unser Ergebnis in der Visda Challenge den 3. Platz belegt.

Kontakt: Yi-Hsuan Tsai (Wasidennis bei Google Mail dot com) und Wei-chih Hung (whunte8 bei Ucmerced dot edu)

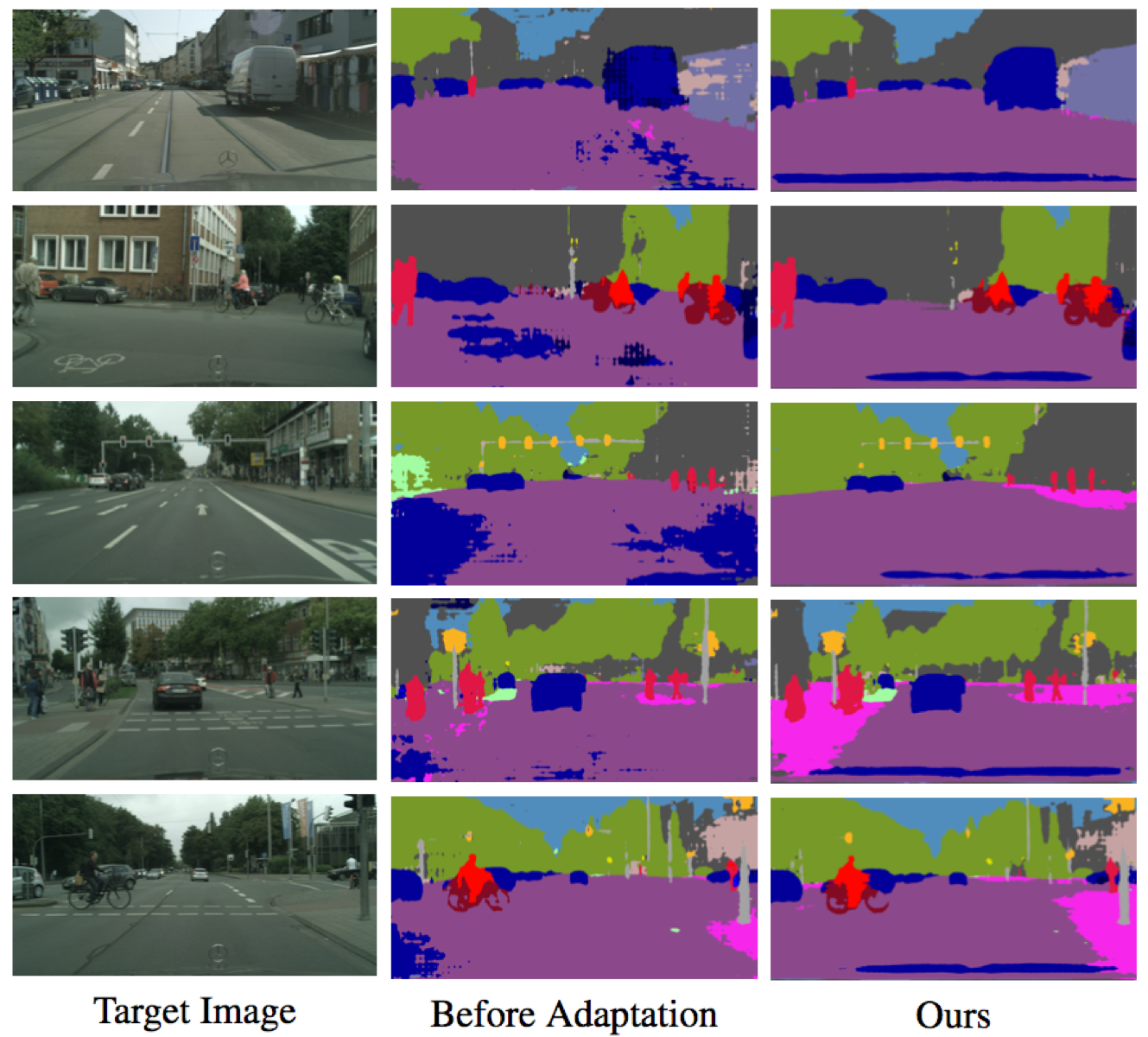

Lernen, den strukturierten Ausgangsraum für die semantische Segmentierung anzupassen

Yi-Hsuan Tsai*, Wei-Chih Hung*, Samuel Schulter, Kihyuk Sohn, Ming-Hsuan Yang und Manmohan Chandraker

IEEE -Konferenz über Computer Vision und Mustererkennung (CVPR), 2018 ( Spotlight ) (* zeigt den gleichen Beitrag an).

Bitte zitieren Sie unser Papier, wenn Sie es für Ihre Forschung nützlich finden.

@inproceedings{Tsai_adaptseg_2018,

author = {Y.-H. Tsai and W.-C. Hung and S. Schulter and K. Sohn and M.-H. Yang and M. Chandraker},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

title = {Learning to Adapt Structured Output Space for Semantic Segmentation},

year = {2018}

}

Installieren Sie Pytorch von http://pytorch.org mit Python 2 und CUDA 8.0

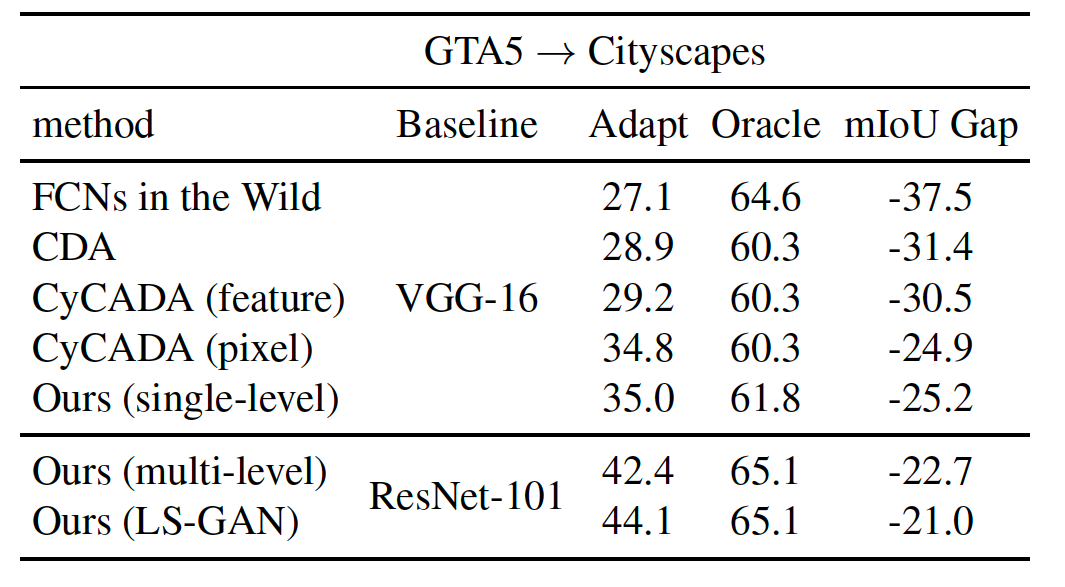

Neu addieren Sie das LS-GAN-Ziel, um die Leistung zu verbessern

--gan LS -Option während des Trainings (siehe unten für weitere Details)Pytorch 0,4 mit Python 3 und CUDA 8.0

pytorch_0.4--tensorboard im Befehl bereitgestellt--lambda-adv-target1 0.00005 --lambda-adv-target2 0.0005 Wir werden dieses Problem bald untersuchen.Klonen Sie dieses Repo

git clone https://github.com/wasidennis/AdaptSegNet

cd AdaptSegNet

Laden Sie den GTA5 -Datensatz als Quelldomäne herunter und geben Sie ihn in den Ordner data/GTA5 ein

Laden Sie den CityScapes -Datensatz als Zieldomäne herunter und legen Sie ihn in den Ordner data/Cityscapes ein

Weitere Modelle finden Sie in drei Benchmark-Einstellungen hier mit ResNet-101

Dazu gehören Baselines (ohne Anpassung und mit Feature-Anpassung) und unsere Modelle (einstufige und mehrstufige)

Neue Update-Ergebnisse mit LS-GAN und Synscapes als Quelldomäne verwenden

Laden Sie das vorgebildete Multi-Level-GTA5-to-City-Sendesmodell herunter und legen Sie es in den model ein

Testen Sie das Modell und die Ergebnisse werden im result gespeichert

python evaluate_cityscapes.py --restore-from ./model/GTA2Cityscapes_multi-ed35151c.pth

python evaluate_cityscapes.py --model DeeplabVGG --restore-from ./model/GTA2Cityscapes_vgg-ac4ac9f6.pth

python compute_iou.py ./data/Cityscapes/data/gtFine/val result/cityscapes

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single_lsgan

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.01

--gan LS

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_multi

--lambda-seg 0.1

--lambda-adv-target1 0.0002 --lambda-adv-target2 0.001

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.001

Dieser Code wird stark von Pytorch-Deeplab geliehen.

Das Modell und der Code sind nur für nichtkommerzielle Forschungszwecke verfügbar.