Implémentation pytorch de notre méthode pour adapter la segmentation sémantique de l'ensemble de données synthétique (domaine source) à l'ensemble de données réel (domaine cible). Sur la base de cette implémentation, notre résultat est classé troisième au Visda Challenge.

Contact: Yi-Hsuan Tsai (Wasidennis à Gmail Dot Com) et Wei-chih Hung (Whung8 at ucmerced dot edu)

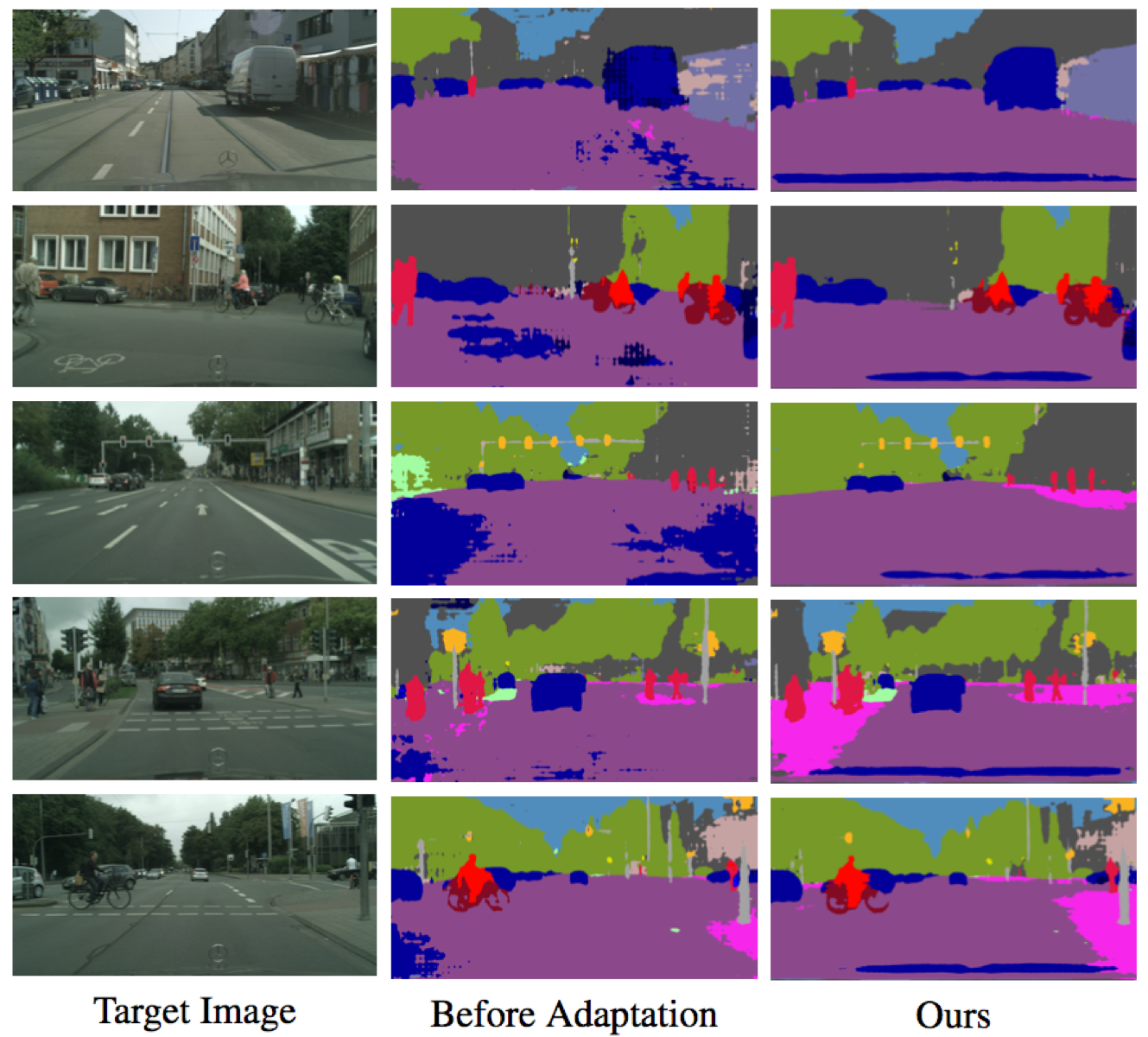

Apprendre à adapter l'espace de sortie structuré pour la segmentation sémantique

Yi-hsuan tsai *, Wei-chih Hung *, Samuel Schulter, Kihyuk Sohn, Ming-Hsuan Yang et Manmohan Chandraker

Conférence IEEE sur la vision par ordinateur et la reconnaissance des modèles (CVPR), 2018 ( Spotlight ) (* indique une contribution égale).

Veuillez citer notre article si vous le trouvez utile pour vos recherches.

@inproceedings{Tsai_adaptseg_2018,

author = {Y.-H. Tsai and W.-C. Hung and S. Schulter and K. Sohn and M.-H. Yang and M. Chandraker},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

title = {Learning to Adapt Structured Output Space for Semantic Segmentation},

year = {2018}

}

Installez Pytorch à partir de http://pytorch.org avec Python 2 et Cuda 8.0

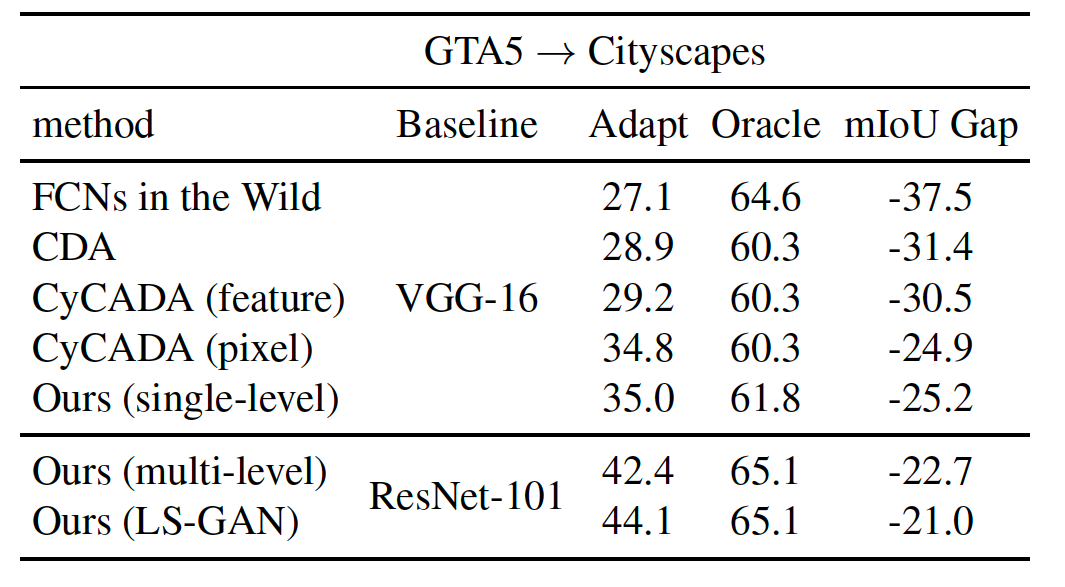

Nouveau Ajouter l'objectif LS-Gan pour améliorer les performances

--gan LS pendant l'entraînement (voir ci-dessous pour plus de détails)Pytorch 0.4 avec Python 3 et Cuda 8.0

pytorch_0.4--tensorboard dans la commande--lambda-adv-target1 0.00005 --lambda-adv-target2 0.0005 . Nous enquêterons bientôt sur ce problème.Cloner ce repo

git clone https://github.com/wasidennis/AdaptSegNet

cd AdaptSegNet

Téléchargez l'ensemble de données GTA5 comme domaine source et mettez-les dans le dossier data/GTA5

Téléchargez l'ensemble de données Cityscapes comme domaine cible et mettez-les dans le dossier data/Cityscapes

Veuillez trouver nos modèles prétraités en utilisant RESNET-101 sur trois paramètres de référence ici

Ils incluent les lignes de base (sans adaptation et avec adaptation des fonctionnalités) et nos modèles (un niveau et multi-niveaux)

Nouveaux résultats de mise à jour à l'aide de LS-Gan et à l'aide de synscapes comme domaine source

Téléchargez le modèle GTA5-to-Cityscapes pré-formé à plusieurs niveaux et mettez-le dans le dossier model

Testez le modèle et les résultats seront enregistrés dans le dossier result

python evaluate_cityscapes.py --restore-from ./model/GTA2Cityscapes_multi-ed35151c.pth

python evaluate_cityscapes.py --model DeeplabVGG --restore-from ./model/GTA2Cityscapes_vgg-ac4ac9f6.pth

python compute_iou.py ./data/Cityscapes/data/gtFine/val result/cityscapes

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single_lsgan

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.01

--gan LS

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_multi

--lambda-seg 0.1

--lambda-adv-target1 0.0002 --lambda-adv-target2 0.001

python train_gta2cityscapes_multi.py --snapshot-dir ./snapshots/GTA2Cityscapes_single

--lambda-seg 0.0

--lambda-adv-target1 0.0 --lambda-adv-target2 0.001

Ce code est fortement emprunté à Pytorch-DeepLab.

Le modèle et le code sont disponibles à des fins de recherche non commerciales uniquement.