很棒的llm-kg

有關統一大型語言模型(LLM)和知識圖(kgs)的論文和資源集合。

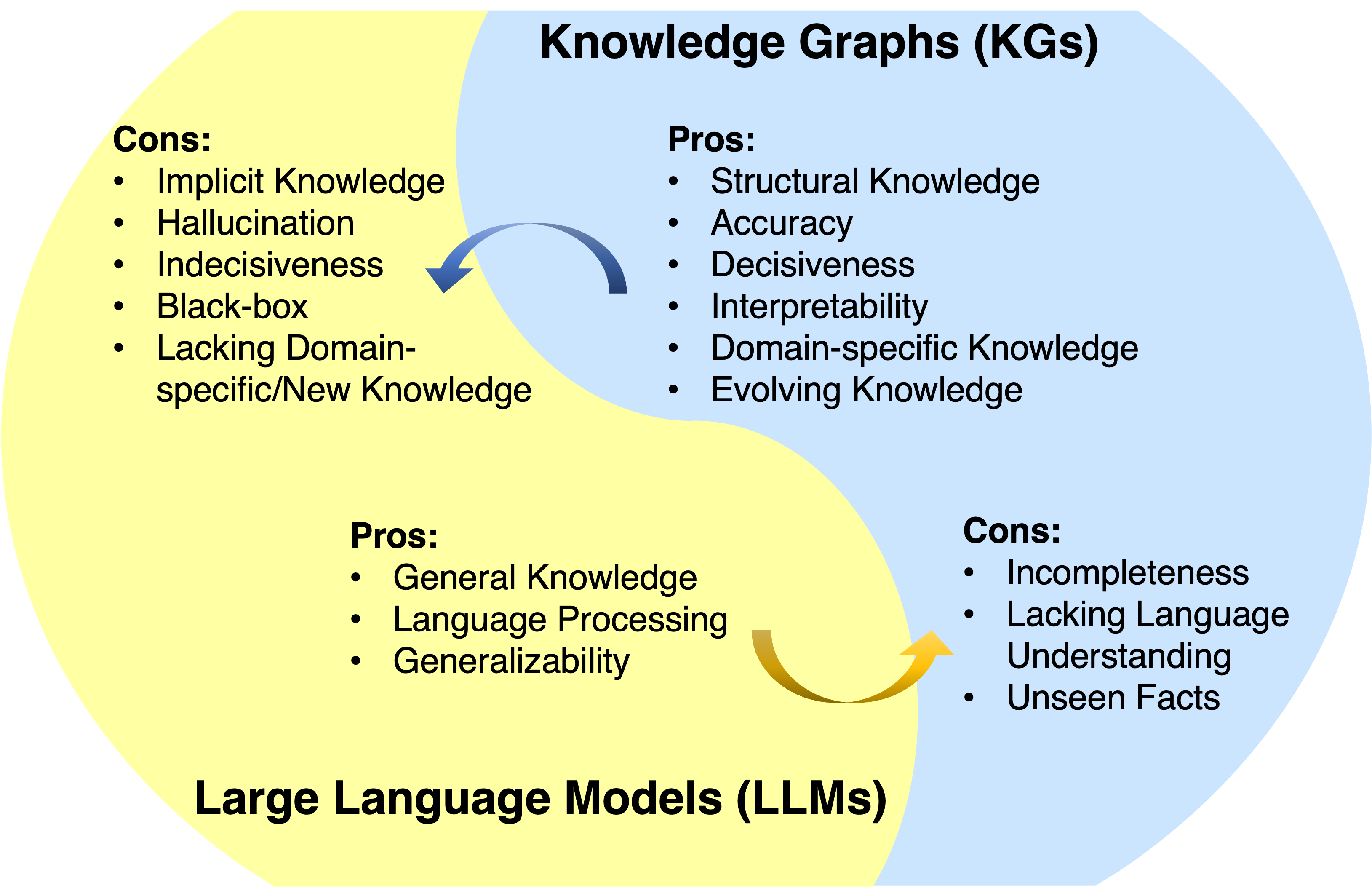

大型語言模型(LLMS)在各種應用中取得了巨大的成功和普遍性。但是,他們通常沒有捕捉和獲得事實知識。知識圖(KGS)是明確存儲豐富事實知識的結構化數據模型。然而,KG很難構建,並且在KGS中的現有方法在處理現實世界中不完整且動態變化的性質方面不足。因此,很自然地將LLM和KG統一併同時利用其優勢。

消息

?該項目正在開發中。您可以擊中星星並觀看以關注更新。

- 我們在KG + LLM reaosning上的最新工作現已公開:圖形受限的推理:具有大語言模型的知識圖上的忠實推理

- 我們用於時間kg推理工作的LLM:2024年Neurips 2024接受了大語言模型引導的時間知識圖形推理的動態適應!

- 我們用於分析LLM推理論文的KG:ACL 2024接受了知識圖的多跳推理中對多跳的推理的直接評估。

- 我們的路線圖紙已被TKDE接受。

- 我們用於LLM探測論文的KG:EMNLP 2023接受了大語言模型中事實知識的系統評估。

- 我們的KG + LLM推理論文:圖表上的推理:ICLR 2024接受了忠實且可解釋的大語言模型推理。

- 我們用於公斤推理論文的LLM:Chatrule:帶有大型語言模型的知識圖形推理的邏輯規則現在已公開。

- 我們的路線圖紙:統一大型語言模型和知識圖:路線圖現已公開。

概述

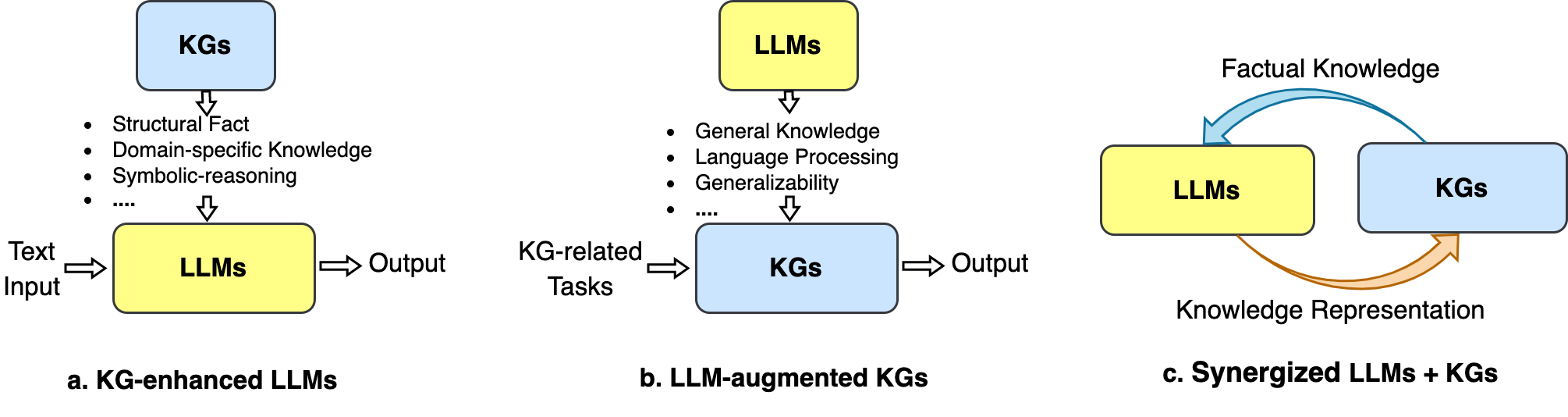

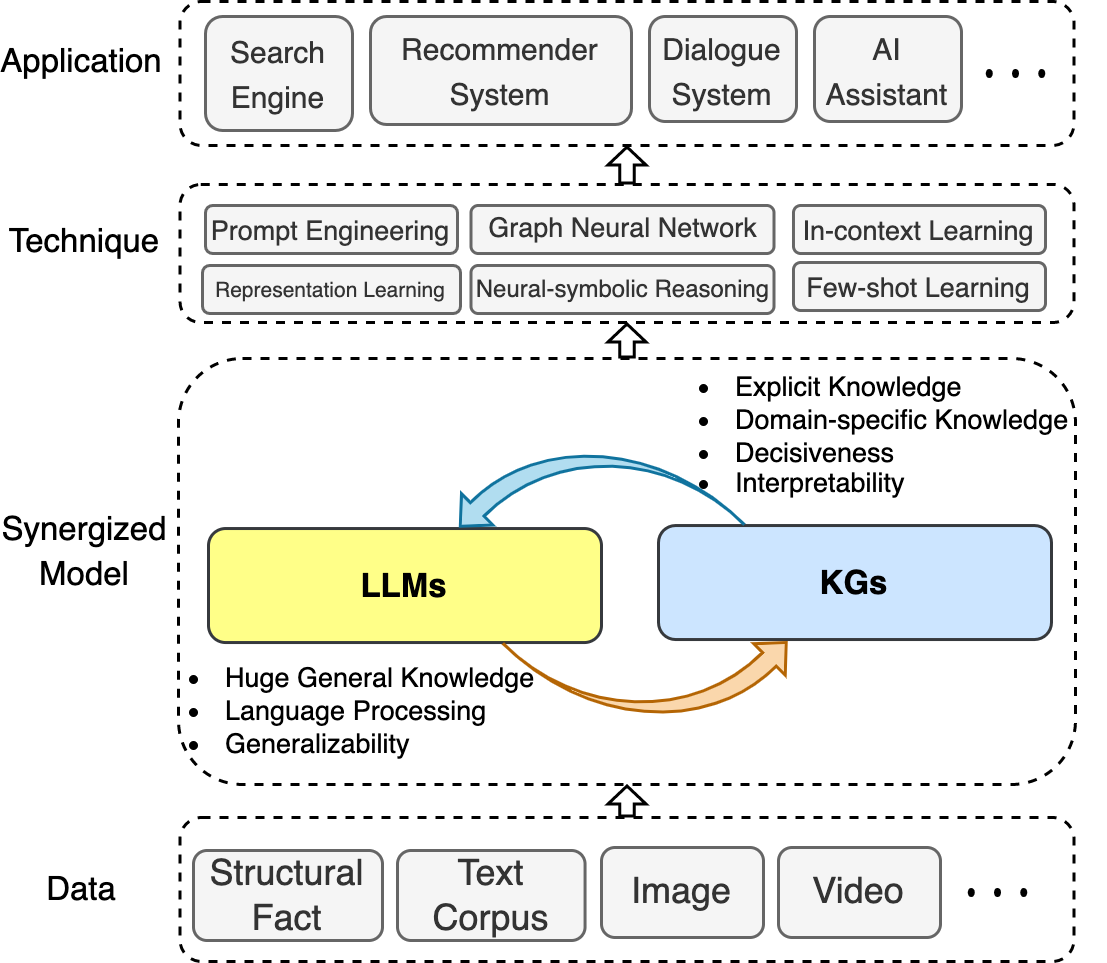

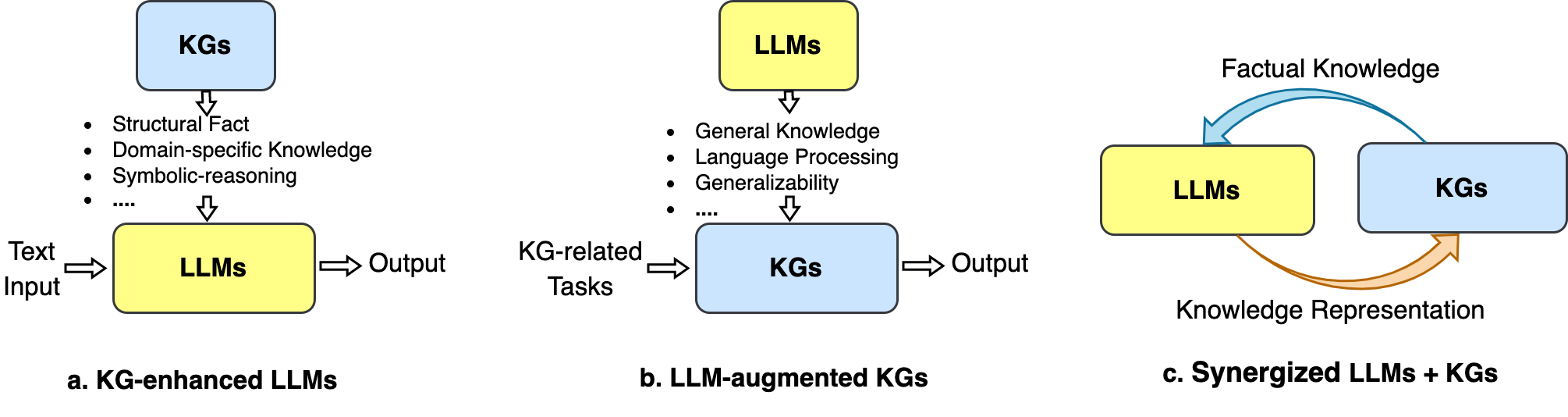

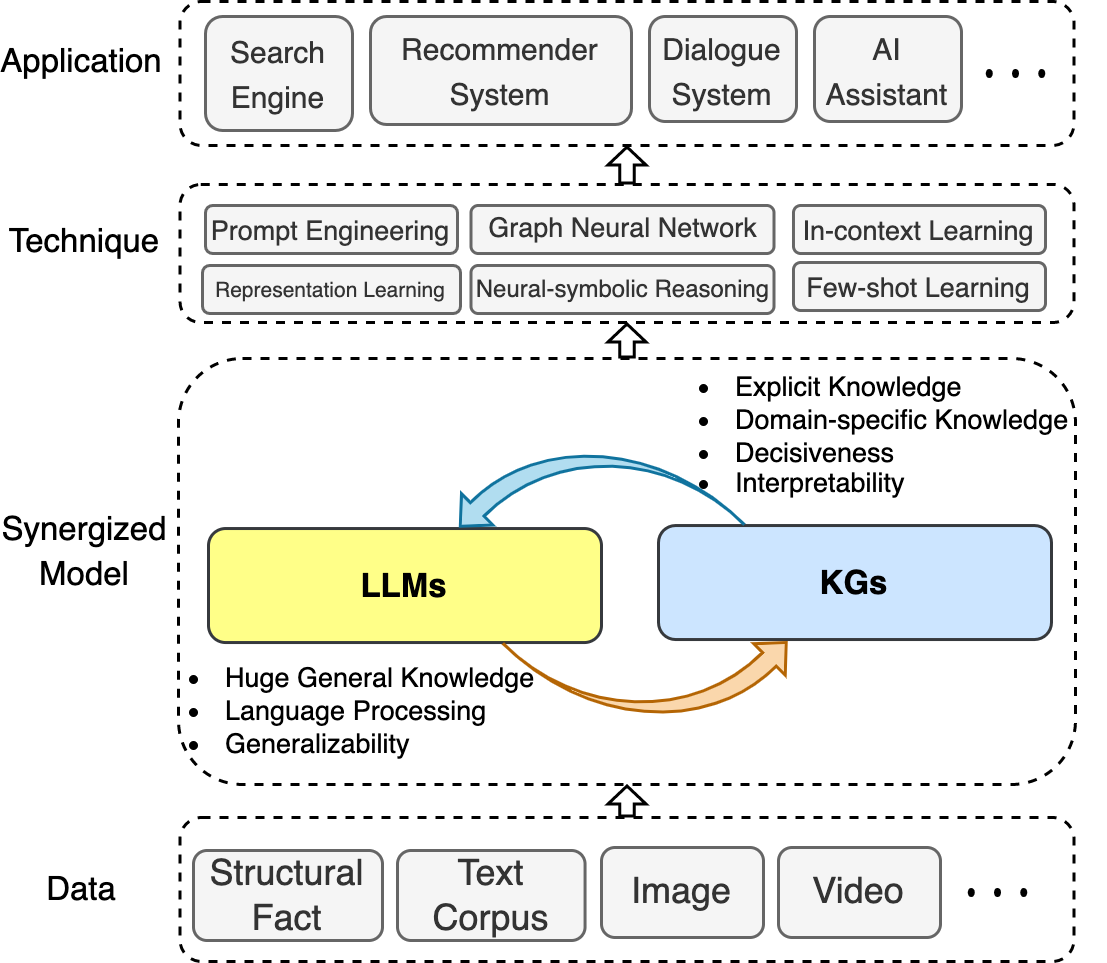

在此存儲庫中,我們收集了統一LLM和KGS的最新進展。我們提出了一個路線圖,該路線圖總結了三個通用框架: 1)kg增強的LLM , 2)LLMS增強的kgs和3)協同的LLMS + kgs 。

我們還說明了所涉及的技術和應用。

我們希望這個存儲庫可以幫助研究人員和從業人員更好地了解這一新興領域。

如果此存儲庫對您有幫助,請引用本文來幫助我們:

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}目錄

- 很棒的llm-kg

- 消息

- 概述

- 目錄

- 相關調查

- kg增強的LLM

- kg增強的LLM預訓練

- KG增強的LLM推論

- KG增強的LLM可解釋性

- llm-aigment kgs

- llm-aigment kg嵌入

- llm-aigment kg完成

- llm aignited kg至文本一代

- llm-aigment kg問題回答

- 協同LLMS + kgs

- 申請

相關調查

- 統一大型語言模型和知識圖:路線圖(TKDE,2024)[紙]

- 一項有關知識增強的預訓練的語言模型的調查(Arxiv,2023)[紙]

- 對知識密集型NLP的調查(Arxiv,2022)[紙]

- 語言模型作為知識基礎的綜述(Arxiv,2022)[紙]

- 生成知識圖構造:評論(EMNLP,2022)[紙]

- 知識增強了預審前的語言模型:一項綜合調查(Arxiv,2021)[紙]

- 在不同類型的知識圖上推理:靜態,時間和多模式(Arxiv,2022)[Paper] [代碼]

kg增強的LLM

kg增強的LLM預訓練

- Ernie:具有信息實體的增強語言表示(ACL,2019年)[論文]

- 通過圖引導表示學習在文本中利用結構化知識(EMNLP,2019)[紙]

- SKEP:情感知識增強了情感分析的預訓練(ACL,2020)[紙]

- e-bert:電子商務的短語和產品知識增強語言模型(Arxiv,2020)[紙]

- 預驗證的百科全書:弱監督的知識語語言模型(ICLR,2020)[紙]

- BERT-MK:將圖表化知識整合到預訓練的語言模型(EMNLP,2020)[紙]

- K-Bert:具有知識圖(AAAI,2020)的語言表示[紙]

- Colake:語境化語言和知識嵌入(Coling,2020)[紙]

- 開普勒:一個統一的知識嵌入和預訓練語言表示模型(TACL,2021)[紙]

- K-Audapter:將知識注入具有適配器的預訓練模型(ACL發現,2021)[紙]

- 可口可樂:上下文知識選擇並嵌入增強的預訓練的語言模型(AI Open,2021)[紙]

- Ernie 3.0:大規模知識增強了語言理解和產生的預訓練(Arixv,2021)[紙]

- 具有確定性事實知識的培訓前語言模型(EMNLP,2022)[紙]

- 卡拉:知識增強語言模型適應(NAACL,2022)[紙]

- DKPLM:自然語言理解的可分解知識增強的預訓練的預訓練的語言模型(AAAI,2022)[紙]

- dict-bert:用字典增強語言模型(ACL調查結果,2022)[紙]

- Jaket:知識圖和語言理解的聯合預培訓(AAAI,2022)[紙]

- 電視知識預訓練用於故障分析(ICDE,2023)[紙]

KG增強的LLM推論

- 巴拉克(Barack)的妻子希拉里(Hillary):將知識圖用於事實感知語言建模(ACL,2019年)[紙]

- 用於知識密集型NLP任務的檢索生成(Neurips,2020)[紙]

- 領域:檢索語言模型預訓練(ICML,2020)[紙]

- QA-GNN:用語言模型和知識圖的推理,以回答問題(NAACL,2021)[紙]

- 記憶和知識增強語言模型,用於推斷長期故事中的顯著性(EMNLP,2021)[紙]

- 聯合LK:與常識性問題的語言模型和知識圖回答的聯合推理(NAACL,2022)[紙]

- 通過基於動態文檔的知識圖(AAAI,2022)對大型語言模型的增強故事理解[紙]

- Greaselm:圖形推理增強語言模型(ICLR,2022)[紙]

- 用於知識密集型NLP任務(EMNLP,2022)的有效內存功能增強的變壓器[Paper]

- 知識增強的語言模型提示零拍的知識圖答錄(NLRSE@acl,2023)[紙]

- 在不斷發展的環境中,基於LLM的多跳問題通過知識圖集成(EMNLP發現,2024年)[紙]

KG增強的LLM可解釋性

- 語言模型作為知識基礎(EMNLP,2019年)[論文]

- Kagnet:常識性推理的知識感知圖網絡(Arxiv,2019)[紙]

- 自動啟動:從具有自動生成的提示的語言模型中獲取知識(EMNLP,2020)[紙]

- 我們怎麼知道語言模型知道什麼? (ACL,2020)[紙]

- 經過審慎的變壓器的知識神經元(ACL,2021)[紙]

- 語言模型可以是生物醫學知識庫嗎? (EMNLP,2021)[紙]

- 通過知識圖提取(Arxiv,2021)來解釋語言模型[紙]

- QA-GNN:用語言模型和知識圖回答的推理(ACL,2021)[紙]

- 如何查詢語言模型? (Arxiv,2021)[紙]

- 重新播放 - 探針:一種探測預訓練語言模型生物醫學知識的對比配方(Arxiv,2021)[紙]

- 當不信任語言模型時:調查參數和非參數記憶的有效性和局限性(Arxiv,2022)[紙]

- 預訓練的語言模型如何捕獲事實知識?因果啟發的分析(Arxiv,2022)[紙]

- 知識圖可以簡化文本嗎? (CIKM,2023)[紙]

llm-aigment kgs

llm-aigment kg嵌入

- 大型語言模型的嘈雜註釋(Neurips,2024)[紙]的實體對齊

- Lambdakg:基於預訓練的語言模型的知識圖嵌入(Arxiv,2023)的庫[Paper]

- 在超複雜空間(Arxiv,2022)中整合知識圖嵌入和驗證的語言模型[紙]

- 具有多模式知識圖表(Arxiv,2022)的賦予語言模型[紙]

- 語言模型指導知識圖嵌入(IEEE訪問,2022)[紙]

- 語言模型作為知識嵌入(IJCAI,2022)[紙]

- 預算:從驗證的語言模型(EMNLP,2020)中學習知識表示[紙]

- 開普勒:知識嵌入和預訓練語言表示的統一模型(TACL,2020)[紙]

llm-aigment kg完成

- 具有大型語言模型(Coling 2024)[紙] [代碼]的知識圖完成的多角度改進

- kg-bert:知識圖完成的伯特(Arxiv,2019年)[紙]

- 具有預訓練的語言模型(Coling,2020)的知識圖完成的多任務學習[紙]

- 預訓練的模型是否有益於知識圖的完成?可靠的評估和合理的方法(ACL,2022)[紙]

- 知識圖完成的聯合語言語義和結構嵌入(Coling,2022)[紙]

- MEM-KGC:具有預訓練的語言模型(IEEE Access,2021)的知識圖完成的蒙版實體模型[Paper]

- 通過統一學習方法(基於知識的Syst。,2023),具有預訓練的語言模型的知識圖擴展名[紙]

- 結構增強的文本表示為有效的知識圖完成(www,2021)[紙]

- SIMKGC:使用預訓練的語言模型(ACL,2022)[Paper]的簡單對比知識圖完成

- LP-bert:多任務預訓練知識圖BERT用於鏈接預測(Arxiv,2022)[紙]

- 從歧視到世代:知識圖完成,具有生成變壓器(www,2022)[紙]

- 序列到序列知識圖的完成和問答(ACL,2022)[紙]

- 知識是平坦的:用於各種知識圖完成的SEQ2SEQ生成框架(Coling,2022)[Paper]

- 將預先訓練的語言模型調整為知識圖完成的框架(EMNLP,2022)[紙]

- 浸入plms醬:通過有條件軟提示完成的有效知識圖完成的橋接結構和文本(ACL,2023)[紙]

llm aignited kg至文本一代

- Genwiki:一個無監督的圖形到文本生成(Coling,2020)的130萬個內容共享文本和圖的數據集[紙

- KGPT:數據到文本生成(EMNLP 2020)的知識接收預培訓[紙]

- 關節:從知識圖(ACL調查結果,2021)[紙]

- 調查圖表到文本生成的審慎語言模型(NLP4Convai,2021)[紙]

- 幾乎沒有驗證的語言模型(ACL,2021)[Paper]

- EventNarrative:一個以事件為中心的大規模知識數據集(Neurips,2021)[Paper]

- 差距:知識圖形到文本生成的圖形知覺語言模型框架(Coling,2022)[紙]

llm-aigment kg問題回答

- UNIKGQA:統一的檢索和推理,用於解決多跳的問題回答知識圖(ICLR,2023)[紙]

- 結構爭奪:大語言模型的一般框架,以推理結構化數據(Arxiv,2023)[紙]

- GPT-3的實證研究,用於基於知識的VQA(AAAI,2022)[紙]

- 簡單知識圖中的預訓練語言模型的經驗研究答案(世界網絡雜誌,2023年)[紙]

- 通過知識圖賦予語言模型的開放域問題回答(EMNLP,2022)[紙]

- DRLK:具有語言模型和知識圖的動態層次結構推理(EMNLP,2022)[紙]

- 多跳躍知識基礎問題回答的子圖檢索增強模型(ACL,2022)[紙]

- Greaselm:圖形推理增強的語言模型,以回答(ICLR,2022)[紙]

- Lako:知識驅動的視覺問題通過後期知識對文本注入回答(IJCKG,2022)[紙]

- QA-GNN:用語言模型和知識圖的推理,以回答問題(NAACL,2021)[紙]

協同LLMS + kgs

知識表示

- 電視知識預訓練用於故障分析(ICDE,2023)[紙]

- 將特定領域的異質知識納入統一表示形式的訓練前語言模型(適用於應用的專家系統,2023年)[紙]

- 深雙向語言知識圖(NIPS,2022)[紙]

- 開普勒:一個統一的知識嵌入和預訓練語言表示模型(TACL,2021)[紙]

- 關節:從知識圖(ACL 2021)[紙]

推理

- 用於增強域特異性NLP任務(Arxiv,2023)的統一知識增強服務[Paper]

- 複雜推理的統一結構推理和語言模型預訓練(Arxiv,2023)[紙]

- 使用大語言模型(Arxiv,2023)[紙]對知識圖上的複雜邏輯推理

申請

推薦系統

- 恢復:使用預審前的語言模型(Arxiv,2023)的統一框架[紙]

故障分析

- 電視知識預訓練用於故障分析(ICDE,2023)[紙]