很棒的llm-kg

有关统一大型语言模型(LLM)和知识图(kgs)的论文和资源集合。

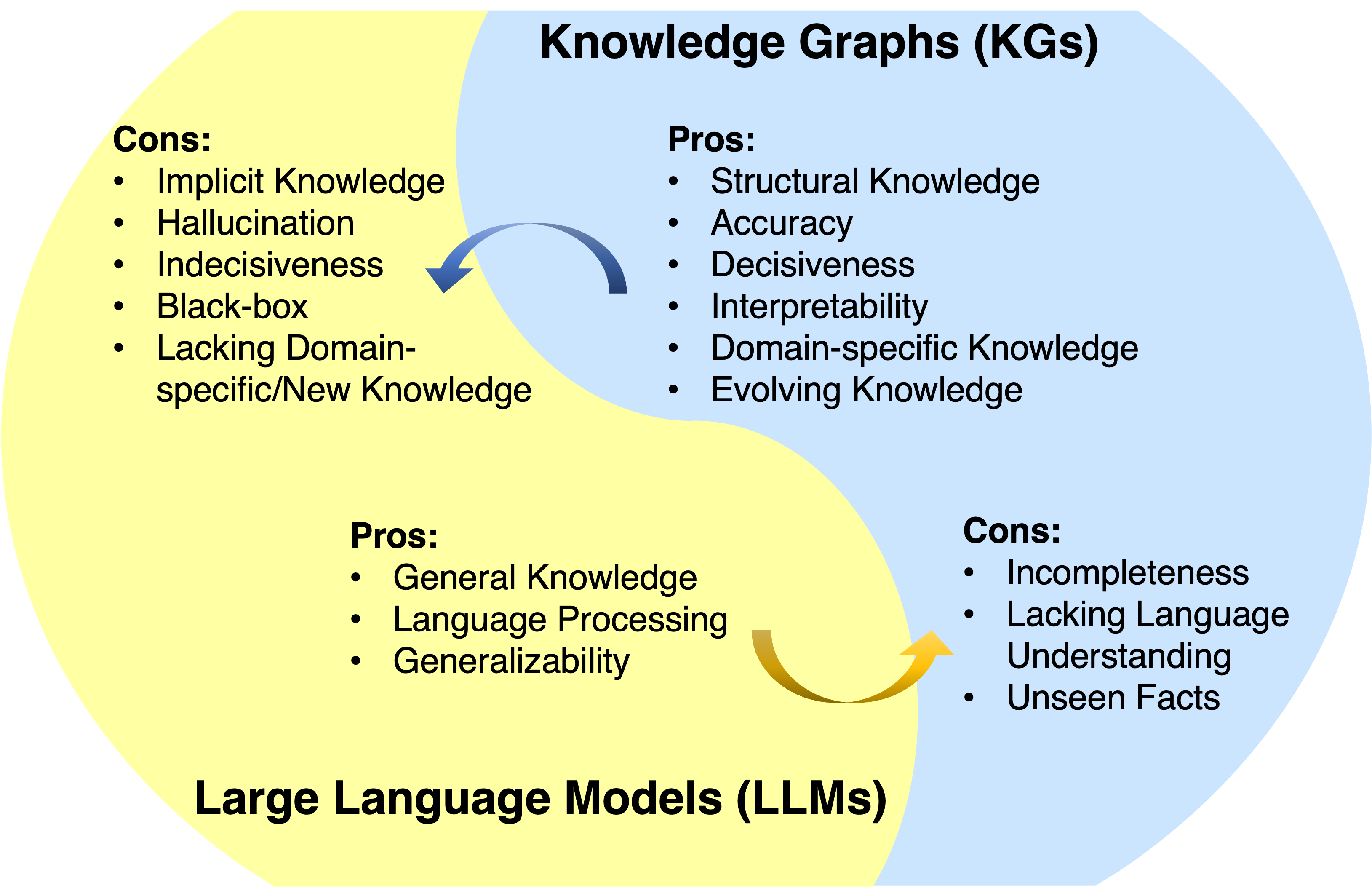

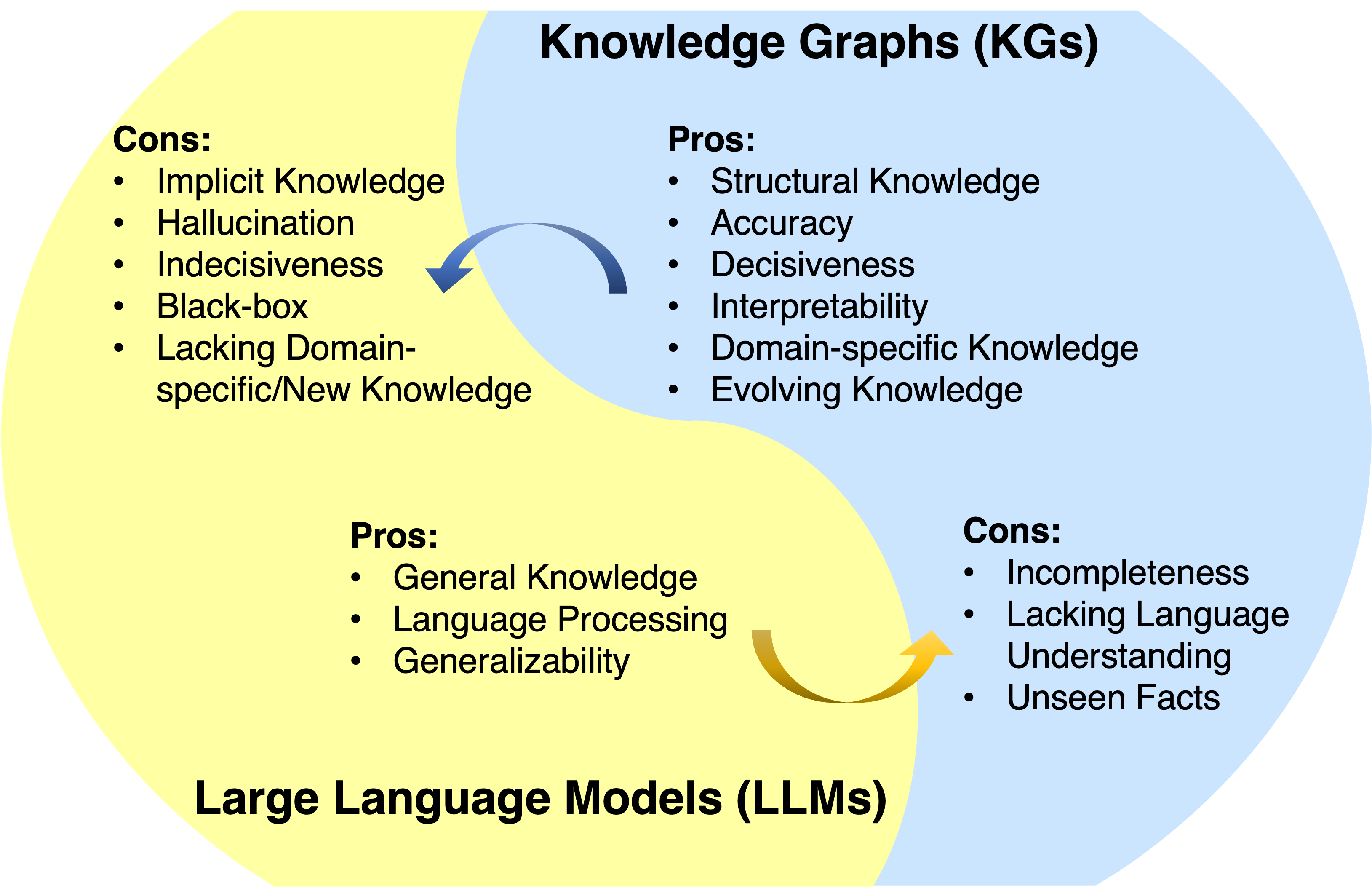

大型语言模型(LLMS)在各种应用中取得了巨大的成功和普遍性。但是,他们通常没有捕捉和获得事实知识。知识图(KGS)是明确存储丰富事实知识的结构化数据模型。然而,KG很难构建,并且在KGS中的现有方法在处理现实世界中不完整且动态变化的性质方面不足。因此,很自然地将LLM和KG统一并同时利用其优势。

消息

?该项目正在开发中。您可以击中星星并观看以关注更新。

- 我们在KG + LLM reaosning上的最新工作现已公开:图形受限的推理:具有大语言模型的知识图上的忠实推理

- 我们用于时间kg推理工作的LLM:2024年Neurips 2024接受了大语言模型引导的时间知识图形推理的动态适应!

- 我们用于分析LLM推理论文的KG:ACL 2024接受了知识图的多跳推理中对多跳的推理的直接评估。

- 我们的路线图纸已被TKDE接受。

- 我们用于LLM探测论文的KG:EMNLP 2023接受了大语言模型中事实知识的系统评估。

- 我们的KG + LLM推理论文:图表上的推理:ICLR 2024接受了忠实且可解释的大语言模型推理。

- 我们用于公斤推理论文的LLM:Chatrule:带有大型语言模型的知识图形推理的逻辑规则现在已公开。

- 我们的路线图纸:统一大型语言模型和知识图:路线图现已公开。

概述

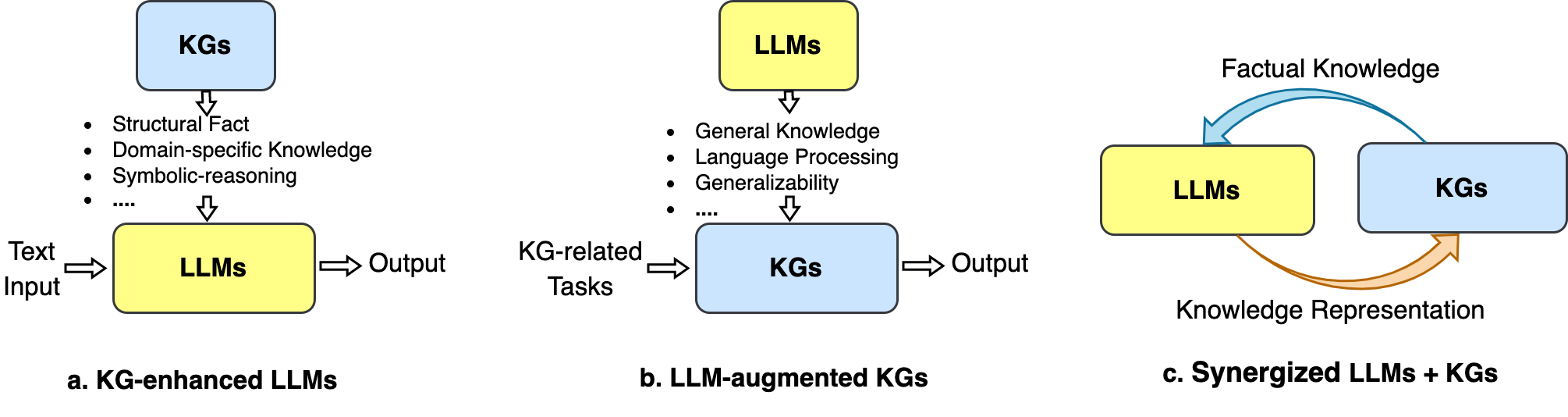

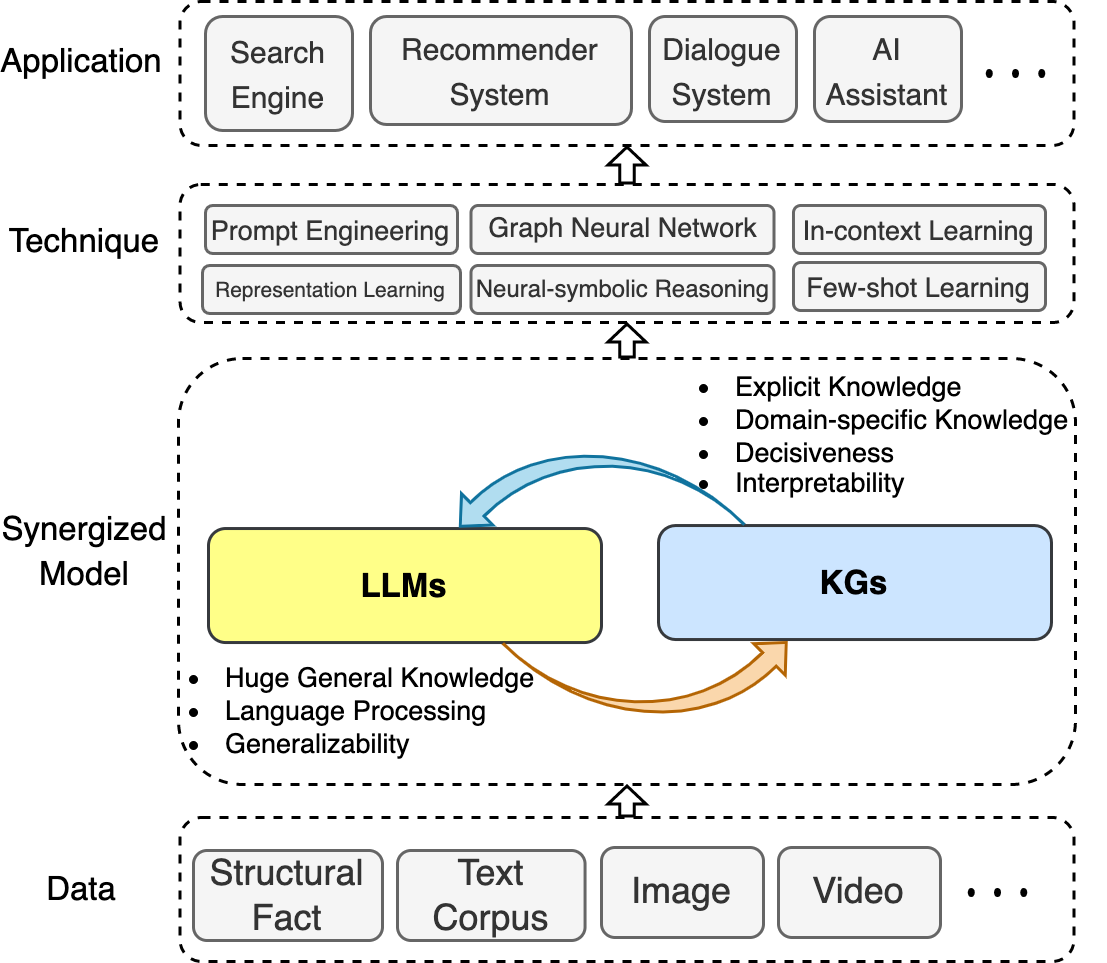

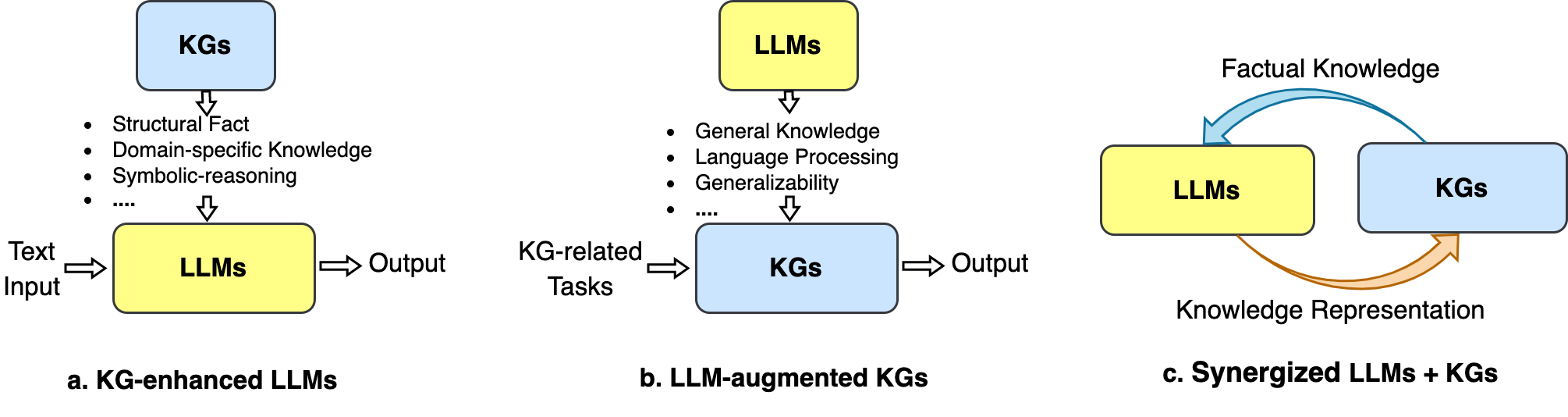

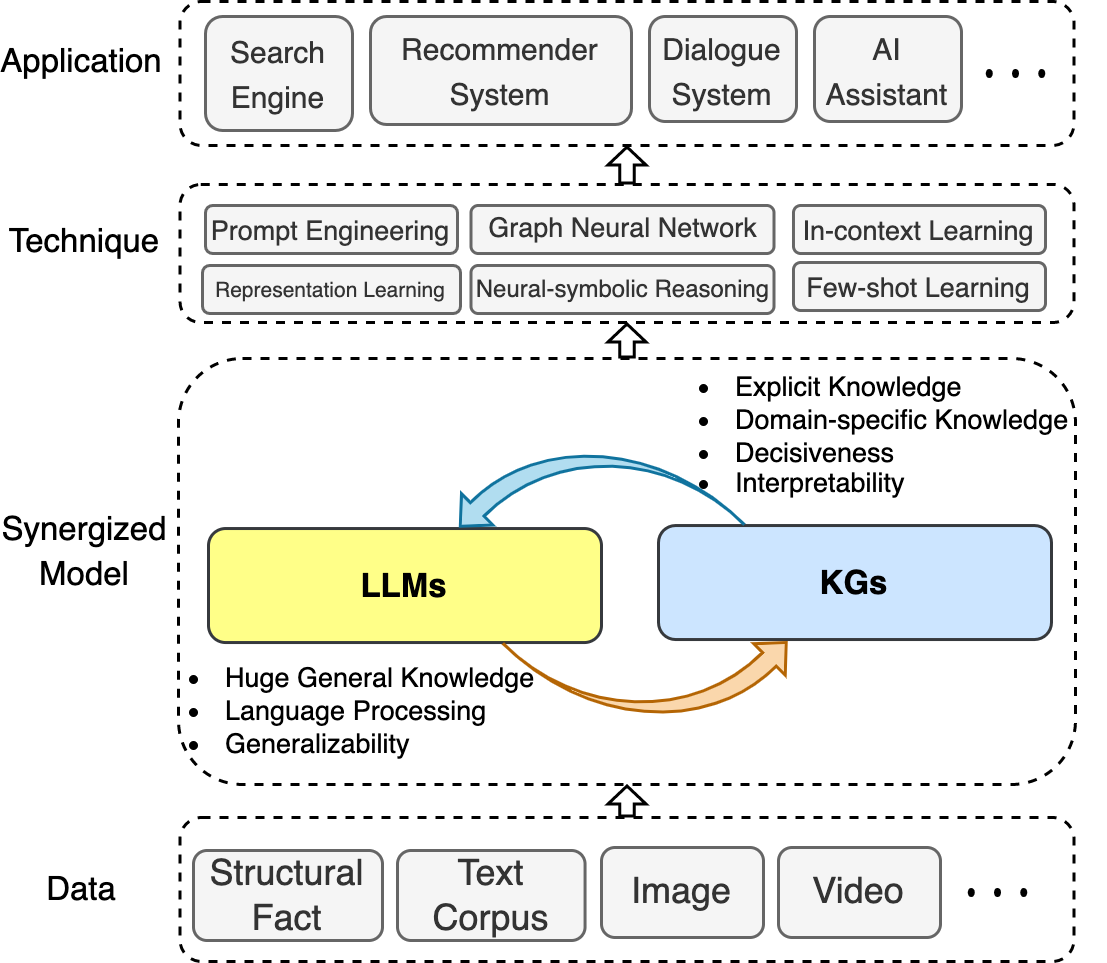

在此存储库中,我们收集了统一LLM和KGS的最新进展。我们提出了一个路线图,该路线图总结了三个通用框架: 1)kg增强的LLM , 2)LLMS增强的kgs和3)协同的LLMS + kgs 。

我们还说明了所涉及的技术和应用。

我们希望这个存储库可以帮助研究人员和从业人员更好地了解这一新兴领域。

如果此存储库对您有帮助,请引用本文来帮助我们:

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}目录

- 很棒的llm-kg

- 消息

- 概述

- 目录

- 相关调查

- kg增强的LLM

- kg增强的LLM预训练

- KG增强的LLM推论

- KG增强的LLM可解释性

- llm-aigment kgs

- llm-aigment kg嵌入

- llm-aigment kg完成

- llm aignited kg至文本一代

- llm-aigment kg问题回答

- 协同LLMS + kgs

- 申请

相关调查

- 统一大型语言模型和知识图:路线图(TKDE,2024)[纸]

- 一项有关知识增强的预训练的语言模型的调查(Arxiv,2023)[纸]

- 对知识密集型NLP的调查(Arxiv,2022)[纸]

- 语言模型作为知识基础的综述(Arxiv,2022)[纸]

- 生成知识图构造:评论(EMNLP,2022)[纸]

- 知识增强了预审前的语言模型:一项综合调查(Arxiv,2021)[纸]

- 在不同类型的知识图上推理:静态,时间和多模式(Arxiv,2022)[Paper] [代码]

kg增强的LLM

kg增强的LLM预训练

- Ernie:具有信息实体的增强语言表示(ACL,2019年)[论文]

- 通过图引导表示学习在文本中利用结构化知识(EMNLP,2019)[纸]

- SKEP:情感知识增强了情感分析的预训练(ACL,2020)[纸]

- e-bert:电子商务的短语和产品知识增强语言模型(Arxiv,2020)[纸]

- 预验证的百科全书:弱监督的知识语语言模型(ICLR,2020)[纸]

- BERT-MK:将图表化知识整合到预训练的语言模型(EMNLP,2020)[纸]

- K-Bert:具有知识图(AAAI,2020)的语言表示[纸]

- Colake:语境化语言和知识嵌入(Coling,2020)[纸]

- 开普勒:一个统一的知识嵌入和预训练语言表示模型(TACL,2021)[纸]

- K-Audapter:将知识注入具有适配器的预训练模型(ACL发现,2021)[纸]

- 可口可乐:上下文知识选择并嵌入增强的预训练的语言模型(AI Open,2021)[纸]

- Ernie 3.0:大规模知识增强了语言理解和产生的预训练(Arixv,2021)[纸]

- 具有确定性事实知识的培训前语言模型(EMNLP,2022)[纸]

- 卡拉:知识增强语言模型适应(NAACL,2022)[纸]

- DKPLM:自然语言理解的可分解知识增强的预训练的预训练的语言模型(AAAI,2022)[纸]

- dict-bert:用字典增强语言模型(ACL调查结果,2022)[纸]

- Jaket:知识图和语言理解的联合预培训(AAAI,2022)[纸]

- 电视知识预训练用于故障分析(ICDE,2023)[纸]

KG增强的LLM推论

- 巴拉克(Barack)的妻子希拉里(Hillary):将知识图用于事实感知语言建模(ACL,2019年)[纸]

- 用于知识密集型NLP任务的检索生成(Neurips,2020)[纸]

- 领域:检索语言模型预训练(ICML,2020)[纸]

- QA-GNN:用语言模型和知识图的推理,以回答问题(NAACL,2021)[纸]

- 记忆和知识增强语言模型,用于推断长期故事中的显着性(EMNLP,2021)[纸]

- 联合LK:与常识性问题的语言模型和知识图回答的联合推理(NAACL,2022)[纸]

- 通过基于动态文档的知识图(AAAI,2022)对大型语言模型的增强故事理解[纸]

- Greaselm:图形推理增强语言模型(ICLR,2022)[纸]

- 用于知识密集型NLP任务(EMNLP,2022)的有效内存功能增强的变压器[Paper]

- 知识增强的语言模型提示零拍的知识图答录(NLRSE@acl,2023)[纸]

- 在不断发展的环境中,基于LLM的多跳问题通过知识图集成(EMNLP发现,2024年)[纸]

KG增强的LLM可解释性

- 语言模型作为知识基础(EMNLP,2019年)[论文]

- Kagnet:常识性推理的知识感知图网络(Arxiv,2019)[纸]

- 自动启动:从具有自动生成的提示的语言模型中获取知识(EMNLP,2020)[纸]

- 我们怎么知道语言模型知道什么? (ACL,2020)[纸]

- 经过审慎的变压器的知识神经元(ACL,2021)[纸]

- 语言模型可以是生物医学知识库吗? (EMNLP,2021)[纸]

- 通过知识图提取(Arxiv,2021)来解释语言模型[纸]

- QA-GNN:用语言模型和知识图回答的推理(ACL,2021)[纸]

- 如何查询语言模型? (Arxiv,2021)[纸]

- 重新播放 - 探针:一种探测预训练语言模型生物医学知识的对比配方(Arxiv,2021)[纸]

- 当不信任语言模型时:调查参数和非参数记忆的有效性和局限性(Arxiv,2022)[纸]

- 预训练的语言模型如何捕获事实知识?因果启发的分析(Arxiv,2022)[纸]

- 知识图可以简化文本吗? (CIKM,2023)[纸]

llm-aigment kgs

llm-aigment kg嵌入

- 大型语言模型的嘈杂注释(Neurips,2024)[纸]的实体对齐

- Lambdakg:基于预训练的语言模型的知识图嵌入(Arxiv,2023)的库[Paper]

- 在超复杂空间(Arxiv,2022)中整合知识图嵌入和验证的语言模型[纸]

- 具有多模式知识图表(Arxiv,2022)的赋予语言模型[纸]

- 语言模型指导知识图嵌入(IEEE访问,2022)[纸]

- 语言模型作为知识嵌入(IJCAI,2022)[纸]

- 预算:从验证的语言模型(EMNLP,2020)中学习知识表示[纸]

- 开普勒:知识嵌入和预训练语言表示的统一模型(TACL,2020)[纸]

llm-aigment kg完成

- 具有大型语言模型(Coling 2024)[纸] [代码]的知识图完成的多角度改进

- kg-bert:知识图完成的伯特(Arxiv,2019年)[纸]

- 具有预训练的语言模型(Coling,2020)的知识图完成的多任务学习[纸]

- 预训练的模型是否有益于知识图的完成?可靠的评估和合理的方法(ACL,2022)[纸]

- 知识图完成的联合语言语义和结构嵌入(Coling,2022)[纸]

- MEM-KGC:具有预训练的语言模型(IEEE Access,2021)的知识图完成的蒙版实体模型[Paper]

- 通过统一学习方法(基于知识的Syst。,2023),具有预训练的语言模型的知识图扩展名[纸]

- 结构增强的文本表示为有效的知识图完成(www,2021)[纸]

- SIMKGC:使用预训练的语言模型(ACL,2022)[Paper]的简单对比知识图完成

- LP-bert:多任务预训练知识图BERT用于链接预测(Arxiv,2022)[纸]

- 从歧视到世代:知识图完成,具有生成变压器(www,2022)[纸]

- 序列到序列知识图的完成和问答(ACL,2022)[纸]

- 知识是平坦的:用于各种知识图完成的SEQ2SEQ生成框架(Coling,2022)[Paper]

- 将预先训练的语言模型调整为知识图完成的框架(EMNLP,2022)[纸]

- 浸入plms酱:通过有条件软提示完成的有效知识图完成的桥接结构和文本(ACL,2023)[纸]

llm aignited kg至文本一代

- Genwiki:一个无监督的图形到文本生成(Coling,2020)的130万个内容共享文本和图的数据集[纸

- KGPT:数据到文本生成(EMNLP 2020)的知识接收预培训[纸]

- 关节:从知识图(ACL调查结果,2021)[纸]

- 调查图表到文本生成的审慎语言模型(NLP4Convai,2021)[纸]

- 几乎没有验证的语言模型(ACL,2021)[Paper]

- EventNarrative:一个以事件为中心的大规模知识数据集(Neurips,2021)[Paper]

- 差距:知识图形到文本生成的图形知觉语言模型框架(Coling,2022)[纸]

llm-aigment kg问题回答

- UNIKGQA:统一的检索和推理,用于解决多跳的问题回答知识图(ICLR,2023)[纸]

- 结构争夺:大语言模型的一般框架,以推理结构化数据(Arxiv,2023)[纸]

- GPT-3的实证研究,用于基于知识的VQA(AAAI,2022)[纸]

- 简单知识图中的预训练语言模型的经验研究答案(世界网络杂志,2023年)[纸]

- 通过知识图赋予语言模型的开放域问题回答(EMNLP,2022)[纸]

- DRLK:具有语言模型和知识图的动态层次结构推理(EMNLP,2022)[纸]

- 多跳跃知识基础问题回答的子图检索增强模型(ACL,2022)[纸]

- Greaselm:图形推理增强的语言模型,以回答(ICLR,2022)[纸]

- Lako:知识驱动的视觉问题通过后期知识对文本注入回答(IJCKG,2022)[纸]

- QA-GNN:用语言模型和知识图的推理,以回答问题(NAACL,2021)[纸]

协同LLMS + kgs

知识表示

- 电视知识预训练用于故障分析(ICDE,2023)[纸]

- 将特定领域的异质知识纳入统一表示形式的训练前语言模型(适用于应用的专家系统,2023年)[纸]

- 深双向语言知识图(NIPS,2022)[纸]

- 开普勒:一个统一的知识嵌入和预训练语言表示模型(TACL,2021)[纸]

- 关节:从知识图(ACL 2021)[纸]

推理

- 用于增强域特异性NLP任务(Arxiv,2023)的统一知识增强服务[Paper]

- 复杂推理的统一结构推理和语言模型预训练(Arxiv,2023)[纸]

- 使用大语言模型(Arxiv,2023)[纸]对知识图上的复杂逻辑推理

申请

推荐系统

- 恢复:使用预审前的语言模型(Arxiv,2023)的统一框架[纸]

故障分析

- 电视知识预训练用于故障分析(ICDE,2023)[纸]