Génial-llm-kg

Une collection d'articles et de ressources sur l'unification des modèles de grande langue (LLM) et des graphiques de connaissances (KG).

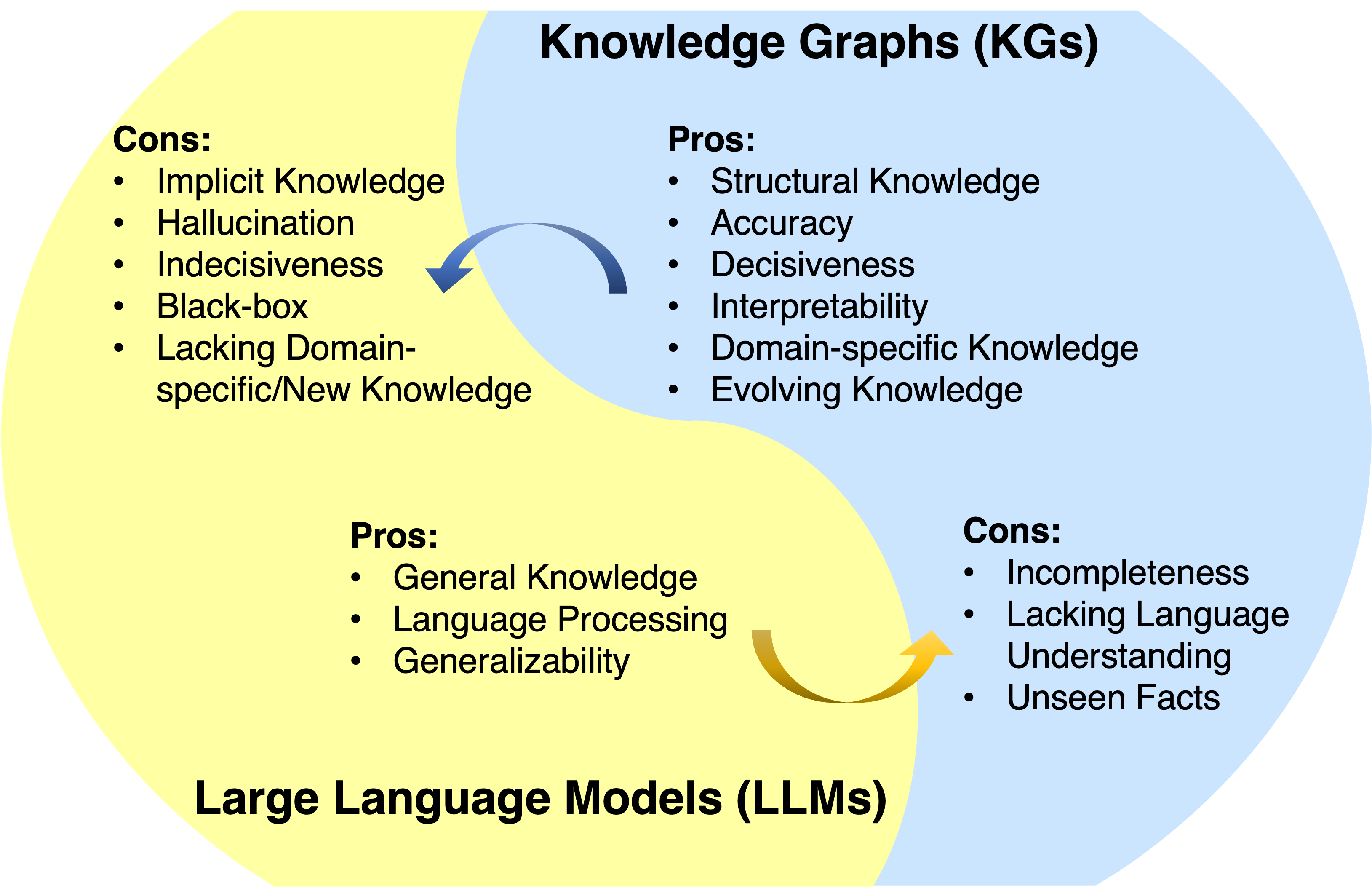

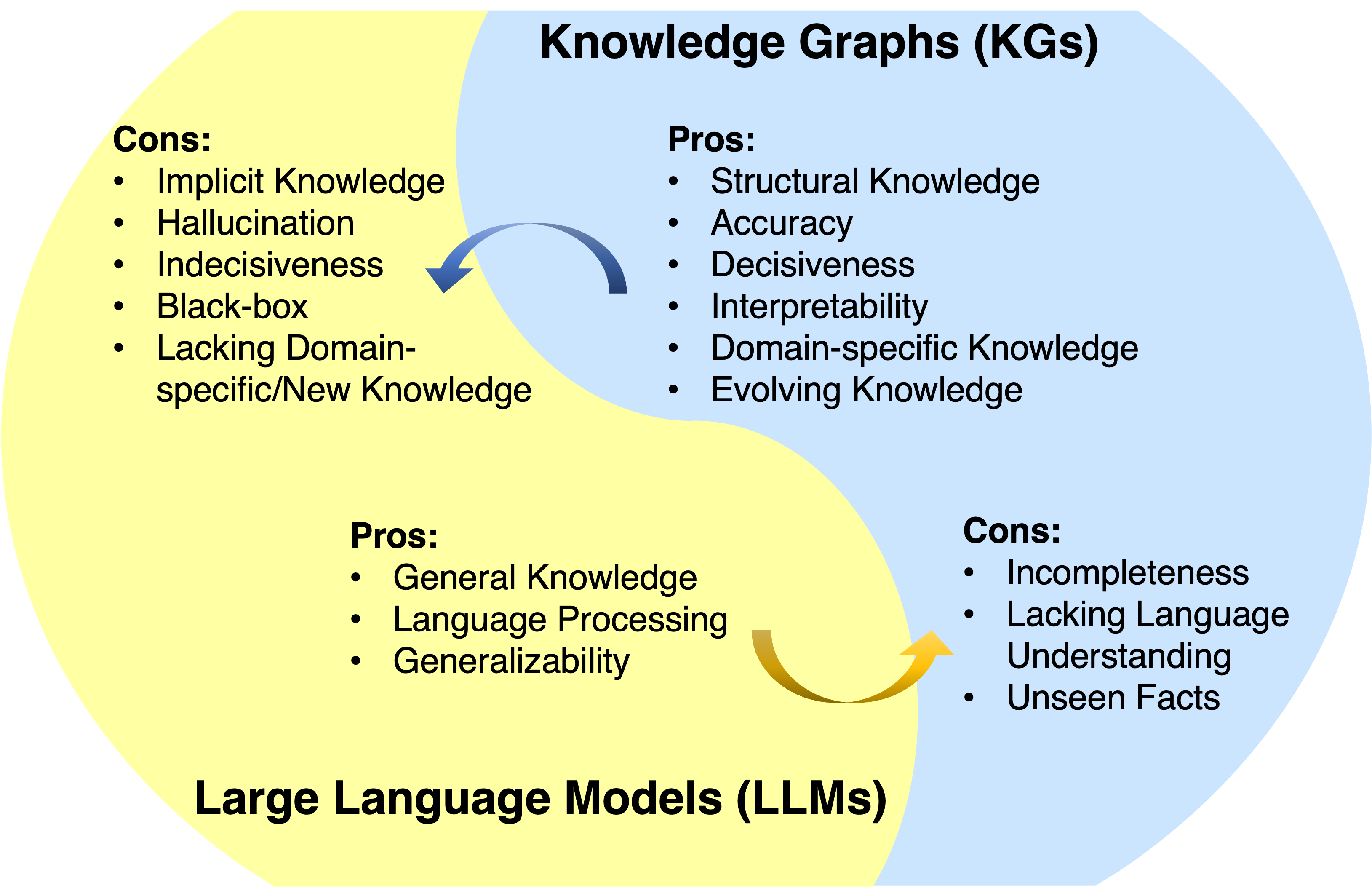

Les modèles de grandes langues (LLM) ont obtenu un succès et une généralisation remarquables dans diverses applications. Cependant, ils ne sont souvent pas en mesure de capturer et d'accès aux connaissances factuelles. Les graphiques de connaissances (KG) sont des modèles de données structurés qui stockent explicitement des connaissances factuelles riches. Néanmoins, les KG sont difficiles à construire et les méthodes existantes dans les KG sont inadéquates dans la gestion de la nature incomplète et en évolution dynamique des KG du monde réel. Par conséquent, il est naturel d'unifier les LLM et les KG ensemble et de tirer parti simultanément leurs avantages.

Nouvelles

? Ce projet est en cours de développement. Vous pouvez frapper l' étoile et regarder pour suivre les mises à jour.

- Nos derniers travaux sur KG + LLM Reosning sont maintenant publics: Raisonnement limité au graphique: Raisonnement fidèle sur les graphiques de connaissances avec de grands modèles de langue

- Notre LLM pour le travail de raisonnement KG temporel: des modèles de grande langue - l'adaptation dynamique guidée pour le raisonnement de graphe de connaissances temporelles a été acceptée par les Neirips 2024!

- Notre KG pour l'analyse du document de raisonnement LLM: l'évaluation directe de la chaîne de pensées dans le raisonnement multi-HOP avec des graphiques de connaissances a été acceptée par ACL 2024.

- Notre article de feuille de route a été accepté par TKDE.

- Notre document de sondage KG pour LLM: l'évaluation systématique des connaissances factuelles dans les modèles de gros langues a été acceptée par EMNLP 2023.

- Notre document de raisonnement KG + LLM: raisonnement sur les graphiques: le raisonnement de modèle de grande langue fidèle et interprétable a été accepté par ICLR 2024.

- Notre LLM pour KG Reasoning Paper: Chatrule: Mining Logical Rules avec des modèles de gros langage pour le raisonnement de graphique de connaissances est désormais public.

- Notre article de feuille de route: Unification des modèles de grande langue et des graphiques de connaissances: une feuille de route est maintenant publique.

Aperçu

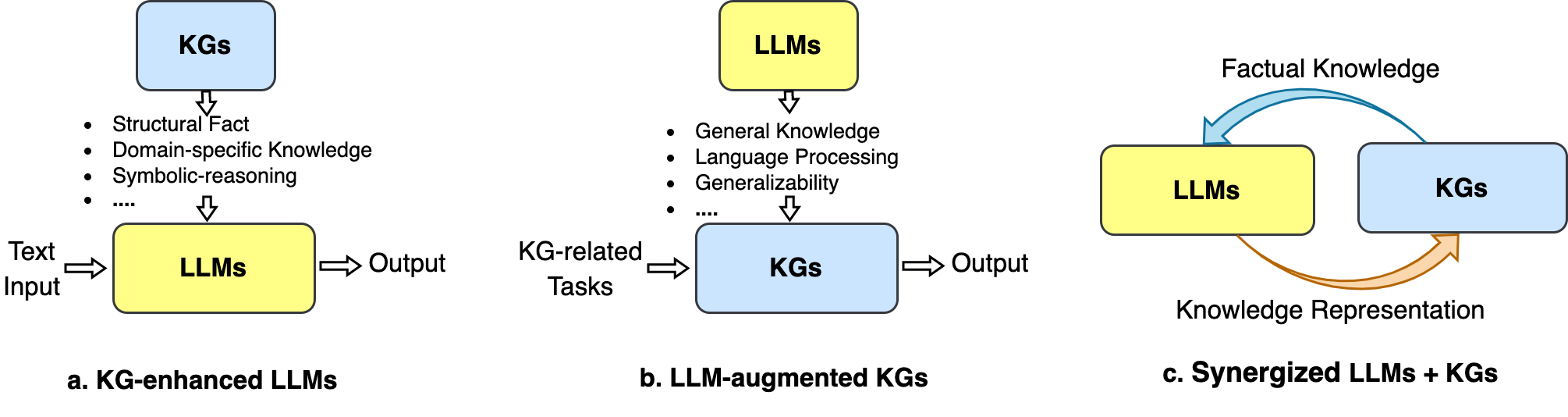

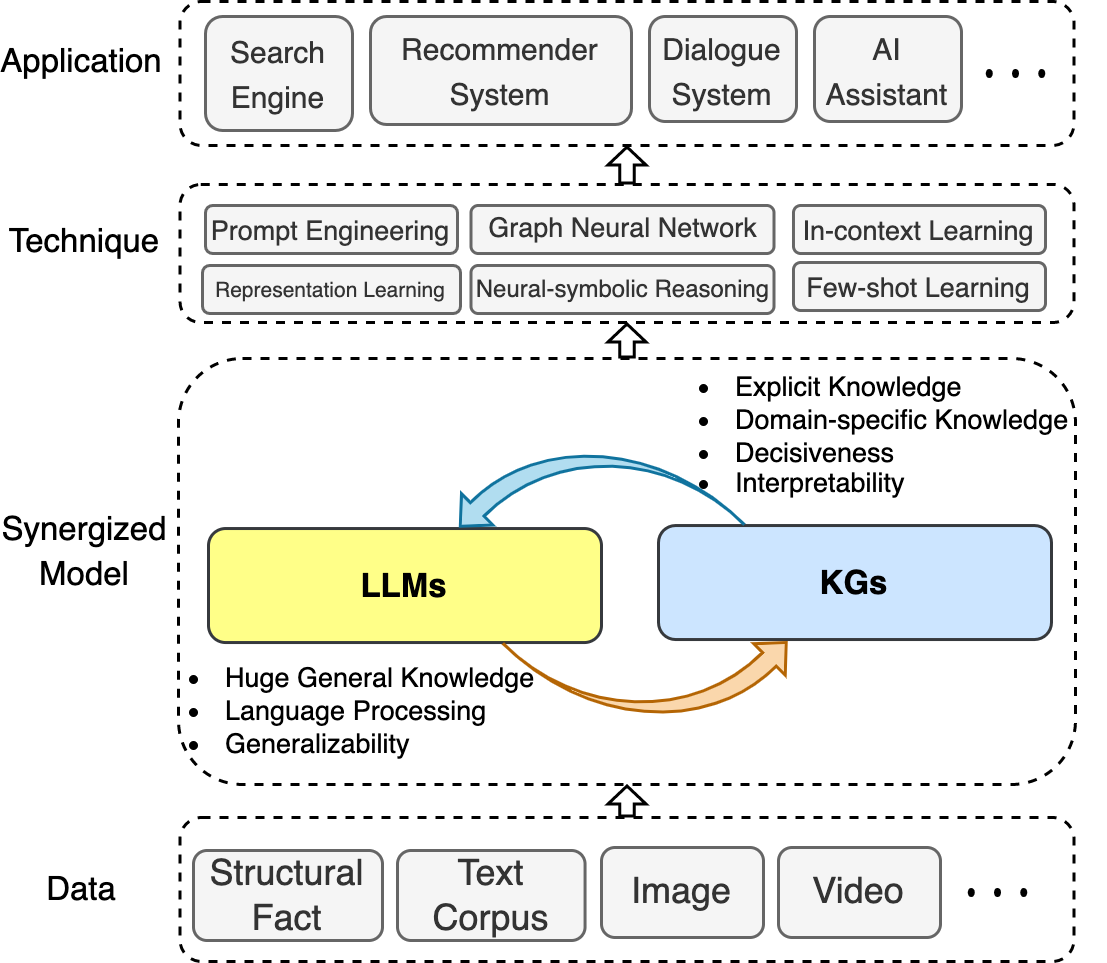

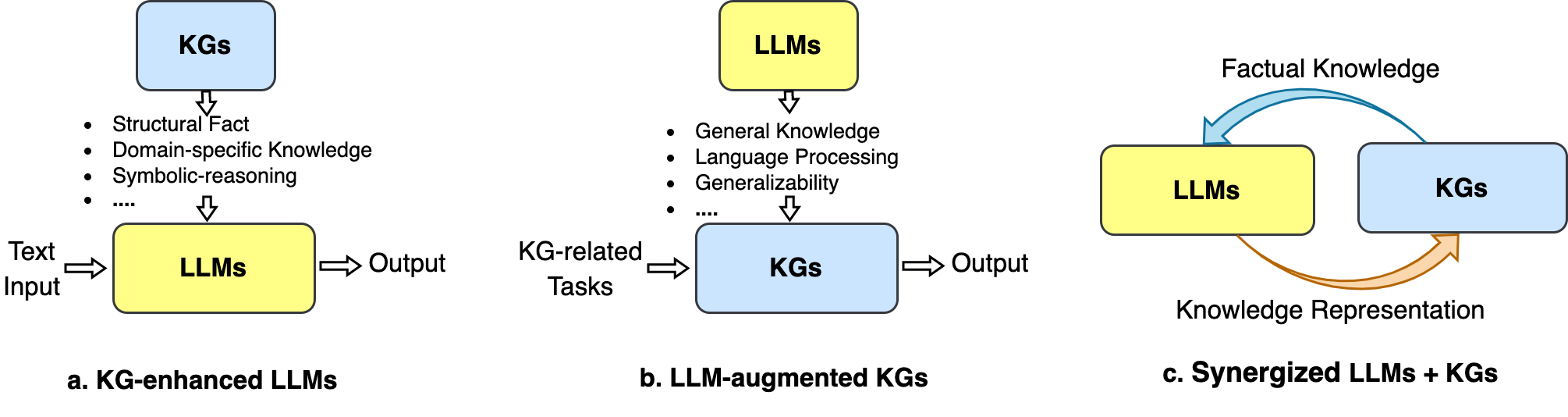

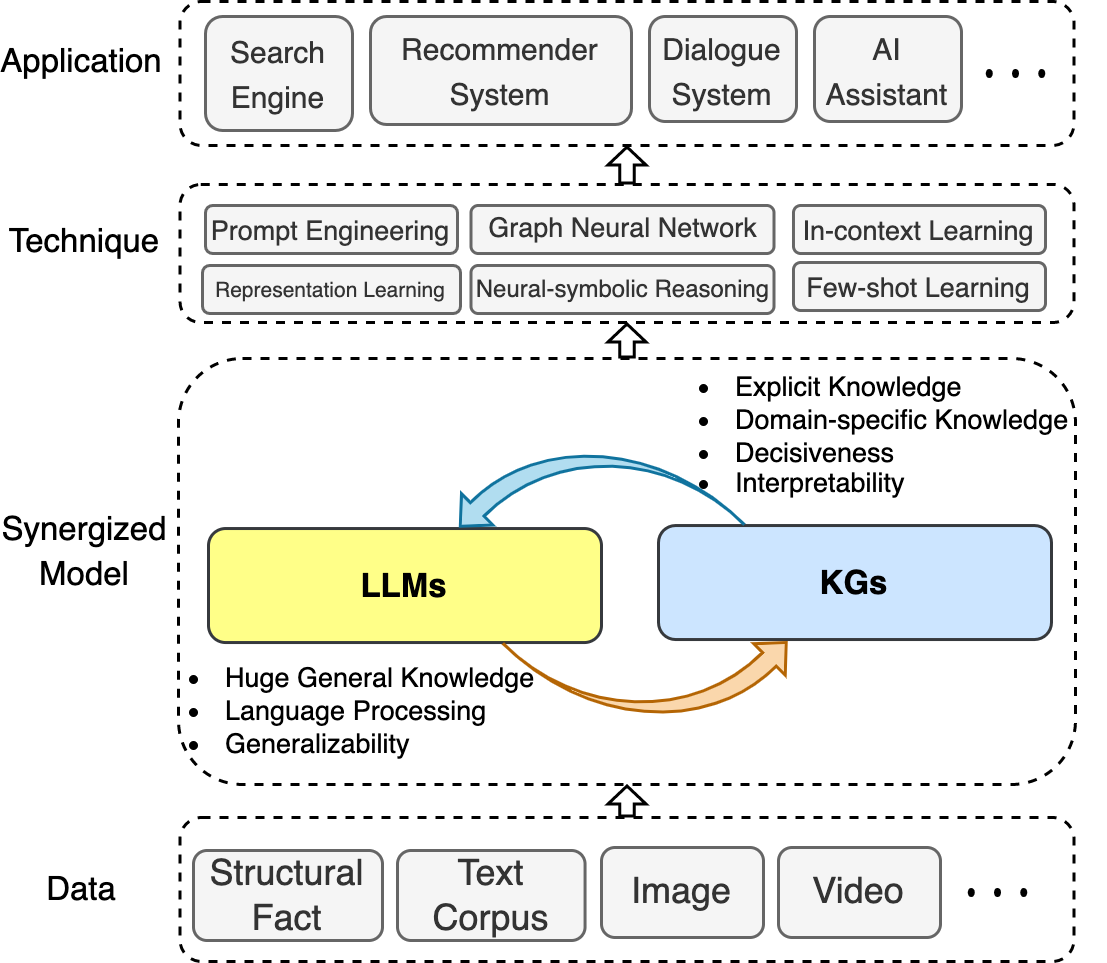

Dans ce référentiel, nous collectons des avancées récentes dans les LLM et KG unificateurs. Nous présentons une feuille de route qui résume trois cadres généraux: 1) LLMS améliorés par KG , 2) KGS de LLMS et 3) LLMS synergisés + KGS .

Nous illustrons également les techniques et applications impliquées.

Nous espérons que ce référentiel peut aider les chercheurs et les praticiens à mieux comprendre ce domaine émergent.

Si ce référentiel vous est utile, Plase nous aide en citant cet article:

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}Table des matières

- Génial-llm-kg

- Nouvelles

- Aperçu

- Table des matières

- Enquêtes connexes

- LLMS améliorés par KG

- Pré-formation LLM améliorée par KG

- Inférence LLM améliorée par KG

- Interprétabilité LLM améliorée par KG

- KGS LLM

- LLM-Augmentation KG intégration

- Achèvement KG LLM-Augmentation

- Génération KG-Text LLM-Augmentation

- LLM-Augmentation KG Question Répondre

- LLMS Synergisé + KGS

- Représentation des connaissances

- Raisonnement

- Applications

- Recommandation

- Analyse des défauts

Enquêtes connexes

- Unification des modèles et graphiques de connaissances unificateurs: une feuille de route (TKDE, 2024) [papier]

- Une enquête sur les modèles de langage pré-formation améliorés par les connaissances (Arxiv, 2023) [Papier]

- Une enquête sur la PNL à forte intensité de connaissances avec des modèles de langage pré-formées (Arxiv, 2022) [document]

- Une revue sur les modèles de langue comme bases de connaissances (Arxiv, 2022) [document]

- Construction de Generative Knowledge Graph: A Review (EMNLP, 2022) [Papier]

- Modèles de langage pré-trainés des connaissances: une enquête compressive (Arxiv, 2021) [document]

- Raisonnement sur différents types de graphiques de connaissances: statique, temporel et multimodal (Arxiv, 2022) [Paper] [Code]

LLMS améliorés par KG

Pré-formation LLM améliorée par KG

- Ernie: Représentation linguistique améliorée avec entités informatives (ACL, 2019) [document]

- Exploitation des connaissances structurées dans le texte via l'apprentissage de la représentation guidée par les graphiques (EMNLP, 2019) [Papier]

- SKEP: Connaissance des sentiments Amélioration de la pré-formation pour l'analyse des sentiments (ACL, 2020) [Papier]

- E-BERT: Une phrase et un modèle de langage amélioré de connaissances pour le commerce électronique (Arxiv, 2020) [Paper]

- Encyclopédie pré-étendue: Modèle de langage prétrainé aux connaissances faiblement supervisé (ICLR, 2020) [Papier]

- Bert-MK: intégrer les connaissances contextualisées du graphique dans les modèles de langage pré-formées (EMNLP, 2020) [papier]

- K-Bert: Permettre une représentation linguistique avec Graphique de connaissances (AAAI, 2020) [document]

- Colake: Langue contextualisée et connaissances sur l'intégration (Coling, 2020) [Papier]

- Kepler: un modèle unifié pour l'intégration des connaissances et la représentation du langage pré-formé (TACL, 2021) [Papier]

- K-adaptère: infuser les connaissances dans les modèles pré-formés avec des adaptateurs (résultats de la LCA, 2021) [papier]

- Cokebert: Sélection et intégration des connaissances contextuelles vers des modèles de langue pré-formés améliorés (AI Open, 2021) [Papier]

- Ernie 3.0: connaissances à grande échelle améliorées pré-formation pour la compréhension et la génération du langage (ARIXV, 2021) [Papier]

- Modèles de langue pré-formation avec des connaissances factuelles déterministes (EMNLP, 2022) [document]

- Kala: Adaptation du modèle de langage auprès de la connaissance (NAACL, 2022) [Papier]

- DKPLM: Modèle de langage pré-formé amélioré par les connaissances pour la compréhension du langage naturel (AAAI, 2022) [Papier]

- Dict-Bert: Amélioration du modèle de langue pré-formation avec dictionnaire (ACL Résultats, 2022) [Papier]

- JAKET: Pré-formation conjointe de la compréhension du graphique de connaissances et du langage (AAAI, 2022) [Papier]

- Pré-formation de télé-connaissances pour l'analyse des défauts (ICDE, 2023) [Papier]

Inférence LLM améliorée par KG

- L'épouse de Barack Hillary: Utilisation de graphiques de connaissances pour la modélisation du langage conscient des faits (ACL, 2019) [Paper]

- Génération auprès de la récupération pour les tâches NLP à forte intensité de connaissances (Neirips, 2020) [papier]

- REALM: Modèle de langage de la récupération pré-formation (ICML, 2020) [Papier]

- QA-GNN: Raisonnement avec des modèles de langue et des graphiques de connaissances pour la réponse aux questions (NAACL, 2021) [Papier]

- Mémoire et connaissance des modèles de langage augmenté pour déduire la saillance dans les histoires longues (EMNLP, 2021) [Paper]

- JOINTLK: Raisonnement conjoint avec des modèles de langue et des graphiques de connaissances pour la réponse aux questions de bon sens (NAACL, 2022) [Papier]

- Compréhension améliorée des histoires pour les modèles de grands langues grâce à des graphiques de connaissances dynamiques basés sur des documents (AAAI, 2022) [Papier]

- Greaselm: Modèles de langage améliorés du raisonnement graphique (ICLR, 2022) [Paper]

- Un transformateur auprès efficace de la mémoire pour les tâches NLP à forte intensité de connaissances (EMNLP, 2022) [papier]

- Modèle de langage auprès d'augmentation des connaissances pour répondre à la question de la question du graphique de connaissances (NLRSE @ ACL, 2023) [Paper]

- Question multi-HOP basée sur LLM Réponse avec l'intégration des graphiques de connaissances dans des environnements en évolution (EMNLP Résultats, 2024) [Paper]

Interprétabilité LLM améliorée par KG

- Modèles linguistiques comme bases de connaissances (EMNLP, 2019) [Papier]

- KAGNET: Réseaux de graphiques conscients des connaissances pour le raisonnement de bon sens (Arxiv, 2019) [Papier]

- AutoPrompt: provoquer des connaissances à partir de modèles de langage avec des invites générées automatiquement (EMNLP, 2020) [papier]

- Comment pouvons-nous savoir ce que les modèles de langue savent? (ACL, 2020) [papier]

- Neurones de connaissances dans les transformateurs pré-entraînés (ACL, 2021) [papier]

- Les modèles de langue peuvent-ils être des bases de connaissances biomédicales? (EMNLP, 2021) [papier]

- Interpréter les modèles de langage par l'extraction de graphiques de connaissances (Arxiv, 2021) [Papier]

- QA-GNN: Raisonnement avec des modèles de langage et des graphiques de connaissances pour la réponse aux questions (ACL, 2021) [Papier]

- Comment interroger les modèles de langage? (Arxiv, 2021) [Paper]

- Rewire-then-probe: une recette contrastive pour sonder la connaissance biomédicale des modèles de langage pré-formé (Arxiv, 2021) [Paper]

- Quand ne pas faire confiance aux modèles de langage: étudier l'efficacité et les limites des souvenirs paramétriques et non paramétriques (Arxiv, 2022) [Paper]

- Comment les modèles de langue pré-formés capturent les connaissances factuelles? Une analyse inspirée de la causalité (Arxiv, 2022) [papier]

- Les graphiques de connaissances peuvent-ils simplifier le texte? (CIKM, 2023) [papier]

KGS LLM

LLM-Augmentation KG intégration

- Alignement des entités avec des annotations bruyantes à partir de modèles de grands langues (Neirips, 2024) [papier]

- Lambdakg: Une bibliothèque pour les incorporations de connaissances de connaissances basées sur un modèle de langue pré-formées (Arxiv, 2023) [Papier]

- Intégration de modèles d'intégration de graphiques de connaissances et de langage pré-entraîné dans des espaces hypercomplexes (Arxiv, 2022) [papier]

- Dotant des modèles de langage avec des représentations de graphiques de connaissances multimodales (Arxiv, 2022) [papier]

- Modèle de langage Grapide Graphique Embeddings (IEEE Access, 2022) [Papier]

- Modèles linguistiques en tant qu'intégration de connaissances (IJCAI, 2022) [Papier]

- Pretrain-Kge: Représentation des connaissances à partir de modèles de langue pré-étendue (EMNLP, 2020) [Paper]

- Kepler: un modèle unifié pour l'intégration des connaissances et la représentation du langage pré-formé (TACL, 2020) [papier]

Achèvement KG LLM-Augmentation

- Amélioration multi-perspective de l'achèvement des graphiques de connaissances avec des modèles de gros langues (Coling 2024) [Papier] [Code]

- KG-BERT: Bert pour l'achèvement du graphique de connaissances (Arxiv, 2019) [Paper]

- Apprentissage multi-tâches pour l'achèvement des graphiques de connaissances avec des modèles de langue pré-formés (Coling, 2020) [Paper]

- Les modèles pré-formés bénéficient-ils à l'achèvement du graphique des connaissances? Une évaluation fiable et une approche raisonnable (ACL, 2022) [document]

- Langue conjointe sémantique et structure intégrée pour l'achèvement des graphiques de connaissances (Coling, 2022) [papier]

- MEM-KGC: Modèle d'entité masqué pour l'achèvement du graphique de connaissances avec modèle de langue pré-formé (IEEE Access, 2021) [Paper]

- Extension du graphique de connaissances avec un modèle de langue pré-formé via une méthode d'apprentissage unifié (Syst.

- Représentation de texte à usine de structure Apprentissage pour l'achèvement des graphiques de connaissances efficaces (www, 2021) [document]

- SIMKGC: Achèvement du graphique de connaissances contrastives simples avec les modèles de langage pré-formés (ACL, 2022) [Papier]

- LP-BERT: Graphique de connaissances pré-formation multi-tâches Bert pour la prédiction des liens (Arxiv, 2022) [Papier]

- De la discrimination à la génération: l'achèvement du graphique des connaissances avec un transformateur génératif (www, 2022) [papier]

- Réponction du graphique des connaissances de séquence à séquence et réponse aux questions (ACL, 2022) [Papier]

- La connaissance est plate: un cadre génératif SEQ2SEQ pour diverses connaissances de l'achèvement du graphique (Coling, 2022) [Paper]

- Un cadre pour adapter les modèles de langue pré-formés à l'achèvement des graphiques de connaissances (EMNLP, 2022) [papier]

- Trempage PLMS Sauce: Structure de pontage et texte pour l'achèvement des graphiques de connaissances efficaces via une invitation souple conditionnelle (ACL, 2023) [Paper]

Génération KG-Text LLM-Augmentation

- Genwiki: un ensemble de données de 1,3 million de texte de partage de contenu et de graphiques pour la génération de graphes à texte non supervisée (Coling, 2020) [Paper]

- KGPT: Pré-formation de connaissances sur la génération de données sur le texte (EMNLP 2020) [Papier]

- JointGT: Graph-Text Repreing Learning for Text Generation à partir de Graphiques de connaissances (ACL Résultats, 2021) [Papier]

- Enquêter sur les modèles de langage pré-entraîné pour la génération graphique à texte (NLP4Convai, 2021) [Papier]

- Génération de graphes de connaissances à quelques coups avec des modèles de langage prétrainés (ACL, 2021) [Papier]

- EventNarrative: un ensemble de données centré sur l'événement à grande échelle pour la génération de graphes de connaissances sur les connaissances (Neirips, 2021) [Paper]

- GAP: un cadre de modèle de langue conscient de graphiques pour la génération de graphes à texte de connaissance (Coling, 2022) [Paper]

LLM-Augmentation KG Question Répondre

- UNIKGQA: Retrievale unifiée et raisonnement pour résoudre les questions multi-HOP répondant sur le graphique de connaissances (ICLR, 2023) [Paper]

- STRUCTGPT: Un cadre général pour le modèle de grande langue à raisonner sur les données structurées (Arxiv, 2023) [Paper]

- Une étude empirique de GPT-3 pour le VQA basé sur les connaissances à quelques coups (AAAI, 2022) [Papier]

- Une étude empirique des modèles de langage pré-formé dans la réponse aux graphiques de connaissances simples (World Wide Web Journal, 2023) [Paper]

- Autonomiser les modèles de langue avec le raisonnement de graphe de connaissances pour la réponse aux questions du domaine ouvert (EMNLP, 2022) [Paper]

- DRLK: raisonnement hiérarchique dynamique avec modèle de langue et graphique de connaissances pour la réponse aux questions (EMNLP, 2022) [Paper]

- Modèle amélioré de récupération de la sous-graphique pour la réponse à la question de la base de connaissances multi-HOP (ACL, 2022) [Papier]

- Greaselm: Modèles de langage améliorés du raisonnement graphique pour la réponse aux questions (ICLR, 2022) [Papier]

- Lako: Question visuelle axée sur les connaissances Répondre via une injection de connaissances tardive-texte (IJCKG, 2022) [Papier]

- QA-GNN: Raisonnement avec des modèles de langue et des graphiques de connaissances pour la réponse aux questions (NAACL, 2021) [Papier]

LLMS Synergisé + KGS

Représentation des connaissances

- Pré-formation de télé-connaissances pour l'analyse des défauts (ICDE, 2023) [Papier]

- Modèle de langue pré-formation incorporant des connaissances hétérogènes spécifiques au domaine dans une représentation unifiée (Experts Systems with Applications, 2023) [Papier]

- Bidirectionnel de la connaissance du langage bidirectionnel Pret Trecaining (NIPS, 2022) [Paper]

- Kepler: un modèle unifié pour l'intégration des connaissances et la représentation du langage pré-formé (TACL, 2021) [Papier]

- JOINTGT: Texte de text graphique Apprentissage de la génération de texte à partir des graphiques de connaissances (ACL 2021) [Papier]

Raisonnement

- Un service d'augmentation de graphe de connaissances unifiés pour augmenter les tâches NLP spécifiques au domaine (Arxiv, 2023) [papier]

- Raisonnement de la structure unificatrice et modèle de modèle de langue pour le raisonnement complexe (Arxiv, 2023) [papier]

- Raisonnement logique complexe sur les graphiques de connaissances utilisant de grands modèles de langage (ArXIV, 2023) [papier]

Applications

Système de recommandation

- RÉCINDIAL: Un cadre unifié pour la recommandation conversationnelle avec des modèles de langage pré-entraîné (Arxiv, 2023) [Paper]

Analyse des défauts

- Pré-formation de télé-connaissances pour l'analyse des défauts (ICDE, 2023) [Papier]