Awesome-llm-kg

คอลเลกชันของเอกสารและทรัพยากรเกี่ยวกับการรวมโมเดลภาษาขนาดใหญ่ (LLMs) และกราฟความรู้ (KGS)

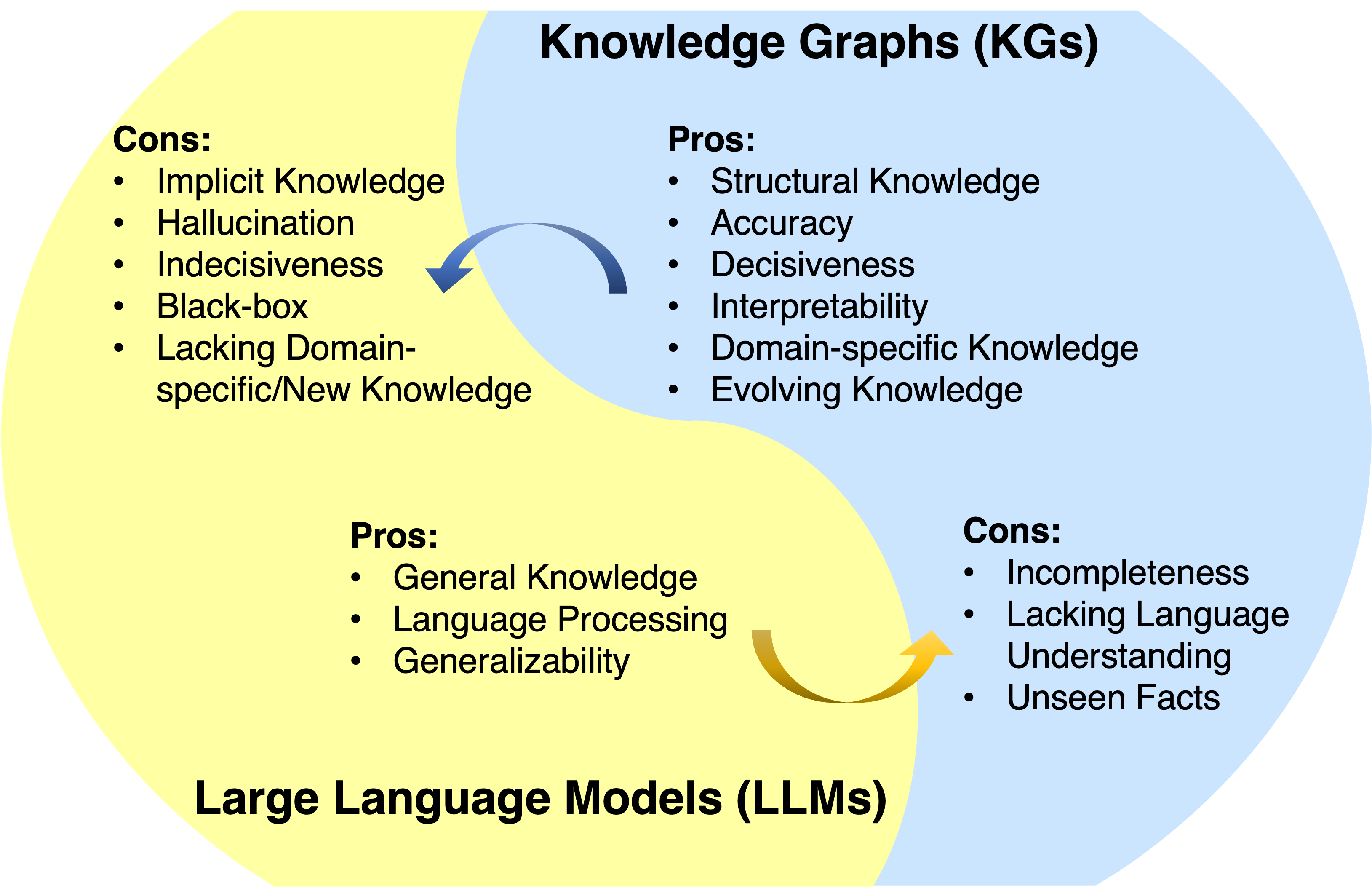

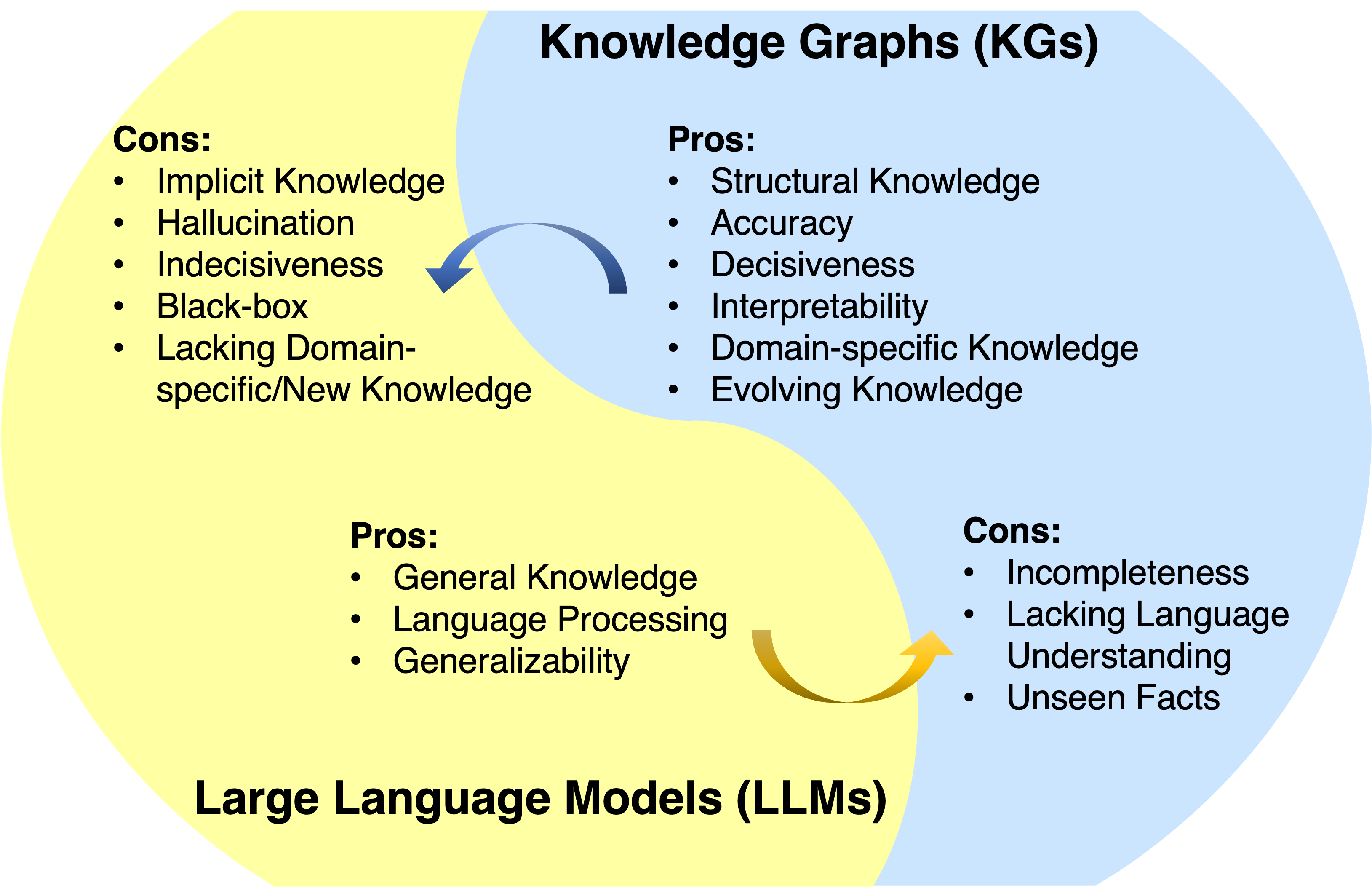

โมเดลภาษาขนาดใหญ่ (LLMS) ประสบความสำเร็จอย่างน่าทึ่งและความสามารถทั่วไปในการใช้งานต่างๆ อย่างไรก็ตามพวกเขามักจะขาดการจับและเข้าถึงความรู้จริง กราฟความรู้ (KGS) เป็นแบบจำลองข้อมูลที่มีโครงสร้างซึ่งจัดเก็บความรู้ที่เป็นข้อเท็จจริงที่หลากหลายอย่างชัดเจน อย่างไรก็ตาม KGs นั้นยากที่จะสร้างและวิธีการที่มีอยู่ใน Kgs นั้นไม่เพียงพอในการจัดการธรรมชาติที่ไม่สมบูรณ์และเปลี่ยนแปลงแบบไดนามิกของ Kgs ในโลกแห่งความเป็นจริง ดังนั้นจึงเป็นเรื่องธรรมดาที่จะรวม LLM และ KGs เข้าด้วยกันและใช้ประโยชน์จากข้อดีของพวกเขาพร้อมกัน

ข่าว

- โครงการนี้อยู่ระหว่างการพัฒนา คุณสามารถตี ดาว และ ดู เพื่อติดตามการอัปเดต

- งานล่าสุดของเราเกี่ยวกับ KG + LLM reaosning ตอนนี้เป็นสาธารณะ: การใช้เหตุผลที่ จำกัด กราฟ: การใช้เหตุผลอย่างซื่อสัตย์เกี่ยวกับกราฟความรู้ด้วยรูปแบบภาษาขนาดใหญ่

- LLM ของเราสำหรับงานการใช้เหตุผล KG ชั่วคราว: การปรับแบบไดนามิกแบบจำลองภาษาขนาดใหญ่สำหรับการใช้เหตุผลกราฟความรู้ทางโลกได้รับการยอมรับจาก Neurips 2024!

- KG ของเราสำหรับการวิเคราะห์กระดาษให้เหตุผล LLM: การประเมินโดยตรงของห่วงโซ่ของความคิดในการให้เหตุผลหลายครั้งด้วยกราฟความรู้ได้รับการยอมรับโดย ACL 2024

- กระดาษแผนงานของเราได้รับการยอมรับจาก TKDE

- KG สำหรับการตรวจสอบ LLM ของเรา: การประเมินอย่างเป็นระบบของความรู้ที่เป็นข้อเท็จจริงในแบบจำลองภาษาขนาดใหญ่ได้รับการยอมรับโดย EMNLP 2023

- เอกสารการใช้เหตุผล KG + LLM ของเรา: การใช้เหตุผลบนกราฟ: การให้เหตุผลแบบจำลองภาษาขนาดใหญ่ที่ซื่อสัตย์และตีความได้นั้นได้รับการยอมรับจาก ICLR 2024

- LLM ของเราสำหรับ KG ให้เหตุผลกระดาษ: chatrule: การขุดกฎเชิงตรรกะที่มีแบบจำลองภาษาขนาดใหญ่สำหรับการใช้เหตุผลกราฟความรู้เป็นสาธารณะ

- กระดาษแผนงานของเรา: การรวมโมเดลภาษาขนาดใหญ่และกราฟความรู้: แผนงานเป็นสาธารณะ

ภาพรวม

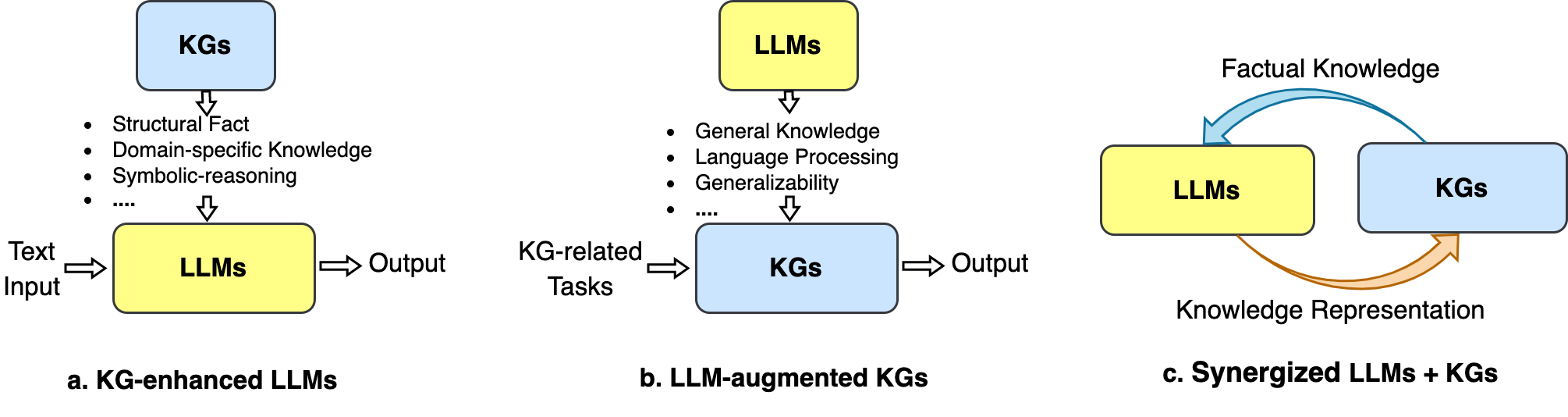

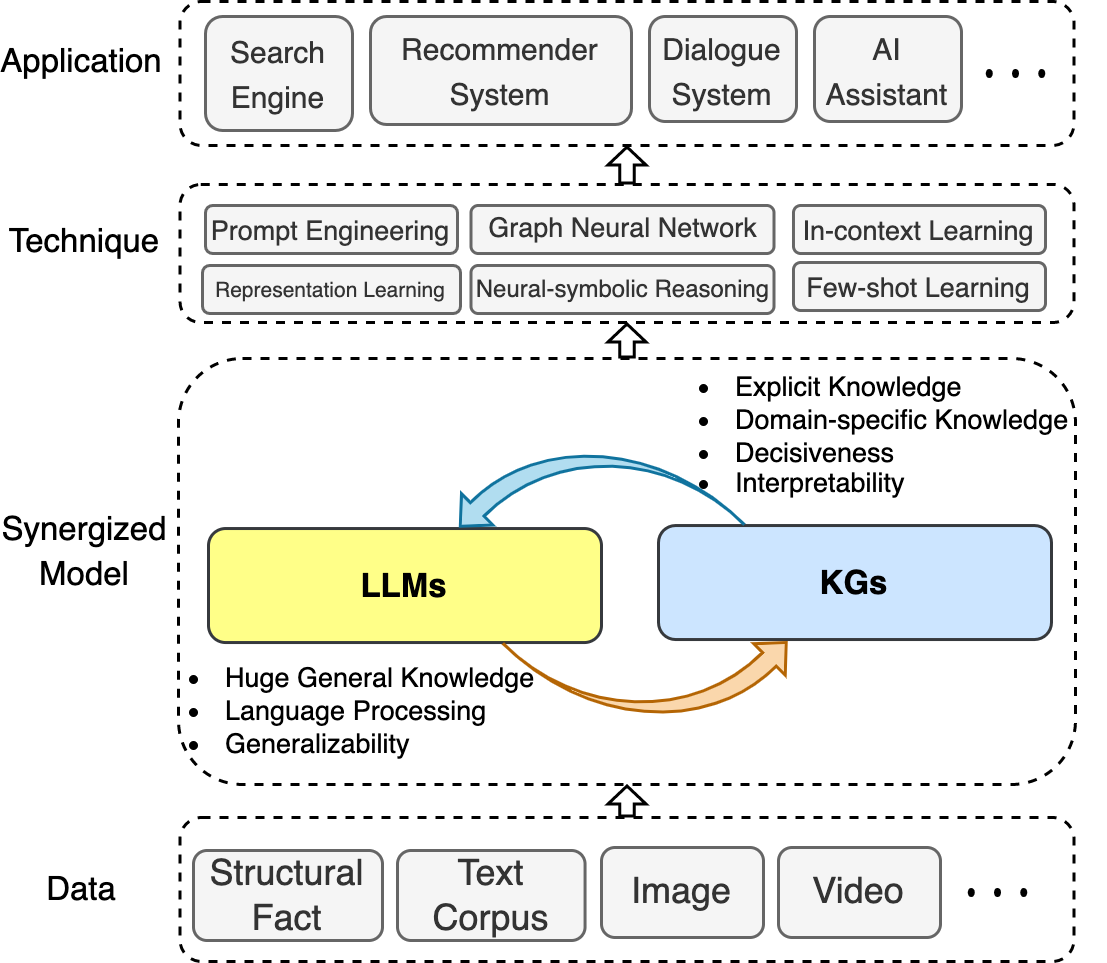

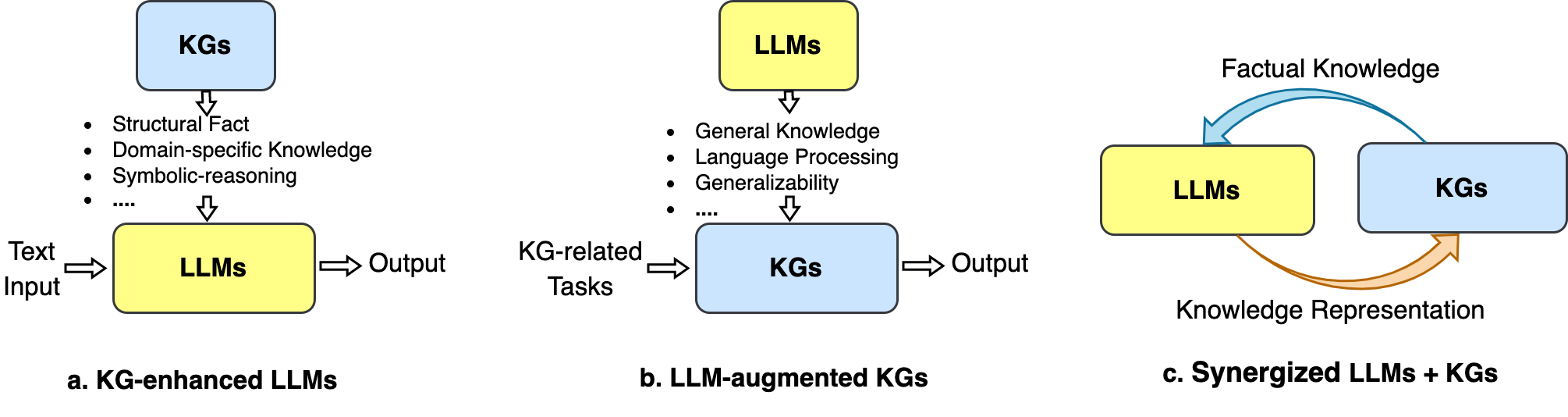

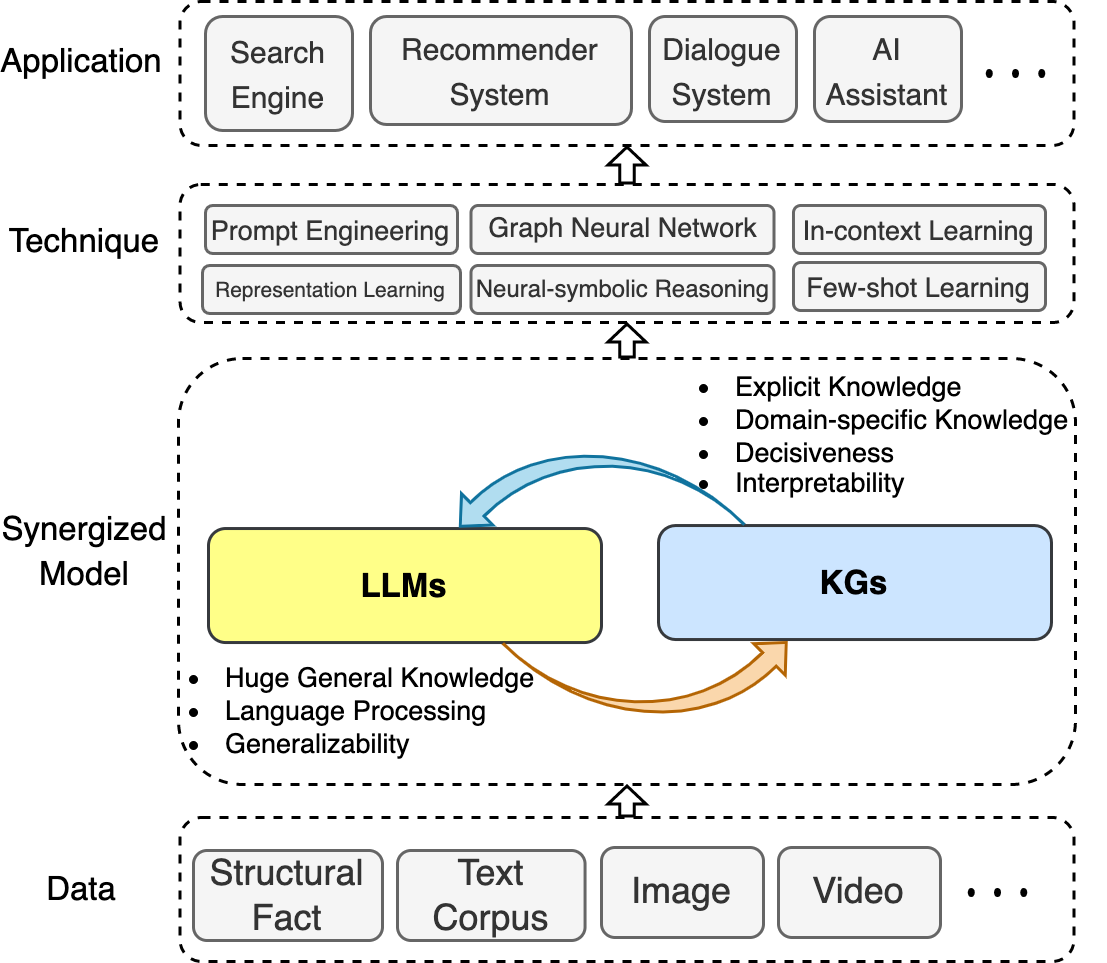

ในที่เก็บนี้เรารวบรวมความก้าวหน้าล่าสุดในการรวม LLM และ KGS เรานำเสนอแผนงานที่สรุปสามเฟรมเวิร์กทั่วไป: 1) LLMS ที่เพิ่มขึ้น Kg , 2) LLMS-Augmented Kgs และ 3) Synergized LLMS + kgs

นอกจากนี้เรายังแสดงให้เห็นถึงเทคนิคและแอปพลิเคชันที่เกี่ยวข้อง

เราหวังว่าพื้นที่เก็บข้อมูลนี้จะช่วยให้นักวิจัยและผู้ปฏิบัติงานได้รับความเข้าใจที่ดีขึ้นเกี่ยวกับสาขาที่เกิดขึ้นใหม่นี้

หากที่เก็บนี้มีประโยชน์สำหรับคุณ PLASE ช่วยเราโดยอ้างถึงบทความนี้:

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}สารบัญ

- Awesome-llm-kg

- ข่าว

- ภาพรวม

- สารบัญ

- แบบสำรวจที่เกี่ยวข้อง

- Kg-enhanced LLMS

- การฝึกอบรม Pre-training KG เพิ่มขึ้น

- การอนุมาน LLM ที่เพิ่มขึ้น KG

- ความสามารถในการตีความ LLM ที่เพิ่มขึ้น KG

- LLM-Augmented Kgs

- LLM-Augmented Kg Embedding

- LLM-Augmented Kg เสร็จสมบูรณ์

- LLM-Augmented KG-text Text

- LLM-Augmented KG ตอบคำถาม

- Synergized LLMS + kgs

- การเป็นตัวแทนความรู้

- การให้เหตุผล

- แอปพลิเคชัน

- คำแนะนำ

- การวิเคราะห์ข้อผิดพลาด

แบบสำรวจที่เกี่ยวข้อง

- การรวมรูปแบบภาษาขนาดใหญ่และกราฟความรู้: แผนงาน (TKDE, 2024) [กระดาษ]

- การสำรวจโมเดลภาษาที่ได้รับการฝึกอบรมล่วงหน้าที่ได้รับการปรับปรุงความรู้ (Arxiv, 2023) [กระดาษ]

- การสำรวจ NLP ที่ใช้ความรู้มากด้วยแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (Arxiv, 2022) [กระดาษ]

- บทวิจารณ์เกี่ยวกับแบบจำลองภาษาเป็นฐานความรู้ (Arxiv, 2022) [กระดาษ]

- การสร้างกราฟความรู้ทั่วไป: การทบทวน (EMNLP, 2022) [กระดาษ]

- ความรู้ที่เพิ่มขึ้นแบบจำลองภาษาที่ผ่านการฝึกฝน: การสำรวจแบบรวม (Arxiv, 2021) [กระดาษ]

- การให้เหตุผลกับกราฟความรู้ประเภทต่าง ๆ : แบบคงที่ชั่วคราวและหลายรูปแบบ (arxiv, 2022) [กระดาษ] [รหัส]

Kg-enhanced LLMS

การฝึกอบรม Pre-training KG เพิ่มขึ้น

- Ernie: การเป็นตัวแทนภาษาที่ได้รับการปรับปรุงด้วยหน่วยงานที่ให้ข้อมูล (ACL, 2019) [กระดาษ]

- การใช้ประโยชน์จากความรู้ที่มีโครงสร้างในข้อความผ่านการเรียนรู้การเป็นตัวแทนกราฟ (EMNLP, 2019) [กระดาษ]

- SKEP: ความรู้ความเข้าใจที่เพิ่มขึ้นก่อนการฝึกอบรมสำหรับการวิเคราะห์ความเชื่อมั่น (ACL, 2020) [กระดาษ]

- E-Bert: วลีและความรู้เกี่ยวกับผลิตภัณฑ์ที่ปรับปรุงรูปแบบภาษาสำหรับอีคอมเมิร์ซ (Arxiv, 2020) [กระดาษ]

- สารานุกรมที่ได้รับการฝึกฝนมาก่อน: แบบจำลองภาษาที่มีความรู้ที่ผ่านการควบคุมอย่างอ่อนระบบ (ICLR, 2020) [กระดาษ]

- Bert-MK: การรวมความรู้เชิงบริบทของกราฟเข้ากับแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (EMNLP, 2020) [กระดาษ]

- K-Bert: เปิดใช้งานการเป็นตัวแทนภาษาด้วยกราฟความรู้ (Aaai, 2020) [Paper]

- โคลค: การฝังภาษาและความรู้เชิงบริบท (Coling, 2020) [Paper]

- Kepler: แบบครบวงจรสำหรับการฝังความรู้และการเป็นตัวแทนภาษาที่ผ่านการฝึกอบรมมาก่อน (TaCl, 2021) [กระดาษ]

- K-Adapter: ผสมผสานความรู้เข้ากับโมเดลที่ผ่านการฝึกอบรมมาก่อนด้วยอะแดปเตอร์ (ผลการวิจัย ACL, 2021) [กระดาษ]

- COKEBERT: การเลือกความรู้ตามบริบทและการฝังสู่แบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (AI Open, 2021) [กระดาษ]

- Ernie 3.0: ความรู้ขนาดใหญ่เพิ่มการฝึกอบรมล่วงหน้าสำหรับการทำความเข้าใจภาษาและการสร้าง (Arixv, 2021) [กระดาษ]

- แบบจำลองภาษาก่อนการฝึกอบรมที่มีความรู้จริงที่กำหนด (EMNLP, 2022) [กระดาษ]

- Kala: การปรับรูปแบบภาษาที่มีความรู้ (NAACL, 2022) [กระดาษ]

- DKPLM: แบบจำลองภาษาที่ได้รับการฝึกอบรมก่อนความรู้ที่ได้รับการฝึกอบรมสำหรับความรู้ด้านภาษาธรรมชาติ (AAAI, 2022) [กระดาษ]

- DICT-BERT: การปรับปรุงรูปแบบภาษาก่อนการฝึกอบรมด้วยพจนานุกรม (ผลการวิจัย ACL, 2022) [กระดาษ]

- JAKET: การฝึกอบรมกราฟความรู้และความเข้าใจภาษาก่อน (AAAI, 2022) [กระดาษ]

- Tele-Knowledge Pre-Training สำหรับการวิเคราะห์ความผิด (ICDE, 2023) [Paper]

การอนุมาน LLM ที่เพิ่มขึ้น KG

- ฮิลลารีภรรยาของบารัค: การใช้กราฟความรู้สำหรับการสร้างแบบจำลองภาษาที่รับรู้จริง (ACL, 2019) [กระดาษ]

- การค้นคืนแบบสืบค้นสำหรับงาน NLP ที่ใช้ความรู้มาก (Neurips, 2020) [Paper]

- Realm: รูปแบบภาษาที่เรียกคืนก่อนการฝึกอบรมก่อน (ICML, 2020) [กระดาษ]

- QA-GNN: การให้เหตุผลกับแบบจำลองภาษาและกราฟความรู้สำหรับการตอบคำถาม (NAACL, 2021) [กระดาษ]

- ความทรงจำและความรู้แบบจำลองภาษาที่เพิ่มขึ้นสำหรับการอนุมานในเรื่องยาว (EMNLP, 2021) [กระดาษ]

- Jointlk: การใช้เหตุผลร่วมกับแบบจำลองภาษาและกราฟความรู้สำหรับการตอบคำถามแบบทั่วไป (NAACL, 2022) [กระดาษ]

- ความเข้าใจในเรื่องราวที่ได้รับการปรับปรุงสำหรับแบบจำลองภาษาขนาดใหญ่ผ่านกราฟความรู้ที่ใช้เอกสารแบบไดนามิก (AAAI, 2022) [กระดาษ]

- Greaselm: กราฟการใช้เหตุผลแบบจำลองภาษาที่ปรับปรุงแล้ว (ICLR, 2022) [กระดาษ]

- หม้อแปลงหน่วยความจำที่มีประสิทธิภาพสำหรับงาน NLP ที่ใช้ความรู้มาก (EMNLP, 2022) [กระดาษ]

- แบบจำลองภาษาที่มีความรู้ที่กระตุ้นการตอบสนองต่อการตอบคำถามกราฟความรู้แบบไม่ติด-ช็อต (NLRSE@ACL, 2023) [กระดาษ]

- การตอบคำถามแบบมัลติฮอปแบบอิง LLM กับการรวมกราฟความรู้ในสภาพแวดล้อมที่กำลังพัฒนา (การค้นพบ EMNLP, 2024) [กระดาษ]

ความสามารถในการตีความ LLM ที่เพิ่มขึ้น KG

- แบบจำลองภาษาเป็นฐานความรู้ (Emnlp, 2019) [กระดาษ]

- KAGNET: เครือข่ายกราฟที่รับรู้เกี่ยวกับความรู้เพื่อการใช้เหตุผลแบบทั่วไป (Arxiv, 2019) [กระดาษ]

- Autoprompt: ความรู้ที่ทำให้เกิดความรู้จากแบบจำลองภาษาที่มีพรอมต์ที่สร้างขึ้นโดยอัตโนมัติ (EMNLP, 2020) [กระดาษ]

- เราจะรู้ได้อย่างไรว่ารูปแบบภาษาใดรู้ (ACL, 2020) [กระดาษ]

- เซลล์ประสาทความรู้ในหม้อแปลงหม้อแปลง (ACL, 2021) [กระดาษ]

- แบบจำลองภาษาสามารถเป็นฐานความรู้ด้านชีวการแพทย์ได้หรือไม่? (Emnlp, 2021) [กระดาษ]

- การตีความแบบจำลองภาษาผ่านการสกัดกราฟความรู้ (Arxiv, 2021) [กระดาษ]

- QA-GNN: การให้เหตุผลกับแบบจำลองภาษาและกราฟความรู้สำหรับการตอบคำถาม (ACL, 2021) [กระดาษ]

- วิธีการสอบถามรูปแบบภาษา? (Arxiv, 2021) [กระดาษ]

- rewire-then-probe: สูตรความแตกต่างสำหรับการตรวจสอบความรู้ด้านชีวการแพทย์ของแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (arxiv, 2021) [กระดาษ]

- เมื่อไม่ไว้วางใจแบบจำลองภาษา: การตรวจสอบประสิทธิภาพและข้อ จำกัด ของความทรงจำแบบพารามิเตอร์และไม่ใช่พารามิเตอร์ (Arxiv, 2022) [กระดาษ]

- แบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อนจับความรู้ที่เป็นข้อเท็จจริงอย่างไร การวิเคราะห์ที่ได้แรงบันดาลใจจากสาเหตุ (Arxiv, 2022) [กระดาษ]

- กราฟความรู้สามารถทำให้ข้อความง่ายขึ้นหรือไม่? (CIKM, 2023) [กระดาษ]

LLM-Augmented Kgs

LLM-Augmented Kg Embedding

- การจัดตำแหน่งเอนทิตีกับคำอธิบายประกอบที่มีเสียงดังจากแบบจำลองภาษาขนาดใหญ่ (Neurips, 2024) [กระดาษ]

- LAMBDAKG: ห้องสมุดสำหรับการฝังกราฟความรู้ตามรูปแบบภาษาที่ผ่านการฝึกอบรมมาก่อน (Arxiv, 2023) [กระดาษ]

- บูรณาการการฝังกราฟความรู้และแบบจำลองภาษาที่ผ่านการฝึกฝนในช่องว่างไฮเปอร์คอมเพล็กซ์ (Arxiv, 2022) [กระดาษ]

- แบบจำลองภาษาที่มีการแสดงกราฟความรู้หลายรูปแบบ (Arxiv, 2022) [กระดาษ]

- รูปแบบภาษาที่มีคำแนะนำกราฟความรู้กราฟ (การเข้าถึง IEEE, 2022) [กระดาษ]

- แบบจำลองภาษาเป็นฝังความรู้ (ijcai, 2022) [กระดาษ]

- pretrain-kge: การเรียนรู้การเป็นตัวแทนจากแบบจำลองภาษาที่ผ่านการฝึกฝน (EMNLP, 2020) [กระดาษ]

- Kepler: แบบครบวงจรสำหรับการฝังความรู้และการเป็นตัวแทนภาษาที่ผ่านการฝึกอบรมมาก่อน (TaCl, 2020) [กระดาษ]

LLM-Augmented Kg เสร็จสมบูรณ์

- การปรับปรุงกราฟความรู้หลายภาพด้วยแบบจำลองภาษาขนาดใหญ่ (Coling 2024) [กระดาษ] [รหัส]

- KG-BERT: Bert for Knowledge กราฟเสร็จสมบูรณ์ (Arxiv, 2019) [Paper]

- การเรียนรู้แบบหลายงานสำหรับการทำให้กราฟความรู้เสร็จสมบูรณ์ด้วยแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (Coling, 2020) [กระดาษ]

- โมเดลที่ผ่านการฝึกอบรมมาก่อนจะเป็นประโยชน์ต่อกราฟความรู้ที่สมบูรณ์หรือไม่? การประเมินที่เชื่อถือได้และวิธีการที่สมเหตุสมผล (ACL, 2022) [กระดาษ]

- ความหมายภาษาร่วมและโครงสร้างการฝังกราฟความรู้ให้เสร็จสมบูรณ์ (Coling, 2022) [กระดาษ]

- MEM-KGC: โมเดลเอนทิตีที่สวมหน้ากากสำหรับการทำให้กราฟความรู้เสร็จสมบูรณ์ด้วยรูปแบบภาษาที่ผ่านการฝึกอบรมมาก่อน (การเข้าถึง IEEE, 2021) [กระดาษ]

- การขยายกราฟความรู้ด้วยรูปแบบภาษาที่ผ่านการฝึกอบรมมาก่อนผ่านวิธีการเรียนรู้แบบครบวงจร (Knowl. Syst., 2023) [กระดาษ]

- การเรียนรู้การเป็นตัวแทนข้อความโครงสร้างการเรียนรู้เพื่อการสร้างกราฟความรู้ที่มีประสิทธิภาพ (www, 2021) [กระดาษ]

- SIMKGC: กราฟความรู้ที่แตกต่างอย่างง่ายด้วยแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (ACL, 2022) [กระดาษ]

- LP-BERT: กราฟการฝึกอบรมก่อนการฝึกอบรมหลายงานเบิร์ตสำหรับการทำนายลิงก์ (Arxiv, 2022) [กระดาษ]

- จากการเลือกปฏิบัติสู่รุ่น: กราฟความรู้เสร็จสมบูรณ์ด้วยหม้อแปลงไฟฟ้า (www, 2022) [กระดาษ]

- การทำกราฟความรู้ตามลำดับต่อลำดับและการตอบคำถาม (ACL, 2022) [กระดาษ]

- ความรู้คือแบน: กรอบการกำเนิด SEQ2SEQ สำหรับการสร้างกราฟความรู้ที่หลากหลาย (COLING, 2022) [กระดาษ]

- กรอบสำหรับการปรับรูปแบบภาษาที่ผ่านการฝึกอบรมมาแล้วให้เข้ากับกราฟความรู้ที่สมบูรณ์ (EMNLP, 2022) [กระดาษ]

- การจุ่มซอส PLMS: โครงสร้างการเชื่อมและข้อความสำหรับกราฟความรู้ที่มีประสิทธิภาพเสร็จสมบูรณ์ผ่านการแจ้งเตือนแบบนุ่มนวลตามเงื่อนไข (ACL, 2023) [กระดาษ]

LLM-Augmented KG-text Text

- Genwiki: ชุดข้อมูลของข้อความและกราฟการแบ่งปันเนื้อหา 1.3 ล้านรายการสำหรับการสร้างกราฟเป็นข้อความ (Coling, 2020) [Paper]

- KGPT: การฝึกอบรมก่อนความรู้สำหรับการสร้างข้อมูลเป็นข้อความ (EMNLP 2020) [กระดาษ]

- JointGT: การเรียนรู้การแสดงข้อต่อกราฟข้อความสำหรับการสร้างข้อความจากกราฟความรู้ (ผลการวิจัย ACL, 2021) [กระดาษ]

- การตรวจสอบแบบจำลองภาษาที่ผ่านการฝึกอบรมสำหรับการสร้างกราฟเป็นข้อความ (NLP4Convai, 2021) [กระดาษ]

- การสร้างกราฟเป็นข้อความถึงความรู้สองสามครั้งด้วยแบบจำลองภาษาที่ผ่านการฝึกฝน (ACL, 2021) [กระดาษ]

- EventNarrative: ชุดข้อมูลเหตุการณ์ขนาดใหญ่เป็นศูนย์กลางสำหรับการสร้างกราฟเป็นข้อความความรู้ (Neurips, 2021)

- GAP: กรอบรูปแบบภาษาที่รับรู้กราฟสำหรับการสร้างกราฟเป็นข้อความความรู้ (Coling, 2022) [กระดาษ]

LLM-Augmented KG ตอบคำถาม

- Unikgqa: การดึงข้อมูลและการใช้เหตุผลแบบครบวงจรสำหรับการแก้ปัญหาหลายคำถามที่ตอบคำถามกราฟความรู้ (ICLR, 2023) [กระดาษ]

- structGPT: กรอบทั่วไปสำหรับแบบจำลองภาษาขนาดใหญ่เพื่อให้เหตุผลมากกว่าข้อมูลที่มีโครงสร้าง (arxiv, 2023) [กระดาษ]

- การศึกษาเชิงประจักษ์ของ GPT-3 สำหรับ VQA ที่ใช้ความรู้ไม่กี่ครั้ง (AAAI, 2022) [กระดาษ]

- การศึกษาเชิงประจักษ์ของแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อนในการตอบคำถามกราฟความรู้ง่ายๆ (World Wide Web Journal, 2023) [กระดาษ]

- เพิ่มขีดความสามารถของแบบจำลองภาษาด้วยการใช้กราฟความรู้สำหรับการตอบคำถามแบบเปิดโดเมน (EMNLP, 2022) [กระดาษ]

- DRLK: การใช้เหตุผลแบบลำดับชั้นแบบไดนามิกด้วยรูปแบบภาษาและกราฟความรู้สำหรับการตอบคำถาม (EMNLP, 2022) [กระดาษ]

- โมเดลที่ได้รับการปรับปรุง Subgraph Retrieval สำหรับการตอบคำถามฐานความรู้แบบหลายฮอป (ACL, 2022) [กระดาษ]

- Greaselm: กราฟการใช้เหตุผลแบบจำลองภาษาที่ปรับปรุงแล้วสำหรับการตอบคำถาม (ICLR, 2022) [กระดาษ]

- LAKO: การตอบคำถามด้วยความรู้ที่ขับเคลื่อนด้วยความรู้ผ่านการฉีดความรู้เป็นข้อความสาย (IJCKG, 2022) [กระดาษ]

- QA-GNN: การให้เหตุผลกับแบบจำลองภาษาและกราฟความรู้สำหรับการตอบคำถาม (NAACL, 2021) [กระดาษ]

Synergized LLMS + kgs

การเป็นตัวแทนความรู้

- Tele-Knowledge Pre-Training สำหรับการวิเคราะห์ความผิด (ICDE, 2023) [Paper]

- แบบจำลองภาษาก่อนการฝึกอบรมที่รวมความรู้ที่แตกต่างกันเฉพาะโดเมนเข้ากับการเป็นตัวแทนแบบครบวงจร (ระบบผู้เชี่ยวชาญที่มีแอปพลิเคชัน, 2023) [กระดาษ]

- กราฟความรู้ภาษาแบบสองทิศทางลึก (NIPS, 2022) [กระดาษ]

- Kepler: แบบครบวงจรสำหรับการฝังความรู้และการเป็นตัวแทนภาษาที่ผ่านการฝึกอบรมมาก่อน (TaCl, 2021) [กระดาษ]

- JointGT: การเรียนรู้การแสดงข้อต่อกราฟข้อความสำหรับการสร้างข้อความจากกราฟความรู้ (ACL 2021) [กระดาษ]

การให้เหตุผล

- บริการเสริมกราฟความรู้แบบครบวงจรสำหรับการส่งเสริมงาน NLP เฉพาะโดเมน (Arxiv, 2023) [กระดาษ]

- การใช้เหตุผลแบบรวมโครงสร้างและแบบจำลองภาษาก่อนการฝึกอบรมเพื่อการใช้เหตุผลที่ซับซ้อน (Arxiv, 2023) [กระดาษ]

- เหตุผลเชิงตรรกะที่ซับซ้อนเกี่ยวกับกราฟความรู้โดยใช้แบบจำลองภาษาขนาดใหญ่ (Arxiv, 2023) [กระดาษ]

แอปพลิเคชัน

ระบบแนะนำ

- Recindial: กรอบการทำงานแบบครบวงจรสำหรับคำแนะนำการสนทนากับแบบจำลองภาษาที่ผ่านการฝึกอบรม (Arxiv, 2023) [กระดาษ]

การวิเคราะห์ข้อผิดพลาด

- Tele-Knowledge Pre-Training สำหรับการวิเคราะห์ความผิด (ICDE, 2023) [Paper]