Awesome-llm-kg

大規模な言語モデル(LLMS)と知識グラフ(KG)の統一に関する論文とリソースのコレクション。

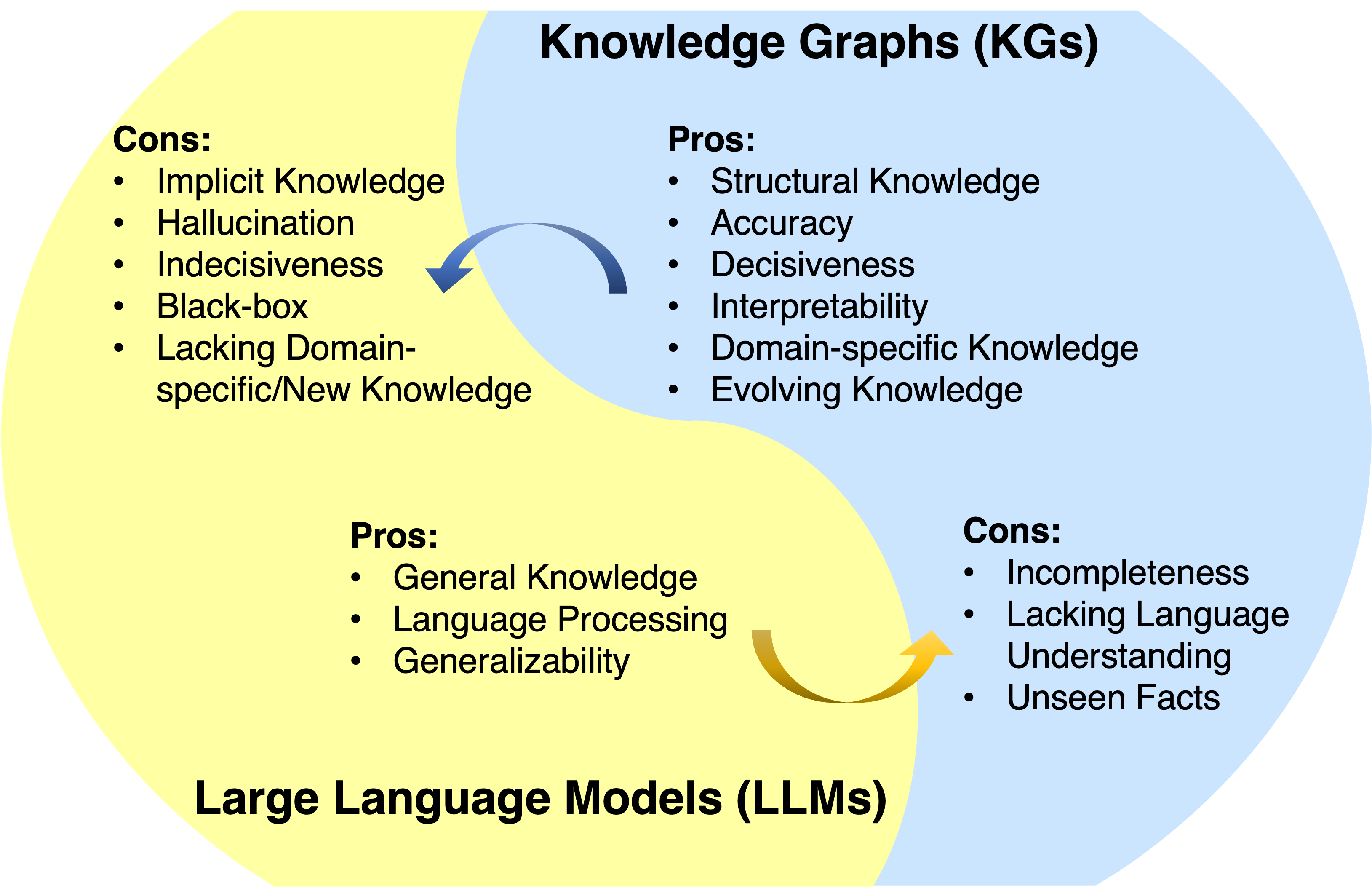

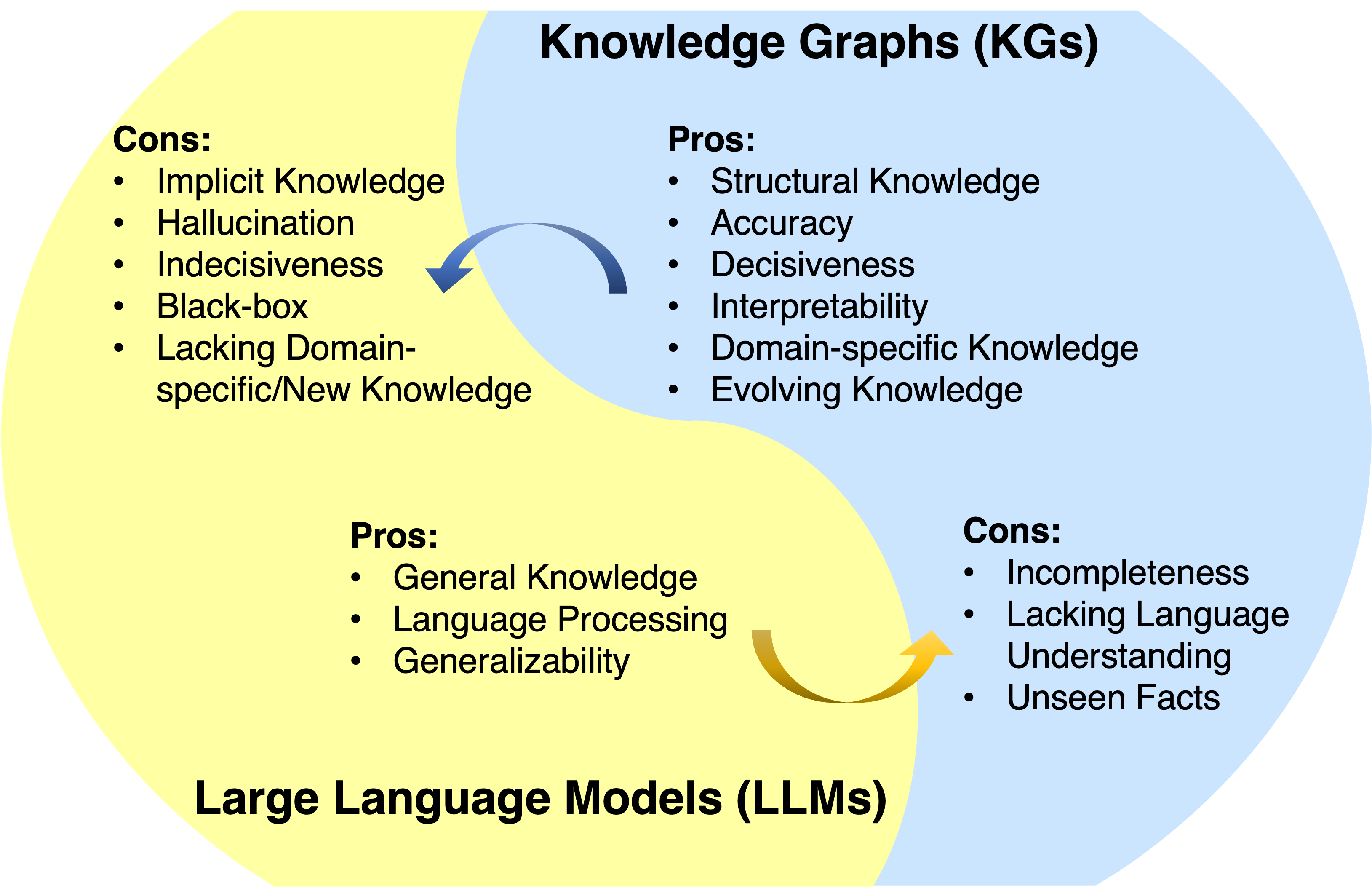

大規模な言語モデル(LLM)は、さまざまなアプリケーションで顕著な成功と一般化可能性を達成しています。しかし、彼らはしばしば事実の知識を捕らえてアクセスすることができません。ナレッジグラフ(KG)は、豊富な事実の知識を明示的に保存する構造化されたデータモデルです。それにもかかわらず、KGは構築するのが難しく、KGの既存の方法は、実際のKGの不完全で動的に変化する性質を処理するのに不十分です。したがって、LLMとKGを一緒に統合し、同時にそれらの利点を活用することは自然です。

ニュース

?このプロジェクトは開発中です。星を叩いて、更新に従うことができます。

- KG + LLM Reaosingに関する私たちの最新の作業は現在公開されています:グラフ制約の推論:大きな言語モデルを持つ知識グラフの忠実な推論

- 一時的なKG推論作業のための当社のLLM:大規模な言語モデルガイド付きダイナミックな適応時間グラフの推論は、Neurips 2024によって受け入れられています!

- LLM推論論文を分析するためのKG:知識グラフを使用したマルチホップ推論におけるチェーンのチェーンの直接評価は、ACL 2024によって受け入れられています。

- ロードマップペーパーはTKDEによって受け入れられました。

- LLMプロービングペーパーのKG:大規模な言語モデルにおける事実の知識の体系的な評価は、EMNLP 2023によって受け入れられています。

- KG + LLM推論論文:グラフの推論:忠実で解釈可能な大規模な言語モデルの推論は、ICLR 2024によって受け入れられています。

- KG推論用LLM:ChatRule:知識のための大規模な言語モデルを使用した論理ルールのマイニンググラフの推論が現在公開されています。

- 私たちのロードマップペーパー:大規模な言語モデルと知識グラフの統一:ロードマップが公開されました。

概要

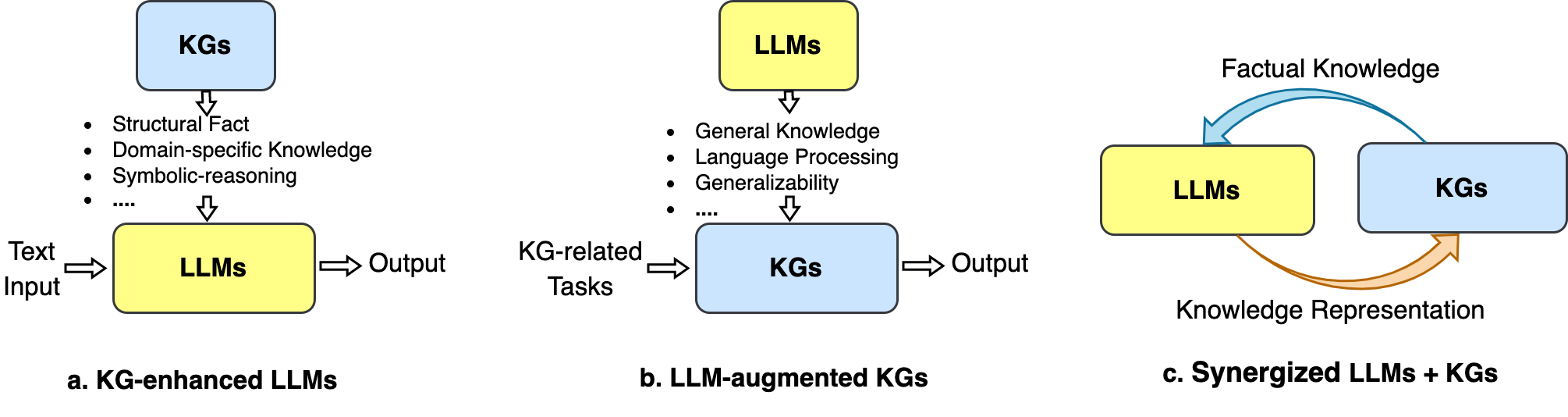

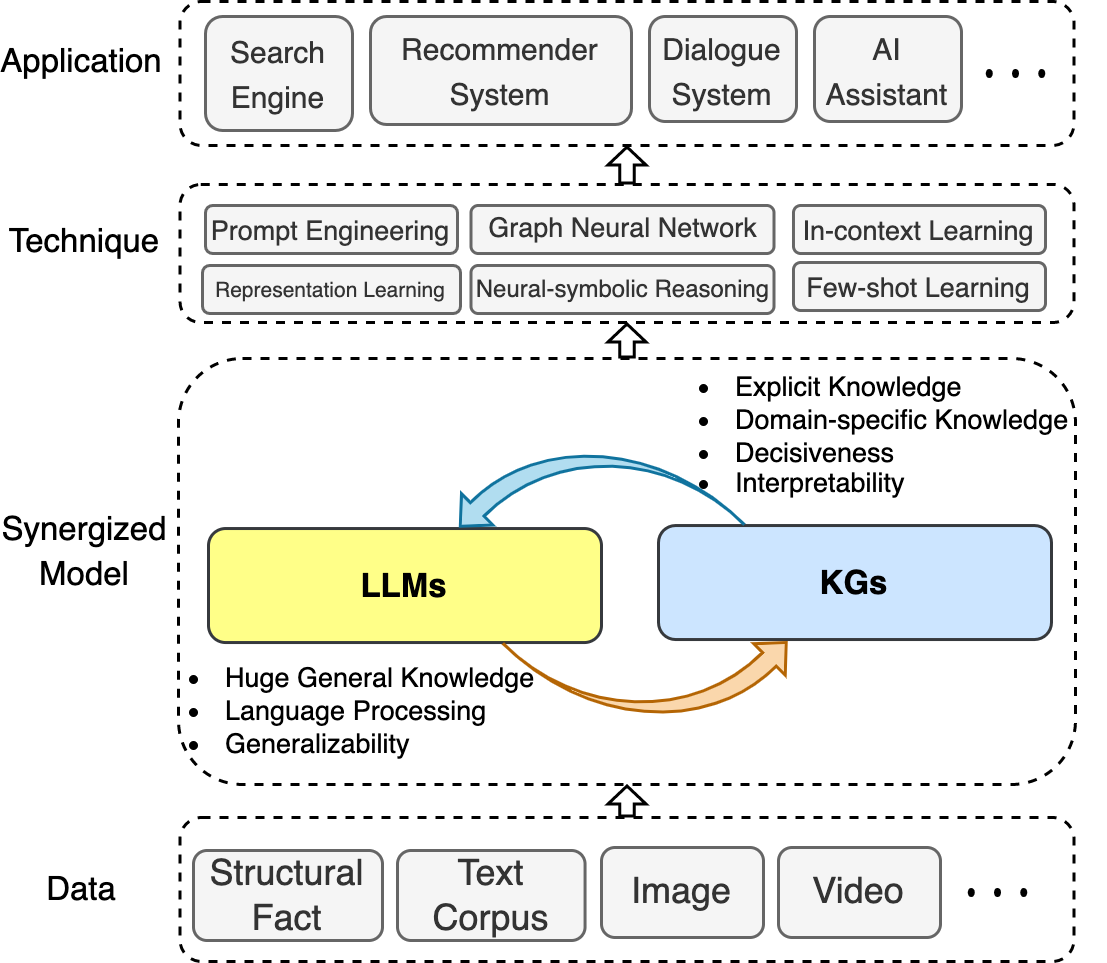

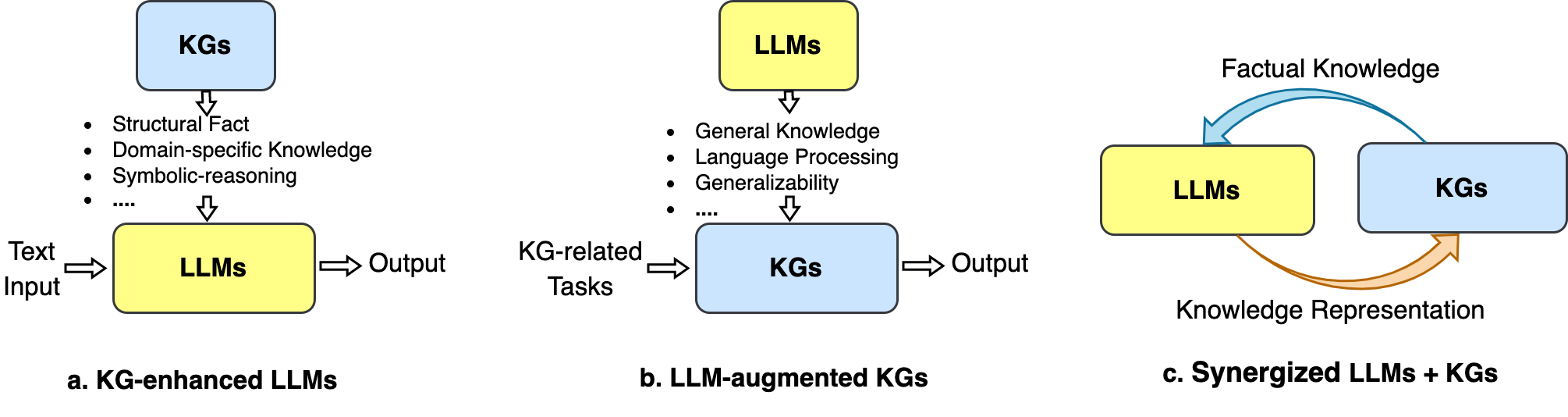

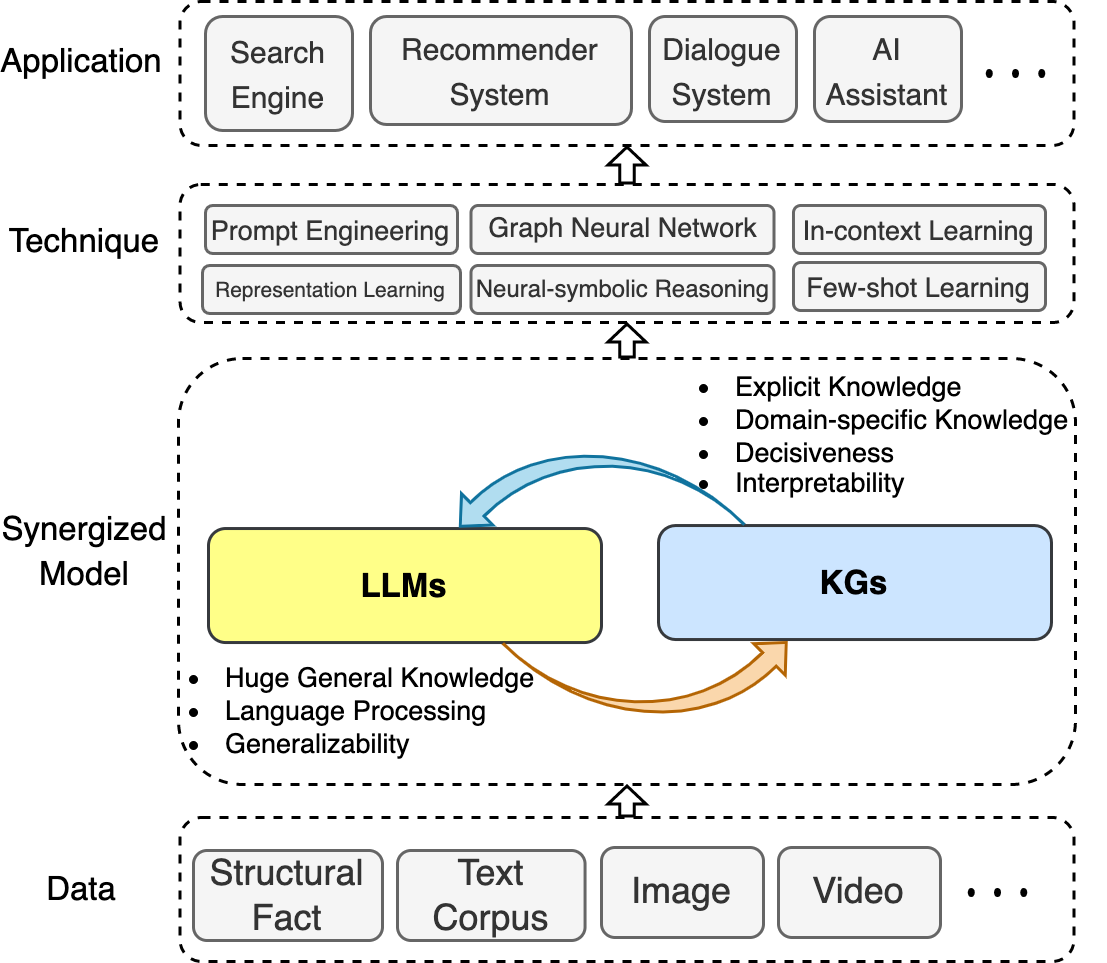

このリポジトリでは、LLMSとKGSの統一における最近の進歩を収集します。 3つの一般的なフレームワークを要約するロードマップを提示します: 1)kg強化LLMS 、 2)LLMSを使用したKG 、および3)相乗化LLMS + KG 。

また、関連する手法とアプリケーションを説明します。

このリポジトリが、研究者と実践者がこの新興分野をよりよく理解するのに役立つことを願っています。

このリポジトリがあなたに役立つ場合は、この論文を引用して、PLASEは私たちを助けてくれます。

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}目次

- Awesome-llm-kg

- ニュース

- 概要

- 目次

- 関連調査

- KG強化LLMS

- KG強化LLMプリトレーニング

- KG強化LLM推論

- KG強化LLM解釈可能性

- LLM-Augmented KGS

- LLMの高度KG埋め込み

- LLMが熟成したKG完了

- LLMの高級KGからテキストの生成

- LLM-Augmented KG質問応答

- 相乗化されたLLMS + kg

- アプリケーション

関連調査

- 大規模な言語モデルと知識グラフの統一:ロードマップ(TKDE、2024)[論文]

- 知識強化された事前訓練モデルに関する調査(ARXIV、2023)[論文]

- 事前に訓練された言語モデルを使用した知識集約型NLPの調査(ARXIV、2022)[論文]

- 知識ベースとしての言語モデルに関するレビュー(Arxiv、2022)[論文]

- 生成知識グラフ構造:レビュー(EMNLP、2022)[論文]

- 知識強化された前提条件モデル:複雑な調査(ARXIV、2021)[論文]

- さまざまな種類の知識グラフを超える推論:静的、時間、マルチモーダル(Arxiv、2022)[Paper] [Code]

KG強化LLMS

KG強化LLMプリトレーニング

- アーニー:有益なエンティティを使用した言語表現の強化(ACL、2019)[Paper]

- グラフ誘導表現学習を介してテキストの構造化された知識を活用する(EMNLP、2019)[Paper]

- SKEP:センチメントの知識は、センチメント分析のための事前トレーニングを強化しました(ACL、2020)[論文]

- e-bert:eコマースのフレーズと製品の知識強化言語モデル(arxiv、2020)[論文]

- 前処理された百科事典:監視されている知識に基づいた言語モデル(ICLR、2020)[論文]

- BERT-MK:グラフのコンテキスト化された知識を事前に訓練された言語モデルに統合する(EMNLP、2020)[Paper]

- K-Bert:知識グラフで言語表現を有効にする(AAAI、2020)[論文]

- Colake:文脈化された言語と知識の埋め込み(Coling、2020)[Paper]

- ケプラー:知識の埋め込みと事前に訓練された言語表現のための統一されたモデル(TACL、2021)[Paper]

- K-Adapter:アダプターを使用して事前に訓練されたモデルに知識を注入する(ACL Industs、2021)[Paper]

- コケバート:コンテキストの知識の選択と、訓練を受けた事前の言語モデルの強化に向けて埋め込む(AI Open、2021)[Paper]

- アーニー3.0:言語の理解と生成のための大規模な知識が事前トレーニングを強化する(ARIXV、2021)[Paper]

- 決定論的な事実知識を持つトレーニング前の言語モデル(EMNLP、2022)[論文]

- Kala:知識の高級言語モデルの適応(NAACL、2022)[論文]

- DKPLM:自然言語理解のための分解可能な知識強化事前訓練を受けた言語モデル(AAAI、2022)[論文]

- DICT-BERT:辞書によるトレーニング前の言語モデルの強化(ACL Industing、2022)[Paper]

- Jaket:知識と言語の理解の共同事前トレーニング(AAAI、2022)[論文]

- 障害分析のためのTele-Knowledge Pre-Training(ICDE、2023)[論文]

KG強化LLM推論

- バラクの妻ヒラリー:ファクトアウェア言語モデリングに知識グラフを使用する(ACL、2019)[Paper]

- 知識集約型NLPタスクの検索された生成(Neurips、2020)[論文]

- レルム:検索された言語モデル前訓練前(ICML、2020)[論文]

- QA-GNN:質問に答えるための言語モデルと知識グラフを使用している(NAACL、2021)[論文]

- 長い形式の物語の顕著性を推測するための記憶と知識の補強言語モデル(EMNLP、2021)[論文]

- 共同lk:言語モデルと知識のグラフとの共同推論質問質問の回答(NAACL、2022)[論文]

- 動的なドキュメントベースの知識グラフを介した大規模な言語モデルのストーリー理解の強化(AAAI、2022)[Paper]

- Greaselm:グラフ推論拡張言語モデル(ICLR、2022)[論文]

- ナレッジ集約型NLPタスクのための効率的なメモリの高度変圧器(EMNLP、2022)[論文]

- ゼロショットの知識グラフのプロンプトの知識補助言語モデル質問応答(nlrse@acl、2023)[Paper]

- LLMベースのマルチホップ質問の進化環境での知識グラフ統合による回答

KG強化LLM解釈可能性

- 知識ベースとしての言語モデル(EMNLP、2019)[論文]

- Kagnet:Commonsense Reasoningのための知識認識グラフネットワーク(Arxiv、2019)[Paper]

- Autoprompt:自動的に生成されたプロンプトを使用して言語モデルから知識を引き出す(EMNLP、2020)[Paper]

- どの言語モデルが知っているかをどうやって知ることができますか? (ACL、2020)[論文]

- 前処理された変圧器の知識ニューロン(ACL、2021)[紙]

- 言語モデルは生物医学的知識ベースになりますか? (EMNLP、2021)[論文]

- ナレッジグラフ抽出を介した言語モデルの解釈(ARXIV、2021)[Paper]

- QA-GNN:質問応答のための言語モデルと知識グラフを使用して(ACL、2021)[Paper]

- 言語モデルを照会する方法は? (Arxiv、2021)[紙]

- Rewire-Then-Probe:事前に訓練された言語モデルの生物医学的知識を調査するための対照的なレシピ(ARXIV、2021)[論文]

- 言語モデルを信頼しない場合:パラメトリックおよびノンパラメトリックメモリの有効性と制限の調査(Arxiv、2022)[Paper]

- 事前に訓練された言語モデルは、どのように事実に基づいた知識を捉えていますか?因果関係のある分析(ARXIV、2022)[論文]

- 知識グラフはテキストを単純化できますか? (Cikm、2023)[紙]

LLM-Augmented KGS

LLMの高度KG埋め込み

- 大規模な言語モデルからの騒々しいアノテーションとのエンティティアラインメント(Neurips、2024)[論文]

- lambdakg:事前に訓練された言語モデルベースの知識グラフ埋め込み(Arxiv、2023)[Paper]のライブラリ

- 知識グラフの統合グラフの埋め込みと、包括的な空間における前提条件の言語モデル(Arxiv、2022)[Paper]

- マルチモーダルナレッジグラフ表現を備えた言語モデルの献身(ARXIV、2022)[論文]

- 言語モデルガイド付き知識グラフ埋め込み(IEEE Access、2022)[Paper]

- 知識の埋め込みとしての言語モデル(IJCAI、2022)[論文]

- Pretrain-kge:事前に処理された言語モデルからの知識表現の学習(EMNLP、2020)[Paper]

- ケプラー:知識の埋め込みと事前に訓練された言語表現のための統一されたモデル(TACL、2020)[論文]

LLMが熟成したKG完了

- 大規模な言語モデルによる知識グラフの完了の多面的な改善(Coling2024)[Paper] [Code]

- KG-BERT:知識グラフの完了のためのBert(ARXIV、2019)[Paper]

- 知識のためのマルチタスク学習前訓練を受けた言語モデルを使用したグラフの完了(Coling、2020)[Paper]

- 事前に訓練されたモデルは知識グラフの完了に利益をもたらしますか?信頼できる評価と合理的なアプローチ(ACL、2022)[論文]

- 知識グラフの完了のための共同言語セマンティックと構造埋め込み(Coling、2022)[Paper]

- MEM-KGC:事前に訓練された言語モデル(IEEE Access、2021)を使用した知識グラフ完了のためのマスクされたエンティティモデル[Paper]

- 統一学習方法を介した事前に訓練された言語モデルを使用した知識グラフ拡張(Knowl。BasedSyst。、2023)[Paper]

- 効率的な知識グラフの完了のための構造の高度テキスト表現学習(www、2021)[論文]

- SIMKGC:事前に訓練された言語モデルを使用した単純なコントラストナレッジグラフの完了(ACL、2022)[Paper]

- LP-BERT:マルチタスクプリトレーニングナレッジグラフリンク予測のグラフ(ARXIV、2022)[Paper]

- 差別から世代へ:生成トランスによる知識グラフの完了(www、2022)[紙]

- シーケンスからシーケンスの知識グラフの完了と質問応答(ACL、2022)[論文]

- 知識はフラットです:さまざまな知識グラフの完了のためのseq2seq生成フレームワーク(Coling、2022)[Paper]

- 事前に訓練された言語モデルを知識グラフの完了に適応させるためのフレームワーク(EMNLP、2022)[Paper]

- 浸漬PLMSソース:効果的な知識のためのブリッジング構造とテキスト条件付きソフトプロンプト(ACL、2023)[Paper]

LLMの高級KGからテキストの生成

- Genwiki:監視されていないグラフからテキストへの生成のための130万のコンテンツ共有テキストとグラフのデータセット(Coling、2020)[Paper]

- KGPT:データからテキストの生成のための知識に基づいた事前トレーニング(EMNLP 2020)[論文]

- 共同GT:知識グラフからのテキスト生成のためのグラフテキスト共同表現学習(ACL Indunts、2021)[Paper]

- グラフからテキストの生成のための前提条件モデルの調査(NLP4Convai、2021)[Paper]

- 少ないショット知識前提条件モデルを使用したグラフからテキストへの生成(ACL、2021)[Paper]

- EventNarrative:知識のための大規模なイベント中心のデータセットグラフからテキストへの生成(Neurips、2021)[Paper]

- ギャップ:知識のためのグラフ認識言語モデルフレームワークグラフからテキストへの生成(Coling、2022)[Paper]

LLM-Augmented KG質問応答

- Unikgqa:統一された検索とマルチホップの質問を解決するための推論知識グラフ(ICLR、2023)[Paper]

- structgpt:構造化されたデータ(ARXIV、2023)上の推論する大規模な言語モデルの一般的なフレームワーク[Paper]

- 少数のショット知識ベースのVQA(AAAI、2022)のGPT-3の経験的研究[論文]

- シンプルな知識における事前に訓練された言語モデルの経験的研究グラフ質問応答(World Wide Web Journal、2023)[Paper]

- ナレッジグラフで言語モデルの力を強化するオープンドメイン質問応答の推論(EMNLP、2022)[論文]

- DRLK:質問回答のための言語モデルと知識グラフを使用した動的階層的推論(EMNLP、2022)[Paper]

- マルチホップナレッジベースの質問応答(ACL、2022)のサブグラフ検索強化モデル[Paper]

- Greaselm:質問応答のグラフ推論強化言語モデル(ICLR、2022)[論文]

- LAKO:知識駆動型の視覚的質問が遅れてテキストからテキストへの注入を介して回答する(IJCKG、2022)[論文]

- QA-GNN:質問に答えるための言語モデルと知識グラフを使用している(NAACL、2021)[論文]

相乗化されたLLMS + kg

知識表現

- 障害分析のためのTele-Knowledge Pre-Training(ICDE、2023)[論文]

- ドメイン固有の不均一な知識を統一された表現に組み込むトレーニング前の言語モデル(アプリケーションを備えたエキスパートシステム、2023)[論文]

- 深い双方向の言語知識グラフ前削除(NIP、2022)[論文]

- ケプラー:知識の埋め込みと事前に訓練された言語表現のための統一されたモデル(TACL、2021)[Paper]

- JointGT:知識グラフからのテキスト生成のためのグラフテキスト共同表現学習(ACL 2021)[Paper]

推論

- ドメイン固有のNLPタスクを強化するための統一された知識グラフ増強サービス(Arxiv、2023)[Paper]

- 統合構造の推論と言語モデル複雑な推論のための事前トレーニング(ARXIV、2023)[論文]

- 大きな言語モデルを使用した知識グラフ上の複雑な論理的推論(ARXIV、2023)[論文]

アプリケーション

推奨システム

- RECINDIAL:前提条件モデルを使用した会話型推奨のための統一されたフレームワーク(ARXIV、2023)[Paper]

障害分析

- 障害分析のためのTele-Knowledge Pre-Training(ICDE、2023)[論文]