Awesome-llm-kg

Eine Sammlung von Arbeiten und Ressourcen über die Vereinigung von großsprachigen Modellen (LLMs) und Wissensgraphen (KGs).

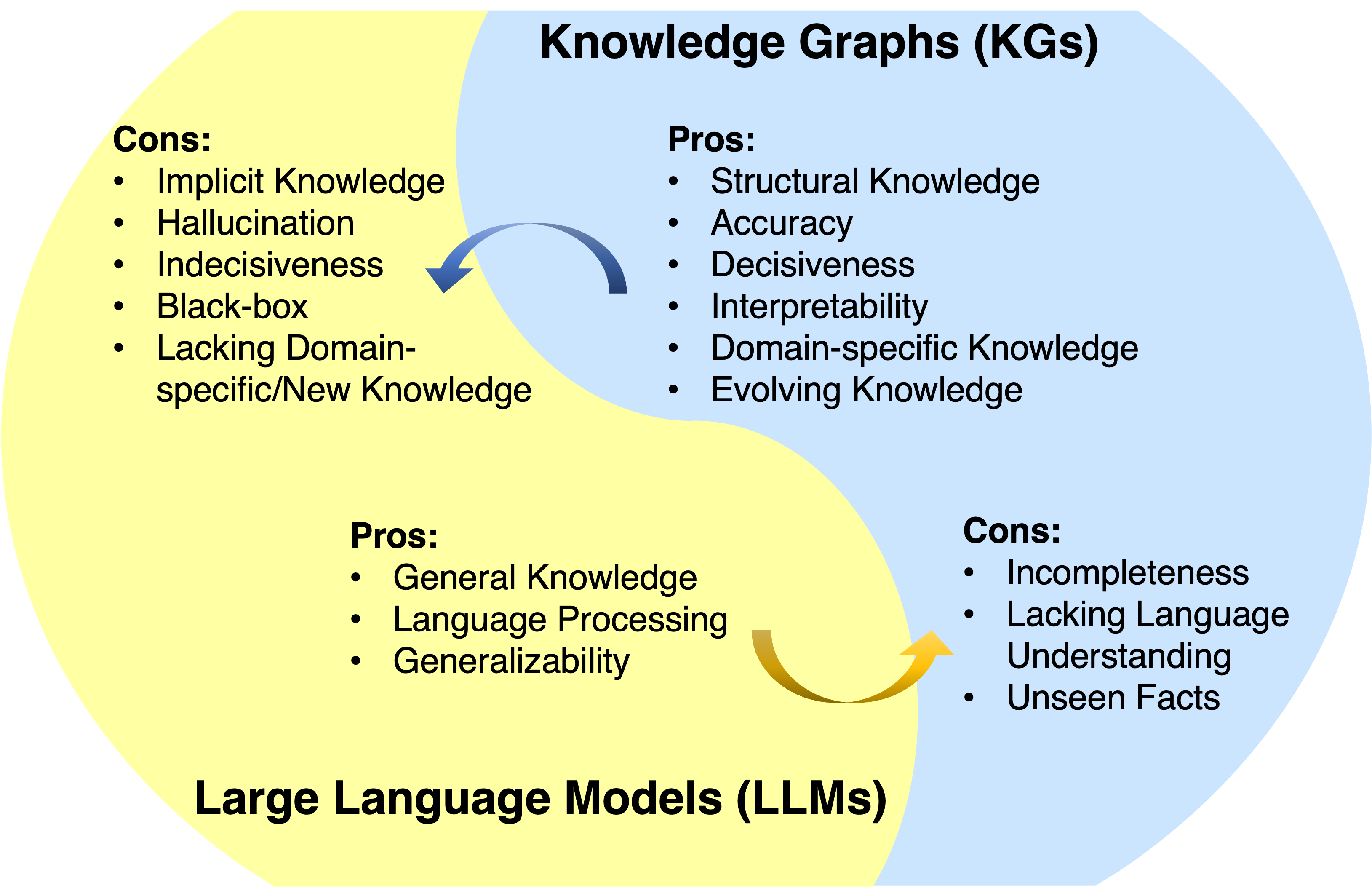

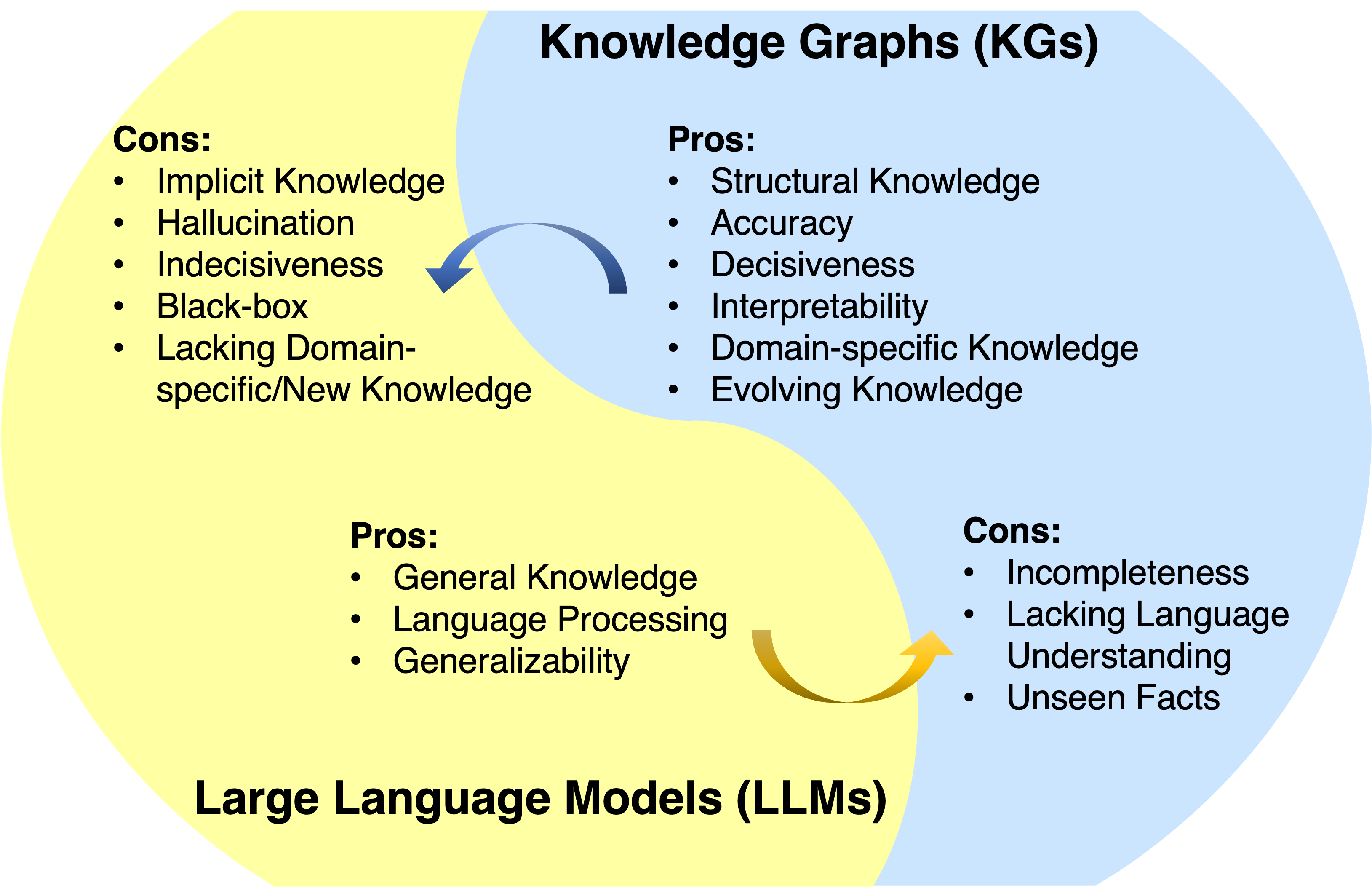

Großsprachenmodelle (LLMs) haben in verschiedenen Anwendungen einen bemerkenswerten Erfolg und die Generalisierbarkeit erzielt. Sie fallen jedoch häufig nicht vor, um sachlich zu erfassen und zugreifen zu können. Knowledge Graphs (KGs) sind strukturierte Datenmodelle, die explizit reiches Sachkenntnis speichern. Trotzdem sind KGs schwer zu konstruieren und vorhandene Methoden in KGs sind bei der Behandlung der unvollständigen und dynamisch verändernden Natur von kgs nicht ausreichend. Daher ist es natürlich, LLMs und KGs zusammen zu vereinen und gleichzeitig ihre Vorteile zu nutzen.

Nachricht

? Dieses Projekt befindet sich in der Entwicklung. Sie können den Stern schlagen und zuschauen , um den Updates zu folgen.

- Unsere jüngste Arbeit zum Nacherwachen von KG + LLM ist jetzt öffentlich: Grafikbeschränke Argumentation: Gläubige Argumentation zu Wissensgraphen mit großen Sprachmodellen

- Unsere LLM für zeitliche KG-Argumentationsarbeit: Großsprachige Modelle, die modelle dynamische Anpassung für zeitliche Wissensgrafik-Argumentation durch Neurips 2024 akzeptiert!

- Unser KG zur Analyse von LLM-Argumentationspapier: Die direkte Bewertung der Gedankenkette in Multi-Hop-Argumentation mit Wissensgraphen wurde von ACL 2024 akzeptiert.

- Unser Roadmap -Papier wurde von Tkde akzeptiert.

- Unser KG für LLM -Prüfpapier: Die systematische Bewertung von sachlichem Wissen in Großsprachenmodellen wurde von EMNLP 2023 akzeptiert.

- Unser KG + LLM -Argumentationspapier: Argumentation zu Grafiken: Treue und interpretierbare Argumentation des Modells wurde von ICLR 2024 akzeptiert.

- Unser LLM für KG -Argumentationspapier: Chatrule: Logische Regeln mit großer Sprachmodellen für Wissensgrafik -Argumentation ist jetzt öffentlich.

- Unser Roadmap -Papier: Vereinheitlich großer Sprachmodelle und Wissensdiagramme: Eine Roadmap ist jetzt öffentlich.

Überblick

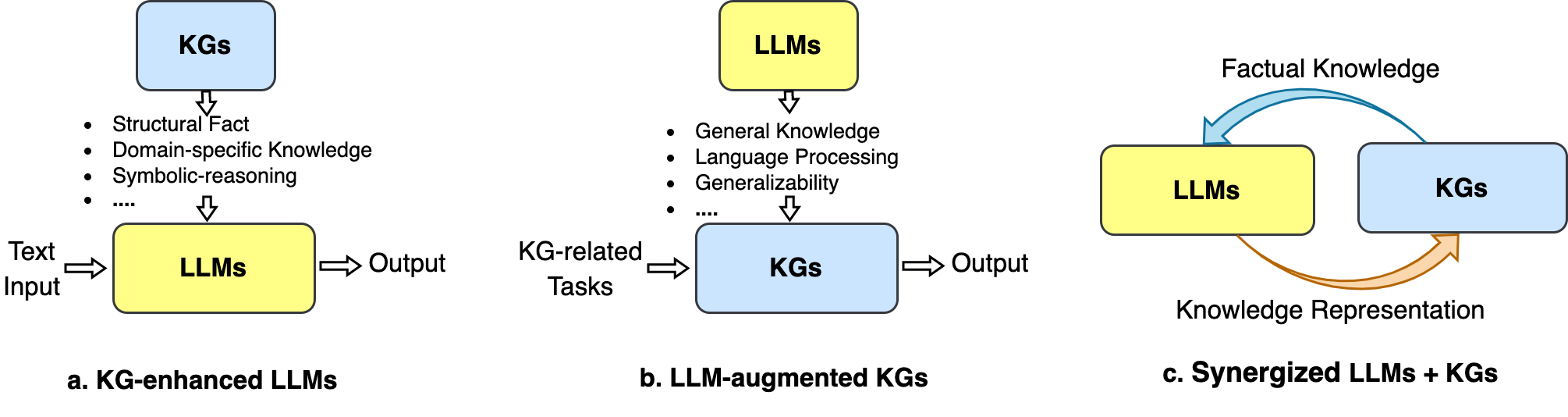

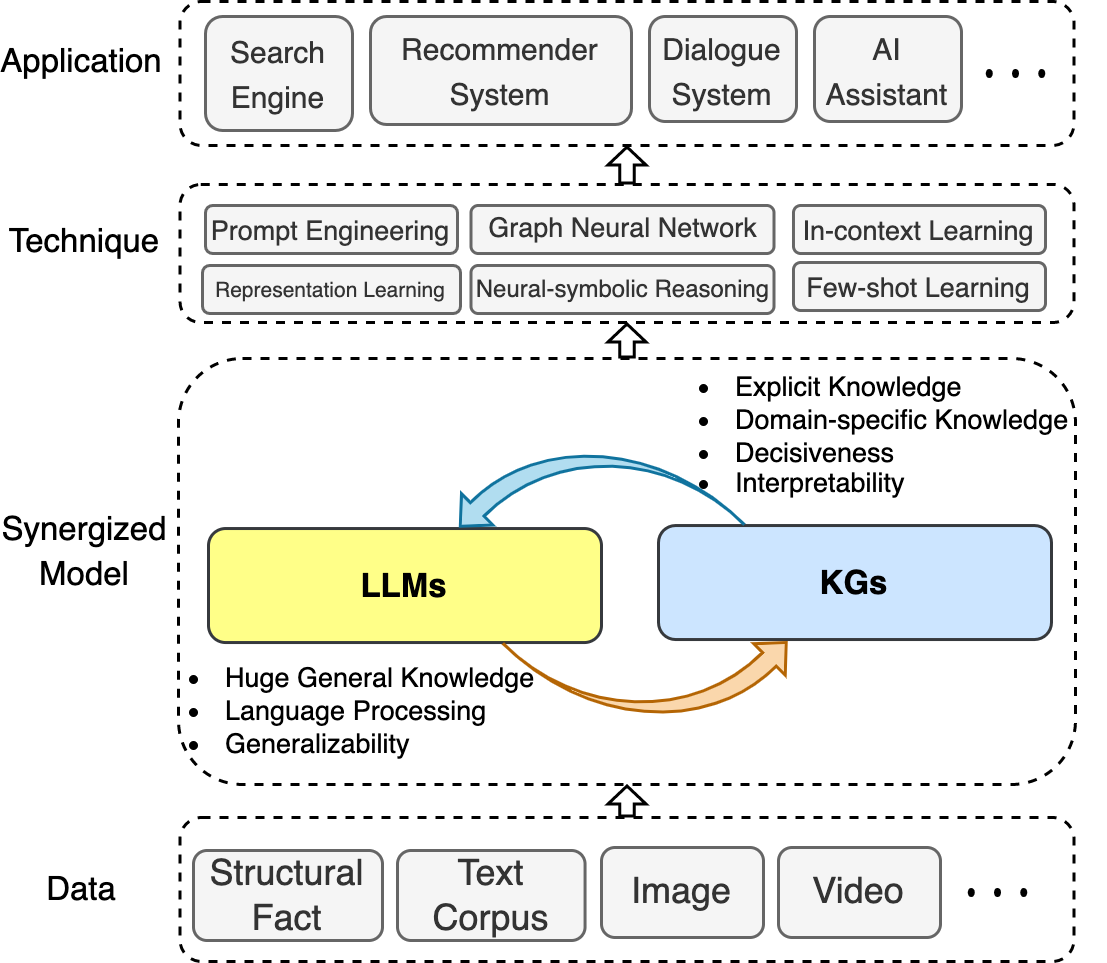

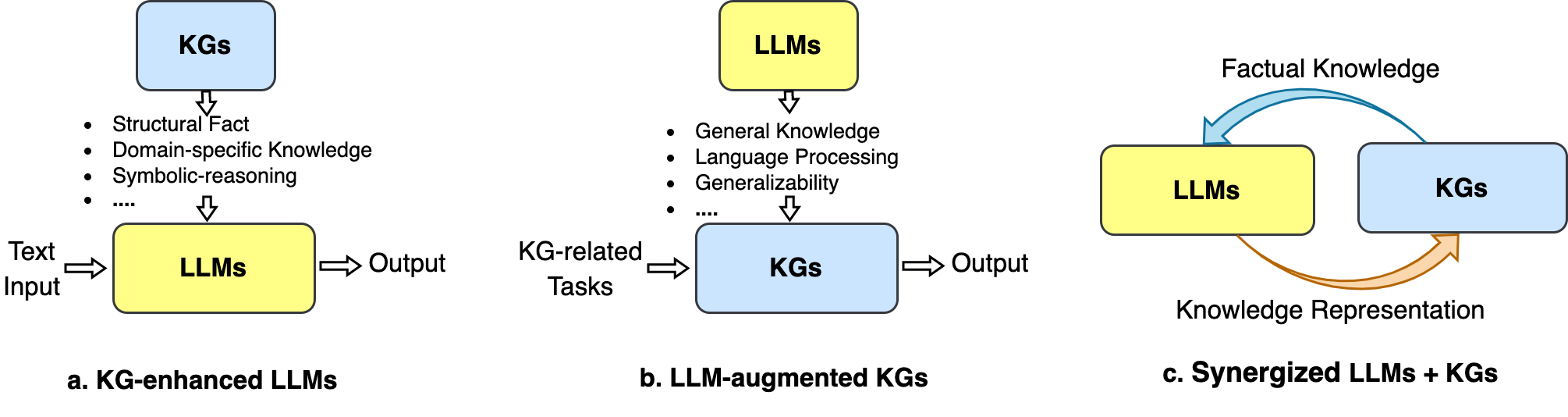

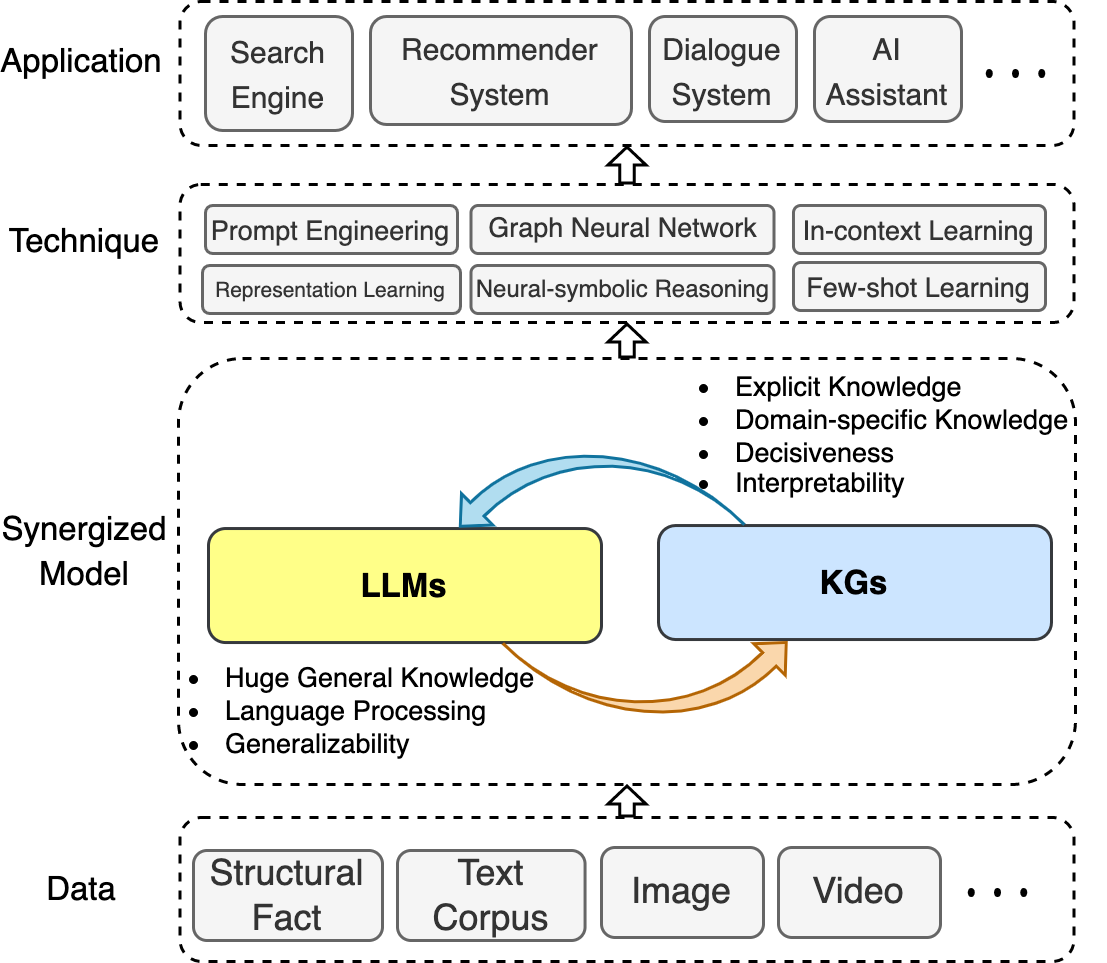

In diesem Repository sammeln wir jüngste Fortschritte bei der Vereinigung von LLMs und KGs. Wir präsentieren eine Roadmap, die drei allgemeine Frameworks zusammenfasst: 1) kg-verstärkte LLMs , 2) LLMs-genehmigte KGs und 3) synergierte LLMs + kg .

Wir veranschaulichen auch die beteiligten Techniken und Anwendungen.

Wir hoffen, dass dieses Repository Forschern und Praktikern helfen kann, dieses aufstrebende Bereich besser zu verstehen.

Wenn dieses Repository für Sie hilfreich ist, hilft uns Plase, indem Sie dieses Papier zitieren:

@article{llm_kg,

title={Unifying Large Language Models and Knowledge Graphs: A Roadmap},

author={Pan, Shirui and Luo, Linhao and Wang, Yufei and Chen, Chen and Wang, Jiapu and Wu, Xindong},

journal={IEEE Transactions on Knowledge and Data Engineering (TKDE)},

year={2024}

}Inhaltsverzeichnis

- Awesome-llm-kg

- Nachricht

- Überblick

- Inhaltsverzeichnis

- Verwandte Umfragen

- KG-verstärkte LLMs

- KG-verbessertes LLM-Vorbild

- KG-verstärkte LLM-Inferenz

- KG-verstärkte LLM-Interpretierbarkeit

- LLM-Augmented KGs

- LLM-Augmented KG-Einbettung

- LLM-Augmented KG Fertigstellung

- LLM-Augmented KG-to-Text-Generation

- LLM-augmented kg Frage Beantwortung

- Synergierte LLMs + kg

- Wissensdarstellung

- Argumentation

- Anwendungen

Verwandte Umfragen

- Vereinheitliche großsprachige Modelle und Wissensgrafiken: Eine Roadmap (Tkde, 2024) [Papier]

- Eine Umfrage zu wissensverbesserten vorgebrachten Sprachmodellen (Arxiv, 2023) [Papier]

- Eine Übersicht über wissensintensive NLP mit vorgeborenen Sprachmodellen (Arxiv, 2022) [Papier]

- Eine Übersicht über Sprachmodelle als Wissensbasis (Arxiv, 2022) [Papier]

- Generative Knowledge Graph Construction: Eine Übersicht (EMNLP, 2022) [Papier]

- Wissensverbesserte vorbereitete Sprachmodelle: Eine kompressive Umfrage (Arxiv, 2021) [Papier]

- Argumentation über verschiedene Arten von Wissensgraphen: Statisch, zeitliches und multimodales (Arxiv, 2022) [Papier] [Code]

KG-verstärkte LLMs

KG-verbessertes LLM-Vorbild

- Ernie: Verbesserte Sprachdarstellung mit informativen Einheiten (ACL, 2019) [Papier]

- Nutzung strukturiertes Wissen im Text über graphgeführte Darstellungslernen (EMNLP, 2019) [Papier]

- SKEP: Sentiment-Kenntnisse verbessert die Vorausbildung für die Stimmungsanalyse (ACL, 2020) [Papier]

- E-Bert: Ein Phrase- und Produktwissen verbessertes Sprachmodell für E-Commerce (Arxiv, 2020) [Papier]

- Vorbereitete Enzyklopädie: Schwach beaufsichtigte Wissensmodell (ICLR, 2020) [Papier]

- BERT-MK: Integrieren von Graphen kontextualisiertem Wissen in vorgeborene Sprachmodelle (EMNLP, 2020) [Papier]

- K-Tbert: Ermöglichung der Sprachdarstellung mit Wissensgrafik (AAAI, 2020) [Papier]

- COLAKE: Kontextualisierte Sprache und Wissensbettierung (Coling, 2020) [Papier]

- Kepler: Ein einheitliches Modell für die Einbettung von Wissen und die Darstellung der vorgebliebenen Sprache (TaCl, 2021) [Papier]

- K-Adapter: Infundieren von Wissen in vorgebrachte Modelle mit Adaptern (ACL-Befunde, 2021) [Papier]

- Cakebert: Kontextwissenauswahl und Einbettung in verbesserte Voraussetzungen (AI Open, 2021) [Papier]

- Ernie 3.0: Großtäuschendes Wissen verbesserte das Vorbild für Sprachverständnis und Generation (ARIXV, 2021) [Papier]

- Voraussetzungssprachmodelle mit deterministischem Faktenwissen (EMNLP, 2022) [Papier]

- Kala: Anpassung des Wissens-ausgelöste Sprachmodells (NAACL, 2022) [Papier]

- DKPLM: dekompossierbares, kenntnisverstärktes vorgebildetes Sprachmodell für das Verständnis der natürlichen Sprache (AAAI, 2022) [Papier]

- Diktat-Bert: Verbesserung des Sprachmodells vor der Ausbildung mit Wörterbuch (ACL-Befunde, 2022) [Papier]

- Jaket: Gemeinsame Vorverarbeitung von Wissensgrafik und Sprachverständnis (AAAI, 2022) [Papier]

- TELE-Wissen vor dem Training für die Fehleranalyse (ICDE, 2023) [Papier]

KG-verstärkte LLM-Inferenz

- Baracks Frau Hillary: Verwenden von Wissensgraphen für faktenbewusste Sprachmodellierung (ACL, 2019) [Papier]

- Retrieval-Augmented-Generation für wissensintensive NLP-Aufgaben (Neurips, 2020) [Papier]

- Realm: Abrufen-Sprachmodell vor dem Training (ICML, 2020) [Papier]

- QA-GNN: Argumentation mit Sprachmodellen und Wissensgraphen zur Beantwortung von Fragen (NAACl, 2021) [Papier]

- Gedächtnis- und Wissen erweiterte Sprachmodelle, um Salience in Langformgeschichten (EMNLP, 2021) zu schließen [Papier]

- Jointlk: Gemeinsame Argumentation mit Sprachmodellen und Wissensgraphen zur Beantwortung von Fragen (NAACL, 2022) [Papier]

- Verbessertes Geschichtenverständnis für Großsprachmodelle durch dynamische dokumentbasierte Wissensgraphen (AAAI, 2022) [Papier]

- Fetthändler: Graph -Argumentation erweiterte Sprachmodelle (ICLR, 2022) [Papier]

- Ein effizienter, von Gedächtnisgeräte für wissensintensives NLP-Aufgaben (EMNLP, 2022) [Papier]

- Sprachmodell für Wissensausfälle für die Beantwortung von Null-Shot-Wissensgraphen (NLRSE@ACL, 2023) [Papier]

- LLM-basierte Multi-Hop-Frage zur Beantwortung der Integration von Knowledge Graph in sich entwickelnden Umgebungen (EMNLP-Befunde, 2024) [Papier]

KG-verstärkte LLM-Interpretierbarkeit

- Sprachmodelle als Wissensbasis (EMNLP, 2019) [Papier]

- KAGNET: Wissensbewusste Graph-Netzwerke für Commonsense-Argumentation (Arxiv, 2019) [Papier]

- Autoprompt: Wissen aus Sprachmodellen mit automatisch generierten Eingabeaufforderungen (EMNLP, 2020) [Papier]

- Wie können wir wissen, was Sprachmodelle wissen? (ACL, 2020) [Papier]

- Wissensneuronen in vorbereiteten Transformatoren (ACL, 2021) [Papier]

- Können Sprachmodelle biomedizinische Wissensbasis sein? (EMNLP, 2021) [Papier]

- Interpretation von Sprachmodellen durch Knowledge -Graph -Extraktion (Arxiv, 2021) [Papier]

- QA-GNN: Argumentation mit Sprachmodellen und Wissensgrafiken zur Beantwortung von Fragen (ACL, 2021) [Papier]

- Wie frage ich Sprachmodelle? (Arxiv, 2021) [Papier]

- REWIRE-Then-Probe: Ein kontrastives Rezept zur Untersuchung biomedizinischer Kenntnisse vor ausgebildeter Sprachmodelle (Arxiv, 2021) [Papier]

- Wenn nicht zu Sprachmodellen vertrauen: Untersuchung der Wirksamkeit und Einschränkungen parametrischer und nichtparametrischer Erinnerungen (Arxiv, 2022) [Papier]

- Wie erfassen vorgebrachte Sprachmodelle Faktenwissen? Eine kausal inspirierte Analyse (Arxiv, 2022) [Papier]

- Können Wissensgrafiken den Text vereinfachen? (CIKM, 2023) [Papier]

LLM-Augmented KGs

LLM-Augmented KG-Einbettung

- Entity -Ausrichtung mit lauten Anmerkungen aus Großsprachenmodellen (Neurips, 2024) [Papier]

- Lambdakg: Eine Bibliothek für vorgeborene Sprachmodell-basierte Knowledge Graphdings (Arxiv, 2023) [Papier]

- Integration von Wissensgraphen und vorgezogenen Sprachmodellen in Hyperkomplexräume (Arxiv, 2022) [Papier]

- Ausgebotsprachmodelle mit multimodalen Wissensgrafikdarstellungen (Arxiv, 2022) [Papier]

- Sprachmodell Guided Knowledge Graph Emetten (IEEE Access, 2022) [Papier]

- Sprachmodelle als Wissensverbettung (IJCAI, 2022) [Papier]

- Pretrain-KGE: Lernkenntnisdarstellung aus vorbereiteten Sprachmodellen (EMNLP, 2020) [Papier]

- Kepler: Ein einheitliches Modell für die Einbettung von Wissen und die Darstellung der Sprachdarstellung (TaCl, 2020) [Papier]

LLM-Augmented KG Fertigstellung

- Multi-Perspektive Verbesserung des Wissensgrafikabschlusses mit großsprachigen Modellen (Coling 2024) [Papier] [Code]

- KG-Bert: Bert für den Abschluss des Wissensgrafiks (Arxiv, 2019) [Papier]

- Multi-Task-Lernen für Wissensgrafiken Abschluss mit vorgebildeten Sprachmodellen (Coling, 2020) [Papier]

- Profitieren vorgebildete Modelle den Kenntnisgrafikabschluss? Eine zuverlässige Bewertung und ein angemessener Ansatz (ACL, 2022) [Papier]

- Joint Language Semantic und Structure Inbetting für den Abschluss des Wissensgrafiks (Coling, 2022) [Papier]

- MEM-KGC: Masked Entity-Modell für Wissensgraphen Abschluss mit vorgebildetem Sprachmodell (IEEE Access, 2021) [Papier]

- Knowledge-Graph-Erweiterung mit einem vorgebildeten Sprachmodell über einheitliche Lernmethode (Knowl. Basierter Syst., 2023) [Papier]

- Struktur-ausgestattete Textrepräsentation Lernen für effiziente Wissensgrafikabschluss (www, 2021) [Papier]

- SIMKGC: Einfache kontrastive Wissensgrafik-Abschluss mit vorgeborenen Sprachmodellen (ACL, 2022) [Papier]

- LP-Bert: Multi-Task-Knowledge-Graph Bert für die Link-Vorhersage (Arxiv, 2022) [Papier]

- Von der Diskriminierung bis zur Generation: Kenntnisgrafikabschluss mit Generativen Transformator (www, 2022) [Papier]

- Sequenz-zu-Sequenz-Wissensgrafikabschluss und Fragenbeantwortung (ACL, 2022) [Papier]

- Wissen ist flach: Ein SEQ2SEQ -generativer Rahmen für verschiedene Wissensgraphen (Coling, 2022) [Papier]

- Ein Rahmen für die Anpassung vor ausgebildeter Sprachmodelle an den Abschluss des Wissensgrafiks (EMNLP, 2022) [Papier]

- Dip -PLMS -Sauce: Überbrückungsstruktur und Text für eine effektive Kenntnisgrafikabschluss durch bedingte Soft -Aufforderung (ACL, 2023) [Papier]

LLM-Augmented KG-to-Text-Generation

- Genwiki: Ein Datensatz von 1,3 Millionen Text- und Grafiken für unbeaufsichtigte Graph-to-Text-Generation (Coling, 2020) [Papier]

- KGPT: Kenntnisgeweihter Vorinstallation für die Erzeugung von Daten zu Text (EMNLP 2020) [Papier]

- JointGT: Graph-Text Joint Repräsentation Lernen für die Textgenerierung aus Wissensgraphen (ACL-Befunde, 2021) [Papier]

- Untersuchung vorgelöster Sprachmodelle für die Erzeugung von Graph-to-Text (NLP4Convai, 2021) [Papier]

- Wenige Schuss-Wissensgrafik-zu-Text-Erzeugung mit vorbereiteten Sprachmodellen (ACL, 2021) [Papier]

- EventNarrative: Ein groß angelegter ereignisorientierter Datensatz für die Erzeugung von Wissensgrafik-zu-Text (Neurips, 2021) [Papier]

- Lücke: Ein grafisches Sprachmodell-Framework für Wissensgrafik-zu-Text-Generierung (Coling, 2022) [Papier]

LLM-augmented kg Frage Beantwortung

- UNIKGQA: Unified Abruf und Argumentation zur Lösung von Multi-Hop-Fragen zur Beantwortung des Wissensgrafiks (ICLR, 2023) [Papier]

- StructGPT: Ein allgemeiner Rahmen für ein großes Sprachmodell, um über strukturierte Daten zu begründen (Arxiv, 2023) [Papier]

- Eine empirische Studie von GPT-3 für wenige schützende wissensbasierte VQA (AAAI, 2022) [Papier]

- Eine empirische Studie über vorgebreitete Sprachmodelle in der Beantwortung von einfacher Knowledge-Graph-Frage (World Wide Web Journal, 2023) [Papier]

- Ermächtigung von Sprachmodellen mit Wissensgrafik-Argumentation für die Beantwortung von Fragen zur Beantwortung offener Domänen (EMNLP, 2022) [Papier]

- DRLK: Dynamisches hierarchisches Denken mit Sprachmodell und Wissensgrafik für die Beantwortung von Fragen (EMNLP, 2022) [Papier]

- Abrufener Abruf des Subgraphes erweitertes Modell für die Beantwortung von Fragen zur Beantwortung von Multi-Hop-Wissensbasis (ACL, 2022) [Papier]

- Fetthändler: Graph -Argumentation erweiterte Sprachmodelle zur Beantwortung von Fragen (ICLR, 2022) [Papier]

- Lako: Wissensgetriebene visuelle Frage zur Beantwortung eines späten Wissens zu Textinjektion (IJCKG, 2022) [Papier]

- QA-GNN: Argumentation mit Sprachmodellen und Wissensgraphen zur Beantwortung von Fragen (NAACl, 2021) [Papier]

Synergierte LLMs + kg

Wissensdarstellung

- TELE-Wissen vor dem Training für die Fehleranalyse (ICDE, 2023) [Papier]

- Vor-Training-Sprachmodell mit domänenspezifischem heterogenem Wissen in eine einheitliche Darstellung (Expertensysteme mit Anwendungen, 2023) [Papier]

- Tiefe bidirektionale Sprachkenntnis-Graph-Vorbereitung (NIPS, 2022) [Papier]

- Kepler: Ein einheitliches Modell für die Einbettung von Wissen und die Darstellung der vorgebliebenen Sprache (TaCl, 2021) [Papier]

- JointGT: Graph-Text Joint Repräsentation Lernen für die Textgenerierung aus Wissensgraphen (ACL 2021) [Papier]

Argumentation

- Ein einheitlicher Knowledge-Graph-Augmentationsdienst zur Steigerung der domänenspezifischen NLP-Aufgaben (Arxiv, 2023) [Papier]

- Einheitliche Struktur-Argumentation und Sprachmodell vor dem Training für komplexes Denken (Arxiv, 2023) [Papier]

- Komplexes logisches Denken über Wissensgraphen mit großer Sprachmodellen (Arxiv, 2023) [Papier]

Anwendungen

Empfehlungssystem

- Wiederholt: Ein einheitlicher Rahmen für die Konversationsempfehlung mit vorbereiteten Sprachmodellen (Arxiv, 2023) [Papier]

Fehleranalyse

- TELE-Wissen vor dem Training für die Fehleranalyse (ICDE, 2023) [Papier]