在人工智能领域,大语言模型(LLM)的发展日新月异,卡内基梅隆大学(CMU)与HuggingFace的研究团队最近提出了一项名为“元强化微调”(Meta Reinforcement Fine-Tuning,简称MRT)的创新方法。这一技术旨在优化大语言模型在测试阶段的计算效率,特别是在处理复杂推理任务时,表现尤为显着。

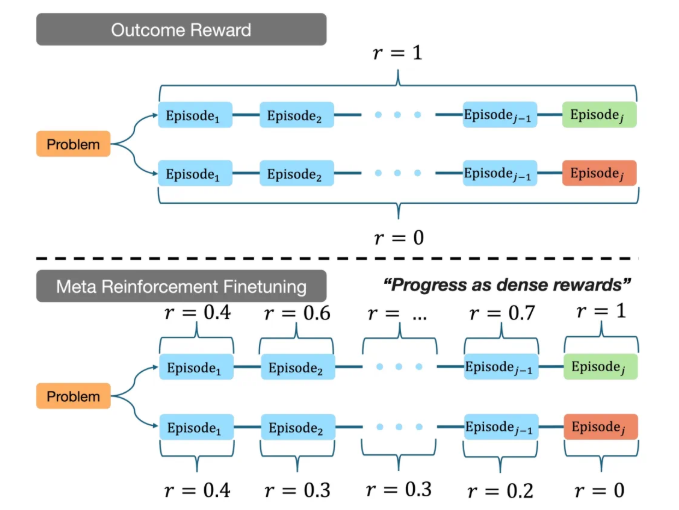

研究表明,现有的大语言模型在推理过程中往往消耗大量计算资源,而MRT的目标是在有限的计算预算内,帮助模型更高效地找到答案。该方法通过将大语言模型的输出分割成多个片段,实现了探索与利用之间的平衡。通过对训练数据的深入分析,MRT使模型在面对未知问题时,既能充分利用已知信息,又能探索新的解题策略。

在CMU团队的实验中,使用MRT微调后的模型在多个推理基准测试中表现优异。与传统的结果奖励强化学习(GRPO)相比,MRT的准确率提高了2到3倍,同时在token使用效率上提升了1.5倍。这一结果表明,MRT不仅能够增强模型的推理能力,还能显着降低计算资源的消耗,使其在实际应用中更具竞争力。

此外,研究团队还提出了如何有效评估现有推理模型性能的方法,为未来的研究提供了重要参考。这一成果不仅展示了MRT的潜力,也为大语言模型在更复杂应用场景中的发展指明了方向。

通过这一创新,CMU与HuggingFace的研究团队在推动人工智能技术的前沿领域迈出了重要一步,赋予机器更强大的推理能力,为未来更智能的应用奠定了坚实基础。

项目地址:https://cohenqu.github.io/mrt.github.io/