人工知能の分野では、大規模な言語モデル(LLM)の開発は、1日ごとに変化しています。カーネギーメロン大学(CMU)とハグイングフェイスの研究チームは最近、「メタ補強材微調整」(MRT)と呼ばれる革新的なアプローチを提案しました。この手法は、特に複雑な推論タスクを扱う場合、テストフェーズ中の大規模な言語モデルの計算効率を最適化することを目的としています。

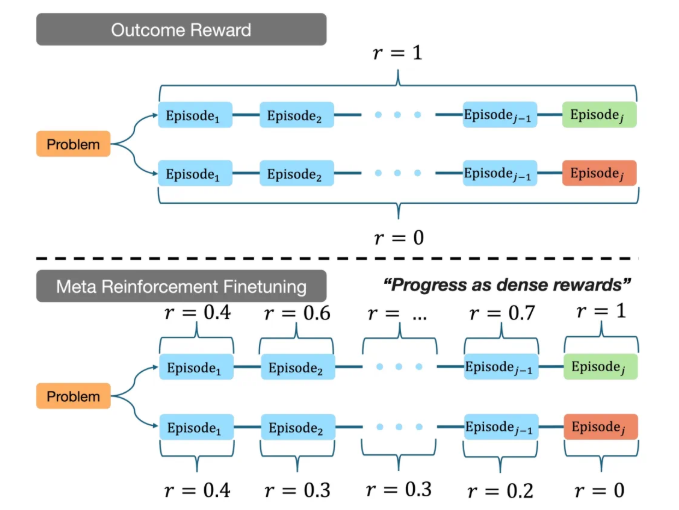

調査によると、既存の大規模な言語モデルは、推論プロセス中に多くのコンピューティングリソースを消費することが多く、MRTの目標は、モデルが限られたコンピューティング予算内でより効率的に回答を見つけるのを支援することです。この方法は、大規模な言語モデルの出力を複数のフラグメントにセグメント化することにより、探索と利用のバランスを達成します。トレーニングデータの詳細な分析を通じて、MRTは、未知の問題に直面しているときにモデルが既知の情報を最大限に活用し、新しい問題解決戦略を調査できるようにします。

CMUチームの実験では、MRTを使用したモデルが微調整されたモデルは、複数の推論ベンチマークで優れた機能を果たしました。従来の結果と比較して、報酬補強学習(GRPO)は、MRTの精度は2〜3倍高く、トークンの使用効率の1.5倍高くなっています。この結果は、MRTがモデルの推論能力を高めるだけでなく、コンピューティングリソースの消費を大幅に削減し、実際のアプリケーションで競争力を高めることを示しています。

さらに、研究チームはまた、既存の推論モデルのパフォーマンスを効果的に評価する方法を提案し、将来の研究のための重要な参照を提供しました。この成果は、MRTの可能性を実証するだけでなく、より複雑なアプリケーションシナリオでの大規模な言語モデルの開発の方向を指摘しています。

このイノベーションを通じて、CMUとHuggingfaceの研究チームは、人工知能技術の最先端の分野を促進し、より強力な推論能力を備えた機械に力を与え、将来よりスマートなアプリケーションのための強固な基盤を築くために重要な一歩を踏み出しました。

プロジェクトアドレス:https://cohenqu.github.io/mrt.github.io/