인공 지능 분야에서 LLM (Lange Language Models)의 개발은 매일 매일 바뀌고 있습니다. CMU (Carnegie Mellon University)의 연구팀과 Huggingf 이 기술은 테스트 단계에서, 특히 복잡한 추론 작업을 처리 할 때 대형 언어 모델의 계산 효율성을 최적화하는 것을 목표로합니다.

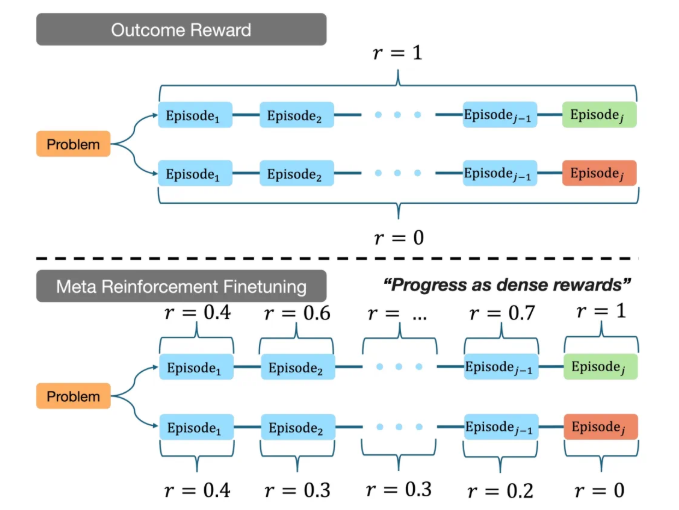

연구에 따르면 기존의 대형 언어 모델은 추론 과정에서 종종 많은 컴퓨팅 리소스를 소비하는 반면, MRT의 목표는 제한된 컴퓨팅 예산 내에서 모델이 더 효율적으로 답변을 찾는 데 도움이되는 것입니다. 이 방법은 큰 언어 모델의 출력을 여러 조각으로 분할하여 탐사와 활용 사이의 균형을 달성합니다. MRT는 교육 데이터에 대한 심층 분석을 통해 모델이 알려지지 않은 문제에 직면 할 때 알려진 정보를 최대한 활용하고 새로운 문제 해결 전략을 탐색 할 수있게합니다.

CMU 팀의 실험에서 MRT를 사용하여 미세 조정 된 모델은 다중 추론 벤치 마크에서 훌륭하게 수행되었습니다. 전통적인 결과와 비교할 때 GRPO (Grosward Inforcement Learning)와 비교할 때 MRT의 정확도는 2 ~ 3 배, 토큰 사용 효율은 1.5 배 더 높습니다. 이 결과는 MRT가 모델의 추론 능력을 향상시킬 수있을뿐만 아니라 컴퓨팅 리소스 소비를 크게 줄여 실제 응용 분야에서보다 경쟁력이 있음을 보여줍니다.

또한, 연구팀은 또한 기존 추론 모델의 성능을 효과적으로 평가하여 향후 연구를위한 중요한 참조를 제공하는 방법을 제안했습니다. 이 성과는 MRT의 잠재력을 보여줄뿐만 아니라보다 복잡한 응용 시나리오에서 대형 언어 모델의 개발 방향을 지적합니다.

CMU와 Huggingf

프로젝트 주소 : https://cohenqu.github.io/mrt.github.io/