ในด้านปัญญาประดิษฐ์การพัฒนาแบบจำลองภาษาขนาดใหญ่ (LLM) กำลังเปลี่ยนแปลงไปในแต่ละวันที่ผ่านมา ทีมวิจัยที่ Carnegie Mellon University (CMU) และ HuggingFace เพิ่งเสนอวิธีการที่เป็นนวัตกรรมที่เรียกว่า เทคนิคนี้มีวัตถุประสงค์เพื่อเพิ่มประสิทธิภาพการคำนวณของแบบจำลองภาษาขนาดใหญ่ในระหว่างขั้นตอนการทดสอบโดยเฉพาะอย่างยิ่งเมื่อต้องรับมือกับงานการอนุมานที่ซับซ้อน

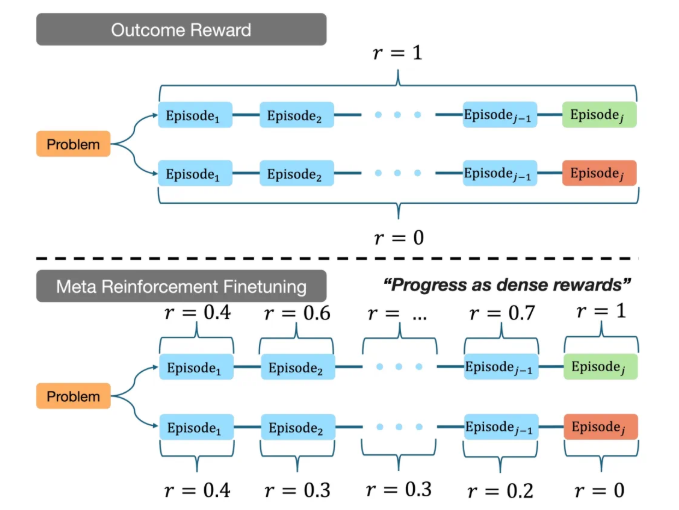

การวิจัยแสดงให้เห็นว่าแบบจำลองภาษาขนาดใหญ่ที่มีอยู่มักจะใช้ทรัพยากรการคำนวณจำนวนมากในระหว่างกระบวนการอนุมานในขณะที่เป้าหมายของ MRT คือการช่วยให้แบบจำลองค้นหาคำตอบได้อย่างมีประสิทธิภาพมากขึ้นภายในงบประมาณการคำนวณที่ จำกัด วิธีนี้ได้รับความสมดุลระหว่างการสำรวจและการใช้งานโดยการแบ่งส่วนผลลัพธ์ของแบบจำลองภาษาขนาดใหญ่เป็นหลายชิ้น ด้วยการวิเคราะห์ข้อมูลเชิงลึกของข้อมูลการฝึกอบรม MRT ช่วยให้แบบจำลองใช้ประโยชน์จากข้อมูลที่รู้จักอย่างเต็มที่เมื่อเผชิญกับปัญหาที่ไม่รู้จักและสำรวจกลยุทธ์การแก้ปัญหาใหม่

ในการทดลองของทีม CMU รุ่นปรับแต่งโดยใช้ MRT ดำเนินการอย่างยอดเยี่ยมในการเปรียบเทียบการอนุมานหลายครั้ง เมื่อเปรียบเทียบกับผลลัพธ์การเรียนรู้การเสริมแรงแบบดั้งเดิม (GRPO) ความแม่นยำของ MRT นั้นสูงขึ้น 2 ถึง 3 เท่าในขณะที่ประสิทธิภาพการใช้โทเค็นสูงขึ้น 1.5 เท่า ผลลัพธ์นี้แสดงให้เห็นว่า MRT ไม่เพียง แต่สามารถเพิ่มความสามารถในการอนุมานของแบบจำลอง แต่ยังช่วยลดการใช้ทรัพยากรการคำนวณอย่างมีนัยสำคัญทำให้สามารถแข่งขันได้มากขึ้นในการใช้งานจริง

นอกจากนี้ทีมวิจัยยังเสนอวิธีการเพื่อประเมินประสิทธิภาพของแบบจำลองการอนุมานที่มีอยู่อย่างมีประสิทธิภาพซึ่งให้การอ้างอิงที่สำคัญสำหรับการวิจัยในอนาคต ความสำเร็จนี้ไม่เพียง แต่แสดงให้เห็นถึงศักยภาพของ MRT เท่านั้น แต่ยังชี้ให้เห็นถึงทิศทางสำหรับการพัฒนาแบบจำลองภาษาขนาดใหญ่ในสถานการณ์แอปพลิเคชันที่ซับซ้อนยิ่งขึ้น

ด้วยนวัตกรรมนี้ทีมวิจัยที่ CMU และ HuggingFace ได้ก้าวเข้าสู่ขั้นตอนสำคัญในการส่งเสริมเทคโนโลยีปัญญาประดิษฐ์ที่ทันสมัยเสริมพลังเครื่องจักรด้วยความสามารถในการให้เหตุผลที่แข็งแกร่งและการวางรากฐานที่มั่นคงสำหรับการใช้งานที่ชาญฉลาดในอนาคต

ที่อยู่โครงการ: https://cohenqu.github.io/mrt.github.io/