في مجال الذكاء الاصطناعي ، يتغير تطوير نماذج اللغة الكبيرة (LLM) مع كل يوم يمر. اقترح فريق الأبحاث في جامعة كارنيجي ميلون (CMU) و Huggingface مؤخرًا نهجًا مبتكرًا يسمى "صياغة التعزيز الفوقية" (MRT). تهدف هذه التقنية إلى تحسين الكفاءة الحسابية لنماذج اللغة الكبيرة خلال مرحلة الاختبار ، خاصة عند التعامل مع مهام الاستدلال المعقدة.

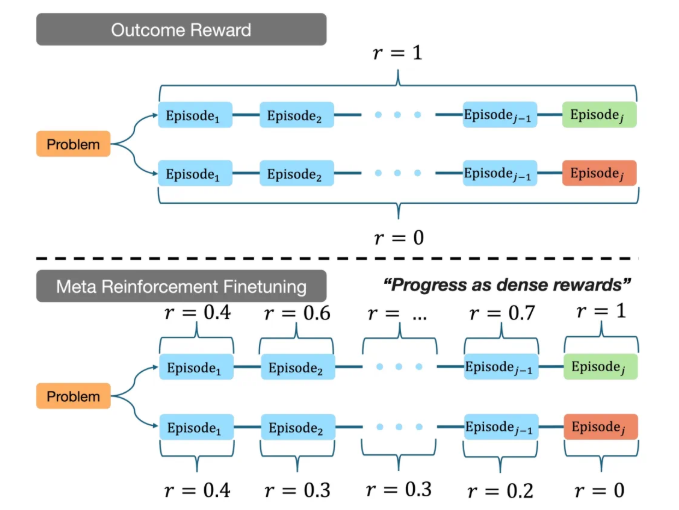

تظهر الأبحاث أن نماذج اللغة الكبيرة الحالية تستهلك غالبًا الكثير من موارد الحوسبة أثناء عملية الاستدلال ، في حين أن هدف MRT هو مساعدة النموذج في العثور على إجابات أكثر كفاءة ضمن ميزانية حوسبة محدودة. تحقق هذه الطريقة توازنًا بين الاستكشاف والاستخدام عن طريق تقسيم ناتج نموذج اللغة الكبير إلى شظايا متعددة. من خلال التحليل المتعمق لبيانات التدريب ، يمكّن MRT النموذج من الاستفادة الكاملة من المعلومات المعروفة عند مواجهة مشاكل غير معروفة ، واستكشاف استراتيجيات جديدة لحل المشكلات.

في تجارب فريق CMU ، قام النموذج الذي تم ضبطه باستخدام MRT بشكل ممتاز في معايير الاستدلال المتعددة. بالمقارنة مع النتائج التقليدية ، فإن تعلم تعزيز التعزيز (GRPO) ، فإن دقة MRT أعلى من مرتين إلى 3 مرات ، بينما أعلى 1.5 مرة في كفاءة استخدام الرمز المميز. توضح هذه النتيجة أن MRT لا يمكن أن تعزز فقط قدرة الاستدلال للنموذج ، ولكن أيضًا تقلل بشكل كبير من استهلاك موارد الحوسبة ، مما يجعله أكثر تنافسية في التطبيقات العملية.

بالإضافة إلى ذلك ، اقترح فريق البحث أيضًا طرقًا لتقييم أداء نماذج الاستدلال الحالية بشكل فعال ، مما يوفر مرجعًا مهمًا للبحث في المستقبل. لا يوضح هذا الإنجاز إمكانات MRT فحسب ، بل يشير أيضًا إلى اتجاه تطوير نماذج اللغة الكبيرة في سيناريوهات التطبيق الأكثر تعقيدًا.

من خلال هذا الابتكار ، اتخذ فريق الأبحاث في CMU و Huggingface خطوة مهمة في تعزيز مجال التكنولوجيا الذكية الاصطناعية المتطورة ، وتمكين الآلات ذات القدرات القوية للتفكير ووضع أساس قوي للتطبيقات الأكثر ذكاءً في المستقبل.

عنوان المشروع: https://cohenqu.github.io/mrt.github.io/