随着大语言模型的广泛应用,如何在资源受限的环境中实现高效部署成为了当前的重要课题。为了解决这一挑战,基于Qwen2.5的轻量化大模型系列DistilQwen2.5正式发布。该模型采用了创新的双层蒸馏框架,通过优化数据和参数融合技术,不仅保留了模型的性能,还显着降低了计算资源的消耗。这一突破为在资源有限的环境中部署大语言模型提供了新的可能性。

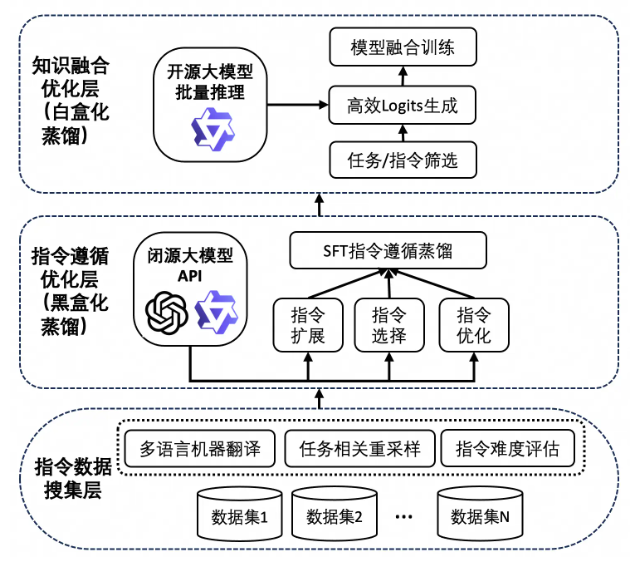

DistilQwen2.5的成功离不开其独特的知识蒸馏技术。这一过程首先依赖于大量高质量的指令数据,这些数据来自多个开源数据集及私有合成数据集。为了确保数据的多样性,研究团队通过Qwen-max扩展了中英文数据,从而实现了任务和语言的均衡。随后,模型通过“黑盒化蒸馏”的方式,利用教师模型的输出进行指令的扩展、选择与改写。这种方法不仅提升了数据的质量,还增强了模型的多任务处理能力,使其在复杂场景中表现更加出色。

值得一提的是,DistilQwen2.5还引入了白盒化蒸馏技术,通过模仿教师模型的its分布,使得学生模型在知识获取上更为高效。这种技术有效避免了传统白盒化蒸馏面临的GPU内存消耗、存储与读取速度慢等问题,进一步提升了模型的训练效率和性能表现。

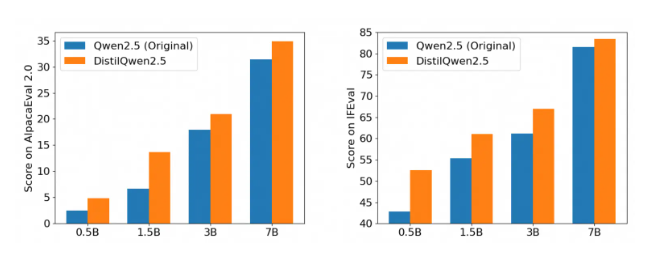

经过多个权威指令遵循评测基准的测试,DistilQwen2.5的表现令人瞩目,尤其是在AlpacaEval2.0和MT-Bench的评测中表现优异。这标志着轻量化大语言模型的发展进入了一个新的阶段,能够在保证性能的前提下,大幅降低计算成本,进一步推动了AI技术在各种应用场景中的落地。无论是企业级应用还是个人开发者,DistilQwen2.5都为其提供了强大的支持。

DistilQwen2.5的开源发布也为更多开发者提供了便利,使他们能够更轻松地使用这一强大的工具,为人工智能技术的普及贡献力量。通过开源,研究团队希望与全球开发者共同推动大语言模型技术的发展,探索更多创新应用场景,为AI的未来注入更多活力。