大規模な言語モデルの広範なアプリケーションにより、リソース制約の環境で効率的な展開を実現する方法が現在重要なトピックになりました。この課題を解決するために、QWEN2.5に基づいた軽量のビッグモデルシリーズDistilQWen2.5が公式にリリースされました。このモデルは、データとパラメーター融合技術を最適化する革新的な二重層蒸留フレームワークを採用し、モデルのパフォーマンスを保持するだけでなく、コンピューティングリソースの消費を大幅に削減します。このブレークスルーは、リソースに制約のある環境で大規模な言語モデルを展開するための新しい可能性を提供します。

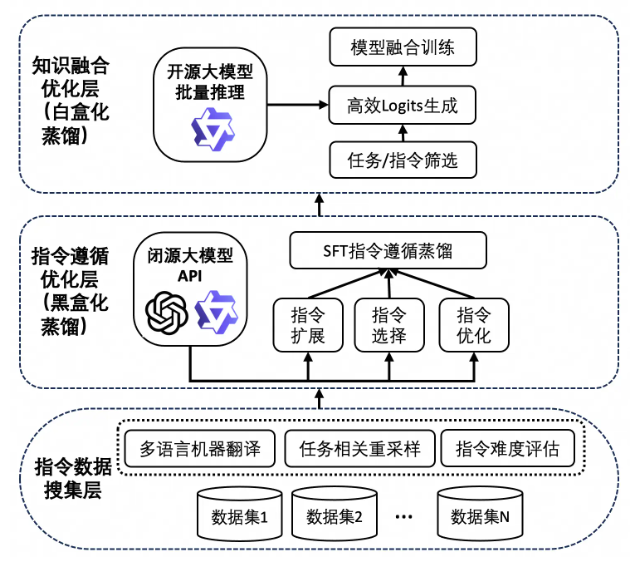

Distilqwen2.5の成功は、独自の知識蒸留技術と切り離せないものです。このプロセスは、最初に、複数のオープンソースデータセットとプライベート合成データセットに由来する多数の高品質の命令データに依存しています。データの多様性を確保するために、研究チームはQwen-Maxを通じて中国と英語のデータを拡大し、タスクと言語のバランスを達成しました。その後、モデルは教師モデルの出力を使用して、「ブラックボックスの蒸留」を介して命令を拡張、選択、書き換えます。このアプローチは、データの品質を向上させるだけでなく、モデルのマルチタスク機能を強化し、複雑なシナリオでパフォーマンスを向上させます。

Distilqwen2.5は、教師モデルの分布を模倣する白いボックス蒸留技術も導入し、学生モデルが知識を得るのにより効率的にすることに言及する価値があります。このテクノロジーは、GPUメモリの消費の問題、従来の白い箱の蒸留が直面している速度の低速速度、読み取り速度の問題を効果的に回避し、モデルのトレーニング効率とパフォーマンスをさらに向上させます。

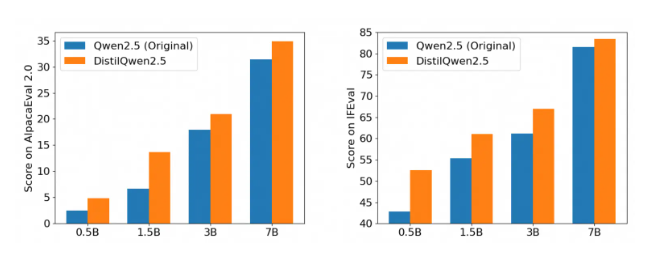

評価ベンチマークに従うための複数の権威ある指示の後、特にAlpacaeval2.0およびMTベンチの評価では、Distilqwen2.5のパフォーマンスが印象的です。これは、軽量の大型言語モデルの開発における新しい段階のエントリをマークします。これにより、コンピューティングコストを大幅に削減しながらパフォーマンスを確保し、さまざまなアプリケーションシナリオでAIテクノロジーの実装をさらに促進できます。エンタープライズレベルのアプリケーションであろうと個々の開発者であろうと、DistilQWen2.5はそれを強力にサポートします。

DistilQwen2.5のオープンソースリリースは、より多くの開発者に利便性を提供し、この強力なツールをより簡単に使用し、人工知能技術の普及に貢献できるようにします。オープンソースを通じて、研究チームはグローバルな開発者と協力して、大規模な言語モデルテクノロジーの開発を促進し、より革新的なアプリケーションシナリオを探求し、AIの未来により多くの活力を注入したいと考えています。