Dengan aplikasi yang meluas dari model bahasa besar, bagaimana mencapai penyebaran yang efisien di lingkungan yang dibatasi sumber daya telah menjadi topik penting saat ini. Untuk menyelesaikan tantangan ini, serial besar model besar distilqwen2.5 berdasarkan QWEN2.5 secara resmi dirilis. Model ini mengadopsi kerangka distilasi lapisan ganda yang inovatif yang mengoptimalkan data dan teknik fusi parameter tidak hanya mempertahankan kinerja model, tetapi juga secara signifikan mengurangi konsumsi sumber daya komputasi. Terobosan ini memberikan kemungkinan baru untuk menggunakan model bahasa besar di lingkungan yang dibatasi sumber daya.

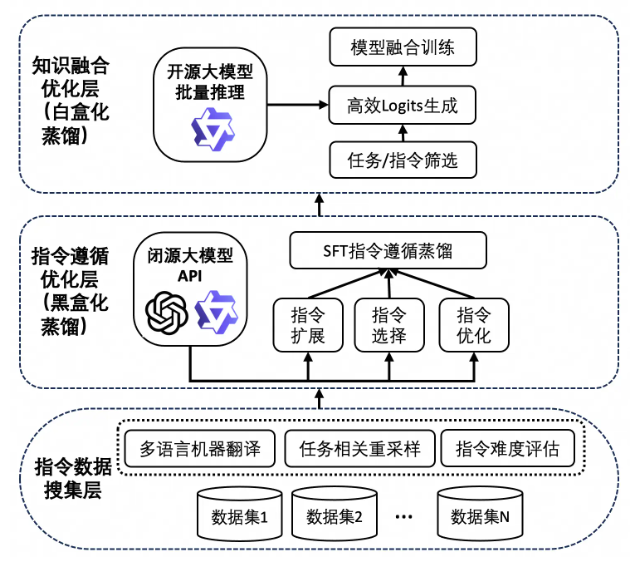

Keberhasilan distilqwen2.5 tidak dapat dipisahkan dari teknologi distilasi pengetahuannya yang unik. Proses ini pertama-tama bergantung pada sejumlah besar data instruksi berkualitas tinggi, yang berasal dari beberapa set data open source dan set data sintetis pribadi. Untuk memastikan keragaman data, tim peneliti memperluas data Cina dan Inggris melalui Qwen-Max, sehingga mencapai keseimbangan tugas dan bahasa. Selanjutnya, model menggunakan output model guru untuk memperluas, memilih dan menulis ulang instruksi melalui "Distilasi Kotak Hitam". Pendekatan ini tidak hanya meningkatkan kualitas data, tetapi juga meningkatkan kemampuan multitasking model, membuatnya berkinerja lebih baik dalam skenario kompleks.

Perlu disebutkan bahwa distilqwen2.5 juga memperkenalkan teknologi distilasi kotak putih, yang meniru distribusi model guru, membuat model siswa lebih efisien dalam memperoleh pengetahuan. Teknologi ini secara efektif menghindari masalah konsumsi memori GPU, kecepatan penyimpanan yang lambat dan kecepatan membaca yang dihadapi oleh distilasi kotak putih tradisional, dan selanjutnya meningkatkan efisiensi pelatihan dan kinerja model.

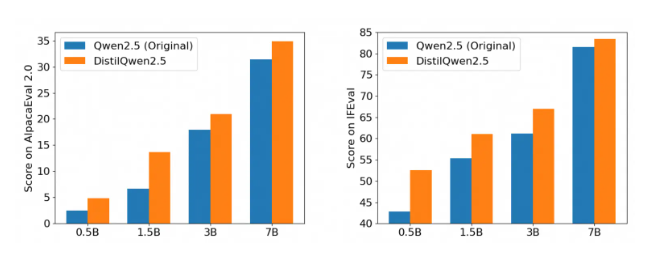

Setelah beberapa instruksi otoritatif untuk mengikuti tolok ukur evaluasi, kinerja Distilqwen2.5 sangat mengesankan, terutama dalam evaluasi Alpacaeval2.0 dan MT-Bench. Ini menandai masuknya tahap baru dalam pengembangan model bahasa besar yang ringan, yang secara signifikan dapat mengurangi biaya komputasi sambil memastikan kinerja, dan lebih lanjut mempromosikan implementasi teknologi AI dalam berbagai skenario aplikasi. Apakah itu aplikasi tingkat perusahaan atau pengembang individu, distilqwen2.5 memberikan dukungan yang kuat untuk itu.

Rilis open source dari distilqwen2.5 juga memberikan kenyamanan bagi lebih banyak pengembang, memungkinkan mereka untuk menggunakan alat yang kuat ini dengan lebih mudah dan berkontribusi pada mempopulerkan teknologi kecerdasan buatan. Melalui Open Source, tim peneliti berharap untuk bekerja dengan pengembang global untuk mempromosikan pengembangan teknologi model bahasa besar, mengeksplorasi skenario aplikasi yang lebih inovatif, dan menyuntikkan lebih banyak vitalitas ke masa depan AI.