Avec l'application généralisée de modèles de grandes langues, comment réaliser un déploiement efficace dans des environnements liés aux ressources est devenu un sujet important à l'heure actuelle. Pour résoudre ce défi, la série Lightweight Big Model Distilqwen2.5 basée sur QWEN2.5 a été officiellement publiée. Le modèle adopte un cadre de distillation à double couche innovant qui optimise les techniques de fusion des données et des paramètres préserve non seulement les performances du modèle, mais réduit également considérablement la consommation de ressources informatiques. Cette percée offre de nouvelles possibilités de déploiement de modèles de langue importants dans des environnements liés aux ressources.

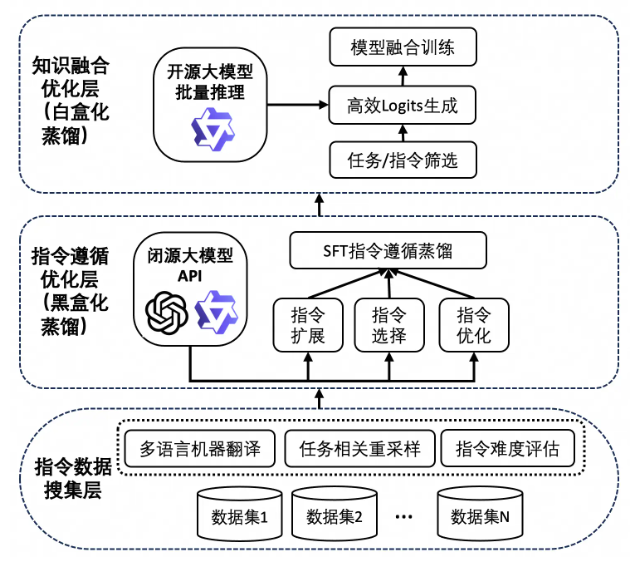

Le succès de Distilqwen2.5 est inséparable de sa technologie de distillation de connaissances unique. Ce processus repose d'abord sur un grand nombre de données d'instructions de haute qualité, qui proviennent de plusieurs ensembles de données open source et des ensembles de données synthétiques privés. Pour assurer la diversité des données, l'équipe de recherche a élargi les données chinoises et anglaises via QWEN-MAX, atteignant ainsi l'équilibre des tâches et des langues. Par la suite, le modèle utilise la sortie du modèle enseignant pour étendre, sélectionner et réécrire les instructions via "Distillation de la boîte noire". Cette approche améliore non seulement la qualité des données, mais améliore également la capacité multitâche du modèle, ce qui le rend meilleur dans des scénarios complexes.

Il convient de mentionner que Distilqwen2.5 introduit également la technologie de distillation de la boîte blanche, qui imite la distribution ITS du modèle des enseignants, rend le modèle étudiant plus efficace pour obtenir des connaissances. Cette technologie évite efficacement les problèmes de consommation de mémoire GPU, les vitesses de stockage et de lecture lentes confrontées à la distillation traditionnelle de la boîte blanche, et améliore encore l'efficacité de la formation et les performances du modèle.

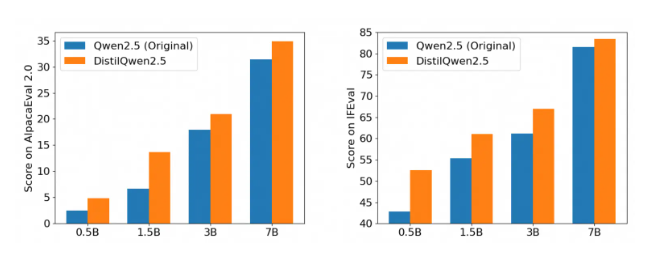

Après plusieurs instructions faisant autorité pour suivre les repères d'évaluation, les performances de Distilqwen2.5 sont impressionnantes, en particulier dans les évaluations alpacaeval2.0 et mt-bench. Cela marque l'entrée d'une nouvelle étape dans le développement de modèles légers de grande langue, ce qui peut réduire considérablement les coûts informatiques tout en garantissant les performances et favoriser davantage la mise en œuvre de la technologie d'IA dans divers scénarios d'application. Qu'il s'agisse d'une application de niveau d'entreprise ou d'un développeur individuel, Distilqwen2.5 en fournit un solide support.

La sortie open source de Distilqwen2.5 assure également la commodité à plus de développeurs, ce qui leur permet d'utiliser plus facilement cet outil puissant et de contribuer à la popularisation de la technologie de l'intelligence artificielle. Grâce à l'open source, l'équipe de recherche espère travailler avec des développeurs mondiaux pour promouvoir le développement d'une technologie de modèle de grande langue, explorer des scénarios d'application plus innovants et injecter plus de vitalité dans l'avenir de l'IA.