Com a aplicação generalizada de grandes modelos de idiomas, como obter uma implantação eficiente em ambientes com restrição de recursos se tornou um tópico importante no momento. Para resolver esse desafio, a grande série de modelos leves Distilqwen2.5 com base no QWEN2.5 foi lançada oficialmente. O modelo adota uma estrutura inovadora de destilação de camada dupla que otimiza as técnicas de fusão de dados e parâmetros não apenas preserva o desempenho do modelo, mas também reduz significativamente o consumo de recursos de computação. Esse avanço fornece novas possibilidades para implantar grandes modelos de idiomas em ambientes com restrição de recursos.

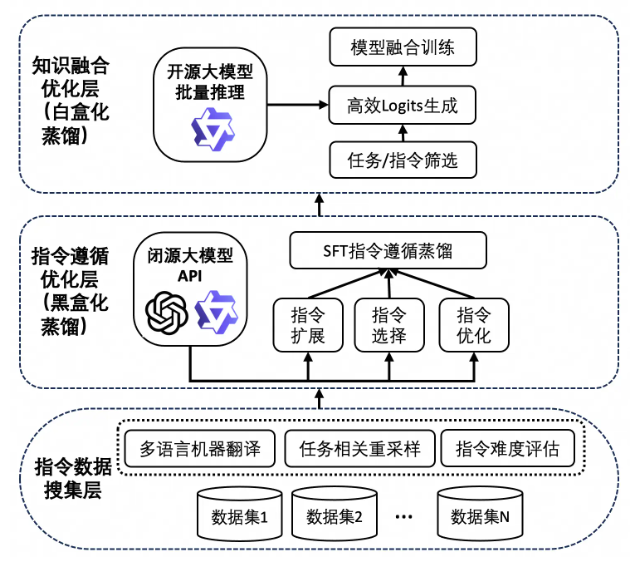

O sucesso da Distilqwen2.5 é inseparável de sua tecnologia exclusiva de destilação de conhecimento. Esse processo primeiro se baseia em um grande número de dados de instruções de alta qualidade, provenientes de vários conjuntos de dados de código aberto e conjuntos de dados sintéticos privados. Para garantir a diversidade de dados, a equipe de pesquisa expandiu os dados chineses e ingleses através de Qwen-Max, alcançando o equilíbrio de tarefas e idiomas. Posteriormente, o modelo usa a saída do modelo do professor para expandir, selecionar e reescrever instruções através da "Destilação da caixa preta". Essa abordagem não apenas melhora a qualidade dos dados, mas também aprimora a capacidade multitarefa do modelo, fazendo com que ele tenha um desempenho melhor em cenários complexos.

Vale ressaltar que o Distilqwen2.5 também apresenta a tecnologia de destilação de caixas brancas, que imita a sua distribuição do modelo de professor, torna o modelo do aluno mais eficiente na obtenção de conhecimento. Essa tecnologia evita efetivamente os problemas do consumo de memória da GPU, o armazenamento lento e as velocidades de leitura enfrentadas pela destilação tradicional de caixa branca e melhora ainda mais a eficiência do treinamento e o desempenho do modelo.

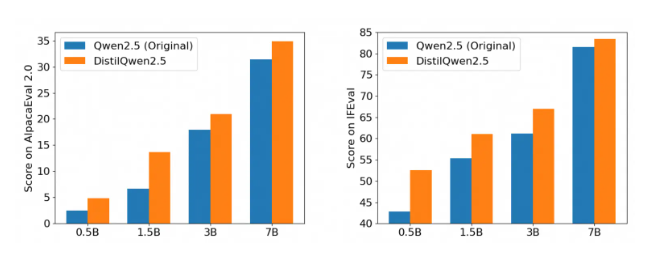

Após várias instruções autorizadas para seguir os benchmarks de avaliação, o desempenho do Distilqwen2.5 é impressionante, especialmente nas avaliações AlpacaEval2.0 e MT-Bench. Isso marca a entrada de um novo estágio no desenvolvimento de grandes modelos de idiomas leves, o que pode reduzir significativamente os custos de computação, garantindo o desempenho e promover ainda mais a implementação da tecnologia de IA em vários cenários de aplicação. Seja um aplicativo de nível corporativo ou um desenvolvedor individual, o Distilqwen2.5 fornece um forte suporte para ele.

A liberação de código aberto do Distilqwen2.5 também fornece conveniência para mais desenvolvedores, permitindo que eles usem essa ferramenta poderosa com mais facilidade e contribua para a popularização da tecnologia de inteligência artificial. Através de código aberto, a equipe de pesquisa espera trabalhar com desenvolvedores globais para promover o desenvolvimento de uma grande tecnologia de modelos de idiomas, explorar cenários de aplicativos mais inovadores e injetar mais vitalidade no futuro da IA.