Благодаря широкому применению моделей крупных языков, как достичь эффективного развертывания в условиях, ограниченных ресурсами, стало важной темой в настоящее время. Чтобы решить эту проблему, была официально выпущена легкая серия Big Model Series Distilqwen2.5 на основе QWEN2.5. Модель принимает инновационную структуру двухслойного перегонки, которая оптимизирует методы слияния данных и параметров не только сохраняет производительность модели, но и значительно снижает потребление вычислительных ресурсов. Этот прорыв предоставляет новые возможности для развертывания крупных языковых моделей в условиях ограниченных ресурсов.

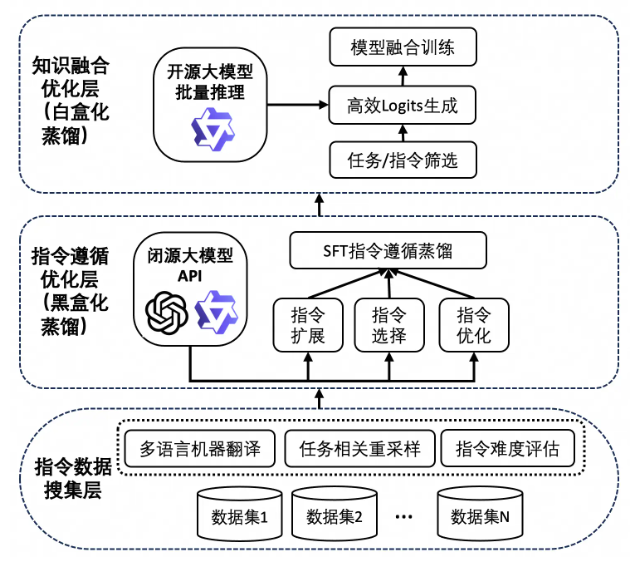

Успех Distilqwen2.5 неотделим от своей уникальной технологии дистилляции знаний. Этот процесс сначала опирается на большое количество высококачественных данных инструкций, которые поступают из нескольких наборов данных с открытым исходным кодом и частных наборов синтетических данных. Чтобы обеспечить разнообразие данных, исследовательская группа расширила данные о китайском и английском языке через QWEN-MAX, таким образом достигнув задачи и языкового баланса. Впоследствии модель использует вывод модели учителя для расширения, выбора и переписывания инструкций с помощью «черного ящика дистилляции». Этот подход не только улучшает качество данных, но и повышает многозадачные возможности модели, что делает его лучше в сложных сценариях.

Стоит отметить, что DistilQwen2.5 также представляет технологию дистилляции белой коробки, которая имитирует ее распределение модели учителя, делает модель студента более эффективной в получении знаний. Эта технология эффективно избегает проблем потребления памяти графических процессоров, медленного хранения и скорости чтения, с которыми сталкиваются традиционная белая бокс -дистилляция, и еще больше повышает эффективность обучения и производительность модели.

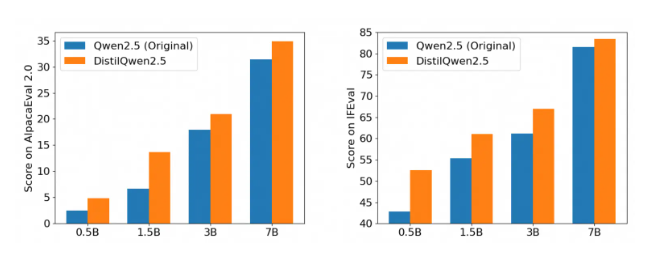

После многочисленных авторитетных инструкций следовать критериям оценки, производительность Distilqwen2.5 впечатляет, особенно в оценках Alpacaeval2.0 и Mt-Bench. Это знаменует собой запись нового этапа в разработке легких моделей крупных языков, которые могут значительно снизить вычислительные затраты при одновременном обеспечении производительности, и еще больше способствовать реализации технологии ИИ в различных сценариях применения. Будь то приложение на уровне предприятия или индивидуальный разработчик, Distilqwen2.5 обеспечивает его сильную поддержку.

Выпуск DistilQwen2.5 с открытым исходным кодом также обеспечивает удобство для большего количества разработчиков, что позволяет им легче использовать этот мощный инструмент и способствует популяризации технологий искусственного интеллекта. Через открытый исходный код исследовательская группа надеется поработать с глобальными разработчиками, чтобы способствовать развитию технологий крупных языковых моделей, изучения более инновационных сценариев применения и внедрить большую жизненную силу в будущее ИИ.