南京大学与旷视研究院合作研发了一种名为SeVa的无监督视觉大模型范式,有效解决了视觉语言模型的偏好对齐难题。这项突破性技术无需人工或GPT-4参与,通过自动化构造偏好数据,显着降低了对齐成本,并提升了模型的指令遵循能力、降低了幻觉,在多个基准测试中取得了显著成果。 SeVa的核心在于利用图像增广技术生成正负样本,并以此训练模型,最终实现了对人类偏好的有效对齐。

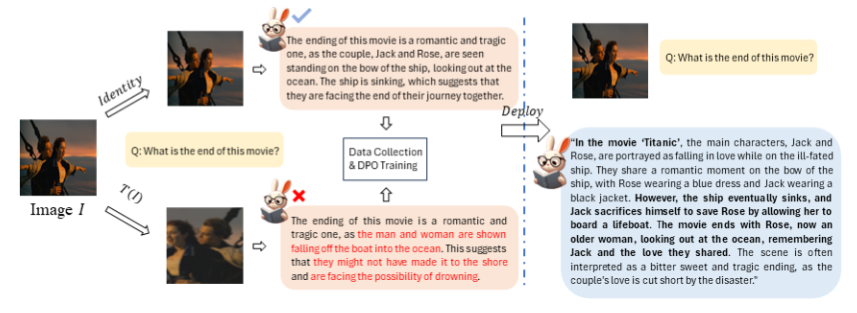

这项技术的核心在于自动化构造偏好数据的pipeline,通过对比偏好对齐前后的模型输出,可以明显看出变化。研究人员们发现,即使是微小的图像增广,也可能让VLM对同一问题产生不同的回答。因此,他们将原始图像的回答作为正样本,增广后的图像回答作为负样本,用于训练。

SeVa的实验结果令人瞩目。仅使用8k构造的无监督数据,就显着提升了VLM的指令遵循能力,降低了幻觉,并在多模态等benchmark上取得了明显提升。更重要的是,这种方法简单易行,成本低廉,不需要任何人类或GPT-4的标注。

在多个benchmark上的测试结果表明,SeVa在提升视觉模型的人类偏好对齐方面具有显着优势。特别是在GPT-4评估的MMVet和LLaVA-bench上,SeVa的表现尤为突出。此外,SeVa还能产生更长、更详细的回答,且每次回答的一致性更高,对不同temperature的扰动具有更强的鲁棒性。

这项研究不仅为视觉大模型的对齐问题提供了一种有效的解决方案,也为AI领域的发展开辟了新的可能性。随着SeVa的开源,我们可以预见,未来将有更多的研究者和开发者利用这一范式,推动AI技术的进一步发展。在这个充满无限可能的时代,让我们共同期待AI技术带来的更多惊喜。

项目地址:https://github.com/Kevinz-code/SeVa

SeVa的开源将推动视觉大模型技术的发展,为研究者和开发者提供新的工具和方法,进一步提升视觉AI的性能和应用。这项研究的成功,展现了无监督学习在解决AI对齐问题上的巨大潜力,为未来AI技术发展指明了新的方向。