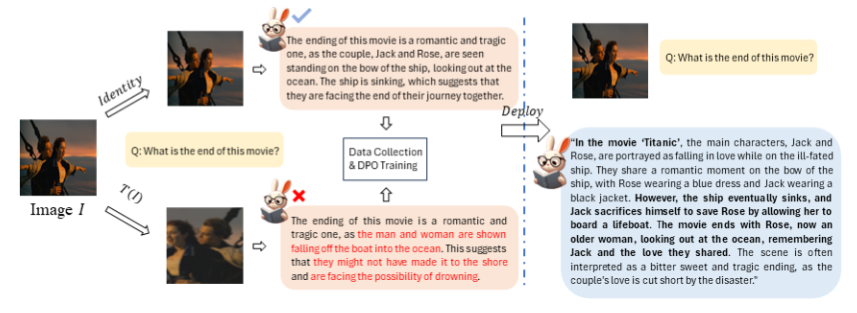

南京大学と Megvii Research Institute は協力して、視覚言語モデルの好みの調整の問題を効果的に解決する、SeVa と呼ばれる教師なし視覚大規模モデル パラダイムを開発しました。この画期的なテクノロジーは、手動または GPT-4 への参加を必要とせず、優先データを自動的に構築することで調整コストを大幅に削減し、モデルの命令追従能力を向上させ、幻覚を軽減し、複数のベンチマーク テストで顕著な結果を達成しました。 SeVa の中核は、画像拡張テクノロジーを使用してポジティブサンプルとネガティブサンプルを生成し、これをモデルのトレーニングに使用して、最終的に人間の好みの効果的な調整を達成することです。

このテクノロジーの核心は、嗜好データのパイプラインを自動的に構築することであり、嗜好の調整前後のモデル出力を比較することで、変化を明確に確認できます。研究者らは、たとえ小さな画像拡張であっても、同じ質問に対して VLM が異なる答えを与える可能性があることを発見しました。したがって、元の画像の回答をポジティブ サンプルとして使用し、拡張された画像の回答をネガティブ サンプルとしてトレーニングに使用しました。

SeVa の実験結果は印象的です。 8K で構築された教師なしデータのみを使用することで、VLM の命令追従能力が大幅に向上し、幻覚が減少し、マルチモーダルおよびその他のベンチマークで大幅な改善が達成されました。さらに重要なのは、この方法はシンプルで低コストであり、人による注釈や GPT-4 アノテーションを必要としないことです。

複数のベンチマークのテスト結果は、視覚モデルの人間の好みの調整を改善する上で SeVa が大きな利点を持っていることを示しています。特に GPT-4 によって評価された MMVet および LLaVA ベンチでは、SeVa のパフォーマンスは特に優れています。さらに、SeVa は、各回答の一貫性が高く、より長く詳細な回答を生成することもでき、さまざまな温度の摂動に対してより堅牢です。

この研究は、大規模なビジュアルモデルの位置合わせ問題に対する効果的な解決策を提供するだけでなく、AI 分野の発展に新たな可能性を切り開きます。 SeVa のオープンソースにより、今後より多くの研究者や開発者がこのパラダイムを利用して AI テクノロジーのさらなる開発を促進すると予測できます。無限の可能性に満ちたこの時代、AI技術がもたらす更なる驚きに期待しましょう。

プロジェクトアドレス: https://github.com/Kevinz-code/SeVa

SeVa のオープンソースは、ビジュアルラージモデルテクノロジーの開発を促進し、研究者と開発者に新しいツールと手法を提供し、ビジュアル AI のパフォーマンスとアプリケーションをさらに向上させます。この研究の成功は、AI アライメント問題の解決における教師なし学習の大きな可能性を実証し、AI テクノロジーの将来の開発に新たな方向性を示しました。