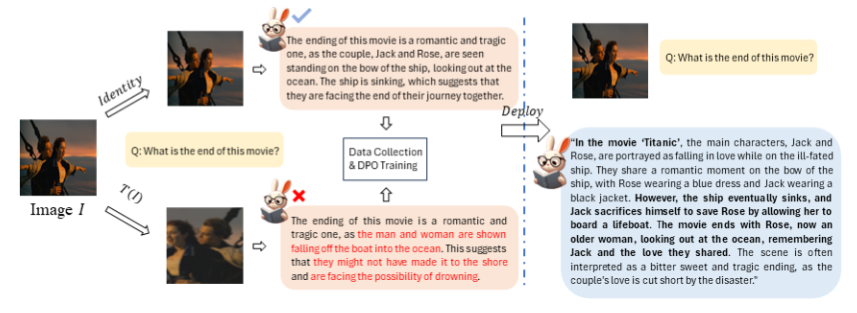

Die Universität Nanjing und das Megvii-Forschungsinstitut haben gemeinsam ein unbeaufsichtigtes visuelles Großmodell-Paradigma namens SeVa entwickelt, das das Problem der Präferenzausrichtung visueller Sprachmodelle effektiv löst. Diese bahnbrechende Technologie erfordert keine manuelle oder GPT-4-Teilnahme. Sie reduziert die Ausrichtungskosten durch die automatische Erstellung von Präferenzdaten erheblich, verbessert die Fähigkeit des Modells, Anweisungen zu folgen, reduziert Halluzinationen und hat in mehreren Benchmark-Tests bemerkenswerte Ergebnisse erzielt. Der Kern von SeVa besteht darin, mithilfe der Bildvergrößerungstechnologie positive und negative Proben zu generieren und diese zum Trainieren des Modells zu nutzen, um letztendlich eine effektive Ausrichtung menschlicher Präferenzen zu erreichen.

Der Kern dieser Technologie besteht darin, automatisch eine Pipeline von Präferenzdaten zu erstellen. Durch den Vergleich der Modellausgabe vor und nach der Präferenzausrichtung können Änderungen deutlich erkannt werden. Die Forscher fanden heraus, dass selbst kleine Bildvergrößerungen VLM unterschiedliche Antworten auf dieselbe Frage geben könnten. Daher verwendeten sie die ursprünglichen Bildantworten als positive Stichproben und die erweiterten Bildantworten als negative Stichproben für das Training.

Die experimentellen Ergebnisse von SeVa sind beeindruckend. Die Verwendung von nur 8.000 konstruierten, unbeaufsichtigten Daten hat die Fähigkeit von VLM zur Befehlsfolge erheblich verbessert, Halluzinationen reduziert und erhebliche Verbesserungen bei multimodalen und anderen Benchmarks erzielt. Noch wichtiger ist, dass diese Methode einfach und kostengünstig ist und keine menschlichen oder GPT-4-Annotationen erfordert.

Testergebnisse mehrerer Benchmarks zeigen, dass SeVa erhebliche Vorteile bei der Verbesserung der menschlichen Präferenzausrichtung visueller Modelle bietet. Insbesondere auf dem von GPT-4 bewerteten MMVet- und LLaVA-Bench ist die Leistung von SeVa besonders herausragend. Darüber hinaus kann SeVa auch längere und detailliertere Antworten mit höherer Konsistenz bei jeder Antwort liefern und ist robuster gegenüber Störungen durch unterschiedliche Temperaturen.

Diese Forschung bietet nicht nur eine wirksame Lösung für das Ausrichtungsproblem großer visueller Modelle, sondern eröffnet auch neue Möglichkeiten für die Entwicklung des KI-Bereichs. Mit der Open Source von SeVa können wir davon ausgehen, dass in Zukunft mehr Forscher und Entwickler dieses Paradigma nutzen werden, um die Weiterentwicklung der KI-Technologie voranzutreiben. Freuen wir uns in dieser Zeit voller unendlicher Möglichkeiten auf weitere Überraschungen, die die KI-Technologie mit sich bringt.

Projektadresse: https://github.com/Kevinz-code/SeVa

Die Open Source von SeVa wird die Entwicklung der visuellen Großmodelltechnologie vorantreiben, Forschern und Entwicklern neue Werkzeuge und Methoden zur Verfügung stellen und die Leistung und Anwendung visueller KI weiter verbessern. Der Erfolg dieser Forschung zeigt das große Potenzial des unbeaufsichtigten Lernens bei der Lösung von KI-Ausrichtungsproblemen und zeigt eine neue Richtung für die zukünftige Entwicklung der KI-Technologie auf.