该COLAB笔记本提供了逐步指南,以通过将声音克隆到视频上来生成Deepfake视频。该过程涉及上传视频和语音文件,重命名,提取音频,创建音频块以及最终使用Wav2lip进行DeepFake生成。

在执行此笔记本之前,我们需要在Google Drive中使用至少一个视频文件(MP4格式)的Google Drive中有一个deepfake夹。强烈建议还包括一个音频(mp3格式)文件以克隆声音。特别是对于视频中非英语语言的情况,也必须上传英文音频文件。

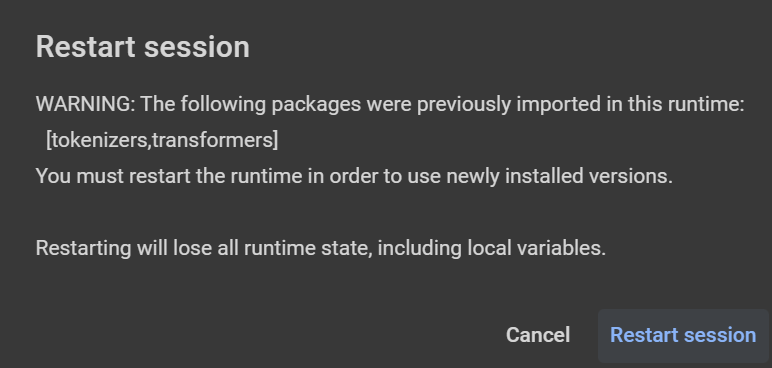

注意:文本提示应与“ |”分开每一到两个句子(每〜20秒读取它)。如果您提出任何警告并建议重新启动会话(安装库后 - 例如Libersa,如下图所示),请单击“取消”。在免费版本(带15GB VRAM和〜13GB RAM的T4或V100)中,最大音频/视频持续时间可以约为50秒(需要约30分钟的时间来运行脚本并获得结果)。对于更长的文本提示,需要更大的GPU(使用具有22.5GB VRAM的L4和〜63GB的RAM或A100的付费版本,带有40GB VRAM和〜84GB RAM-后者使用更多的计算单元/小时)。

from google . colab import drive

drive . mount ( '/content/gdrive' )

cd gdrive / MyDrive / deepfake指定视频和音频文件的基本路径。

base_path = '/content/gdrive/MyDrive/deepfake'安装TTS,Pydub和Monypy库。

!p ip install - q pydub == 0.25 . 1 TTS == 0.22 . 0 moviepy == 1.0 . 3设置将用克隆声音读取的英文文字。

text_to_read = "Joining two modalities results in a surprising increase in generalization! \ n What would happen if we combined them all? " 分别将上传的音频和视频文件重命名为input_voice.mp3和video_full.mp4 。

如果仅提供视频,请从中提取音频以克隆个人。

创建一个带有10秒钟的音频的文件夹,以用作乌龟的输入。

确保音频和视频的持续时间相同。如果不是,则修剪较短的一个(或将它们都切成20秒)匹配的较长的一个。

clone wav2lip github存储库,下载预训练的模型和安装依赖项。

运行WAV2LIP推理脚本以生成DeepFake视频。

删除临时文件和文件夹。