Este notebook Colab fornece um guia passo a passo para gerar um vídeo Deepfake clonando uma voz em um vídeo. O processo envolve o upload de arquivos de vídeo e voz, renomeá -los, extrair áudio, criar pedaços de áudio e finalmente usar o WAV2LIP para geração DeepFake.

Antes de executar este notebook, precisamos ter uma pasta em nosso Google Drive chamado deepfake com pelo menos um arquivo de vídeo (formato MP4). É altamente recomendável incluir também um arquivo de áudio (formato MP3) para clonar a voz. Especialmente para casos de idioma não inglês no vídeo, é essencial fazer upload de um arquivo de áudio em inglês também.

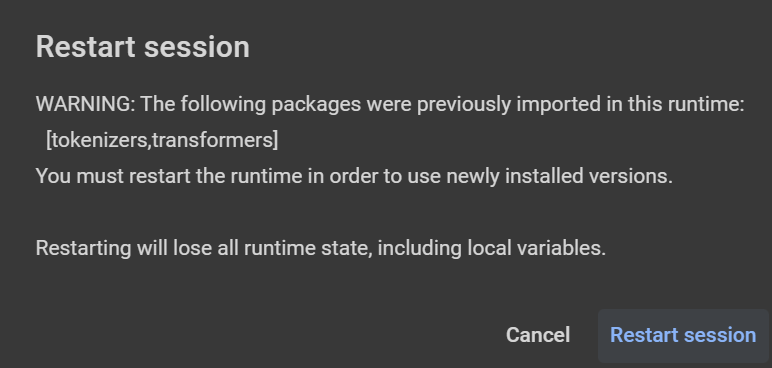

Cuidado: o prompt de texto deve ser separado com '|' Cada a duas frases (a cada ~ 20 segundos necessários para lê -lo). Se você receber algum aviso e reiniciar a sessão (após a instalação de uma biblioteca - por exemplo, Librosa, conforme mostrado na figura abaixo), clique em 'Cancelar'. Na versão gratuita (T4 ou V100 com VRAM de 15 GB e ~ 13 GB de RAM), a duração máxima de áudio/vídeo pode ser ~ 50 segundos (leva ~ 30mins para executar o script e obter resultados). Para um prompt de texto mais longo, é necessária uma GPU maior (versão paga usando L4 com VRAM de 22,5 GB e ~ 63 GB de RAM ou A100 com VRAM de 40 GB e ~ 84 GB de RAM - o último usa mais unidades de computação/hora).

from google . colab import drive

drive . mount ( '/content/gdrive' )

cd gdrive / MyDrive / deepfakeEspecifique o caminho base para arquivos de vídeo e áudio.

base_path = '/content/gdrive/MyDrive/deepfake'Instale as bibliotecas TTS, Pydub e Moviepy.

!p ip install - q pydub == 0.25 . 1 TTS == 0.22 . 0 moviepy == 1.0 . 3Defina o texto em inglês que será lido com a voz clonada.

text_to_read = "Joining two modalities results in a surprising increase in generalization! \ n What would happen if we combined them all? " Renomeie os arquivos de áudio e vídeo enviados para input_voice.mp3 e video_full.mp4 , respectivamente.

Se apenas um vídeo for fornecido, extraia áudio para ser usado para clonar o indivíduo.

Crie uma pasta com pedaços de áudio de 10 segundos para serem usados como entrada na tartaruga.

Verifique se o áudio e o vídeo têm a mesma duração. Caso contrário, apare o mais longo para corresponder ao mais curto (ou corte -os a 20 segundos).

CLONE WAV2LIP Github Repository, baixe modelos pré-treinados e instale dependências.

Execute o script de inferência WAV2LIP para gerar o vídeo Deepfake.

Remova arquivos e pastas temporárias.