Dieses Colab-Notizbuch bietet eine Schritt-für-Schritt-Anleitung, um ein DeepFake-Video zu generieren, indem eine Stimme auf ein Video kloniert. Der Prozess umfasst das Hochladen von Video- und Sprachdateien, das Umbenennen, das Extrahieren von Audio, das Erstellen von Audiobrocken und die Verwendung von WAV2LIP für die DeepFake -Generierung.

Bevor Sie dieses Notebook ausführen, müssen wir einen Ordner in unserem Google Drive namens deepfake mit mindestens eine Videodatei (MP4 -Format) haben. Es wird dringend empfohlen, auch eine Audio -Formatdatei (MP3 -Format) einzuschließen, um die Stimme aus zu klonen. Insbesondere für Fälle von nicht englischer Sprache im Video ist es wichtig, auch eine englische Audiodatei hochzuladen.

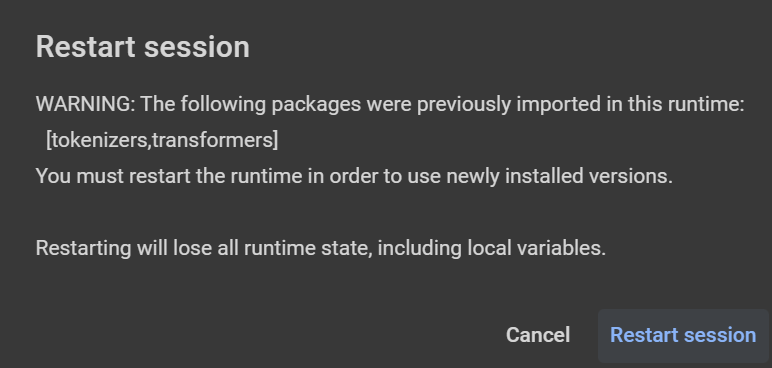

Achtung: Die Textaufforderung sollte mit '|' getrennt werden Jeder bis zwei Sätze (alle ~ 20 Sekunden, die es braucht, um es zu lesen). Wenn Sie Warnungen erhalten und eine Neustartsitzung vorgeschlagen werden (nach der Installation einer Bibliothek - z. B. Librosa, wie in der Abbildung unten gezeigt), klicken Sie auf "Abbrechen". In der kostenlosen Version (T4 oder V100 mit 15 GB VRAM und ~ 13 GB RAM) kann die maximale Audio-/Videodauer ~ 50 Sekunden betragen (dauert ~ 30 Minuten, um das Skript auszuführen und Ergebnisse zu erhalten). Für eine längere Textaufforderung wird eine größere GPU benötigt (bezahlte Version mit L4 mit 22,5 GB VRAM und ~ 63 GB RAM oder A100 mit 40 GB VRAM und ~ 84 GB RAM - letztere verwendet mehr Recheneinheiten/Stunde).

from google . colab import drive

drive . mount ( '/content/gdrive' )

cd gdrive / MyDrive / deepfakeGeben Sie den Basispfad für Video- und Audiodateien an.

base_path = '/content/gdrive/MyDrive/deepfake'Installieren Sie TTS-, Pydub- und Moviepy -Bibliotheken.

!p ip install - q pydub == 0.25 . 1 TTS == 0.22 . 0 moviepy == 1.0 . 3Legen Sie den englischen Text fest, der mit der geklonten Stimme gelesen wird.

text_to_read = "Joining two modalities results in a surprising increase in generalization! \ n What would happen if we combined them all? " Benennen Sie die hochgeladenen Audio- und Videodateien in input_voice.mp3 bzw. video_full.mp4 um.

Wenn nur ein Video bereitgestellt wird, extrahieren Sie Audio daraus, um das Individuum zu klonen.

Erstellen Sie einen Ordner mit 10-Sekunden-Audiobrocken, die als Eingabe in der Schildkröte verwendet werden sollen.

Stellen Sie sicher, dass Audio und Video die gleiche Dauer haben. Wenn nicht, abschneiden, je länger eine zu dem kürzeren entspricht (oder schneiden Sie sie beide auf 20 Sekunden).

Klon Wav2Lip Github-Repository, Herunterladen vor ausgebildete Modelle und installieren Sie Abhängigkeiten.

Führen Sie das WAV2LIP -Inferenzskript aus, um das DeepFake -Video zu generieren.

Entfernen Sie temporäre Dateien und Ordner.