Ce carnet Colab fournit un guide étape par étape pour générer une vidéo DeepFake en clonant une voix sur une vidéo. Le processus consiste à télécharger des fichiers vidéo et vocaux, de les renommer, d'extraire l'audio, de créer des morceaux audio et enfin d'utiliser wav2lip pour la génération DeepFake.

Avant d'exécuter ce cahier, nous devons avoir un dossier dans notre Google Drive nommé deepfake avec au moins un fichier vidéo (format MP4). Il est fortement recommandé d'inclure également un fichier audio (format MP3) pour cloner la voix. Surtout pour les cas de langue non anglophone dans la vidéo, il est également essentiel de télécharger un fichier audio anglais.

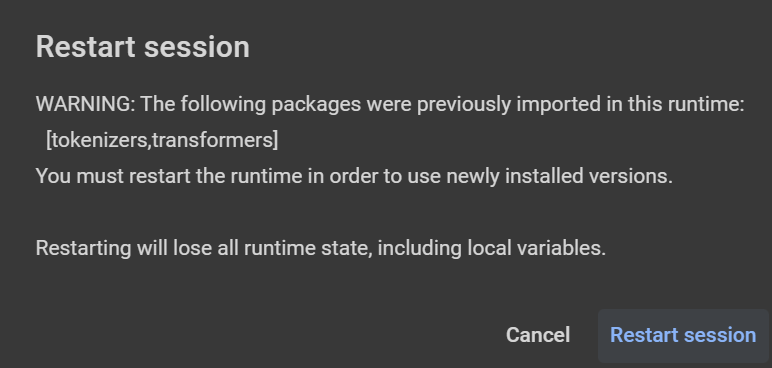

ATTENTION: L'invite de texte doit être séparée avec '|' chacune à deux phrases (toutes les ~ 20 secondes il faut pour la lire). Si vous obtenez des avertissements et que la session de redémarrage est suggérée (après l'installation d'une bibliothèque - par exemple Librosa, comme indiqué dans la figure ci-dessous), cliquez sur «Annuler». Dans la version gratuite (T4 ou V100 avec 15 Go de VRAM et ~ 13 Go de RAM), la durée audio / vidéo maximale peut être de ~ 50 secondes (prend ~ 30 minutes pour exécuter le script et obtenir des résultats). Pour une invite de texte plus longue, un GPU plus grand est nécessaire (version payante utilisant L4 avec 22,5 Go de VRAM et ~ 63 Go de RAM ou A100 avec 40 Go de VRAM et ~ 84 Go de RAM - ce dernier utilise plus d'unités de calcul / heure).

from google . colab import drive

drive . mount ( '/content/gdrive' )

cd gdrive / MyDrive / deepfakeSpécifiez le chemin de base pour les fichiers vidéo et audio.

base_path = '/content/gdrive/MyDrive/deepfake'Installez les bibliothèques TTS, Pydub et MoviePy.

!p ip install - q pydub == 0.25 . 1 TTS == 0.22 . 0 moviepy == 1.0 . 3Définissez le texte anglais qui sera lu avec la voix clonée.

text_to_read = "Joining two modalities results in a surprising increase in generalization! \ n What would happen if we combined them all? " Renommez respectivement les fichiers audio et vidéo téléchargés sur input_voice.mp3 et video_full.mp4 .

Si seule une vidéo est fournie, en extraire un audio pour être utilisée pour cloner l'individu.

Créez un dossier avec des morceaux d'audio de 10 secondes à utiliser comme entrée dans Tortoise.

Assurez-vous que l'audio et la vidéo ont la même durée. Sinon, coupez le plus long pour correspondre à celui le plus court (ou coupez-les tous les deux à 20 secondes).

Clone WAV2lip GitHub Repository, téléchargez des modèles pré-formés et installez les dépendances.

Exécutez le script d'inférence WAV2lip pour générer la vidéo DeepFake.

Supprimer les fichiers et dossiers temporaires.