*****我们团队的新后续研究可通过https://github.com/rlawjdghek/stableviton *****获得

Viton-HD:高分辨率虚拟试验通过未对准归一化

Seunghwan Choi* 1 ,Sunghyun Park* 1 ,Minsoo Lee* 1 ,Jaegul Choo 1

1 kaist

在CVPR 2021中。(*表示同等的贡献)

论文:https://arxiv.org/abs/2103.16874

项目页面:https://psh01087.github.io/viton-hd

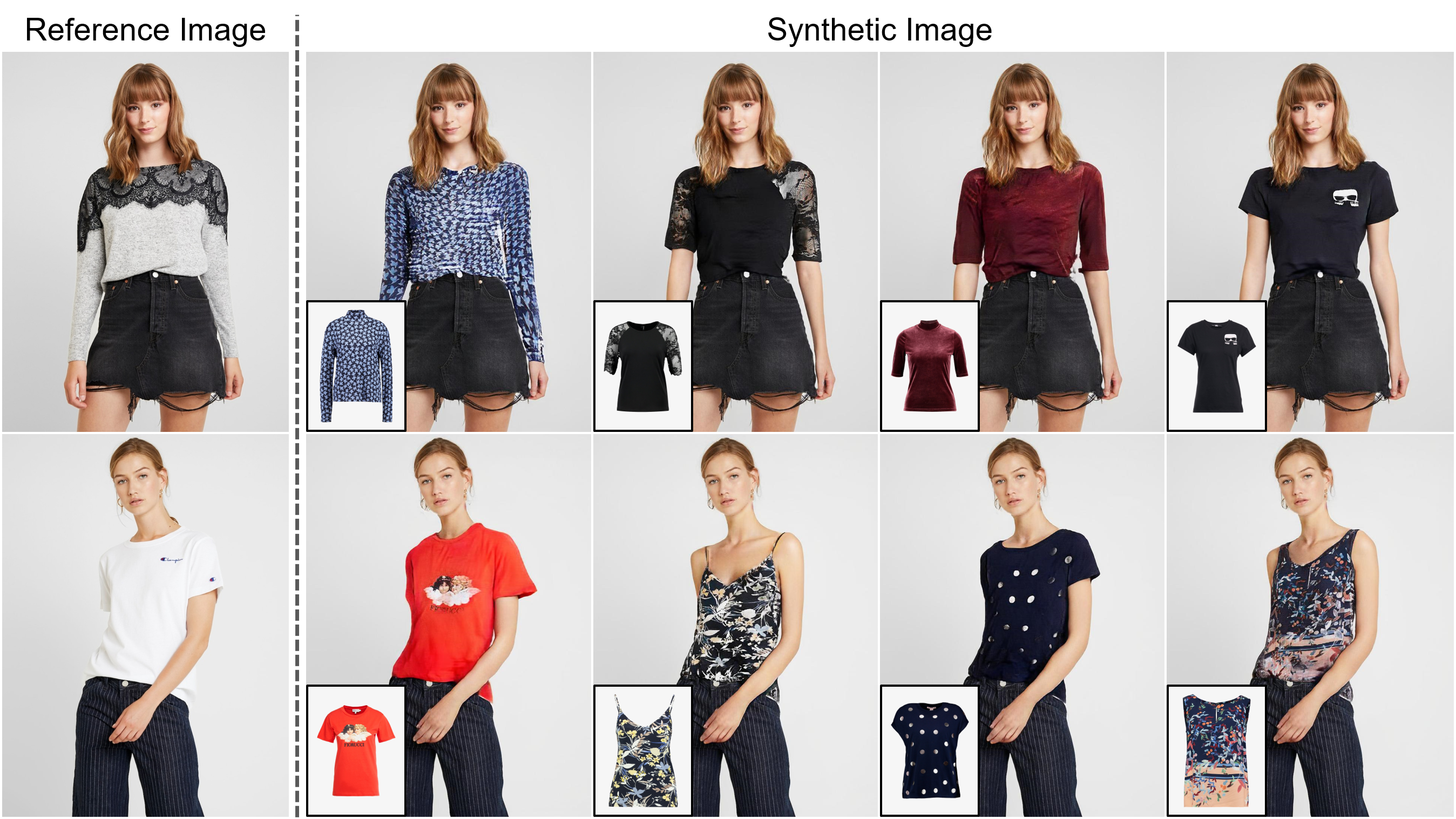

摘要:基于图像的虚拟试验的任务旨在将目标服装项目转移到一个人的相应区域,通常通过将项目安装到所需的身体部位并将扭曲的物品与人融合来解决。尽管已经进行了越来越多的研究,但合成图像的分辨率仍然仅限于低(例如,256x192),这是对满足在线消费者的关键限制。我们认为,限制源于几个挑战:随着决议的增加,扭曲的衣服和所需服装区域之间未对准的区域中的伪影在最终结果中变得显着;现有方法中使用的体系结构在产生高质量的身体部位并保持衣服的质地清晰度方面具有较低的性能。为了应对挑战,我们提出了一种称为Viton-HD的新型虚拟试验方法,该方法成功合成了1024x768虚拟试验图像。具体来说,我们首先准备分割图以指导我们的虚拟试验合成,然后将目标服装项目大致适合给定人的身体。接下来,我们提出对齐感知细分市场(别名)标准化和别名发生器,以处理未对准的区域并保留1024x768输入的细节。通过与现有方法进行严格的比较,我们证明Viton-HD在定性和定量上都在合成的图像质量方面高度超过基准。

我们的团队的ECCV 2022论文(后续研究):https://github.com/sangyun884/hr-viton预处理代码https://github.com/sangyun884848484/hr-viton。

克隆这个存储库:

git clone https://github.com/shadow2496/VITON-HD.git

cd ./VITON-HD/

安装Pytorch和其他依赖关系:

conda create -y -n [ENV] python=3.8

conda activate [ENV]

conda install -y pytorch=[>=1.6.0] torchvision cudatoolkit=[>=9.2] -c pytorch

pip install opencv-python torchgeometry

我们仅出于我们的研究目的收集了1024 x 768虚拟试验数据集。您可以从Viton-HD Dropbox下载预处理数据集。正面的女人和顶部服装图像对分别分为训练和测试套,分别为11,647和2,032对。

我们提供预先训练的网络和测试数据集的示例图像。请下载*.pkl并从Viton-HD Google Drive文件夹和UNZIP *.zip文件中测试图像。 test.py假设下载的文件放在./checkpoints/和./datasets/目录中。

要生成虚拟的尝试图像,请运行:

CUDA_VISIBLE_DEVICES=[GPU_ID] python test.py --name [NAME]

结果保存在./results/ Results/目录中。您可以通过指定--save_dir参数来更改位置。要使用不同对的人和服装项目综合虚拟的尝试图像,请编辑./datasets/test_pairs.txt并运行同一命令。

所有材料均在NC 4.0的Creative Commons下提供。只要您引用我们的论文并指出您所做的任何更改,您就可以将材料用于非商业目的的材料来使用,重新分配和调整材料。

如果您发现这项工作对您的研究有用,请引用我们的论文:

@inproceedings{choi2021viton,

title={VITON-HD: High-Resolution Virtual Try-On via Misalignment-Aware Normalization},

author={Choi, Seunghwan and Park, Sunghyun and Lee, Minsoo and Choo, Jaegul},

booktitle={Proc. of the IEEE conference on computer vision and pattern recognition (CVPR)},

year={2021}

}