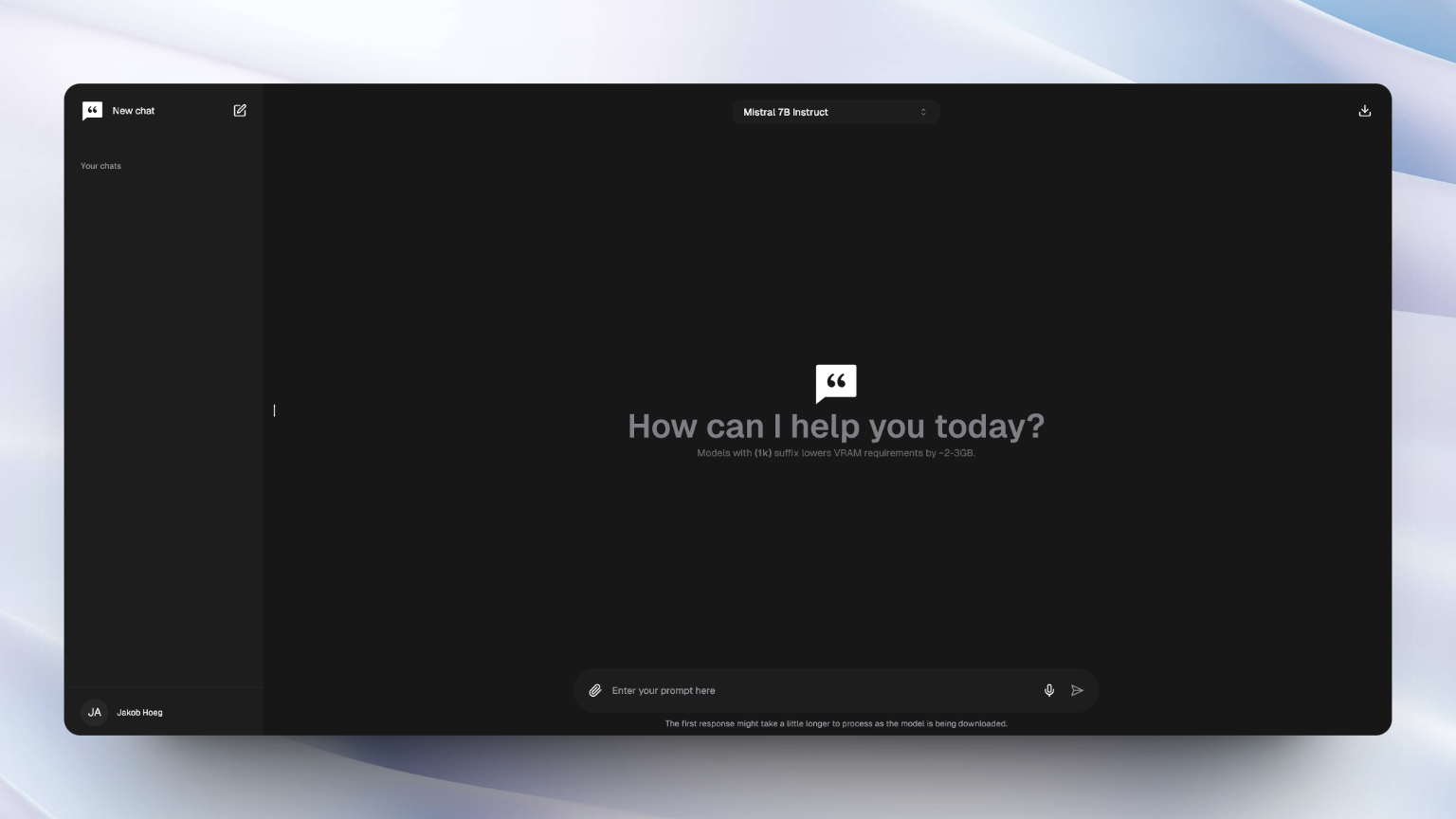

chatty

Llama3.1 & Qwen2 model support

Chatty是您的私人AI,它利用WebGPU在浏览器中本地和私人地运行大型语言模型(LLMS),为您带来最丰富的浏览器AI体验。

该项目旨在将最接近的尝试从Chatgpt和Gemini等流行的AI接口将著名性和功能带入浏览器体验。

默认情况下,在Chrome和Edge中启用和支持WebGPU。但是,可以在每晚使用Firefox和Firefox中启用它。检查浏览器兼容性以获取更多信息。

如果您只想尝试该应用程序,则可以在此网站上进行直播。

这是一个spect.js应用程序,需要安装node.js(18+)和NPM以本地运行该项目。

如果您想在本地设置和运行该项目,请按照以下步骤操作:

1。通过命令提示符将存储库克隆到PC上的目录:

git clone https://github.com/addyosmani/chatty

2。打开文件夹:

cd chatty

3。安装依赖项:

npm install

4。启动开发服务器:

npm run dev

5。转到Localhost:3000,开始聊天!

笔记

Dockerfile尚未针对生产环境进行优化。如果您想自己这样做,请结帐示例

docker build -t chattyui .

docker run -d -p 3000:3000 chattyui

或使用docker-compose :

docker compose up

如果您进行了更改并想重建,则可以简单地运行

docker-compose up --build

贡献非常欢迎!但是,请确保首先阅读贡献指南:)

笔记

为了有效地运行模型,您需要一个具有足够内存的GPU。 7B型号需要大约6GB内存的GPU,而3B型号则需要大约3GB。

较小的型号可能无法处理像较大型号一样有效的文件嵌入。

Chatty是使用Webllm项目建造的,该项目使用HuggingFace,开源LLM和Langchain建立。我们要承认他们的出色工作,并感谢开源社区。

Chatty由Addy Osmani&JakobHoegMørk创建和维护。