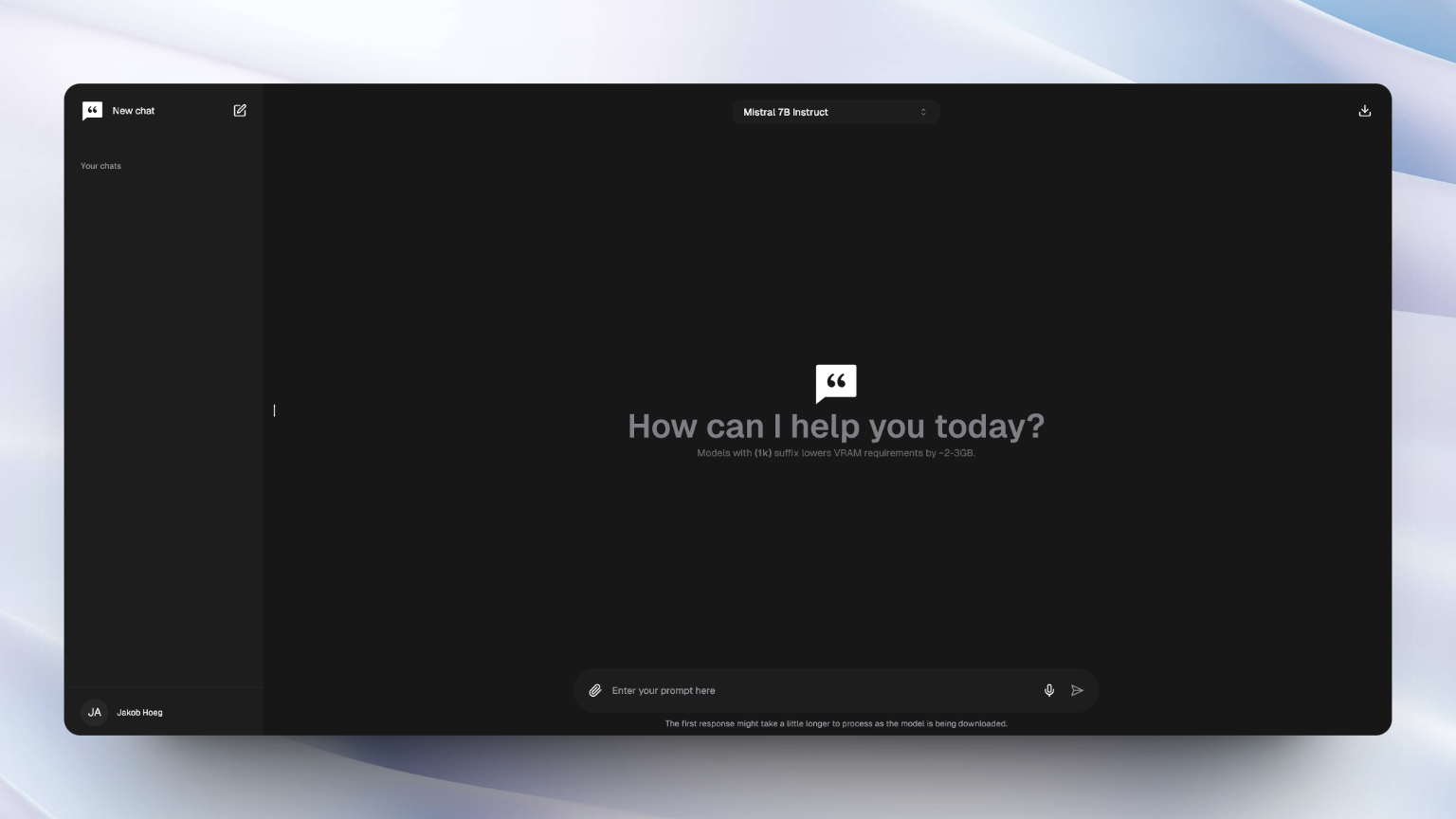

Chattyは、WebGPUを活用して大規模な言語モデル(LLMS)をブラウザでネイティブおよび個人的に実行するプライベートAIであり、最も機能の豊富なブラウザーAIエクスペリエンスを提供します。

このプロジェクトは、ChatGptやGeminiなどの人気のあるAIインターフェイスからの家族性と機能をブラウザー内体験にもたらすための最も近い試みであることを意図しています。

デフォルトでは、ChromeとEdgeの両方でWebGPUが有効になり、サポートされています。ただし、FirefoxとFirefoxで毎晩有効にすることができます。詳細については、ブラウザの互換性を確認してください。

アプリを試してみたい場合は、このWebサイトでライブです。

これはnext.jsアプリケーションであり、プロジェクトをローカルに実行するためにnode.js(18+)とNPMがインストールされます。

プロジェクトをローカルでセットアップして実行する場合は、以下の手順に従ってください。

1.コマンドプロンプトを介して、PCのディレクトリにリポジトリをクローンします。

git clone https://github.com/addyosmani/chatty

2。フォルダーを開きます:

cd chatty

3。依存関係をインストールします:

npm install

4。開発サーバーを起動します。

npm run dev

5。LocalHost:3000にアクセスして、チャットを開始してください!

注記

Dockerfileは、生産環境にまだ最適化されていません。自分でやりたい場合は、次のjsの例をチェックアウトしてください

docker build -t chattyui .

docker run -d -p 3000:3000 chattyui

または、 docker-composeを使用します。

docker compose up

変更を加えて再構築したい場合は、

docker-compose up --build

貢献は大歓迎です!ただし、最初に貢献ガイドラインを読んでください:)

注記

モデルを効率的に実行するには、十分なメモリを備えたGPUが必要です。 7Bモデルには、約6GBのメモリを備えたGPUが必要ですが、3Bモデルには約3GBが必要です。

小さなモデルがファイルの埋め込みをより大きなモデルと同じように効率的に処理できない場合があります。

Chattyは、Huggingface、Open Source LLMS、Langchainを使用して、Webllmプロジェクトを使用して構築されています。私たちは彼らの素晴らしい仕事を認め、オープンソースコミュニティに感謝したいと思います。

チャットは、Addy Osmani&Jakob HoegMørkによって作成および維持されています。