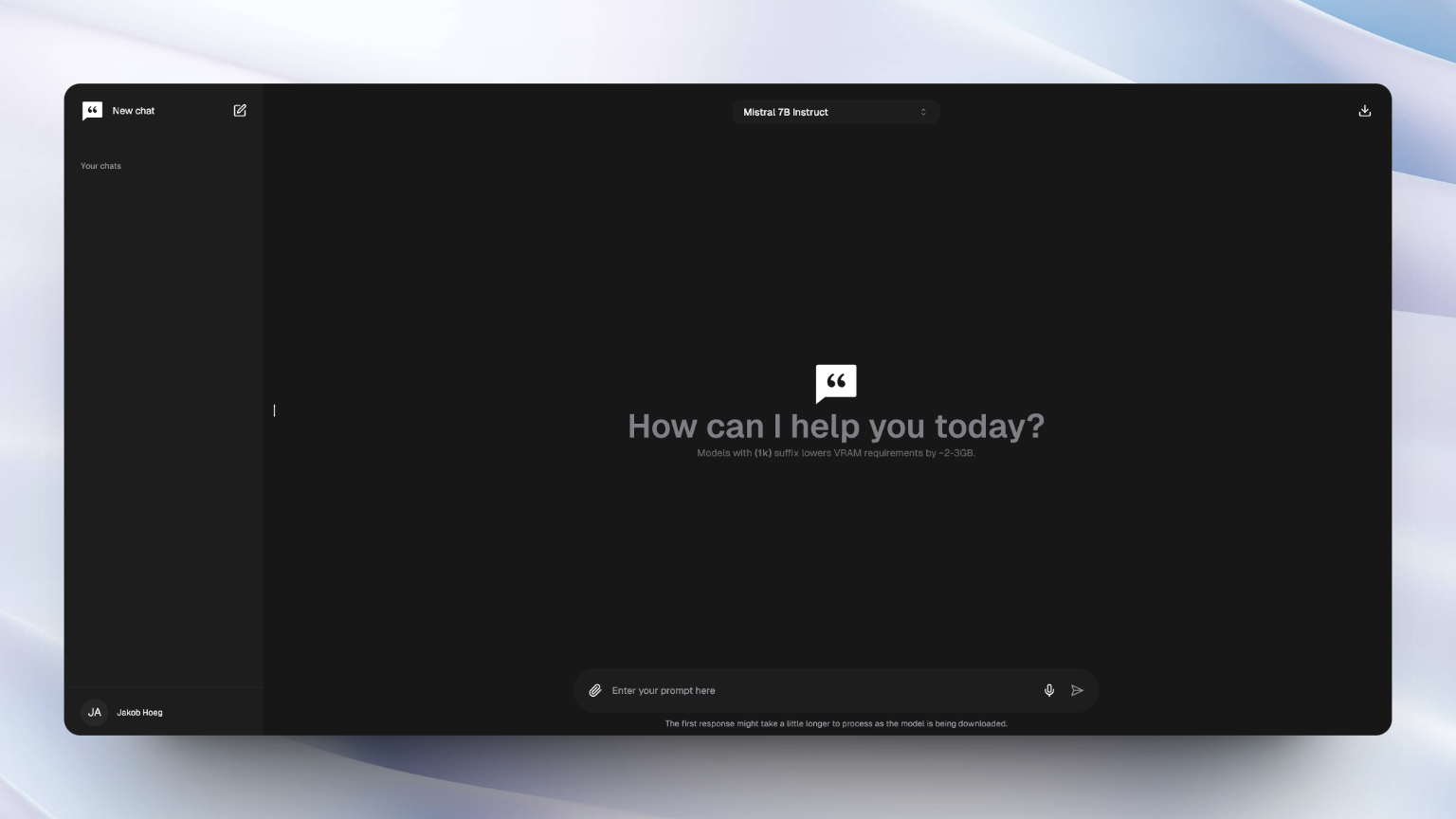

chatty هو الذكاء الاصطناعي الخاص بك الذي يعزز WebGPU لتشغيل نماذج لغة كبيرة (LLMS) أصلاً وخاصة في متصفحك ، مما يجلب لك تجربة AI الأكثر ثراءً.

من المفترض أن يكون هذا المشروع هو أقرب محاولة لجلب العائلة والوظائف من واجهات الذكاء الاصطناعى الشهيرة مثل ChatGpt و Gemini إلى تجربة في المتصفح.

بشكل افتراضي ، يتم تمكين WebGPU ودعمه في كل من Chrome و Edge. ومع ذلك ، من الممكن تمكينه في Firefox و Firefox الليلية. تحقق من توافق المتصفح لمزيد من المعلومات.

إذا كنت ترغب فقط في تجربة التطبيق ، فهو مباشر على هذا الموقع.

هذا تطبيق Next.js ويتطلب Node.js (18+) و NPM مثبتة لتشغيل المشروع محليًا.

إذا كنت ترغب في إعداد وتشغيل المشروع محليًا ، اتبع الخطوات أدناه:

1. استنساخ المستودع إلى دليل على جهاز الكمبيوتر الخاص بك عبر موجه الأوامر:

git clone https://github.com/addyosmani/chatty

2. افتح المجلد:

cd chatty

3. تثبيت التبعيات:

npm install

4. ابدأ خادم التطوير:

npm run dev

5. انتقل إلى LocalHost: 3000 وابدأ الدردشة!

ملحوظة

لم يتم بعد تحسين Dockerfile لبيئة الإنتاج. إذا كنت ترغب في القيام بذلك بنفسك ، فقم بالخروج عن مثال NEXTJS

docker build -t chattyui .

docker run -d -p 3000:3000 chattyui

أو استخدم docker-compose :

docker compose up

إذا قمت بإجراء تغييرات وترغب في إعادة البناء ، فيمكنك ببساطة تشغيل

docker-compose up --build

المساهمات أكثر من موضع ترحيب! ومع ذلك ، يرجى التأكد من قراءة الإرشادات المساهمة أولاً :)

ملحوظة

لتشغيل النماذج بكفاءة ، ستحتاج إلى وحدة معالجة الرسومات مع ذاكرة كافية. تتطلب نماذج 7B وحدة معالجة الرسومات مع حوالي 6 جيجابايت ذاكرة بينما تتطلب النماذج 3B حوالي 3 جيجابايت.

قد لا تكون النماذج الأصغر قادرة على معالجة تضمينات الملفات الفعالة مثل الكفاءة.

تم تصميم chatty باستخدام مشروع WebLLM ، باستخدام Huggingface و Open Source LLMs و Langchain. نريد أن نعترف بعملهم العظيم ونشكر مجتمع المصدر المفتوح.

يتم إنشاء chatty وصيانتها بواسطة Addy Osmani & Jakob Hoeg Mørk.